Hadoop局限性與數據多樣性令數據科學家抓狂

譯文企業用戶正逐漸將更多注意力集中在創建大數據分析能力身上,而數據科學家則因此而承受著更為沉重的壓力。

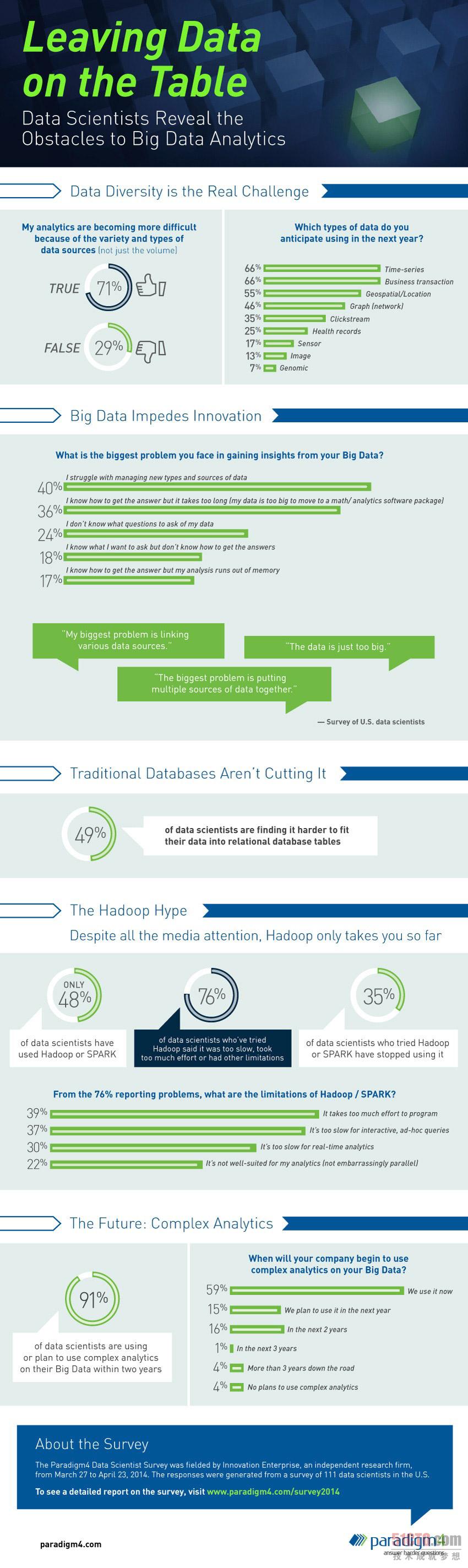

在Paradigm4(也就是開源計算數據庫管理系統SciDB的***)本周發布的一份面向超過一百位數據科學家的調查報告當中,他們發現有71%的受訪數據科學家認為隨著數據源種類以及數據規模的不斷增加、他們的工作難度也隨之逐步攀升。

值得注意的是,只有48%的受訪者在調查中表示他們曾經在工作當中使用過Hadoop或者Spark,而且76%的受訪者認為Hadoop的執行速度太過緩慢、在建立規劃時需要投入大量精力或者存在其它嚴重局限。

“數據源種類的不斷增加正迫使數據科學家們尋找處理問題的捷徑,否則數據量與財政預算之間的矛盾將變得不可調和,”Paradigm4公司CEO Marilyn Matz表示。“目前對于數據規模的關注掩蓋了分析工作當中的真正挑戰所在。只有解決對不同類型數據加以利用這一重大難題,我們才有可能釋放分析手段當中所蘊藏的巨大潛能。”

即使拋開Hadoop平臺周邊存在的諸多挑戰性因素,其本身也仍然無法令人滿意。約有半數受訪者在調查中表示(49%),他們發現自己的數據很難與關系型數據庫表相適應。59%的受訪者指出他們所在的企業已經開始使用復雜的分析機制——包括協方差分析等數學手段、集群化、機器學習、主成分分析與圖形操作,而非商務智能報告等“基礎分析”手段——對業務數據進行分析。

另有15%的受訪者計劃在未來一年中開始使用復雜分析機制,16%的受訪者則將復雜分析機制的引入規劃設定在未來兩年內。只有4%的受訪者表示他們所在的企業尚無計劃使用復雜分析方案。

Paradigm4認為這意味著大數據這一“唾手可得的價值果實”已經開始轉化為實際收益,而數據科學家們將需要進一步深入研究、從而***程度提升其附加價值。

“大數據發展進程中由簡單向復雜分析的過渡預示著分析機制將逐步走向規模化道路,而這個過程將超越單一服務器內存容量限制、將分散且易于忽略的價值作為關注重點并需要以適當的混合采樣頻率作為依托——這一切都將成為分析領域的新興需求,”Paradigm4在報告中寫道。“這些復雜分析方法同時也會給數據科學家帶來眾多不受監管且無從假設的實際處理方案,并最終讓數據自身有能力給出結論。”

Paradigm4還認為,Hadoop已經被不切實際地夸大成了一套具有普遍性與顛覆性的大數據解決方案。報告指出,在某些特定復雜分析用例當中,Hadoop根本不能算是可行的解決方案。Paradigm4表示,基礎分析已經成為一種“高度并行機制”(也被稱為‘數據并行機制’),而復雜分析則并非如此。

所謂高度并行問題可以被拆分成多個獨立的子問題且能夠并行運作——不同任務之間幾乎甚至完全不存在關聯性,因此大家不需要一次性訪問全部數據內容。這也正是Hadoop MapReduce在處理數據時所遵循的辦法。而非高度并行類分析任務,例如眾多復雜分析問題,要求一次性使用并共享全部數據內容并在處理過程當中隨時進行結果通信。

22%的受訪數據科學家在調查中表示,Hadoop與Spark并不適合自己的分析實例。Paradigm4公司還發現,35%的受訪數據科學家曾經嘗試過Hadoop或者Spark,但最終放棄了將其引入實際業務環境的打算。

Paradigm4在報告中提到的111位美國數據科學家來自由創新研究企業Innovation Enterprise自2014年3月27日到4月23日進行的調查群體。Paradigm4在下面這份圖表當中匯總了全部相關調查結果。

原文鏈接: