爬蟲-化被動為主動

一、前言

現在網上有很多被動式掃描器,配置一個代理給瀏覽器設置,然后人去點擊瀏覽器上的網頁,在這種模式下抓到的URL數量沒有用爬蟲的效果好。

我個人是比較懶的,先也寫了個被動的掃描器,不想改以前寫的東西,而且被動也有被動的優點,所以就想可不可以讓爬蟲也設置個代理。就有了下面的東西,很方便。

二、實操

如何在不改變原被動掃描器的情況下讓被動變成主動。

主結構:

以phantomjs為核心,用JS模仿人對頁面的操作,代理軟件抓鏈接。以下流程是通用pychon腳本實現的。

1打開瀏覽器并設置代理->2輸入網址->3填充表單->4點擊按鈕->5點擊超鏈拉->6關閉標簽->7關閉瀏覽器,循環2-6。

1. 打開瀏覽器并設置代理

- proxy_config = [

- '--proxy=127.0.0.1:8080',

- '--proxy-type=http',

- '--ignore-ssl-errors=yes',

- ]

- phantomjs_path='/home/ubuntu_235/proxyscan/phantomjs/phantomjs/bin/phantomjs'

- driver = webdriver.PhantomJS(executable_path=phantomjs_path,service_args=sys_config)

2. 輸入網址

- driver.get('http://demo.aisec.cn')

3. 填充表單

- _input_text = """

- var input_list=document.getElementsByTagName("input");

- for (i_i=0;i_i<input_list.length;i_i++){

- var input_type=input_list[i_i].attributes["type"].value

- if (input_type == "text" || input_type == "password"){

- input_list[i_i].value="ascan@ascan.com";

- continue;

- }

- if (input_type == "radio" || input_type == "checkbox"){

- input_list[i_i].setAttribute('target','_blank');

- input_list[i_i].checked="True";

- }

- }

- """

4. 點擊按鈕

- _but_click = """

- var but_list=document.getElementsByTagName("input");

- for (b_i=0;b_i<but_list.length;b_i++){

- var but_type=but_list[b_i].attributes["type"].value

- if (but_type == "button" || but_type == "submit"){

- but_list[b_i].setAttribute('target','_blank');

- but_list[b_i].click();

- }

- }

- """

5. 點擊超鏈接

- _a_click = """

- var a_list=document.getElementsByTagName("a");

- for (a_i=0;a_i<a_list.length;a_i++){

- a_list[a_i].setAttribute('target','_blank');

- a_list[a_i].click();

- }

- """

這里注意下,我在click前給標簽加了一個target=”_blank”,在新的標簽頁打開鏈接

6. 關閉標簽

- for h in driver.window_handles[1:]:

- driver.switch_to_window(h)

- driver.close()

注意:應該先獲取有標簽頁的handle在用switch_to_window

切換到該標簽頁,執行quit()操作。driver.window_handles[1:]保留的是第一個頁面。

在完成所有操作后關閉瀏覽器

- driver.close()

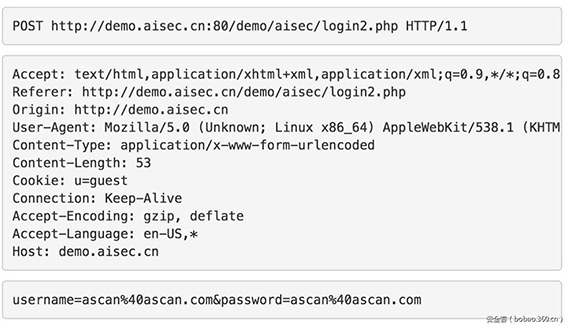

通過burpsuite抓到的請求包

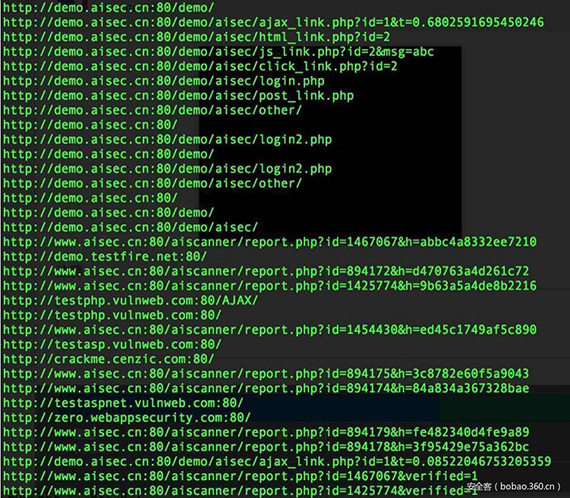

最終實現的結果展示

一些注意點:

如何獲取當前頁面的所有標簽的href?

- url_list=[]

- a_list=self.driver.find_elements_by_xpath("//a[@href]")

- for a in a_list:

- url_list.append(a.get_attribute("href"))

- print(url_list)

如何獲取當前標簽的URL? 有什么坑? a.瀏覽器打頁面要時間,但python不知道(不是真不知道) b.會不明原因的卡死,沒有報錯 c.頁面跳轉