ICLR-17 最佳論文:理解深度學習需要重新思考泛化問題

本文是一篇很好的綜述論文:結(jié)果很容易理解,也讓人有些驚訝,但其意指又會讓人思考良久。

對于文中的問題,作者是這樣回答的:

如何區(qū)分泛化能力好的與差的神經(jīng)網(wǎng)絡(luò)?問題答案是泛化能力好的神經(jīng)網(wǎng)絡(luò)不僅有助于提升網(wǎng)絡(luò)解釋性,而且還可以帶來更有規(guī)律、更可靠的模型架構(gòu)設(shè)計。

所謂的「泛化能力好」,作者對此做出的簡單解釋是「那些在訓練集上表現(xiàn)好的網(wǎng)絡(luò)在測試集上也有良好的表現(xiàn)?」(與遷移學習不同的是,這涉及將訓練過的網(wǎng)絡(luò)應(yīng)用于相關(guān)而又不相同的問題中)。如果你思考一下,這個問題幾乎歸結(jié)為為什么神經(jīng)網(wǎng)絡(luò)可以跟它們工作的一樣好?泛化性與僅僅記憶部分訓練數(shù)據(jù)并將其重新編寫返回不同,泛化性實際上是開發(fā)了一些可用于預(yù)測數(shù)據(jù)的有意義的能力。所以這可能會讓人有一點懊惱,如果這個問題「為什么神經(jīng)網(wǎng)絡(luò)的可以跟其他模型工作的一樣好」的答案是「我們真的不知道」,那么也就不會有懊惱了。

隨機標簽的奇怪案例

我們的故事從熟悉的地方開始---CIFAR 10(50000 張訓練圖像,分為 10 類,另有 10000 張驗證圖像)、2012 年的 ILSVR(1281167 張訓練圖像,50000 張驗證圖片,并且有 1000 個類) 的數(shù)據(jù)以及 Inception 網(wǎng)絡(luò)架構(gòu)的變體。

用訓練數(shù)據(jù)訓練網(wǎng)絡(luò),在訓練集上達到零誤差你肯定不會感到奇怪。這是一個很明顯的過擬合訓練示例,而不是學習真實的預(yù)測特征。我們采用諸如正則化技術(shù)防止過擬合,而且能使模型獲得更好的泛化能力,關(guān)于正則化后文會有細述。

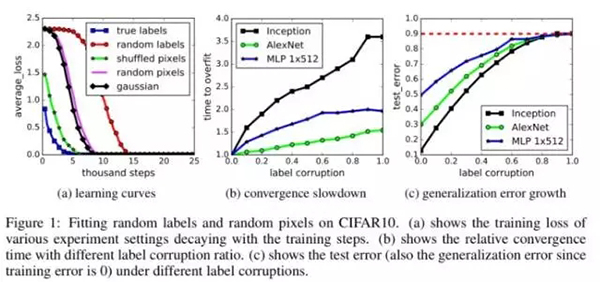

采用相同的訓練數(shù)據(jù),但這次使用隨機的標簽 (即這樣使得標簽和圖像中的內(nèi)容之間不再有真正的對應(yīng)關(guān)系)。用這些隨機的標簽訓練網(wǎng)絡(luò)然后你會得到什么?零訓練誤差!

在這個例子中,實例和類別標簽之間沒有任何的關(guān)系。因此,學習是不可能的。這直觀地表明了這種不可能性在訓練過程中應(yīng)該自我表現(xiàn)的很清楚,例如在訓練之后誤差是不可能收斂或者減小的。令我們驚訝的是,多標準架構(gòu)的訓練過程中的幾個屬性很大程度上不受這個標簽轉(zhuǎn)換的影響。

正如作者總結(jié)所言,「深度神經(jīng)網(wǎng)絡(luò)很容易擬合這些隨機標簽」。這是***個實驗中獲得三個重要發(fā)現(xiàn):

- 神經(jīng)網(wǎng)絡(luò)的有效容量足夠記憶整個數(shù)據(jù)集。

- 盡管優(yōu)化隨機標簽依舊容易,實際上與使用真正標簽的訓練比,隨機標簽訓練的時間只多了一個小的常數(shù)時間。

- 隨機標簽只不過是一個數(shù)據(jù)轉(zhuǎn)換,而學習問題的所有其他屬性不變。

如果你用隨機標簽訓練網(wǎng)絡(luò),然后看網(wǎng)絡(luò)在測試集中的表現(xiàn),這個表現(xiàn)顯然不好,這是因為網(wǎng)絡(luò)沒有學習到數(shù)據(jù)集的正確信息。這一問題的一個奇怪描述是它具有高泛化誤差。將這些情況綜合考慮,你能理解到:

- 單獨通過隨機標簽,在不改變模型的大小、超參數(shù)或者優(yōu)化下,我們可以強制明顯地提高模型的泛化誤差。我們在 CIFA 10 和 ImageNet 分類基準上訓練的幾種不同標準體系確立了這個事實。

- 或易言之,模型及其大小、超參數(shù)和優(yōu)化器并不能解釋當前***進神經(jīng)網(wǎng)絡(luò)的泛化能力。這正是由于模型可以毫無變化,但是泛化能力的表現(xiàn)可以千差萬別。

更奇怪的隨機圖像案例

如果我們不僅僅是弄亂標簽,而且弄亂圖像本身會發(fā)生什么?事實上,如果用隨機噪聲替換真實圖像又會怎么樣?在圖中,這個被稱為「高斯」實驗,因為是使用與原始圖像相匹配的均值和方差的高斯分布生成每張圖像的隨機像素。

事實證明,網(wǎng)絡(luò)依然能夠訓練到零誤差,但是速度比隨機標簽更快。至于為什么會發(fā)生這種情況的假設(shè)是:隨機像素比隨機化標簽的原始圖像更容易區(qū)分,這是因為原始圖像中屬于同一個類別的圖像在經(jīng)過類別隨機化后被學習為其他類別。

帶有一系列變化的團隊實驗將不同程度和種類的隨機化引入數(shù)據(jù)集:

- 真實標簽(沒有經(jīng)過任何修改的原始數(shù)據(jù)集)

- 部分壞標簽(弄亂部分標簽)

- 隨機標簽(弄亂所有標簽)

- 混合像素(選擇一排像素,然后將它應(yīng)用于所有圖像)

- 隨機像素(對每個圖像使用不同的排列)

- 高斯(僅是為每張圖片填充,如前所述)

所有的這一系列方法,網(wǎng)絡(luò)依舊可以很好的擬合這些訓練數(shù)據(jù)。

此外,我們進一步改變隨機化的數(shù)量,在無噪聲和全噪聲的情況下平滑內(nèi)插。這會導致一系列中間學習的問題,其中標簽中存在一定的信號。隨著噪聲的不斷加大,我們發(fā)現(xiàn)泛化誤差也不斷的加大。這說明神經(jīng)網(wǎng)絡(luò)能夠捕獲數(shù)據(jù)中的剩余信號,同時使用蠻力來擬合部分噪聲。

對我來說***一句是關(guān)鍵。我們在模型中做出的某些選擇清楚的表明了模型泛化能力的差異(否則所有的架構(gòu)應(yīng)該具有相同的泛化能力)。在數(shù)據(jù)中沒有其他真實信號時,世界上泛化能力***的網(wǎng)絡(luò)依舊需要回顧一下。所以我們可能需要一種方法去挑選數(shù)據(jù)集中存在的真正泛化能力,以及給定模型架構(gòu)在捕捉這種潛力的效率。一個簡單方法是用不同架構(gòu)的模型訓練在同樣的數(shù)據(jù)上訓練(當然我們一直是這樣做的)。這依然不能幫助我們解決原始問題,但是可以理解為什么一些模型的泛化能力比其他模型好。

用正則化彌補?

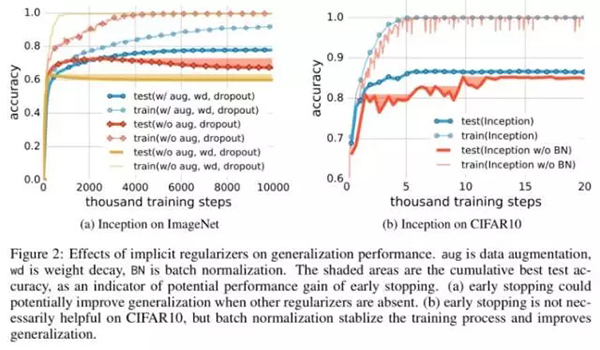

模型架構(gòu)本身顯然不能充分正規(guī)化(不能防止過擬合/記憶),但是常用的正則化技術(shù)呢?

如下我們顯示采用一些正則化技術(shù),例如權(quán)重衰減 、dropout、增加一些數(shù)據(jù)都足以解釋神經(jīng)網(wǎng)絡(luò)的泛化誤差:采用正則化可能會提供模型的泛化能力,但這并不是必須的也不足以控制泛化誤差。

顯性正則化似乎更多的是一個調(diào)整參數(shù),有助于提高泛化能力,但是其缺失也并不意味著泛化誤差。當然并非所有能夠擬合訓練數(shù)據(jù)的模型都能很好地泛化。本文分析中的有趣一面是,我們僅僅通過使用梯度下降過程就獲得了一定量的正則化:

我們分析 SGD 如何作為一個隱性正則器。對于線性模型,SGD 經(jīng)常收斂到一個小規(guī)模的解決方案。因此算法本身隱性地正則化了解決方案,盡管這個無法解釋為什么某些架構(gòu)比其他架構(gòu)泛化能力更好,但卻表明需要使用更多的研究來了解 SGD 的內(nèi)在屬性。

機器學習模型的有效容量

考慮樣本大小為 n 的神經(jīng)網(wǎng)絡(luò)情況,如果網(wǎng)絡(luò)有一個參數(shù) p,p 比 n 更大,然后盡管一個簡單的兩層神經(jīng)網(wǎng)絡(luò)可以表示輸入樣本的任何函數(shù)。作者證明(在附錄中)以下定律:

存在一個帶有 ReLU 激活函數(shù)、有 2n+d 個權(quán)重的二層神經(jīng)網(wǎng)絡(luò),可以表示大小為 n*d 的樣本上的任何函數(shù)。

所以這一切都偏離我們了?

這種情況對統(tǒng)計學習提出了一個概念上的挑戰(zhàn),因為傳統(tǒng)的模型復雜度度量很難解釋大型人工神經(jīng)網(wǎng)絡(luò)的泛化能力。我們的任務(wù)在這個巨大的模型下,且還沒有發(fā)現(xiàn)簡單準確的度量方法。從我們的實驗得出的另一個解釋是:即使是模型的泛化能力不好,通過經(jīng)驗優(yōu)化模型也是比較容易的。這表明了優(yōu)化為什么容易的經(jīng)驗性原因,肯定不同于真正的泛化原因。

【本文是51CTO專欄機構(gòu)機器之心的原創(chuàng)譯文,微信公眾號“機器之心( id: almosthuman2014)”】