蘋果機器學習期刊「Siri 三部曲」之一:通過跨帶寬和跨語言初始化提升神經網絡聲學模型

近日,蘋果 Siri 團隊在蘋果機器學習期刊上連發(fā)三文《Improving Neural Network Acoustic Models by Cross-bandwidth and Cross-lingual Initialization》、《Inverse Text Normalization as a Labeling Problem》、《Deep Learning for Siri』s Voice: On-device Deep Mixture Density Networks for Hybrid Unit Selection Synthesis》,詳實展現了蘋果在語音助手 Siri 上的***進展與成果。其中***篇文章討論了一項利用聲學模型數據的遷移學習技術,它可以顯著提升新語言版本 Siri 的精確度。機器之心隨后將奉獻上第二篇、第三篇博文,敬請讀者期待。

用戶希望 Siri 的語音識別功能保持穩(wěn)定,不受語言、設備、聲音環(huán)境或者通信信道帶寬的影響。正如其他監(jiān)督式機器學習任務一樣,高精度的獲取通常需要大量的標注數據。無論何時在 Siri 中部署新的語言,或者擴展 Siri 以支持不同的音頻信道帶寬,我們都面臨著是否有足夠數據來訓練聲學模型的挑戰(zhàn)。本文中,我們討論了使用聲學模型數據的遷移學習技術,該技術已經投入使用。我們展示了,表征不僅可跨語言遷移,還可以跨音頻信道帶寬遷移。作為一個研究案例,我們專注于以新的 Siri 語言識別超過 8 kHz 藍牙耳機的窄帶音頻。我們的技術有助于顯著提升新語言版本 Siri 的精確度。

任何數量的域數據

即使你只有與訓練域相關的有限數據,它也很有價值。絕大多數 Siri 的使用發(fā)生在寬帶音頻信道,只有很少一部分發(fā)生在窄帶信道(比如,8KHz 藍牙耳機)。然而,從絕對意義上講,蘋果的大量客戶在窄帶信道上使用 Siri。在新語言版本的 Siri 發(fā)布之前,我們可以搜集的窄帶藍牙音頻的數量是有限的。盡管如此,我們的目標仍是在***天就為客戶提供***的體驗。

2014 年年中,Siri 啟動了一個使用深度神經網絡(DNN)的新語音識別引擎。該引擎首先引入到美式英語的 Siri 中,截至 2015 年年中,我們已經把該引擎擴展到 13 種語言。為了實現成功擴展,我們必須使用發(fā)布前可收集的有限數量的轉錄數據來解決建立高質量聲學模型的問題。對于寬帶音頻情況是這樣,例如通過 iPhone 麥克風收集寬帶音頻,而對于通過藍牙耳機收集的窄帶音頻更是如此。

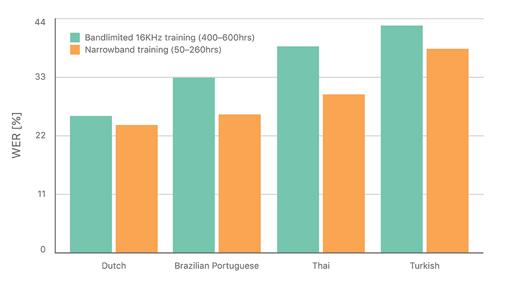

一個可以解決小數量窄帶藍牙音頻問題的方法是帶限(band-limit)相對較多、更易收集的寬帶音頻。實際上,我們發(fā)現在有限數量的窄帶藍牙音頻上訓練的聲學模型依然優(yōu)于在更大數量的帶限寬帶音頻上訓練的模型,這表明了聲學模型訓練中域內數據的價值(圖 1)。這就要求同時利用大量的寬帶音頻和有限的窄帶音頻。在這項工作中,我們在遷移學習框架中調查了神經網絡初始化 [1], [2]。

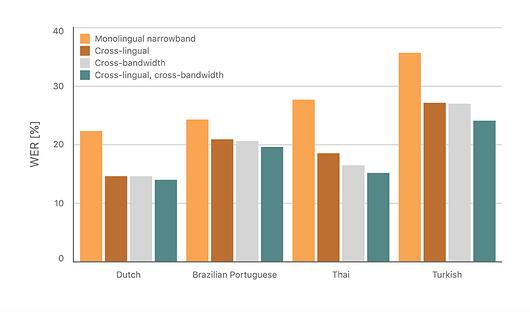

表 1 :窄帶藍牙測試中的詞錯率(WER)

跨語言初始化

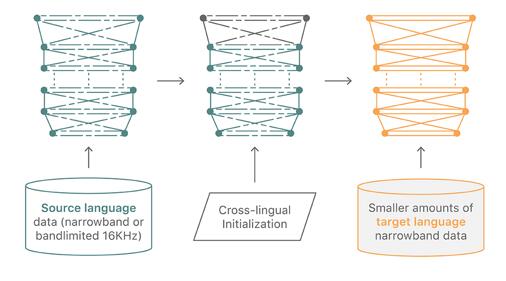

很多研究者認為 [3] [4] [5] 神經網絡聲學模型的隱藏層可以跨語言共享。背后原理在于隱藏層學習的特征變換(feature transformation)不太指定具體語言,因此可以在多種語言之間泛化。

圖 2. 跨語言初始化

我們將訓練好的現有語言窄帶 DNN 模型的隱藏層遷移到新的目標語言,并使用目標語言數據重新訓練該網絡,如圖 2 所示。

即使我們用不同的源 DNN 進行嘗試,使用所有可用的窄帶訓練數據進行跨語言初始化訓練的效果通常顯著優(yōu)于基線(詳見 [6])。即使只有 20 個小時的窄帶數據,對大多數語言來說,使用英語窄帶模型開始跨語言訓練優(yōu)于使用更多窄帶數據的基線。而當我們思考源語言和目標語言之間的語言關系時,我們無法得出結論。

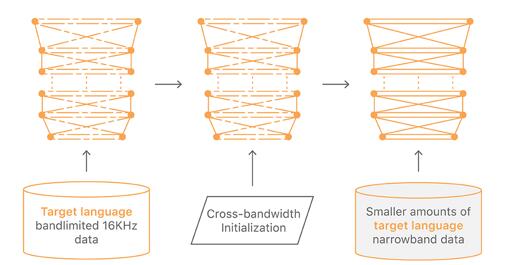

跨帶寬初始化

圖 3. 跨帶寬初始化

在最初的實驗中,我們發(fā)現使用較少真實窄帶藍牙音頻數據訓練的模型優(yōu)于使用較多帶限寬帶數據訓練的模型。但是,在一種語言中使用帶限數據訓練的模型作為初始化的起點仍然是有用的。我們在真實窄帶藍牙音頻數據上重新訓練帶限模型。用這種方式,我們能夠使用一種語言的寬帶和窄帶數據來訓練窄帶模型(見圖 3)。

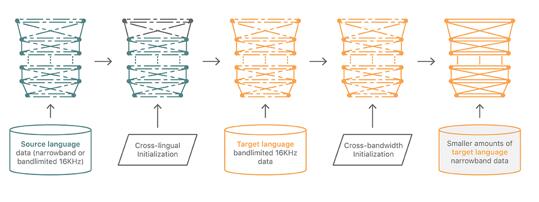

跨語言和跨帶寬遷移的結合

看到前兩個遷移學習技術的成功之后,我們認為我們可以結合這兩種技術,實現更進一步的發(fā)展。具體來說,我們在一個新的語言的帶限寬帶數據上訓練 DNN 時,不需要使用隨機權重開始,但是可以初始化在已支持的語言的帶限數據上訓練的 DNN 模型中的隱藏層。

圖 4. 跨語言和跨帶寬初始化的結合

圖 5. 跨語言和跨帶寬初始化的詞錯率對比

結論

我們利用從其他語音識別任務中獲取的知識來改善窄帶藍牙應用的 DNN 聲學模型。這類知識通常從 DNN 聲學模型初始化中獲取,具體來說,就是使用在帶限寬帶數據上預訓練的 DNN 的權重,或者將其用于另一種語言。

對于我們實驗中使用的全部語言,這些技術產生的詞錯率比只在目標語言的藍牙窄帶數據中單獨訓練的模型低 45%。我們的方法還可以靈活地在訓練時間和從可用的多樣化數據中學習之間進行權衡,詳情見論文 [6]。

除本文論述的藍牙窄帶模型案例研究外,這些方法在很多神經網絡聲學模型場景中都顯示出其高效性,并且?guī)椭覀冊?nbsp;Siri 使用新語言和新音頻信道時構建***模型。