嫌Python太慢?并行運(yùn)算Process Pools三行代碼給你4倍提速!

Python絕對(duì)是處理數(shù)據(jù)或者把重復(fù)任務(wù)自動(dòng)化的***編程語(yǔ)言。要抓取網(wǎng)頁(yè)日志?或者要調(diào)整一百萬(wàn)張圖片?總有對(duì)應(yīng)的Python庫(kù)讓你輕松完成任務(wù)。

然而,Python的運(yùn)營(yíng)速度一直飽受詬病。默認(rèn)狀態(tài)下,Python程序使用單個(gè)CPU的單個(gè)進(jìn)程。如果你的電腦是最近十年生產(chǎn)的,多數(shù)情況下會(huì)有4個(gè)及以上CPU核。也就是說(shuō),當(dāng)你在等程序運(yùn)行結(jié)束的時(shí)候,你的計(jì)算機(jī)有75%或者更多的計(jì)算資源都是空置的!

讓我們來(lái)看看如何通過(guò)并行運(yùn)算充分利用計(jì)算資源。多虧有Python的concurrent.futures模塊,僅需3行代碼就可以讓一個(gè)普通程序并行運(yùn)行。

一般情況下的Python運(yùn)行

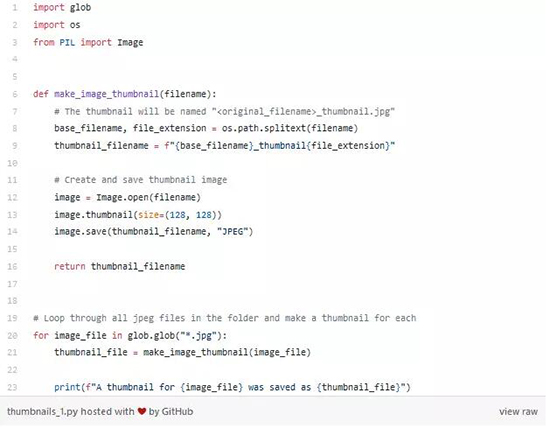

比如說(shuō)我們有一個(gè)文件夾,里面全是圖片文件,我們想給每一張圖片創(chuàng)建縮略圖。

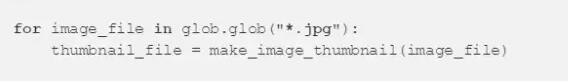

下面的短程序中我們使用Python自帶的glob 函數(shù)獲取一個(gè)包含文件夾中所有圖片文件的列表,并用Pillow圖片處理庫(kù)獲取每張圖片的128像素縮略圖。

這個(gè)程序遵循很常見(jiàn)的數(shù)據(jù)處理模式:

- 從您想處理的一系列文件(或其他數(shù)據(jù))開(kāi)始

- 編寫(xiě)一個(gè)處理一個(gè)數(shù)據(jù)的輔助函數(shù)

- 用for循環(huán)調(diào)動(dòng)輔助函數(shù),一個(gè)一個(gè)的去處理數(shù)據(jù)

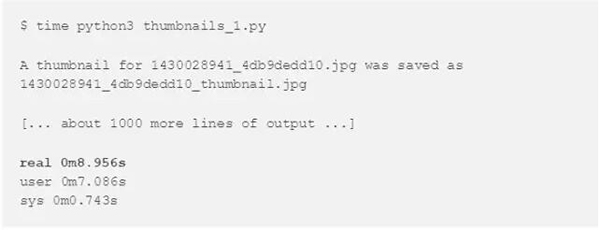

讓我們用1000張圖片來(lái)測(cè)試這個(gè)程序,看看運(yùn)行時(shí)間是多少。

程序運(yùn)行時(shí)間8.9秒,但是計(jì)算機(jī)的運(yùn)算資源占用了多少呢?

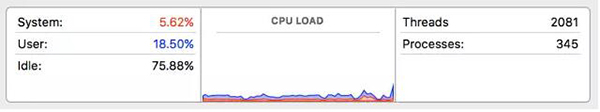

讓我們?cè)倥芤淮纬绦颍瑫r(shí)查看活動(dòng)監(jiān)視器:

計(jì)算機(jī)有75%空置,這是為什么呢?

問(wèn)題在于我的計(jì)算機(jī)有4個(gè)CPU核,但是Python只用了其中一個(gè)核。即便我的程序把那個(gè)CPU核完全占滿(mǎn),但是其他3個(gè)CPU核什么也沒(méi)干。我們需要想辦法把整個(gè)程序的工作量分成4份然后平行運(yùn)行。所幸Python可以做到這一點(diǎn)!

讓我們來(lái)試試并行運(yùn)算

下面是實(shí)現(xiàn)并行運(yùn)算的一個(gè)方法:

- 把Jpeg圖片文件列表分成4個(gè)部分。

- 同時(shí)跑四個(gè)Python解釋器。

- 讓四個(gè)解釋器分別處理一部分圖片文件。

- 匯總四個(gè)解釋器的結(jié)果得到最終結(jié)果。

四個(gè)Python程序分別在4個(gè)CPU上運(yùn)行,跟之前在1個(gè)CPU運(yùn)行相比大概可以達(dá)到4倍的速度,對(duì)不對(duì)?

好消息是Python可以幫我們解決并行運(yùn)算麻煩的部分。我們僅需要告訴 Python我們想要運(yùn)行什么函數(shù)以及我們希望工作分成多少份,其他部分留給Python。我們只需要修改三行代碼。

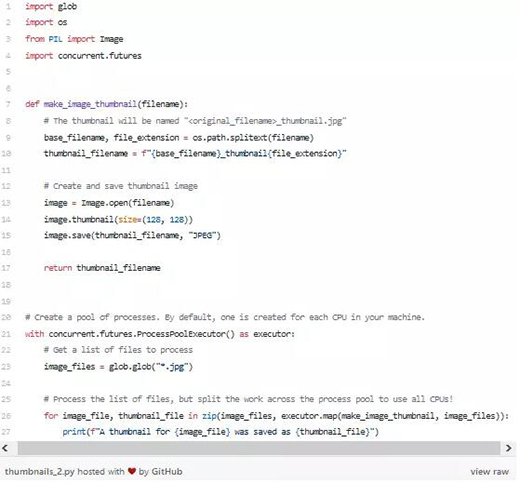

首先,我們需要導(dǎo)入concurrent.futures庫(kù)。這個(gè)庫(kù)是Python自帶的:

然后,我們需要告訴 Python另外啟動(dòng)4個(gè)Python實(shí)例。我們通過(guò)創(chuàng)建Process Pool來(lái)傳達(dá)指令:

默認(rèn)設(shè)置下,上面的代碼會(huì)給計(jì)算機(jī)的每一個(gè)CPU創(chuàng)建一個(gè)Python進(jìn)程,所以如果您的計(jì)算機(jī)有4個(gè)CPU,就會(huì)開(kāi)啟4個(gè)Python進(jìn)程。

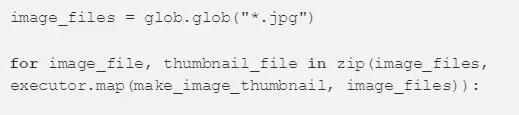

***一步是讓Process Pool 用這4個(gè)進(jìn)程在數(shù)據(jù)列表中執(zhí)行我們的輔助函數(shù)。我們可以把我們之前的for循環(huán)替代為:

新代碼是調(diào)用executor.map()函數(shù)

executor.map() 函數(shù)調(diào)用時(shí)需要輸入輔助函數(shù)和待處理的數(shù)據(jù)列表。這個(gè)函數(shù)幫我們完成所有麻煩的工作,把列表分成幾個(gè)小列表,把小列表分配給每個(gè)子進(jìn)程,運(yùn)行子進(jìn)程,以及匯總結(jié)果。干得漂亮!

我們也可以得到每次調(diào)用輔助函數(shù)的結(jié)果。executor.map()函數(shù)以輸入數(shù)據(jù)順序返回結(jié)果。 Python的zip()函數(shù)可以一步獲取原始文件名以及相應(yīng)結(jié)果。

下面是經(jīng)過(guò)三步改動(dòng)之后的程序:

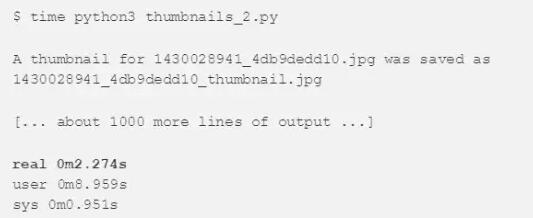

讓我們?cè)囍\(yùn)行一下,看看有沒(méi)有縮短運(yùn)行時(shí)間:

2.274秒程序就運(yùn)行完了!這便是原來(lái)版本的4倍加速。運(yùn)行時(shí)間縮短的原因正是我們這次用4個(gè)CPU代替了1個(gè)CPU。

但是如果您仔細(xì)看看,您會(huì)看到“用戶(hù)(User)”時(shí)間大概是接近9秒,如果程序2秒就運(yùn)行結(jié)束了,為什么客戶(hù)時(shí)間會(huì)是9秒?這似乎…有哪里不對(duì)?

其實(shí)這是因?yàn)?rdquo;用戶(hù)”時(shí)間是所有CPU時(shí)間的總和。我們和上次一樣,用9秒的總CPU

注意:?jiǎn)⒂肞ython進(jìn)程以及給子進(jìn)程分配數(shù)據(jù)都會(huì)占用時(shí)間,因此您不一定能靠這個(gè)方法大幅提高速度。如果您處理的數(shù)據(jù)量很大,這里有一篇“設(shè)置chunksize參數(shù)的技巧”文章可能可以幫助您:https://docs.python.org/3/library/concurrent.futures.html#concurrent.futures.Executor.map。

這種方法總能幫我的程序提速嗎?

當(dāng)你有一列數(shù)據(jù),并且每個(gè)數(shù)據(jù)都可以獨(dú)立處理的時(shí)候,使用Process Pools是一個(gè)好方法。這有一些適合使用并行處理的例子:

- 從一系列單獨(dú)的網(wǎng)頁(yè)服務(wù)器日志里抓取數(shù)據(jù)。

- 從一堆XML,CSV和JSON文件中解析數(shù)據(jù)。

- 對(duì)大量圖片數(shù)據(jù)做預(yù)處理,建立機(jī)器學(xué)習(xí)數(shù)據(jù)集。

但Process Pools不是***的。使用Process Pool需要在獨(dú)立的Python處理過(guò)程中將數(shù)據(jù)來(lái)回傳遞。如果你正在使用的數(shù)據(jù)不能在處理過(guò)程中有效的被傳遞,這種方法就行不通。你處理的數(shù)據(jù)必須是Python知道怎么搞定的類(lèi)型

(https://docs.python.org/3/library/pickle.html#what-can-be-pickled-and-unpickled)。

同時(shí),數(shù)據(jù)不會(huì)按照一個(gè)預(yù)想的順序被處理。如果你需要前一步的處理結(jié)果來(lái)進(jìn)行下一步驟,這種方法也行不通。

那GIL怎么辦?

你可能聽(tīng)說(shuō)過(guò)Python有一個(gè)全局解釋器鎖(Global Interpreter Lock,),縮寫(xiě)為GIL。這意味著即使你的程序是多層的,每一層也只有一個(gè)Python命令能被執(zhí)行。GIL確保任何時(shí)候都只有一個(gè)Python線(xiàn)程執(zhí)行。 GIL***的問(wèn)題就是Python的多線(xiàn)程程序并不能利用多核CPU的優(yōu)勢(shì)。

但Process Pools能解決這個(gè)問(wèn)題!因?yàn)槲覀冊(cè)谶\(yùn)行單獨(dú)的Python實(shí)例,每個(gè)實(shí)例都有自己的GIL。這樣你就有了真正的并行處理的Python代碼!

不要害怕并行處理!

有了concurrent.futures庫(kù),Python可以讓你簡(jiǎn)簡(jiǎn)單單地修改腳本,卻能立刻調(diào)用你電腦上所有CPU內(nèi)核開(kāi)足馬力地運(yùn)行。不要害怕嘗試。一旦你會(huì)用了,它就像寫(xiě)一個(gè)for循環(huán)那樣簡(jiǎn)單,但會(huì)讓整個(gè)程序快很多。

原文:

https://medium.com/@ageitgey/quick-tip-speed-up-your-python-data-processing-scripts-with-process-pools-cf275350163a

【本文是51CTO專(zhuān)欄機(jī)構(gòu)大數(shù)據(jù)文摘的原創(chuàng)譯文,微信公眾號(hào)“大數(shù)據(jù)文摘( id: BigDataDigest)”】