AR/AI必攻的實時光補償算法,太平洋未來科技能否把握科技創新風口?

在Google 、 Apple 和BAT等國際、國內大頭,都在AR/AI領域擲出大手筆或深度注資的熱潮遠景下,光場算法作為涵蓋三大產業中姿態、捕捉、編解碼、壓縮、分析、分發、顯示等整套技術環節體系中***層也最核心的技術,只有真正將基礎打好,從核心抓起,才能賦能多元技術沖破壁壘,率先把握自主科研創新風口。

作為一家集成光場、圖像識別、姿態分析、運動追蹤等于一體全球化人工智能算法科研公司——太平洋未來科技,從2016年成立之初,就已深耕基底,跨越多數人復制少數的“有人區”,開辟了一條穩扎穩打的“無人區”:一方面為研發者及應用開發公司提供一整套綜合全面且高度融合的***深度計算機算法研發系統;另一方面,主攻底層核心實時光補償算法,完善其夯實基礎,方才使得其技術研發系統精確而完整,在自主創新科研產業布局風口站穩腳跟。

化繁為簡 潛心科研方制勝

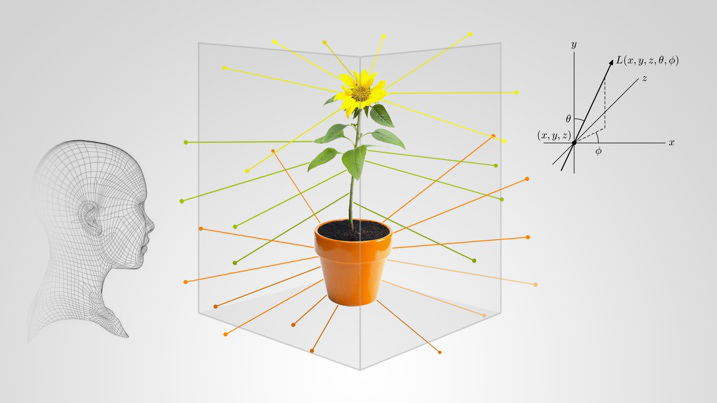

所謂光場,是指整個三維空間內所有光線的集合。空間中每個點的光場都可以定義為5D函數,每條射線的方向均由5D全光函數發射,其波長和角度作為附加變量,每一個光場的建立都是***的向量集合,每個方向都有一個影響點,長度與其輻射成正比,而人的2只眼睛在接受光線位置和方向不同時,會產生雙目視差、移動視差、聚焦模糊和遮擋深淺等現象,只有將外部世界的完整光場信息實時、無損地復現,才能實時再現人眼所見的視界。

太平洋未來科技 AMreal Engine 實時光補償算法原理

基于以上原理及復現場景的真實性考慮,太平洋未來科技通過80臺單反相機收集光場環境與物體之間的關系,從而建立光場,他們自主研發的實時光補償算法——AMreal Engine,從5D全光功能中,提取適當的2D貼片,通過單個圖像合集來確定光照,將光的顏色、光的強弱及光的方向,在三維空間里完整投射呈現。此實時光場補償算法不僅特別適用于移動單目、雙目設備(如手機、平板及主流穿戴設備)及主流U3D渲染引擎;同時為開發者們解決了開發難度大、硬件匹配度高、生成速率慢等種種困難,提供從現實到虛擬再到現實的閉環沉浸空間,大大降低高質量光場內容的制作門檻。

打破光場算法現狀 革新科研產業布局

目前,市面上的光場算法,均只能呈現虛擬光與虛擬光之間的關系,光場引擎亦沒有辦法實時判斷主光源,無法讓虛擬物體與真實環境融合,或者需要昂貴的硬件、感光器去來收集光場,不能滿足人眼不同深度的對焦沉浸感。

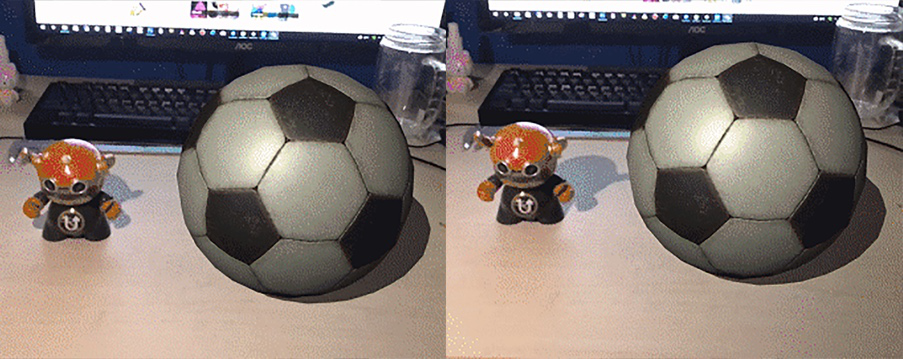

Google ARcore、Apple ARkit 光場和華為AR Engine:

虛擬物體僅根據實際光照發生亮度變化,不能判斷光源及實時追蹤互動(球的影子始終未變)

太平洋未來科技 AMreal Engine實時光補償算法:

實時判斷光源,虛擬物體實時與真實環境光互動補償

Google和Apple等巨頭均把光場列主要功能之一,但均無法做到實時檢測光源,讓虛擬光看起來更接近現實人眼所看到的世界,而太平洋未來科技實時光補償算法,在不需要昂貴成本的情況下,便能模擬實際光束融入現實空間中的情景,完整記錄光場信息,在實時捕捉真實世界的完整光場信息的同時,進行不失真的虛擬構建,無需復雜的、多模組化的攝像頭,亦能完成實時同步的光場效果。 “目前,此實時光補償算法已經提供給相關合作伙伴進行技術評估、使用,SDK也即將上線。”太平洋未來科技創始人兼CEO李建億日前談到。

太平洋未來科技低硬件成本、高效、便捷的實時光補償算法不僅驅動AR/AI產業底層技術革新,也將滲透到虛擬電商、影視制作、3D設計、工業監測、航空、教育、醫療、文旅、博覽等各個領域,期待穩扎行業先行者為科技創新核心技術發展加速。