Web架構之路:MongoDB集群及高可用實踐

MongoDB集群有副本集及主從復制兩種模式,不過主從模式在MongoDB 3.6已經徹底廢棄,今天主要探討副本集的搭建和使用,以及分片。

副本集介紹

副本集(Replica Set)即副本的集合,在MongoDB中通過先定義一個副本集合,然后將多個節點(副本)加入到這個集合中。簡單來說就是集群中包含了多份數據,保證主節點掛掉,備節點能夠繼續提供數據服務,實現MongoDB的數據備份及高可用。

副本集具有以下特征:

- N 個節點的集群

- 任何節點可作為主節點

- 所有寫入操作都在主節點上

- 自動故障轉移

- 自動恢復

副本集搭建

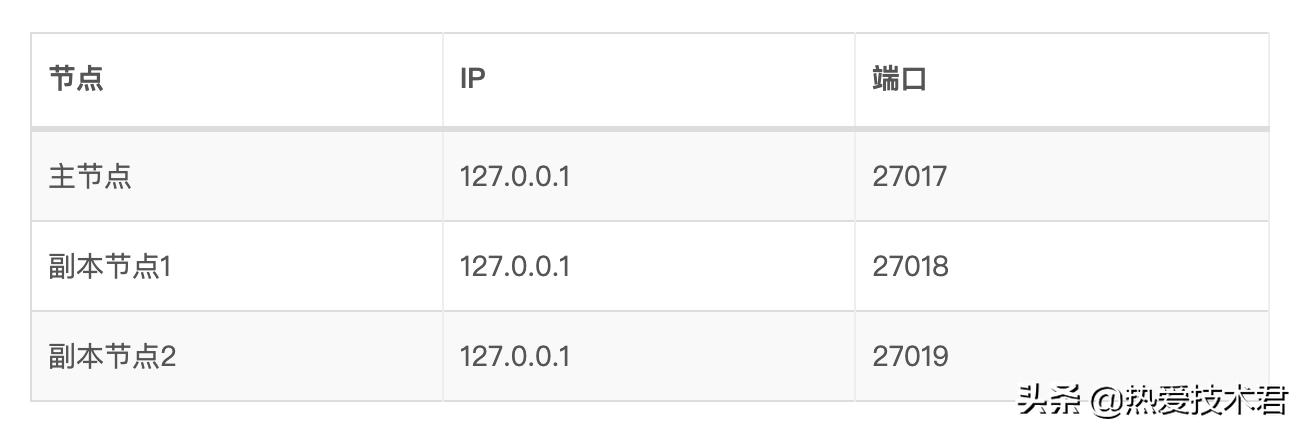

條件有限,我們在單機上,通過三個不同的MongoD線程來搭副本集。

主節點配置如下:

- # 指定數據庫路徑

- dbpath=/usr/local/mongodb/data/db

- # 使用追加的方式寫日志

- logpath=/usr/local/mongodb/log/mongodb.log

- # 使用追加的方式寫日志

- logappend = true

- # 綁定服務IP

- bind_ip=127.0.0.1

- # 服務器端口

- port = 27017

- # 以守護進程的方式運行MongoDB,創建服務器進程

- fork = true

- # PID File 的完整路徑

- pidfilepath=/usr/local/mongodb/var/mongod.pid

- # 不啟用驗證

- noauth=true

- # 最大同時連接數,默認2000

- maxConns=2000

- # 同步復制的日志大小設置,單位MB

- oplogSize=10

- # 副本集名稱

- replSet=rs0

副本節點的配置和主節點的基本一致,需要修改一下數據庫/日志/PID路徑和端口號,副本集名稱需一致:

- # 指定數據庫路徑

- dbpath=/usr/local/mongodb/node/2/data/db

- # 使用追加的方式寫日志

- logpath=/usr/local/mongodb/node/2/log/mongodb.log

- # 使用追加的方式寫日志

- logappend = true

- # 綁定服務IP

- bind_ip=127.0.0.1

- # 服務器端口

- port = 27018

- # 以守護進程的方式運行MongoDB,創建服務器進程

- fork = true

- # PID File 的完整路徑

- pidfilepath=/usr/local/mongodb/var/mongod2.pid

- # 不啟用驗證

- noauth=true

- # 最大同時連接數,默認2000

- maxConns=2000

- # 副本集

- replSet=rs0

依次啟動三個mongod進程:

- gitlib@devops:/usr/local/mongodb$ ps -aux | grep mongod

- root 14293 0.8 2.3 1588812 92700 ? Sl 08:06 0:01 bin/mongod -f mongod.conf

- root 14652 3.5 2.2 1583180 89364 ? Sl 08:08 0:00 bin/mongod -f mongod2.conf

- root 14723 6.4 2.2 1583180 89172 ? Sl 08:08 0:00 bin/mongod -f mongod3.conf

在主節點中,先使用rs.initiate()方法進行副本集初始化操作,再使用rs.add()方法來添加副本集的成員:

- > rs.initiate()

- {

- "info2" : "no configuration specified. Using a default configuration for the set",

- "me" : "127.0.0.1:27017",

- "ok" : 1,

- "$clusterTime" : {

- "clusterTime" : Timestamp(1569457173, 1),

- "signature" : {

- "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

- "keyId" : NumberLong(0)

- }

- },

- "operationTime" : Timestamp(1569457173, 1)

- }

- rs0:OTHER> rs.add('127.0.0.1:27018');

- {

- "ok" : 1,

- "$clusterTime" : {

- "clusterTime" : Timestamp(1569457214, 2),

- "signature" : {

- "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

- "keyId" : NumberLong(0)

- }

- },

- "operationTime" : Timestamp(1569457214, 2)

- }

- rs0:PRIMARY> rs.add('127.0.0.1:27019');

- {

- "ok" : 1,

- "$clusterTime" : {

- "clusterTime" : Timestamp(1569457219, 1),

- "signature" : {

- "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

- "keyId" : NumberLong(0)

- }

- },

- "operationTime" : Timestamp(1569457219, 1)

- }

- rs0:PRIMARY>

到此,MongoDB副本集部署完成,我們可以通過rs.status()命令查看副本集狀態。

- gitlib@devops:~$ mongo 127.0.0.1:27018

- rs0:SECONDARY> rs.status()

- {

- "set" : "rs0",

- "date" : ISODate("2019-09-26T12:09:48.818Z"),

- "myState" : 2,

- "term" : NumberLong(1),

- "syncingTo" : "127.0.0.1:27017",

- "syncSourceHost" : "127.0.0.1:27017",

- "syncSourceId" : 0,

- "heartbeatIntervalMillis" : NumberLong(2000),

- "optimes" : {

- "lastCommittedOpTime" : {

- "ts" : Timestamp(1569499786, 1),

- "t" : NumberLong(1)

- },

- "lastCommittedWallTime" : ISODate("2019-09-26T12:09:46.038Z"),

- "readConcernMajorityOpTime" : {

- "ts" : Timestamp(1569499786, 1),

- "t" : NumberLong(1)

- },

- "readConcernMajorityWallTime" : ISODate("2019-09-26T12:09:46.038Z"),

- "appliedOpTime" : {

- "ts" : Timestamp(1569499786, 1),

- "t" : NumberLong(1)

- },

- "durableOpTime" : {

- "ts" : Timestamp(1569499786, 1),

- "t" : NumberLong(1)

- },

- "lastAppliedWallTime" : ISODate("2019-09-26T12:09:46.038Z"),

- "lastDurableWallTime" : ISODate("2019-09-26T12:09:46.038Z")

- },

- "lastStableRecoveryTimestamp" : Timestamp(1569499726, 1),

- "lastStableCheckpointTimestamp" : Timestamp(1569499726, 1),

- "members" : [

- {

- "_id" : 0,

- "name" : "127.0.0.1:27017",

- "ip" : "127.0.0.1",

- "health" : 1,

- "state" : 1,

- "stateStr" : "PRIMARY",

- "uptime" : 42574,

- "optime" : {

- "ts" : Timestamp(1569499786, 1),

- "t" : NumberLong(1)

- },

- "optimeDurable" : {

- "ts" : Timestamp(1569499786, 1),

- "t" : NumberLong(1)

- },

- "optimeDate" : ISODate("2019-09-26T12:09:46Z"),

- "optimeDurableDate" : ISODate("2019-09-26T12:09:46Z"),

- "lastHeartbeat" : ISODate("2019-09-26T12:09:47.119Z"),

- "lastHeartbeatRecv" : ISODate("2019-09-26T12:09:47.667Z"),

- "pingMs" : NumberLong(0),

- "lastHeartbeatMessage" : "",

- "syncingTo" : "",

- "syncSourceHost" : "",

- "syncSourceId" : -1,

- "infoMessage" : "",

- "electionTime" : Timestamp(1569457173, 2),

- "electionDate" : ISODate("2019-09-26T00:19:33Z"),

- "configVersion" : 3

- },

- {

- "_id" : 1,

- "name" : "127.0.0.1:27018",

- "ip" : "127.0.0.1",

- "health" : 1,

- "state" : 2,

- "stateStr" : "SECONDARY",

- "uptime" : 43284,

- "optime" : {

- "ts" : Timestamp(1569499786, 1),

- "t" : NumberLong(1)

- },

- "optimeDate" : ISODate("2019-09-26T12:09:46Z"),

- "syncingTo" : "127.0.0.1:27017",

- "syncSourceHost" : "127.0.0.1:27017",

- "syncSourceId" : 0,

- "infoMessage" : "",

- "configVersion" : 3,

- "self" : true,

- "lastHeartbeatMessage" : ""

- },

- {

- "_id" : 2,

- "name" : "127.0.0.1:27019",

- "ip" : "127.0.0.1",

- "health" : 1,

- "state" : 2,

- "stateStr" : "SECONDARY",

- "uptime" : 42569,

- "optime" : {

- "ts" : Timestamp(1569499786, 1),

- "t" : NumberLong(1)

- },

- "optimeDurable" : {

- "ts" : Timestamp(1569499786, 1),

- "t" : NumberLong(1)

- },

- "optimeDate" : ISODate("2019-09-26T12:09:46Z"),

- "optimeDurableDate" : ISODate("2019-09-26T12:09:46Z"),

- "lastHeartbeat" : ISODate("2019-09-26T12:09:47.646Z"),

- "lastHeartbeatRecv" : ISODate("2019-09-26T12:09:47.036Z"),

- "pingMs" : NumberLong(0),

- "lastHeartbeatMessage" : "",

- "syncingTo" : "127.0.0.1:27018",

- "syncSourceHost" : "127.0.0.1:27018",

- "syncSourceId" : 1,

- "infoMessage" : "",

- "configVersion" : 3

- }

- ],

- "ok" : 1,

- "$clusterTime" : {

- "clusterTime" : Timestamp(1569499786, 1),

- "signature" : {

- "hash" : BinData(0,"AAAAAAAAAAAAAAAAAAAAAAAAAAA="),

- "keyId" : NumberLong(0)

- }

- },

- "operationTime" : Timestamp(1569499786, 1)

- }

副本集高可用

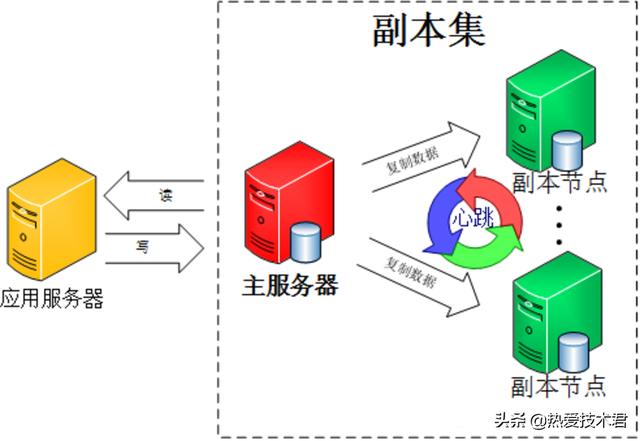

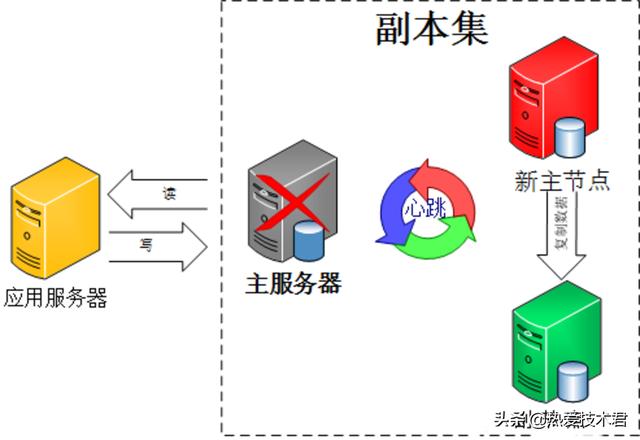

集群中的各節點還會通過傳遞心跳信息來檢測各自的健康狀況。當主節點故障時,多個從節點會觸發一次 新的選舉操作,并選舉其中的一個成為新的主節點(通常誰的優先級更高,誰就是新的主節點),心跳信息默認每 2 秒傳遞一次。

客戶端連接到副本集后,不關心具體哪一臺機器是否掛掉。主服務器負責整個副本集的讀寫,副本集定期同步數據備份。一旦主節點掛掉,副本節點就會選舉一個新的主服務器。這一切對于應用服務器不需要關心。

我們可以通過關閉主節點,測試是否會選舉新的主節點:

- gitlib@devops:~$ ps -aux | grep mongod

- root 14293 0.6 2.5 1888584 99504 ? Sl 08:06 4:39 bin/mongod -f mongod.conf

- root 14652 0.6 2.6 1923896 102200 ? Sl 08:08 4:59 bin/mongod -f mongod2.conf

- root 14723 0.6 2.5 1886124 98984 ? Sl 08:08 4:47 bin/mongod -f mongod3.conf

- gitlib@devops:~$ sudo kill -9 14293

- [sudo] password for zhoufei:

- zhoufei@devops:~$ ps -aux | grep mongod

- root 14652 0.6 2.6 1932092 102200 ? Sl 08:08 4:59 bin/mongod -f mongod2.conf

- root 14723 0.6 2.5 1894320 99064 ? Sl 08:08 4:47 bin/mongod -f mongod3.conf

我們直接kill掉主節點,進入節點1,看一下當前節點是否是主節點:

- gitlib@devops:~$ mongo 127.0.0.1:27018

- rs0:SECONDARY> rs.isMaster()

- {

- "hosts" : [

- "127.0.0.1:27017",

- "127.0.0.1:27018",

- "127.0.0.1:27019"

- ],

- "setName" : "rs0",

- "setVersion" : 3,

- "ismaster" : false,

- "secondary" : true,

- "primary" : "127.0.0.1:27019",

- "me" : "127.0.0.1:27018",

- ...

可以看到當主節點(127.0.0.1:27017)掛掉之后,主節點自動切換到從節點2(127.0.0.1:27019)上。

副本集選舉機制

副本集中的從節點在主節點掛掉后通過心跳機制檢測到后,就會在集群內發起主節點的選舉機制,自動選舉出一位新的主服務器。

副本集包括三種節點:主節點、從節點、仲裁節點。

- 主節點負責處理客戶端請求,讀、寫數據, 記錄在其上所有操作的oplog;

- 從節點定期輪詢主節點獲取這些操作,然后對自己的數據副本執行這些操作,從而保證從節點的數據與主節點一致。默認情況下,從節點不支持外部讀取,但可以設置,副本集的機制在于主節點出現故障的時候,余下的節點會選舉出一個新的主節點,從而保證系統可以正常運行。

- 仲裁節點不復制數據,僅參與投票。由于它沒有訪問的壓力,比較空閑,因此不容易出故障。由于副本集出現故障的時候,存活的節點必須大于副本集節點總數的一半,否則無法選舉主節點,或者主節點會自動降級為從節點,整個副本集變為只讀。因此,增加一個不容易出故障的仲裁節點,可以增加有效選票,降低整個副本集不可用的風險。仲裁節點可多于一個。也就是說只參與投票,不接收復制的數據,也不能成為活躍節點。

官方推薦MongoDB副本節點最少為3臺, 建議副本集成員為奇數,最多12個副本節點,最多7個節點參與選舉。限制副本節點的數量,主要是因為一個集群中過多的副本節點,增加了復制的成本,反而拖累了集群的整體性能。 太多的副本節點參與選舉,也會增加選舉的時間。而官方建議奇數的節點,是為了避免腦裂 的發生。

選舉過程

副本集的選舉過程大致如下:

得到每個服務器節點的最后操作時間戳。每個 mongodb都有oplog機制會記錄本機的操作,方便和主服務器進行對比數據是否同步還可以用于錯誤恢復。

如果集群中大部分服務器down機了,保留活著的節點都為secondary狀態并停止,不選舉了。

如果集群中選舉出來的主節點或者所有從節點最后一次同步時間看起來很舊了,停止選舉等待人來操作。

如果上面都沒有問題就選擇最后操作時間戳最新(保證數據是最新的)的服務器節點作為主節點。

MongoDB 同步延遲問題

在MongoDB中,所有寫操作都會產生 oplog,oplog 是每修改一條數據都會生成一條,如果你采用一個批量update命令更新了 N 多條數據,那么oplog 會有很多條,而不是一條。所以同步延遲就是寫操作在主節點上執行完后,從節點還沒有把 oplog 拿過來再執行一次。而這個寫操作的量越大,主節點與從節點的差別也就越大,同步延遲也就越大了。

分片

當MongoDB存儲海量的數據時,一臺機器可能不足以存儲數據,也可能不足以提供可接受的讀寫吞吐量。這時我們就可以通過在多臺機器上分割數據,使得數據庫系統能存儲和處理更多的數據。

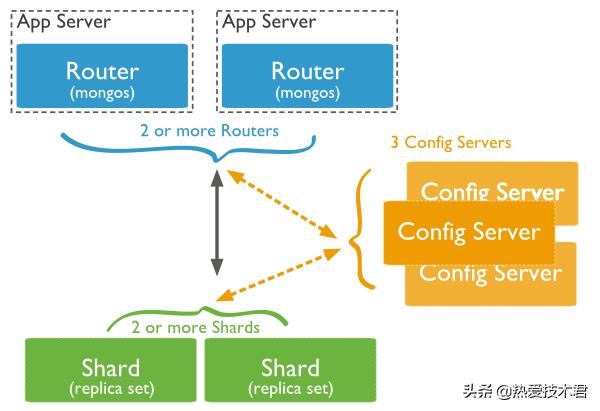

分片集群結構分布:

三個主要組件:

- Shard:數據存儲位置,以chunk為單位存數據,實際生產環境中一個shard server角色可由幾臺機器組個一個replica set承擔,防止主機單點故障;

- Config Server:mongod實例,存儲了整個ClusterMetadata,其中包括 chunk信息,默認需要配置3個Config Server節點;

- Query Routers:(Mongos) 前端路由,客戶端由此接入,且讓整個集群看上去像單一數據庫,前端應用可以透明使用。

Mongos本身并不持久化數據,Sharded Cluster所有的元數據都會存儲到Config Server,而用戶的數據會議分散存儲到各個shard。Mongos啟動后,會從配置服務器加載元數據,開始提供服務,將用戶的請求正確路由到對應的碎片。

Mongos的路由功能:

- 當數據寫入時,MongoDB Cluster根據分片鍵設計寫入數據。

- 當外部語句發起數據查詢時,MongoDB根據數據分布自動路由至指定節點返回數據。

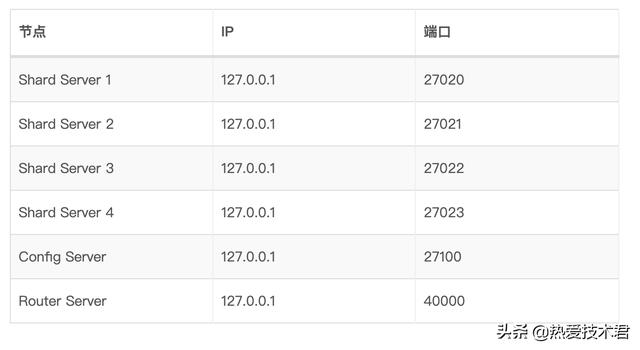

分片部署

條件有限,我們還是在單機上,用不同MongoDB線程來部署分片。

分片服務器

Shard Server和普通Mongod程序一樣,不同的是需要在配置文件中添加shardsvr=true標記為Shard Server,配置參考如下:

- # 指定數據庫路徑

- dbpath=/usr/local/mongodb/share/1/data/db

- # 使用追加的方式寫日志

- logpath=/usr/local/mongodb/share/1/log/mongodb.log

- # 使用追加的方式寫日志

- logappend = true

- # 綁定服務IP

- bind_ip=127.0.0.1

- # 服務器端口

- port = 27020

- # 以守護進程的方式運行MongoDB,創建服務器進程

- fork = true

- # PID File 的完整路徑

- pidfilepath=/usr/local/mongodb/var/mongod27020.pid

- # 不啟用驗證

- noauth=true

- # 最大同時連接數,默認2000

- maxConns=2000

- # 同步復制的日志大小設置,單位MB

- oplogSize=10

- # 設置為shared server

- shardsvr=true

以上配置復制4份,修改一下數據庫路徑/日志路徑/服務器IP和端口/PID路徑,啟動4個Shard Server:

- sudo bin/mongod -f shard1.conf

- sudo bin/mongod -f shard2.conf

- sudo bin/mongod -f shard3.conf

- sudo bin/mongod -f shard4.conf

配置服務器

4.0版本的MongoDB中配置服務器(Config Server)需要設置副本集,同時設置configsvr=true,配置參考如下:

- # 指定數據庫路徑

- dbpath=/usr/local/mongodb/share/5/data/db

- # 使用追加的方式寫日志

- logpath=/usr/local/mongodb/share/5/log/mongodb.log

- # 使用追加的方式寫日志

- logappend = true

- # 綁定服務IP

- bind_ip=127.0.0.1

- # 服務器端口

- port = 27100

- # 以守護進程的方式運行MongoDB,創建服務器進程

- fork = true

- # PID File 的完整路徑

- pidfilepath=/usr/local/mongodb/var/mongod27100.pid

- # 不啟用驗證

- noauth=true

- # 最大同時連接數,默認2000

- maxConns=2000

- # 同步復制的日志大小設置,單位MB

- oplogSize=10

- # 配置為config server

- configsvr=true

- # 副本集名稱

- replSet=rs0

啟動Config Server,并初始化副本集:

- sudo bin/mongod -f shard-config.conf

- mongo 127.0.0.1:27100

- > rs.initiaze()

新版本MongoDB建議設置多個Config Server,采用副本集形式設置集群,為了搭建方便,這里我們只采用單個Config Server。

路由服務器

Router Server不存放數據,配置參考如下:

- # 使用追加的方式寫日志

- logpath=/usr/local/mongodb/share/6/log/mongodb.log

- # 使用追加的方式寫日志

- logappend = true

- # 綁定服務IP

- bind_ip=127.0.0.1

- # 服務器端口

- port = 4000

- # 以守護進程的方式運行MongoDB,創建服務器進程

- fork = true

- # PID File 的完整路徑

- pidfilepath=/usr/local/mongodb/var/mongod4000.pid

- # 設置監聽的config服務器

- configdb=rs0/127.0.0.1:27100

啟動Router Server,路由服務器是由mongos命令啟動,與分片服務器及配置服務器不同。

- sudo bin/mongos -f shard-router.conf

啟動后,需要通過sh.addShard()命令添加分片服務器:

- sh.addShard('127.0.0.1:27020')

- sh.addShard('127.0.0.1:27021')

- sh.addShard('127.0.0.1:27022')

- sh.addShard('127.0.0.1:27023')

配置完成后,可以通過sh.status()命令,查看分片情況:

- mongos> sh.status()

- --- Sharding Status ---

- sharding version: {

- "_id" : 1,

- "minCompatibleVersion" : 5,

- "currentVersion" : 6,

- "clusterId" : ObjectId("5d8ddd1d94796dc650e29f67")

- }

- shards:

- { "_id" : "shard0000", "host" : "127.0.0.1:27020", "state" : 1 }

- { "_id" : "shard0001", "host" : "127.0.0.1:27021", "state" : 1 }

- { "_id" : "shard0002", "host" : "127.0.0.1:27022", "state" : 1 }

- { "_id" : "shard0003", "host" : "127.0.0.1:27023", "state" : 1 }

- active mongoses:

- "4.2.0" : 1

- autosplit:

- Currently enabled: yes

- balancer:

- Currently enabled: yes

- Currently running: no

- Failed balancer rounds in last 5 attempts: 0

- Migration Results for the last 24 hours:

- No recent migrations

- databases:

- { "_id" : "config", "primary" : "config", "partitioned" : true }

- config.system.sessions

- shard key: { "_id" : 1 }

- unique: false

- balancing: true

- chunks:

- shard0000 1

- { "_id" : { "$minKey" : 1 } } -->> { "_id" : { "$max