幾十億數據查詢3秒返回,ES性能優化實戰!

公司的數據平臺已迭代三個版本,從頭開始遇到很多常見的難題,終于有時間整理一些完善的文檔,在此分享以供所需的朋友。

圖片來自 Pexels

在此篇幅中偏重于 ES 的優化,關于 HBase,Hadoop 的設計優化有很多文章可以參考,不再贅述。

需求說明

項目背景:在一業務系統中,部分表每天的數據量過億,已按天分表,但業務上受限于按天查詢,并且 DB 中只能保留 3 個月的數據(硬件高配),分庫代價較高。

改進版本目標:

- 數據能跨月查詢,并且支持 1 年以上的歷史數據查詢與導出。

- 按條件的數據查詢秒級返回。

Elasticsearch 檢索原理

①關于 ES 和 Lucene 基礎結構

談到優化必須能了解組件的基本原理,才容易找到瓶頸所在,以免走多種彎路。

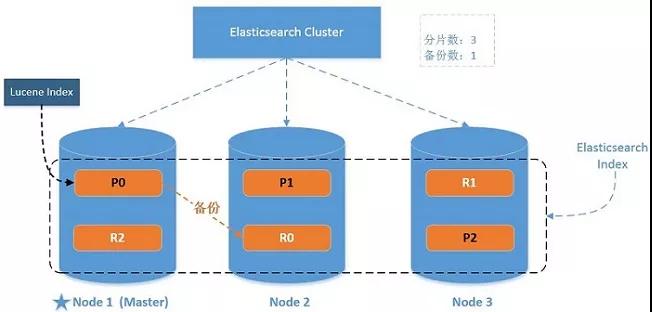

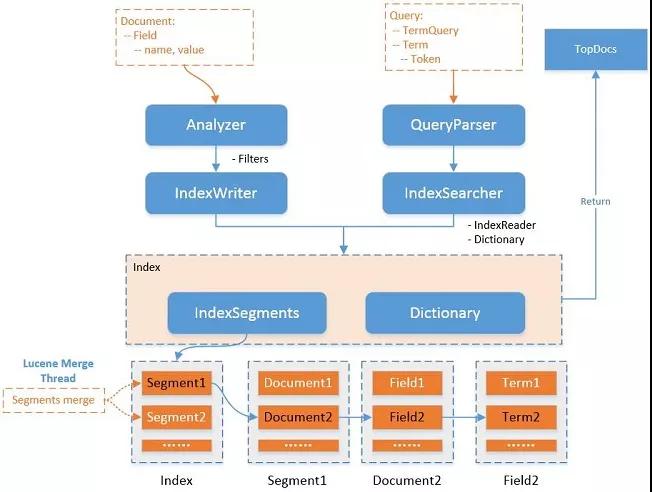

先從 ES 的基礎結構說起(如下圖):

一些基本概念:

- Cluster 包含多個 Node 的集群。

- Node 集群服務單元。

- Index 一個 ES 索引包含一個或多個物理分片,它只是這些分片的邏輯命名空間。

- Type 一個 index 的不同分類,6.x 后只能配置一個 Type,以后將移除。

- Document 最基礎的可被索引的數據單元,如一個 JSON 串。

- Shards 一個分片是一個底層的工作單元,它僅保存全部數據中的一部分,它是一個 Lucence 實例。

一個 Lucene 索引最大包含 2,147,483,519 (= Integer.MAX_VALUE - 128)個文檔數量。

- Replicas 分片備份,用于保障數據安全與分擔檢索壓力。

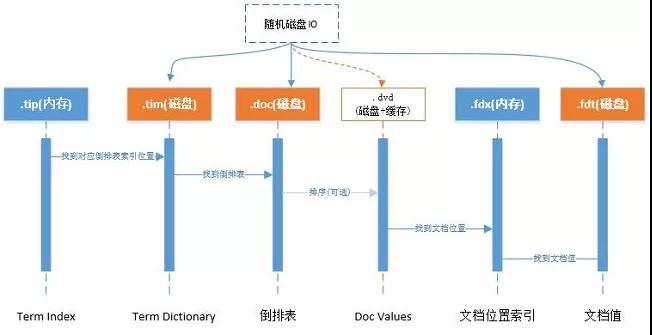

ES 依賴一個重要的組件 Lucene,關于數據結構的優化通常來說是對 Lucene 的優化,它是集群的一個存儲與檢索工作單元,結構如下圖:

在 Lucene 中,分為索引(錄入)與檢索(查詢)兩部分,索引部分包含分詞器、過濾器、字符映射器等,檢索部分包含查詢解析器等。

一個 Lucene 索引包含多個 Segments,一個 Segment 包含多個文檔,每個文檔包含多個字段,每個字段經過分詞后形成一個或多個 Term。

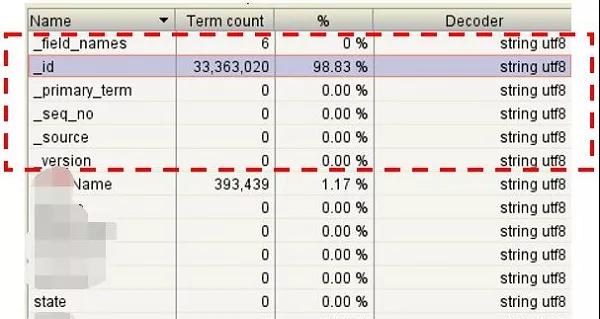

通過 Luke 工具查看 ES 的 Lucene 文件如下,主要增加了 _id 和 _source 字段:

②Lucene 索引實現

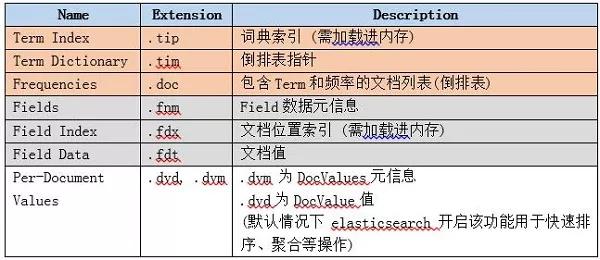

Lucene 索引文件結構主要的分為:詞典、倒排表、正向文件、DocValues 等。

如下圖:

整理來源于 Lucene 官方:

- http://lucene.apache.org/core/7_2_1/core/org/apache/lucene/codecs/lucene70/package-summary.html#package.description

Lucene 隨機三次磁盤讀取比較耗時。其中 .fdt 文件保存數據值損耗空間大,.tim 和 .doc 則需要 SSD 存儲提高隨機讀寫性能。另外一個比較消耗性能的是打分流程,不需要則可屏蔽。

關于 DocValues:倒排索引解決從詞快速檢索到相應文檔 ID, 但如果需要對結果進行排序、分組、聚合等操作的時候則需要根據文檔 ID 快速找到對應的值。

通過倒排索引代價卻很高:需迭代索引里的每個詞項并收集文檔的列里面 Token。

這很慢而且難以擴展:隨著詞項和文檔的數量增加,執行時間也會增加。

Solr docs 對此的解釋如下:

- For other features that we now commonly associate with search, such as sorting, faceting, and highlighting, this approach is not very efficient. The faceting engine,

- for example, must look up each term that appears in each document that will make up the result set and pull the document IDs in order to build the facet list. In Solr, this is maintained in memory, and can be slow to load (depending on the number of documents, terms, etc.)

在 Lucene 4.0 版本前通過 FieldCache,原理是通過按列逆轉倒排表將(field value->doc)映射變成(doc->field value)映射,問題為逐步構建時間長并且消耗大量內存,容易造成 OOM。

DocValues 是一種列存儲結構,能快速通過文檔 ID 找到相關需要排序的字段。

在 ES 中,默認開啟所有(除了標記需 analyzed 的字符串字段)字段的 doc values,如果不需要對此字段做任何排序等工作,則可關閉以減少資源消耗。

③關于 ES 索引與檢索分片

ES 中一個索引由一個或多個 Lucene 索引構成,一個 Lucene 索引由一個或多個 Segment 構成,其中 Segment 是最小的檢索域。

數據具體被存儲到哪個分片上:

- shard = hash(routing) % number_of_primary_shards

默認情況下 routing 參數是文檔 ID (murmurhash3),可通過 URL 中的 _routing 參數指定數據分布在同一個分片中,index 和 search 的時候都需要一致才能找到數據。

如果能明確根據 _routing 進行數據分區,則可減少分片的檢索工作,以提高性能。

優化案例

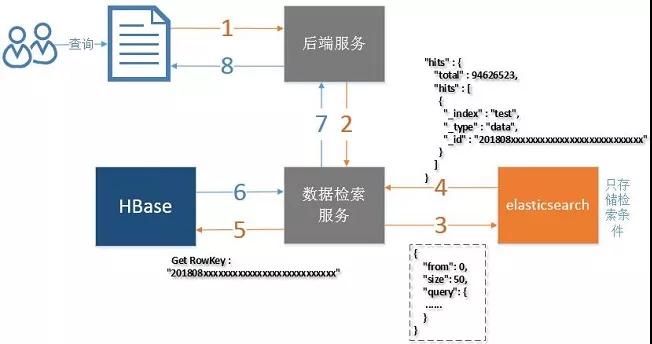

在我們的案例中,查詢字段都是固定的,不提供全文檢索功能,這也是幾十億數據能秒級返回的一個大前提:

- ES 僅提供字段的檢索,僅存儲 HBase 的 Rowkey 不存儲實際數據。

- 實際數據存儲在 HBase 中,通過 Rowkey 查詢,如下圖。

- 提高索引與檢索的性能建議,可參考官方文檔:

- https://www.elastic.co/guide/en/elasticsearch/reference/current/tune-for-indexing-speed.html

一些細節優化項官方與其他的一些文章都有描述,在此文章中僅提出一些本案例的重點優化項。

優化索引性能

①批量寫入,看每條數據量的大小,一般都是幾百到幾千。

②多線程寫入,寫入線程數一般和機器數相當,可以配多種情況,在測試環境通過 Kibana 觀察性能曲線。

③增加 Segments 的刷新時間,通過上面的原理知道,Segment 作為一個最小的檢索單元。

比如 Segment 有 50 個,目的需要查 10 條數據,但需要從 50 個 Segment 分別查詢 10 條,共 500 條記錄,再進行排序或者分數比較后,截取最前面的 10 條,丟棄 490 條。

在我們的案例中將此 "refresh_interval": "-1" ,程序批量寫入完成后進行手工刷新(調用相應的 API 即可)。

④內存分配方面,很多文章已經提到,給系統 50% 的內存給 Lucene 做文件緩存,它任務很繁重,所以 ES 節點的內存需要比較多(比如每個節點能配置 64G 以上最好)。

⑤磁盤方面配置 SSD,機械盤做陣列 RAID5 RAID10 雖然看上去很快,但是隨機 IO 還是 SSD 好。

⑥使用自動生成的 ID,在我們的案例中使用自定義的 KEY,也就是與 HBase 的 ROW KEY,是為了能根據 Rowkey 刪除和更新數據,性能下降不是很明顯。

⑦關于段合并,合并在后臺定期執行,比較大的 Segment 需要很長時間才能完成。

為了減少對其他操作的影響(如檢索),Elasticsearch 進行閾值限制,默認是 20MB/s,可配置的參數(根據磁盤性能調整):

- "indices.store.throttle.max_bytes_per_sec" : "200mb"

合并線程數默認是:

- Math.max(1, Math.min(4, Runtime.getRuntime().availableProcessors() / 2))

如果是機械磁盤,可以考慮設置為 1:

- index.merge.scheduler.max_thread_count: 1

在我們的案例中使用 SSD,配置了 6 個合并線程。

優化檢索性能

①關閉不需要字段的 doc values。

②盡量使用 keyword 替代一些 long 或者 int 之類,term 查詢總比 range 查詢好 (參考 Lucene 說明 )。

- http://lucene.apache.org/core/7_4_0/core/org/apache/lucene/index/PointValues.html

③關閉不需要查詢字段的 _source 功能,不將此存儲僅 ES 中,以節省磁盤空間。

④評分消耗資源,如果不需要可使用 filter 過濾來達到關閉評分功能,score 則為 0,如果使用 constantScoreQuery 則 score 為 1。

⑤關于分頁

from+size:每分片檢索結果數最大為 from+size,假設 from=20,size=20,則每個分片需要獲取 20*20=400 條數據。

多個分片的結果在協調節點合并(假設請求的分配數為 5,則結果數最大為 400*5=2000 條)再在內存中排序后,然后 20 條給用戶。

這種機制導致越往后分頁獲取的代價越高,達到 50000 條將面臨沉重的代價,默認 from+size 默認如下:

- index.max_result_window :10000

search_after:使用前一個分頁記錄的最后一條來檢索下一個分頁記錄。

在我們的案例中,首先使用 from+size,檢索出結果后再使用 search_after,在頁面上我們限制了用戶只能跳 5 頁,不能跳到最后一頁。

scroll:用于大結果集查詢,缺陷是需要維護 scroll_id。

⑥關于排序:我們增加一個 long 字段,它用于存儲時間和 ID 的組合(通過移位即可),正排與倒排性能相差不明顯。

⑦關于 CPU 消耗,檢索時如果需要做排序則需要字段對比,消耗 CPU 比較大,如果有可能盡量分配 16cores 以上的 CPU,具體看業務壓力。

⑧關于合并被標記刪除的記錄,我們設置為 0 表示在合并的時候一定刪除被標記的記錄,默認應該是大于 10% 才刪除:

- "merge.policy.expunge_deletes_allowed": "0"

- {

- "mappings": {

- "data": {

- "dynamic": "false",

- "_source": {

- "includes": ["XXX"] -- 僅將查詢結果所需的數據存儲僅_source中

- },

- "properties": {

- "state": {

- "type": "keyword", -- 雖然state為int值,但如果不需要做范圍查詢,盡量使用keyword,因為int需要比keyword增加額外的消耗。

- "doc_values": false -- 關閉不需要字段的doc values功能,僅對需要排序,匯聚功能的字段開啟。

- },

- "b": {

- "type": "long" -- 使用了范圍查詢字段,則需要用long或者int之類 (構建類似KD-trees結構)

- }

- }

- }

- },

- "settings": {......}

- }

性能測試

優化效果評估基于基準測試,如果沒有基準測試無法了解是否有性能提升,在這所有的變動前做一次測試會比較好。

在我們的案例中:

- 單節點 5000 萬到 1 億的數據量測試,檢查單點承受能力。

- 集群測試 1 億-30 億的數量,磁盤 IO/內存/CPU/網絡 IO 消耗如何。

- 隨機不同組合條件的檢索,在各個數據量情況下表現如何。

- 另外 SSD 與機械盤在測試中性能差距如何。

性能的測試組合有很多,通常也很花時間,不過作為評測標準時間上的投入有必要,否則生產出現性能問題很難定位或不好改善。

對于 ES 的性能研究花了不少時間,最多的關注點就是 Lucene 的優化,能深入了解 Lucene 原理對優化有很大的幫助。

生產效果

目前平臺穩定運行,幾十億的數據查詢 100 條都在 3 秒內返回,前后翻頁很快,如果后續有性能瓶頸,可通過擴展節點分擔數據壓力。