Reddit網友吵爆!算力和數據真能解決一切?

眾所周知,算力和數據非常重要,但只有它們就夠了嗎?

近日,一位reddit用戶發起一個討論帖:如果我們只有更多的數據和計算能力而停止理論工作的發展,今天的哪些問題可以解決?哪些問題絕對無法解決?

這個問題引發了reddit網友的熱烈討論:

MrAcurite表示:我猜想任何涉及罕見疾病診斷的事情。我們沒有更多數據,因為數據不存在。但這只是一個猜測,也許小樣本學習還是可以解決這個問題的。

MichaelMMeskhi回復道:小樣本學習并不解決任何問題。如果我們有數據,那么以往的的深度學習就可以了。但是從理論上講,小樣本學習可能能做到。

pm-me-your-covfefes表示:

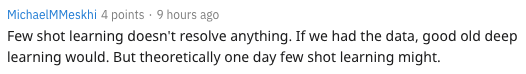

我想說的是,有了足夠的數據,我們可以找到大多數問題的解決方案,但這并不能使問題解決(或更容易解決)。

我是美國最大的醫療保健公司的高級數據科學總監。我們很龐大。我們基本上有你想知道的任何事情的數據。我懷疑除了中國的醫療體系之外,沒有其他機構擁有比我們更多的醫療數據。

有了這些數據,我們就可以制作成千上萬的生產模型,這些模型比我在公開場合甚至私下里看到的任何東西都讓人印象深刻。這包括那些試圖進入醫療行業的“性感”科技公司所做的一切。

但是,這些模型對改善醫療保健并不重要。我們有一些模型可以很容易地預測出每種疾病(甚至是最罕見的疾病)。疾病預測模型根本不是新穎的。也許10到15年前。這些模型對改善醫療保健甚至沒有真正的幫助。

以糖尿病預測模型為例。我不需要一個花哨的模型來告訴我,這個350磅重、每天吃兩個漢堡的不聽話的病人,將會得2型糖尿病。但是,即使當他們被告知“嗨,你應該改變你的飲食和生活方式”,他們的病情隨著時間的推移只會變得越來越嚴重和惡化(90%的概率)。這只會讓他們的健康狀況惡化,花更多的錢。

長話短說,至少在醫療保健領域,即使沒有無限的數據,我們也可以創建我們想要的所有幻想模型,但這無助于解決問題,因為在大多數情況下,問題只是人(患者和providers)。我想對于其他依賴于人們做出他們可能不想做的改變的行業來說,情況也是一樣的。

DoorsofPerceptron表示:“基本上,我認為可以使用無限標記的數據和近鄰取樣解決任何問題。如果你有足夠的數據,那么你應該已經看過這一場景,你只需查找答案即可。

我們也可以大幅改進現有的深度學習方法,僅僅通過在問題上拋出足夠的計算來找到最優的架構和在搜索空間上的brute forcing,而不是試圖想出一些聰明的東西。(在某種程度上,行業已經做到了這一點,這就是為什么很多最好的架構都來自谷歌這樣的地方)。

如果你不需要擔心計算或數據,則可以通過關注探索/利用tradeoff的探索部分來最佳地進行強化學習。

因此,將需要更多地限制問題。對于無限的數據和無限的計算,我認為我們甚至不需要現代方法來解決所有問題。”

m--w認為:對于現代計算而言,大規模貝葉斯推理仍然過于昂貴。

談到哪些問題是絕對解決不了的,Phylliida表示:

我們甚至還沒有一個理論模型來解釋如何使技術奇點發生。例如,對于許多理論問題,我們可以說“如果我們有一個形式問題X(如P=NP)的解決方案,我們就可以解決這個問題”。對于奇點我們也不能說,因為它還沒有一個正式的定義。即使我們能夠以某種方式解決halting問題,我們也沒有一條清晰的路徑去達到技術奇點(不,AIXI不是這樣的理論,AIXI描述了一個在一個有明確行動和回報的環境中的optimal agent)。

對于AGI來說也是如此,盡管在AGI的情況下,至少具有足夠的計算能力和數據,我們可以通過試圖復制人類行為來制作人類智能的“duck typed”(如果它看起來像鴨子,并且行為像鴨子,那就是鴨子)模型。我們認為這是使用talktoatransformer進行的小規模操作,尚不足以進行對話,但是subreddit模擬器GPT2非常逼真,而這正是我們目前擁有的計算能力和數據。

Turings_Ego則認為:我認為我們應該走另一條路。該領域在很大程度上受到數據集/基準測試的經驗支持。如果我們真的想解決更復雜的問題,就需要做大量的工作來理解收斂性和什么不是收斂性。我預感到拓撲數據分析將提供這些證明的一些關鍵方面。

人工智能進步來自計算力?周志華:絕對錯誤!

再來看看國內的AI大佬們是如何看待算力和數據的。

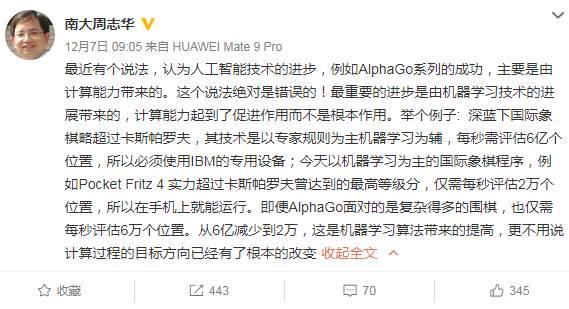

對于“人工智能進步是計算能力帶來的”這種觀點,南大周志華教授曾表示:這個說法絕對錯誤的!周老師將IBM深藍和AlphaGo做對比,深藍下國際象棋每秒需要評估6億個位置,而AlphaGo面對更加復雜的圍棋,每秒也僅需評估2萬個位置,“從6億到2萬,這是機器學習算法帶來的提高,更不用說是計算過程的目標方向已經有了根本的改變”。

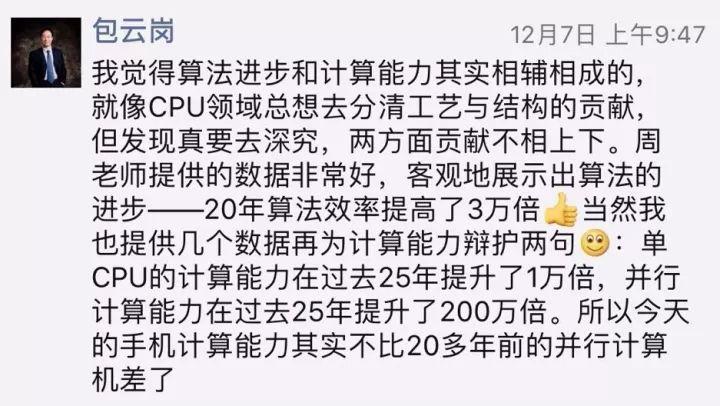

對此,中科院計算所先進計算機系統研究中心主任包云崗回應,算法起到了至關重要的作用,而計算力的進步也不可或缺。包云崗用“登月”來類比兩者相輔相成的關系。“AI進步中算法的作用是導航+一級火箭,計算能力的作用相當于二級+三級火箭”,對于登月缺一不可。包云崗還表示,周老師提供的數據,從IBM評估6億個位置到AlphaGo評估2萬個,“20年算法效率提高了3萬倍”,客觀展示了算法的進步。

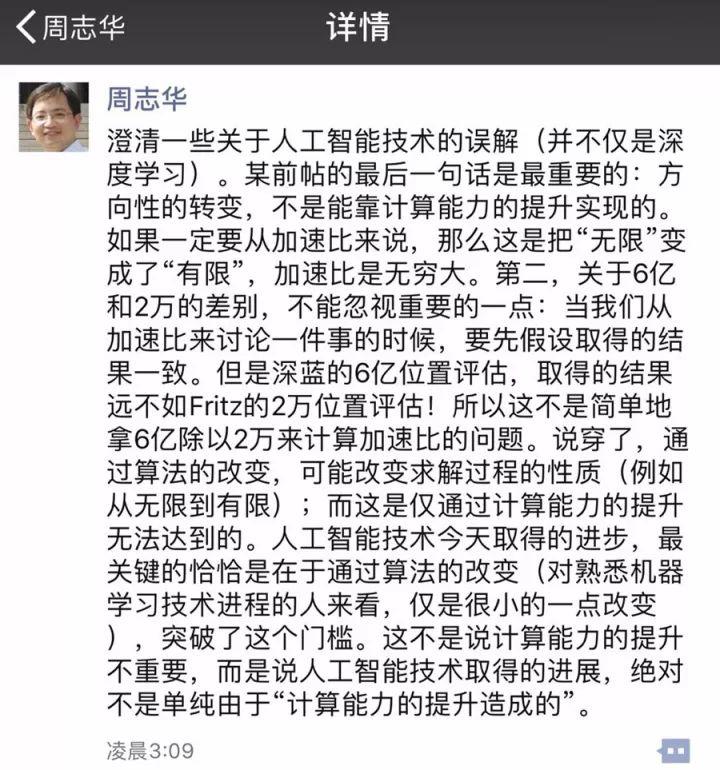

對此,周志華教授表示,不是說計算能力的提升不重要,而是說人工智能技術取得的進展,絕對不是單純由于“計算能力的提升造成的”。周老師做了進一步闡釋:方向性的轉變,不是能靠計算能力的提升實現的。如果算法沒有取得突破,仍然依靠專家規則,哪怕是研發出量子計算機來加速也沒有用。

此外,關于6億和2萬的位置評估,兩者取得的結果并不一致。因此,不能簡單地拿6億除以2萬來計算加速比。周志華教授說,算法的改變可能改變求解過程的性質,今天人工智能取得的進步恰恰是通過這一點,而且這是僅通過計算能力的提升無法實現的。

Hinton 認為未來的 AI 系統將主要是無監督的。無監督學習是機器學習的一個分支,可以從未標記、未分類的測試數據中提取知識 —— 在學習共性和對共性是否存在做出反應的能力方面,無監督學習的能力幾乎達到人類水平。

Hinton 說:“如果你采用一個擁有數十億參數的系統,對某個目標函數執行隨機梯度下降,它的效果會比你想象的好得多…… 規模越大,效果越好。”

神經網絡和深度學習在幾十年前失敗,但是現在卻成功了,原因是什么?而它的局限又在什么地方?賈揚清曾談到:

- 成功的原因,一點是大數據,一點是高性能計算。

- 局限的原因,一點是結構化的理解,一點是小數據上的有效學習算法。

阿里巴巴副總裁賈揚清認為:“大量的數據,比如說移動互聯網的興起,以及 AWS 這樣低成本獲得標注數據的平臺,使機器學習算法得以打破數據的限制;由于 GPGPU 等高性能運算的興起,又使得我們可以在可以控制的時間內(以天為單位甚至更短)進行 exaflop 級別的計算,從而使得訓練復雜網絡變得可能。要注意的是,高性能計算并不僅限于 GPU ,在 CPU 上的大量向量化計算,分布式計算中的 MPI 抽象,這些都和 60 年代就開始興起的 HPC 領域的研究成果密不可分。

但是,我們也要看到深度學習的局限性。今天,很多深度學習的算法還是在感知這個層面上形成了突破,可以從語音、圖像,這些非結構化的數據中進行識別的工作。在面對更加結構化的問題的時候,簡單地套用深度學習算法可能并不能達到很好的效果。有的同學可能會問為什么 AlphaGo 和 Starcraft 這樣的算法可以成功, 一方面,深度學習解決了感知的問題,另一方面,我們也要看到還有很多傳統的非深度學習算法,比如說 Q-learning 和其他增強學習的算法,一起支撐起了整個系統。而且,在數據量非常小的時候,深度學習的復雜網絡往往無法取得很好的效果,但是很多領域,特別是類似醫療這樣的領域,數據是非常難獲得的,這可能是接下去的一個很有意義的科研方向。

接下去,深度學習或者更廣泛地說,AI 這個方向會怎么走?我個人的感覺,雖然大家前幾年一直關注 AI 框架,但是近年來框架的同質化說明了它不再是一個需要花大精力解決的問題,TensorFlow 這樣的框架在工業界的廣泛應用,以及各種框架利用 Python 在建模領域的優秀表現,已經可以幫助我們解決很多以前需要自己編程實現的問題,因此,作為 AI 工程師,我們應該跳出框架的桎梏,往更廣泛的領域尋找價值。”