深度學習?不一定非得搞“黑箱”

深度神經網絡的參數網絡極其龐大復雜,也因此讓機器得以實現以往難以想象的各類功能。然而,這種復雜性也成為制約其廣泛應用的禍根:神經網絡的內部工作機理一直是個謎,就連創建者自己也搞不清它到底怎么做出決策。自深度學習在2010年初全面流行以來,這個難題一直困擾著人工智能業界。

隨著深度學習在各個領域及應用中的拓展,人們對根據神經網絡的結果以及學習到的參數組合來解釋神經網絡技術原理的興致也越來越高。然而,這些解釋方法往往并不靠譜,甚至充滿種種誤導性。更要命的是,這一切對于在訓練過程中修復深度學習模型內的偏差/偏見幾乎沒有任何實際意義。

最近,《自然:機器智能》雜志發表了一篇經過同行評審的論文,杜克大學的科學家們在其中提出了“概念白化(concept whitening)”技術,希望在不犧牲性能的前提下引導神經網絡學習特定概念。概念白化將可解釋性引入深度學習模型,而不再由模型自主在數百萬訓練得出的參數中尋找答案。這項技術適用于卷積神經網絡,展示出令人鼓舞的結果,亦有望為人工智能的未來發展及研究產生重大影響。

深度學習模型的特征與潛在空間

面對質量過硬的訓練示例,擁有正確架構的深度學習模型應該有能力區分不同類型的輸入素材。例如,在計算機視覺任務場景下,經過訓練的神經網絡能夠將圖像的像素值轉換為相應的類別。(由于概念白化主要適用于圖像識別,因此我們這里主要討論機器學習任務的這一特定子集。當然,本文涉及的很多內容同樣適用于整個深度學習領域。)

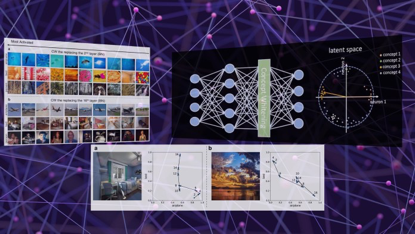

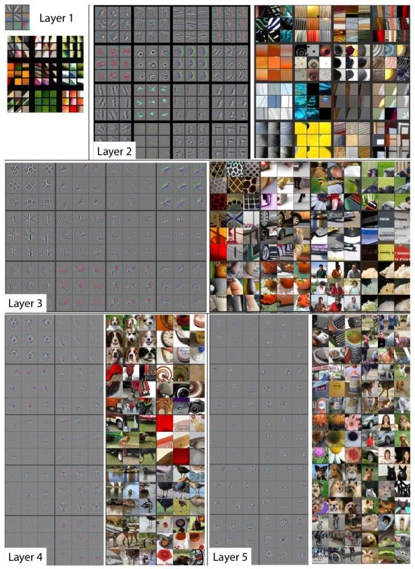

在訓練期間,深度學習模型的每一層都會將訓練圖像的特征編碼為一組數值,并將其存儲在參數當中。這個過程,即AI模型的潛在空間。通常,多層卷積神經網絡中的較低層負責學習基本特征,例如角度和邊界。神經網絡的較高層則學習檢測更復雜的特征,例如人臉、物體、完整場景等。

圖注:神經網絡中的各層都會對輸入圖像中的特定特征進行編碼。

在理想情況下,神經網絡的潛在空間應代表與待檢測圖像類別相關的概念。但我們并不確定,因為深度學習模型往往傾向于學習最具區分性的特征——即使這些特征與結論并無因果關聯。

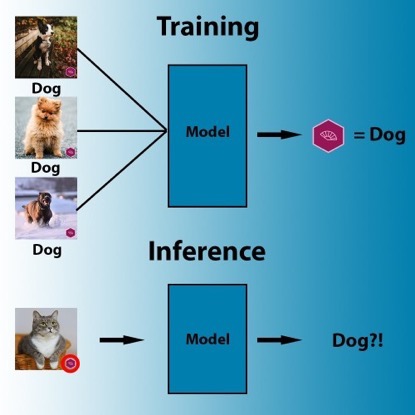

例如,以下數據集中包含小貓的每一張圖像,右下角都恰巧有個徽標。人類能夠很快發現,徽標跟小貓沒有任何關系。但深度學習模型卻很可能選擇取巧路線,即認定右下角有徽標的就是包含小貓的圖像。同樣的,如果訓練集中所有包含綿羊的圖像都有草地背景,那么神經網絡學會的很可能是檢測草地、而非綿羊。

圖注:在訓練期間,機器學習算法會搜索最容易將像素與標簽關聯起來的訪問模式。

因此,除了深度學習模型在訓練與測試數據集上的實際表現之外,更重要的是理解模型到底學會檢測出哪些概念與特征。經典解釋技術也正是從這個角度試圖解決問題。

神經網絡的事后解釋

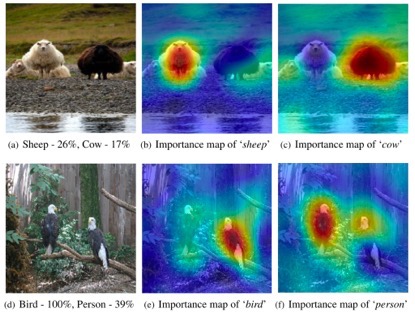

大部分深度學習解釋技術都具有事后特性,意味著只能通過檢查輸出結果及參數值對經過訓練的神經網絡加以評估。例如,目前一種用于確定神經網絡在圖像中到底在觀察哪些對象的流行技術,就嘗試遮擋住輸入圖像中的不同部分,并觀察這些變化會給深度學習模型的輸出造成哪些影響。這項技術有助于創建熱圖,突出顯示與神經網絡相關度最高的各項圖像特征。

圖注:顯著性圖示例

其他事后技術還包括開啟及關閉不同人工神經元,檢查這些調整如何影響AI模型的輸出。這些方法同樣有助于找到相關特征與潛在空間之間的映射關系。

雖然這些方法效果不錯,但本質上仍是在以“黑箱”形式看待深度學習模型,無法真正描繪出神經網絡的確切情況。

白皮書作者寫道,“「解釋」方法通常屬于性能的摘要統計信息(例如局部逼近、節點激活的總體趨勢等),而非對模型計算的實際解釋。”

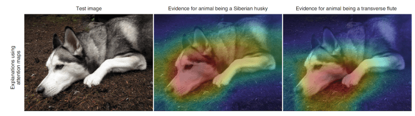

例如,顯著性圖的問題在于,它們往往無法發現神經網絡學習到錯誤信息的問題。當神經網絡的特征分散在潛在空間中時,解釋單一神經元的作用將變得極為困難。

圖注:顯著性圖解釋,無法準確表示黑箱AI模型如何做出最終判斷。

杜克大學計算機科學專業學生、概念白化論文第一作者在采訪中表示,“深度神經網絡(NN)在圖像識別方面非常強大,但由于極為復雜,我們無法理解神經網絡隱藏層中的學習過程。這種可解釋性缺失,導致神經網絡變得不可信且難以實際應用。以往大部分事后解釋只是在努力分析模型學到了什么,例如各個神經元具體學到了什么概念。但這些方法仍然嚴重依賴于這樣一個假設:這些概念已經被網絡所學會(并不一定),而且只集中在一個神經元上(同樣并不一定)。”

杜克大學計算機科學教授、概念白化論文聯合作者Cynthia Rudin之前曾就信任黑箱解釋技術的危險性發出警告,并表示此類方法有可能給出錯誤的神經網絡解釋。在之前發表在《自然:機器智能》雜志上的另一篇論文中,Rudin鼓勵使用并開發天然具有可解釋性的AI模型。作為博士導師,Rudin領導著杜克大學的預測分析實驗室(此實驗室專注于研究機器學習的可解釋性課題)。

概念白化的目標在于開發神經網絡,其潛在空間將與訓練過程中學會的概念相匹配。這種方法使深度學習模型真正具有可解釋性,同時也極大降低了在輸入圖像的特征與神經網絡輸出之間建立關系映射的難度。

Rudin在采訪中表示,“我們的工作直接改變了神經網絡處理潛在空間的方式,讓關系軸真正與已知概念對應起來。”

將概念融入神經網絡

深度學習模型通常會在經過標記的單一數據集上完成訓練。概念白化則引入了包含概念示例的第二套數據集。這些概念與AI模型的核心任務有關。例如,如果您的深度學習模型給出“臥室”這一檢測結果,則相關概念將涵蓋床、冰箱、燈、窗戶及門等。

Chen指出,“代表性樣本可以手動選擇,因為它們有望構建我們對可解釋性的定義。機器學習從業者可以通過任何方式收集這些樣本,借此建立起適合自身應用的具體概念數據集。例如,我們可以要求醫師選擇具有代表性的X光片來定義各項醫學概念。”

通過概念白化,深度學習模型將經歷兩個并行的訓練周期。神經網絡會調整自身總體參數以表示主要任務中的類,而概念白化技術則調整各層中的特定神經元,使其與概念數據集中包含的類對齊。

這樣的結果,就是造成一個糾纏的潛在空間,其中各個概念將在每層中整齊分布,神經元的激活也與其各自概念相對應。Chen表示,“這種糾纏使我們能夠對網絡如何一層層學習概念擁有更清晰的理解。”

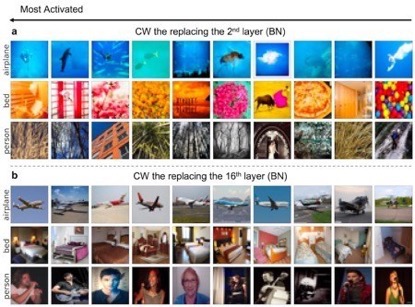

為了評估這項技術的有效性,研究人員通過深度學習模型(在不同層上插入概念白化模塊)運行一系列驗證圖像。接下來,他們根據每一層上激活的概念神經元對圖像進行分類。在較低的層中,概念白化模塊能夠捕捉到低級特征,例如顏色及紋理。舉例來說,網絡能夠通過較低層意識到藍色背景下的白色物體可能與“飛機”概念緊密相關,而帶有暖色的圖像則更可能包含“床”的概念。在較高層中,網絡將學習如何對代表該概念的對象進行分類。

圖注:概念白化會在較低層學習低級信息(例如顏色、紋理),在較高層學習高級信息(例如對象、人)。

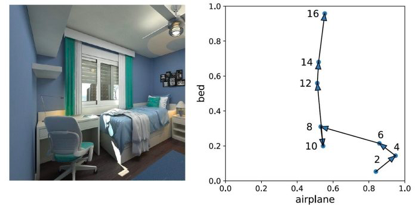

概念糾紛與對齊的一大優勢,是保證神經網絡不會犯下太過低級的錯誤。當圖像通過網絡運行時,較高層中的概念神經元會糾正較低層中可能發生的钷。例如,在下圖當中,由于密集存在大量藍色與白色像素,因此神經網絡的較低層錯誤將圖像與“飛機”概念關聯了起來。但當圖像轉移到較高層中時,概念神經元開始幫助模型將結果導向正確的方向(右圖為可視化糾正過程)。

圖注:當圖像從神經網絡的較低層轉移至較高層時,概念白化有助于糾正誤解和錯誤。

以往的模型可解釋性嘗試往往強調創建分類器,利用這些分類器通過神經網絡潛在空間中的值推理概念。但根據Chen的解釋,在不存在糾纏潛在空間的情況下,通過這類方法學習到的概念并不純粹,很可能將概念神經元的預測分數關聯起來。“以往人們雖然嘗試用監督方式破解神經網絡之謎,但他們并沒有真正解開謎題本身。另一方面,概念白化則通過白化轉換對各關系軸進行關聯性分解,借此真正理解模型的概念映射思路。”

將概念白化引入深度學習應用

概念白化是一類能夠插入卷積神經網絡的模塊,而非批量歸一化模塊。批量歸一化技術誕生于2015年,這是一種流行技術,能夠調整用于神經網絡訓練的數據分布,借此加快訓練速度并避免出現過度擬合等問題。目前最流行的卷積神經網絡均已在各層中使用批量歸一化技術。

除了批量歸一化功能之外,概念白化還能讓數據沿著代表相關概念的多條軸實現對齊。

概念白化架構的優勢在于,它能夠輕松被集成至多種現有深度學習模型當中。通過研究,科學家們使用概念白化替代批量歸一化模塊,借此修改了多種經過預訓練的流行深度學習模型,并僅用一輪訓練就達到了預期效果。(一個輪次,代表深度學習模型通過完整訓練集進行訓練的整個周期。深度學習模型在從零開始進行訓練時,往往需要經歷多個輪次。)

Rudin指出,“概念白化有望被廣泛應用于醫學成像等高度強調可解釋性的領域。”

在實驗當中,研究人員將概念白化應用于皮膚病變診斷深度學習模型當中。他們在論文中寫道,“概念白化潛在空間上測量出的概念重要性評分能夠提供重要的洞見,幫助我們了解哪些概念在皮膚病變診斷中更具意義。”

Chen表示,“為了未來的持續發展,我們認為可能應該脫離預定義的概念,轉而從數據集中發現這些概念——特別是那些尚未被發現的重要概念。以此為基礎,我們能夠以糾纏方式在神經網絡的潛在空間內明確表示這些概念,進一步提高模型的可解釋性。”

目前研究的另一個重要方向,是在分層結構中組織概念,由此建立起概念集群以替代彼此孤立的個體概念。

深度學習研究帶來的啟示

隨著深度學習模型變得越來越龐大、越來越復雜,業界對于如何實現神經網絡透明性也開始產生明顯的意見分歧。

一種意見強調觀察AI模型的行為,而非徒勞地觀察黑箱內部。這種方法也是人們研究動物乃至人類大腦、設計實驗并記錄激活方式時采取的思路。這種理論的支持者們認為,任何對神經網絡施加可解釋性設計約束,都必然會導致模型質量下降。如果大腦能夠從無到有經過數十億次迭代進化出智能,神經網絡也應該可以通過這種純進化途徑達成相同的效果。

概念白化的出現反駁了這一理論,并證明我們能夠在不造成任何性能損失的前提下,對神經網絡施加自上而下的設計約束。有趣的是,實驗表明深度學習模型在引入概念白化模塊后確實能夠提供可解釋性,且核心推理任務的準確性不會發生任何顯著下降。

Rudin總結道,“概念白化以及我們乃至更多其他研究實驗室的成果已經全面證明,構建可解釋模型又不損害其性能確有客觀可行性。我們希望這項工作能夠改變人們對黑箱模型機制的盲目推崇,吸引更多參與者立足各自領域建立起具備可解釋性的機器學習模型。”