聽說你的多智能體強化學習算法不work?你用對MAPPO了嗎

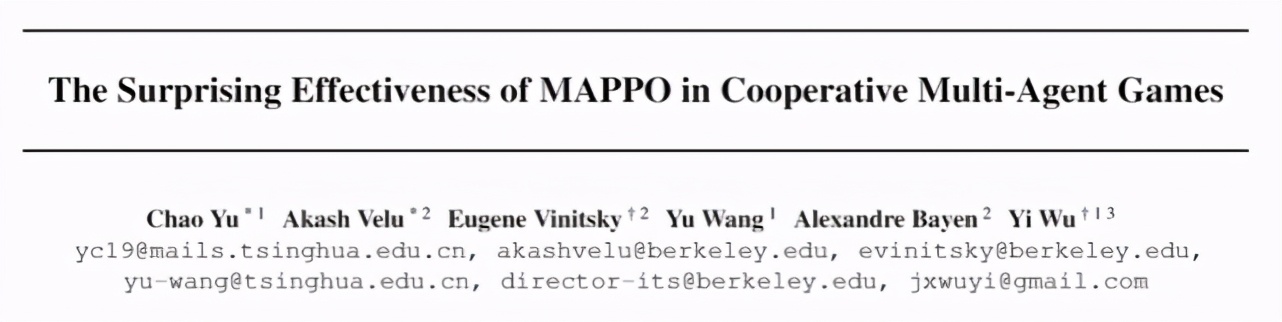

清華和UC伯克利聯合研究發現,在不進行任何算法或者網絡架構變動的情況下,用 MAPPO(Multi-Agent PPO)在 3 個具有代表性的多智能體任務(Multi-Agent Particle World, StarCraftII, Hanabi)中取得了與 SOTA 算法相當的性能。

近些年,多智能體強化學習(Multi-Agent Reinforcement Learning,MARL)取得了突破性進展,例如 DeepMind 開發的 AlphaStar 在星際爭霸 II 中打敗了職業星際玩家,超過了 99.8% 的人類玩家;OpenAI Five 在 DOTA2 中多次擊敗世界冠軍隊伍,是首個在電子競技比賽中擊敗冠軍的人工智能系統;以及在仿真物理環境 hide-and-seek 中訓練出像人一樣可以使用工具的智能體。我們提到的這些智能體大多是采用 on-policy 算法(例如 IMPALA[8])訓練得到的,這就意味著需要很高的并行度和龐大的算力支持,例如 OpenAI Five 消耗了 12.8 萬塊 CPU 和 256 塊 P100 GPU 來收集數據樣本和訓練網絡。

然而,大多數的學術機構很難配備這個量級的計算資源。因此,MARL 領域幾乎已經達成共識:與 on-policy 算法(例如 PPO[3])相比,在計算資源有限的情況下,off-policy 算法(例如 MADDPG[5],QMix[6])因其更高的采樣效率更適合用來訓練智能體,并且也演化出一系列解決某些具體問題(domain-specific)的 SOTA 算法(例如 SAD[9],RODE[7])。

但是,來自清華大學與 UC 伯克利的研究者在一篇論文中針對這一傳統認知提出了不同的觀點:MARL 算法需要綜合考慮數據樣本效率(sample efficiency)和算法運行效率(wall-clock runtime efficiency)。在有限計算資源的條件下,與 off-policy 算法相比,on-policy 算法 --MAPPO(Multi-Agent PPO)具有顯著高的算法運行效率和與之相當(甚至更高)的數據樣本效率。有趣的是,研究者發現只需要對 MAPPO 進行極小的超參搜索,在不進行任何算法或者網絡架構變動的情況下就可以取得與 SOTA 算法相當的性能。更進一步地,還貼心地給出了 5 條可以提升 MAPPO 性能的重要建議,并且開源了一套優化后的 MARL 算法源碼(代碼地址:

https://github.com/marlbenchmark/on-policy)。

所以,如果你的 MARL 算法一直不 work,不妨參考一下這項研究,有可能是你沒有用對算法;如果你專注于研究 MARL 算法,不妨嘗試將 MAPPO 作為 baseline,說不定可以提高任務基準;如果你處于 MARL 研究入門階段,這套源碼值得擁有,據說開發完備,簡單易上手。這篇論文由清華大學的汪玉、吳翼等人與 UC 伯克利的研究者合作完成。研究者后續會持續開源更多優化后的算法及任務(倉庫指路:

https://github.com/marlbenchmark)

論文鏈接:

https://arxiv.org/abs/2103.01955

什么是 MAPPO

PPO(Proximal Policy Optimization)[4]是一個目前非常流行的單智能體強化學習算法,也是 OpenAI 在進行實驗時首選的算法,可見其適用性之廣。PPO 采用的是經典的 actor-critic 架構。其中,actor 網絡,也稱之為 policy 網絡,接收局部觀測(obs)并輸出動作(action);critic 網絡,也稱之為 value 網絡,接收狀態(state)輸出動作價值(value),用于評估 actor 網絡輸出動作的好壞。可以直觀理解為評委(critic)在給演員(actor)的表演(action)打分(value)。MAPPO(Multi-agent PPO)是 PPO 算法應用于多智能體任務的變種,同樣采用 actor-critic 架構,不同之處在于此時 critic 學習的是一個中心價值函數(centralized value function),簡而言之,此時 critic 能夠觀測到全局信息(global state),包括其他 agent 的信息和環境的信息。

實驗環境

接下來介紹一下論文中的實驗環境。論文選擇了 3 個具有代表性的協作 Multi-agent 任務,之所以選擇協作任務的一個重要原因是合作任務具有明確的評價指標,便于對不同的算法進行比較。

第一個環境是 OpenAI 開源的 Multi-agent Particle World(MPE)任務(源代碼指路:

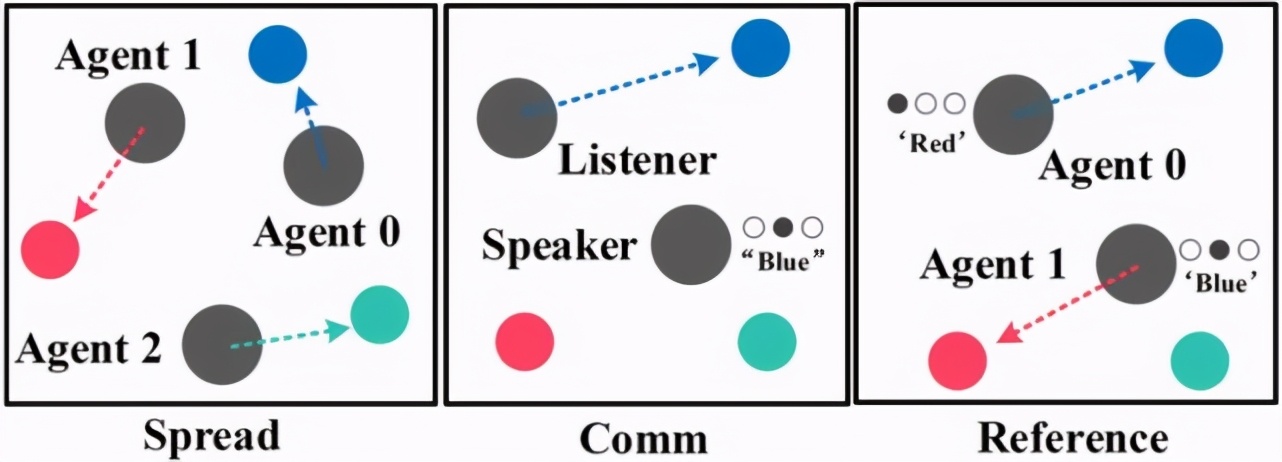

https://github.com/openai/multiagent-particle-envs)[1],輕量級的環境和抽象多樣的任務設定使之成為快速驗證 MARL 算法的首選測試平臺。在 MPE 中有 3 個協作任務,分別是 Spread,Comm 和 Reference,如圖 1 所示。

圖 1:MPE 環境中的 3 個子任務:Spread,Comm 和 Reference

第二個環境是 MARL 領域著名的 StarCraftII(星際爭霸 II)任務(源代碼:

https://github.com/oxwhirl/smac),如圖 2 所示。這一任務最初由 M. Samvelyan 等人提出 [2],提供了 23 個實驗地圖,agent 數量從 2 到 27 不等,我方 agent 需要進行協作來打敗敵方 agent 以贏得游戲。自該任務發布以來,有很多研究人員針對其特點進行了算法研究,例如經典算法 QMix[6] 以及最新發表的 RODE[7]等等。由于 StarCraftII 經過了版本迭代,并且不同版本之間性能有差距,特別說明,這篇論文采用的是最新版本 SC2.4.10。

圖 2:StarCraftII 環境中的 2 個代表性地圖:Corridor 和 2c vs. 64zg

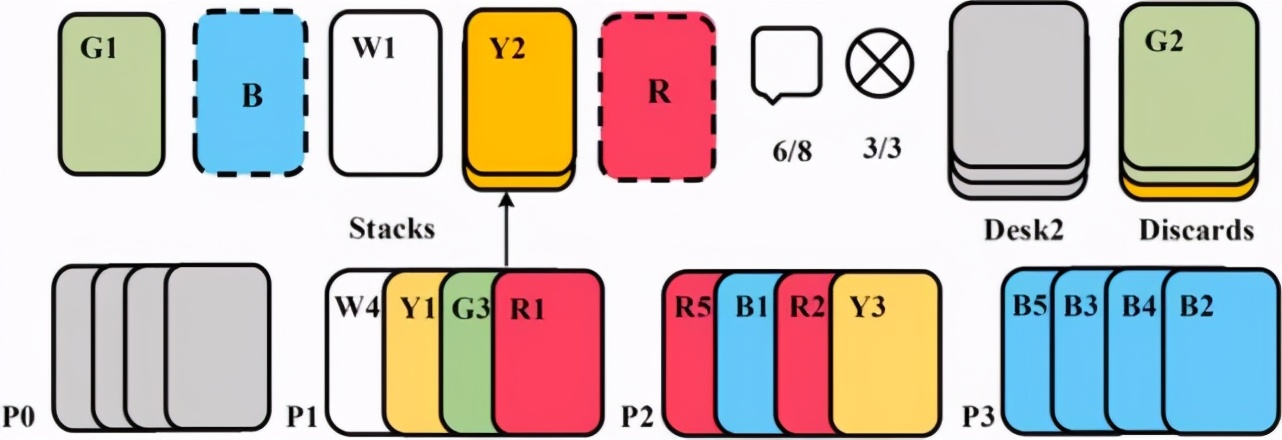

第三個環境是由 Nolan Bard 等人 [3] 在 2019 年提出的一個純協作任務 Hanabi(源代碼:

https://github.com/deepmind/hanabi-learning-environment),Hanabi 是一個 turn-based 的紙牌類游戲,也就是每一輪只有一個玩家可以出牌,相較于之前的多智能體任務,Hanabi 的一個重要特點是純合作,每個玩家需要對其他玩家的意圖進行推理,完成協作才能獲得分數,Hanabi 的玩家數可以是 2-5 個,圖 3 是 4 個玩家的任務示意圖,感興趣的讀者可以自己嘗試玩一下。

圖 3:4 個玩家的 Hanabi-Full 任務示意圖

實驗結果

首先來看一下論文給出的實驗結果,特別注意,論文所有的實驗都在一臺主機中完成,該主機的配置是 256 GB 內存, 一塊 64 核 CPU 和一塊 GeForce RTX 3090 24GB 顯卡。另外,研究者表示,本文的所有的算法都進行了微調(fine-tune),所以本文中的復現的某些實驗結果會優于原論文。

(1)MPE 環境

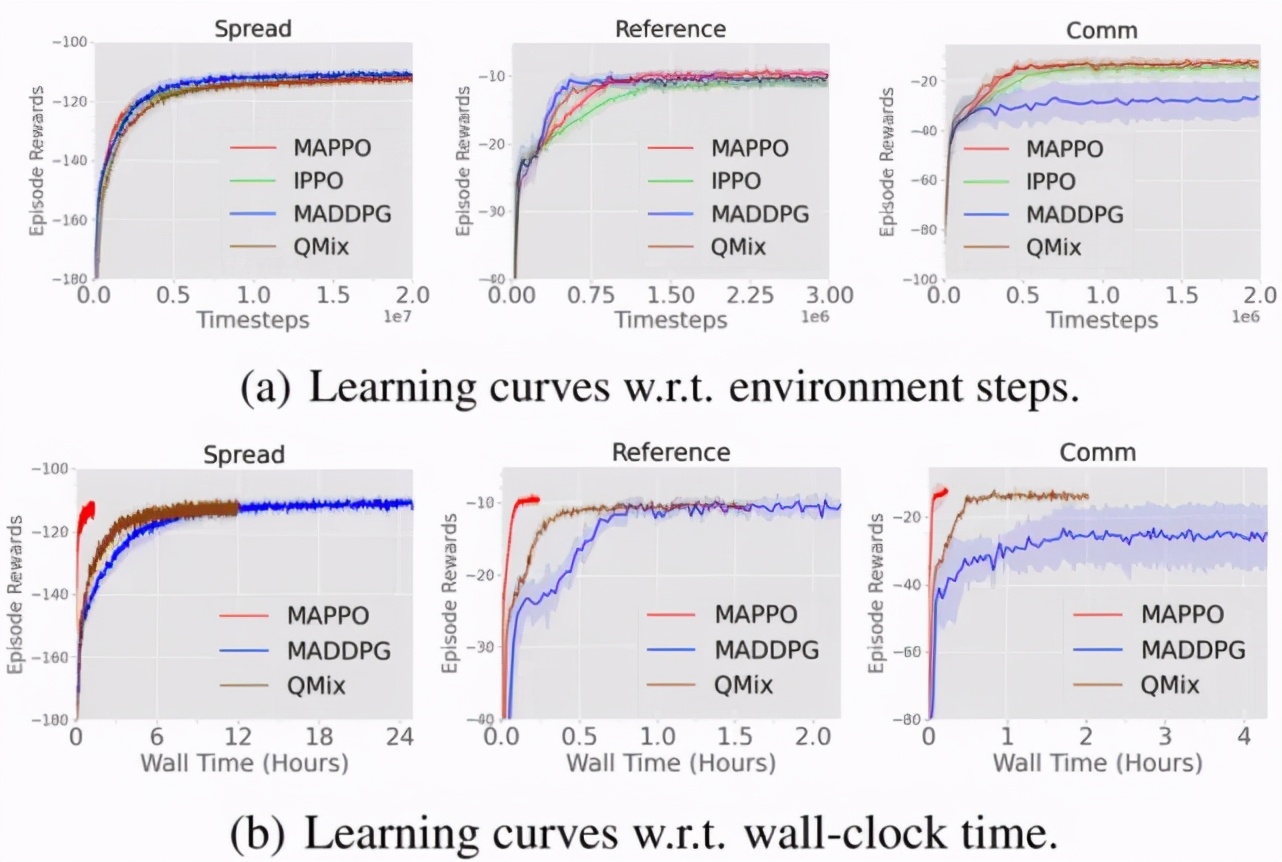

圖 4 展示了在 MPE 中不同算法的數據樣本效率和算法運行效率對比,其中 IPPO(Independent PPO)表示的是 critic 學習一個分布式的價值函數(decentralized value function),即 critic 與 actor 的輸入均為局部觀測,IPPO 和 MAPPO 超參保持一致;MADDPG[5]是 MARL 領域十分流行的 off-policy 算法,也是針對 MPE 開發的一個算法,QMix[6]是針對 StarCraftII 開發的 MARL 算法,也是 StarCraftII 中的常用 baseline。

從圖 4 可以看出與其他算法相比,MAPPO 不僅具有相當的數據樣本效率和性能表現(performance)(圖(a)),同時還具有顯著高的算法運行效率(圖(b))。

圖 4:在 MPE 中不同算法的數據樣本效率和算法運行效率對比

(2)StarCraftII 環境

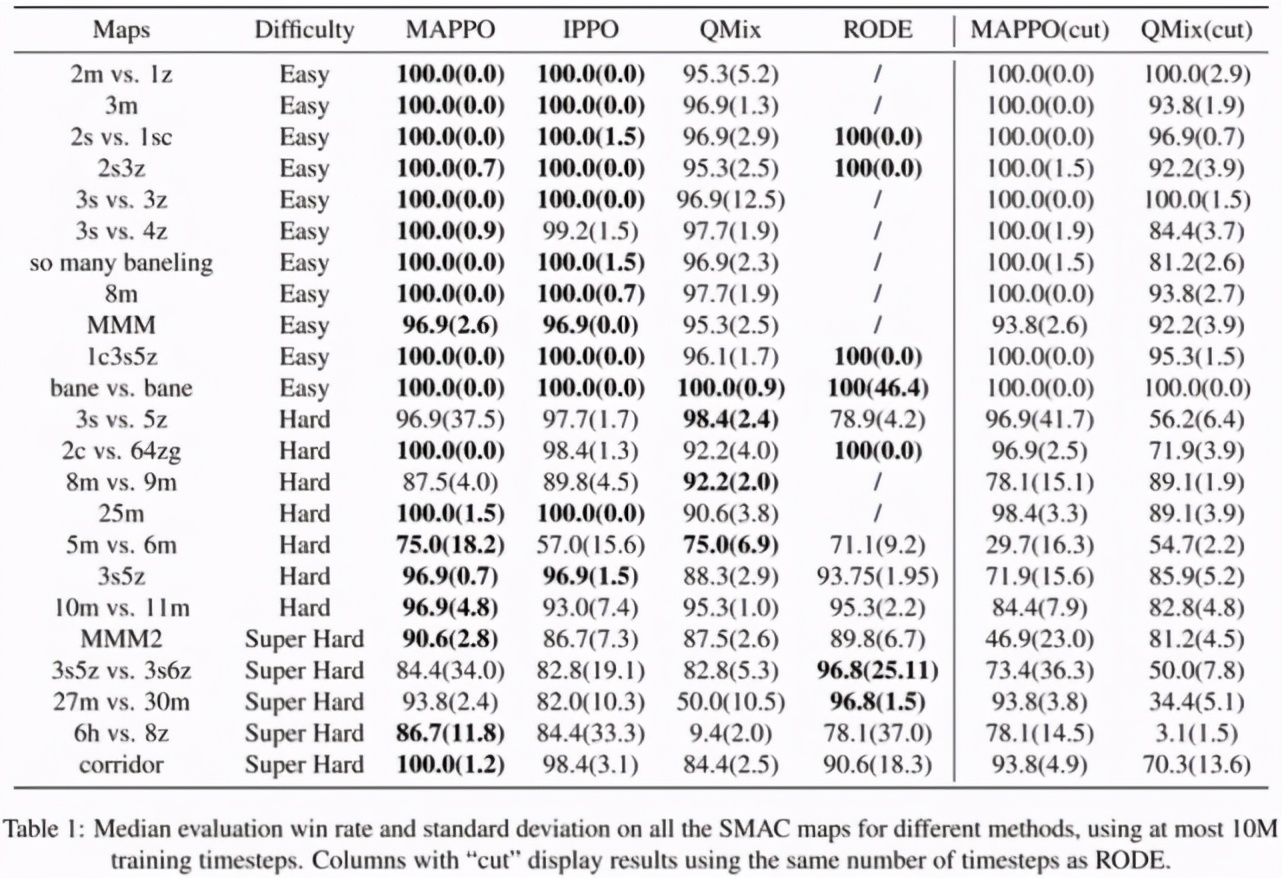

表 1 展示了 MAPPO 與 IPPO,QMix 以及針對 StarCraftII 的開發的 SOTA 算法 RODE 的勝率對比,在截斷至 10M 數據的情況下,MAPPO 在 19/23 個地圖的勝率都達到了 SOTA,除了 3s5z vs. 3s6z,其他地圖與 SOTA 算法的差距小于 5%,而 3s5z vs. 3s6z 在截斷至 10M 時并未完全收斂,如果截斷至 25M,則可以達到 91% 的勝率。

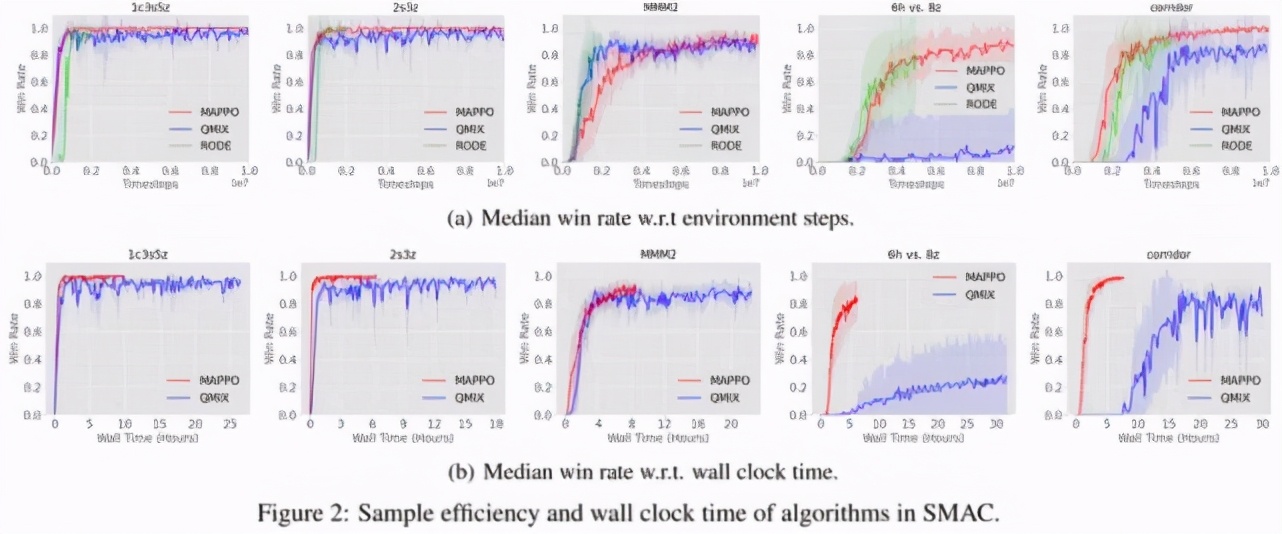

圖 5 表示在 StarCraftII 中不同算法的數據樣本效率和算法運行效率對比。可以看出 MAPPO 實際上與 QMix 和 RODE 具有相當的數據樣本效率,以及更快的算法運行效率。由于在實際訓練 StarCraftII 任務的時候僅采用 8 個并行環境,而在 MPE 任務中采用了 128 個并行環境,所以圖 5 的算法運行效率沒有圖 4 差距那么大,但是即便如此,依然可以看出 MAPPO 驚人的性能表現和運行效率。

表 1:不同算法在 StarCraftII 的 23 個地圖中的勝率對比,其中 cut 標記表示將 MAPPO 和 QMix 截斷至與 RODE 相同的步數,目的是為了與 SOTA 算法公平對比。

(3)Hanabi 環境

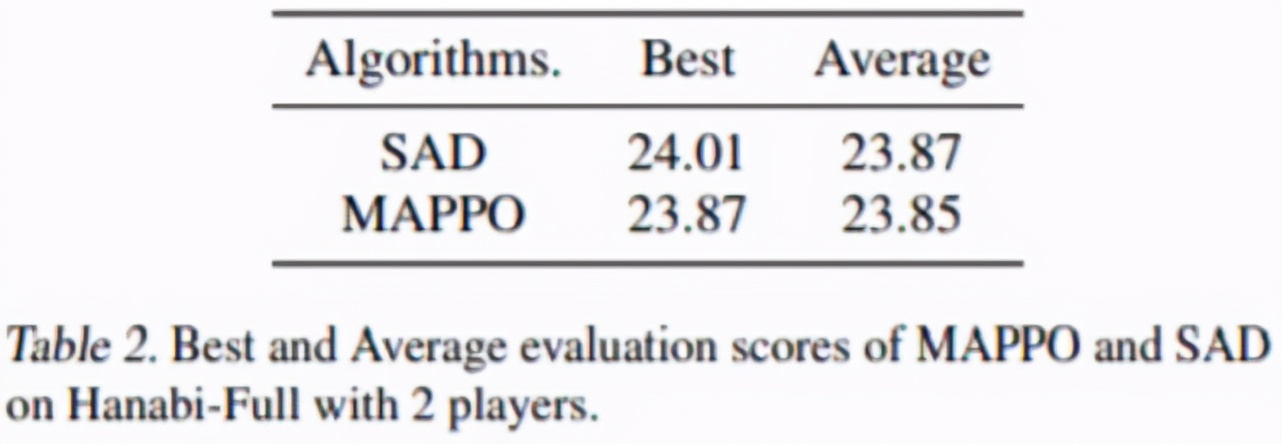

SAD 是針對 Hanabi 任務開發的一個 SOTA 算法,值得注意的是,SAD 的得分取自原論文,原作者跑了 13 個隨機種子,每個種子需要約 10B 數據,而由于時間限制,MAPPO 只跑了 4 個隨機種子,每個種子約 7.2B 數據。從表 2 可以看出 MAPPO 依然可以達到與 SAD 相當的得分。

表 2:MAPPO 和 SAD 在 2 個玩家的 Hanabi-Full 任務的得分對比。

5 條小建議

看完了論文給出的實驗結果,那么,回到最開始的問題,你用對 MAPPO 了嗎?

研究者發現,即便多智能體任務與單智能體任務差別很大,但是之前在其他單智能體任務中的給出的 PPO 實現建議依然很有用,例如 input normalization,value clip,max gradient norm clip,orthogonal initialization,GAE normalization 等。但是除此之外,研究者額外給出了針對 MARL 領域以及其他易被忽視的因素的 5 條建議。

Value normalization: 研究者采用 PopArt 對 value 進行 normalization,并且指出使用 PopArt 有益無害。

Agent Specific Global State: 采用 agent-specific 的全局信息,避免全局信息遺漏以及維度過高。值得一提的是,研究者發現 StarCraftII 中原有的全局信息存在信息遺漏,甚至其所包含的信息少于 agent 的局部觀測,這也是直接將 MAPPO 應用在 StarCraftII 中性能表現不佳的重要原因。

Training Data Usage: 簡單任務中推薦使用 15 training epochs,而對于較難的任務,嘗試 10 或者 5 training epochs。除此之外,盡量使用一整份的訓練數據,而不要切成很多小份(mini-batch)訓練。

Action Masking: 在多智能體任務中經常出現 agent 無法執行某些 action 的情況,建議無論前向執行還是反向傳播時,都應將這些無效動作屏蔽掉,使其不參與動作概率計算。

Death Masking: 在多智能體任務中,也經常會出現某個 agent 或者某些 agents 中途死掉的情況(例如 StarCraftII)。當 agent 死亡后,僅保留其 agent id,將其他信息屏蔽能夠學得更加準確的狀態價值函數。

更多的實驗細節和分析可以查看論文原文。