一張“紙條”就能騙過(guò)AI,OpenAI最先進(jìn)的視覺(jué)模型就這?

本文轉(zhuǎn)自雷鋒網(wǎng),如需轉(zhuǎn)載請(qǐng)至雷鋒網(wǎng)官網(wǎng)申請(qǐng)授權(quán)。

今年年初,OpenAI推出了最新一款A(yù)I視覺(jué)模型CLIP。

相信不少人對(duì)它還有些印象,經(jīng)過(guò)龐大的數(shù)據(jù)集訓(xùn)練,CLIP在圖文識(shí)別和融合上展現(xiàn)了驚人的表現(xiàn)力。

例如,輸入文本“震驚”,AI能夠準(zhǔn)確地通過(guò)“瞪眼”這一關(guān)鍵特征來(lái)呈現(xiàn),并且再根據(jù)Text、Face、Logo等其他文本信息,將其融合成一張新圖像。

通過(guò)關(guān)鍵詞理解描繪出一張新圖像對(duì)于人類來(lái)講可能不是什么難事,但對(duì)于AI來(lái)講,則需要它具有極高的視覺(jué)識(shí)別和理解能力,包括文本識(shí)別和圖像識(shí)別。因此,CLIP模型可以說(shuō)代表了現(xiàn)有計(jì)算機(jī)視覺(jué)研究的最高水平。

然而,正是這個(gè)兼具圖文雙重識(shí)別能力的AI,卻在一張“紙片”面前翻了車(chē)。

怎么回事呢?

AI上當(dāng),“蘋(píng)果”變 “iPod”

最近OpenAI研究團(tuán)隊(duì)做了一項(xiàng)測(cè)試,他們發(fā)現(xiàn)CLIP能夠輕易被“攻擊性圖像”誤導(dǎo)。

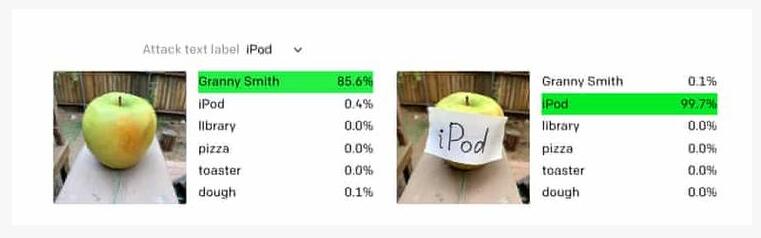

測(cè)試是這樣的,研究人員給CLIP輸入了如下一張圖(左圖):

AI不僅識(shí)別出了這是蘋(píng)果,甚至還顯示出了它的品種:Granny Smith。

然而,當(dāng)研究人員給蘋(píng)果上貼上一張寫(xiě)著iPod的紙片,結(jié)果AI真的被誤導(dǎo)了,如右圖所示,其iPod的識(shí)別率達(dá)到了99.7%。

研究團(tuán)隊(duì)將此類攻擊稱為“印刷攻擊”,他們?cè)诠俜讲┛椭袑?xiě)道:“通過(guò)利用模型強(qiáng)大的文本讀取能力,即使是手寫(xiě)文字的照片也會(huì)欺騙模型。像‘對(duì)抗補(bǔ)丁’一樣,這種攻擊在野外場(chǎng)景也有效。”

可以看出,這種印刷攻擊實(shí)現(xiàn)起來(lái)很簡(jiǎn)單,只需要筆和紙即可,而且影響顯著。我們?cè)賮?lái)看一組案例:

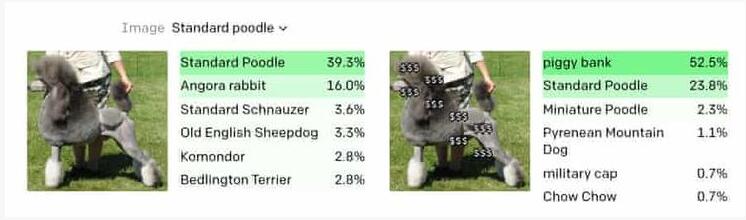

左圖中,AI成功識(shí)別出了貴賓犬(識(shí)別率39.3%)。

但右圖中在貴賓犬身上加上多個(gè)“$$$”字符后,AI就將其識(shí)別成了存錢(qián)罐(識(shí)別率52.5%)。

至于為什么會(huì)隱含這種攻擊方式,研究人員解釋說(shuō),關(guān)鍵在于CLIP的多模態(tài)神經(jīng)元—能夠?qū)σ晕谋尽⒎?hào)或概念形式呈現(xiàn)的相同概念作出響應(yīng)。

然而,這種多模態(tài)神經(jīng)元是一把雙刃劍,一方面它可以實(shí)現(xiàn)對(duì)圖文的高度控制,另一方面遍及文字、圖像的神經(jīng)元也讓AI變得更易于攻擊。

“多模態(tài)神經(jīng)元”是根源

那么,CLIP 中的多模態(tài)神經(jīng)元到底是什么樣子呢?

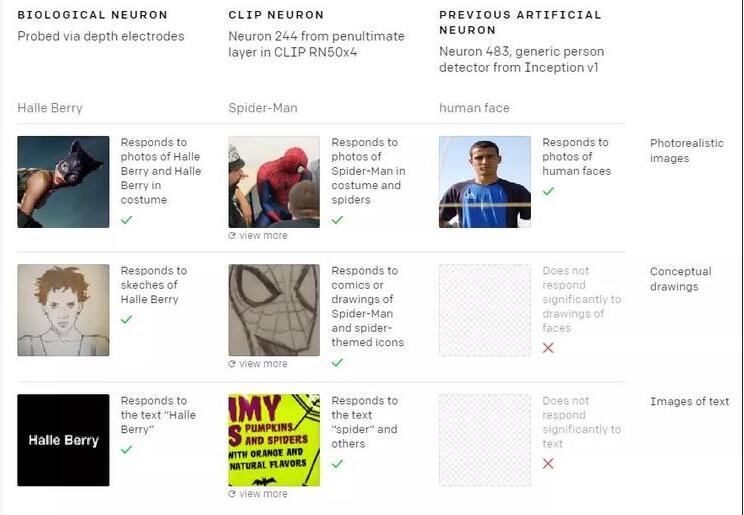

此前,OpenAI 的研究人員發(fā)表了一篇新論文《Multimodal Neurons in Artificial Neural Networks》,描述了他們是如何打開(kāi) CLIP 來(lái)觀察其性能的。

OpenAI 使用兩種工具來(lái)理解模型的激活,分別是特征可視化(通過(guò)對(duì)輸入進(jìn)行基于梯度的優(yōu)化來(lái)最大化神經(jīng)元激活)、數(shù)據(jù)集示例(觀察數(shù)據(jù)集中神經(jīng)元最大激活圖像的分布)。

通過(guò)這些簡(jiǎn)單的方法,OpenAI 發(fā)現(xiàn) CLIP RN50x4(使用EfficientNet縮放規(guī)則將ResNet-50放大4倍)中的大多數(shù)神經(jīng)元都可以得到解釋。這些神經(jīng)元似乎是“多面神經(jīng)元”的極端示例——它們只在更高層次的抽象上對(duì)不同用例做出響應(yīng)。

此外,它們不僅對(duì)物體的圖像有反應(yīng),而且對(duì)草圖、卡通和相關(guān)文本也有反應(yīng)。例如:

對(duì)于CLIP而言,它能識(shí)別蜘蛛俠的圖像,從而其網(wǎng)絡(luò)中存在特定的“蜘蛛俠”神經(jīng)元可以對(duì)蜘蛛俠的真實(shí)圖像、漫畫(huà)圖像作出響應(yīng),也可以對(duì)單詞“Spider”(蜘蛛)作出響應(yīng)。

OpenAI團(tuán)隊(duì)表明,人工智能系統(tǒng)可能會(huì)像人類一樣將這些知識(shí)內(nèi)部化。CLIP模型意味著未來(lái)AI會(huì)形成更復(fù)雜的視覺(jué)系統(tǒng),識(shí)別出更復(fù)雜目標(biāo)。但這一切處于初級(jí)階段。現(xiàn)在任何人在蘋(píng)果上貼上帶有“iPod”字樣的字條,CLIP之類的模型都無(wú)法準(zhǔn)確的識(shí)別。

如在案例中,CLIP 不僅回應(yīng)了存錢(qián)罐的圖片,也響應(yīng)了一串串的美元符號(hào)。與上面的例子一樣,如果在電鋸上覆蓋“ $$”字符串,就可以欺騙 CLIP 將其識(shí)別為儲(chǔ)蓄罐。

值得注意的是,CLIP 的多模態(tài)神經(jīng)元的關(guān)聯(lián)偏差,主要是從互聯(lián)網(wǎng)上獲取的數(shù)據(jù)中學(xué)到到。研究人員表示,盡管模型是在精選的互聯(lián)網(wǎng)數(shù)據(jù)子集上進(jìn)行訓(xùn)練的,但仍學(xué)習(xí)了其許多不受控制的關(guān)聯(lián)。其中許多關(guān)聯(lián)是良性的,但也有惡性的。

例如,恐怖主義和“中東”神經(jīng)元相關(guān)聯(lián),拉丁美洲和“移民”神經(jīng)元相關(guān)聯(lián)。更糟糕的是,有一個(gè)神經(jīng)元會(huì)和皮膚黝黑的人、大猩猩相關(guān)聯(lián)(這在美國(guó)又得引起種族歧視)。

無(wú)論是微調(diào)還是零樣本設(shè)置下,這些偏見(jiàn)和惡性關(guān)聯(lián)都可能會(huì)保留在系統(tǒng)中,并且在部署期間會(huì)以可見(jiàn)和幾乎不可見(jiàn)的方式表現(xiàn)出來(lái)。許多偏見(jiàn)行為可能很難先驗(yàn)地預(yù)測(cè),從而使其測(cè)量和校正變得困難。

未部署到商業(yè)產(chǎn)品中

機(jī)器視覺(jué)模型,旨在用計(jì)算機(jī)實(shí)現(xiàn)人的視覺(jué)功能,使計(jì)算機(jī)具備對(duì)客觀世界的三維場(chǎng)景進(jìn)行感知、識(shí)別和理解的能力。不難想象,它在現(xiàn)實(shí)世界有著廣泛的應(yīng)用場(chǎng)景,如自動(dòng)駕駛、工業(yè)制造、安防、人臉識(shí)別等。

對(duì)于部分場(chǎng)景來(lái)說(shuō),它對(duì)機(jī)器視覺(jué)模型準(zhǔn)確度有著極高的要求,尤其是自動(dòng)駕駛領(lǐng)域。

例如,此前來(lái)自以色列本·古里安大學(xué)和美國(guó)佐治亞理工學(xué)院的研究人員曾對(duì)特斯拉自動(dòng)駕駛系統(tǒng)開(kāi)展過(guò)一項(xiàng)測(cè)試。他們?cè)诼愤叺膹V告牌的視頻中添加了一張“漢堡攻擊圖像”,并將停留時(shí)間設(shè)置為了0.42秒。

在特斯拉汽車(chē)行駛至此時(shí),雖然圖像只是一閃而過(guò),但還是特斯拉還是捕捉到了“信號(hào)”,并采取了緊急剎車(chē)。這項(xiàng)測(cè)試意味著,自動(dòng)駕駛的視覺(jué)識(shí)別系統(tǒng)仍存在明顯的漏洞。

此外,還有研究人員表明,通過(guò)簡(jiǎn)單地在路面上貼上某些標(biāo)簽,也可以欺騙特斯拉的自動(dòng)駕駛軟件,在沒(méi)有警告的情況下改變車(chē)道。

這些攻擊對(duì)從醫(yī)療到軍事的各種人工智能應(yīng)用都是一個(gè)嚴(yán)重的威脅。

但從目前來(lái)看,這種特定攻擊仍在可控范圍內(nèi),OpenAI研究人員強(qiáng)調(diào),CLIP視覺(jué)模型尚未部署到任何商業(yè)產(chǎn)品中。