厲害了,人工智能可以識別人的情緒,我不信

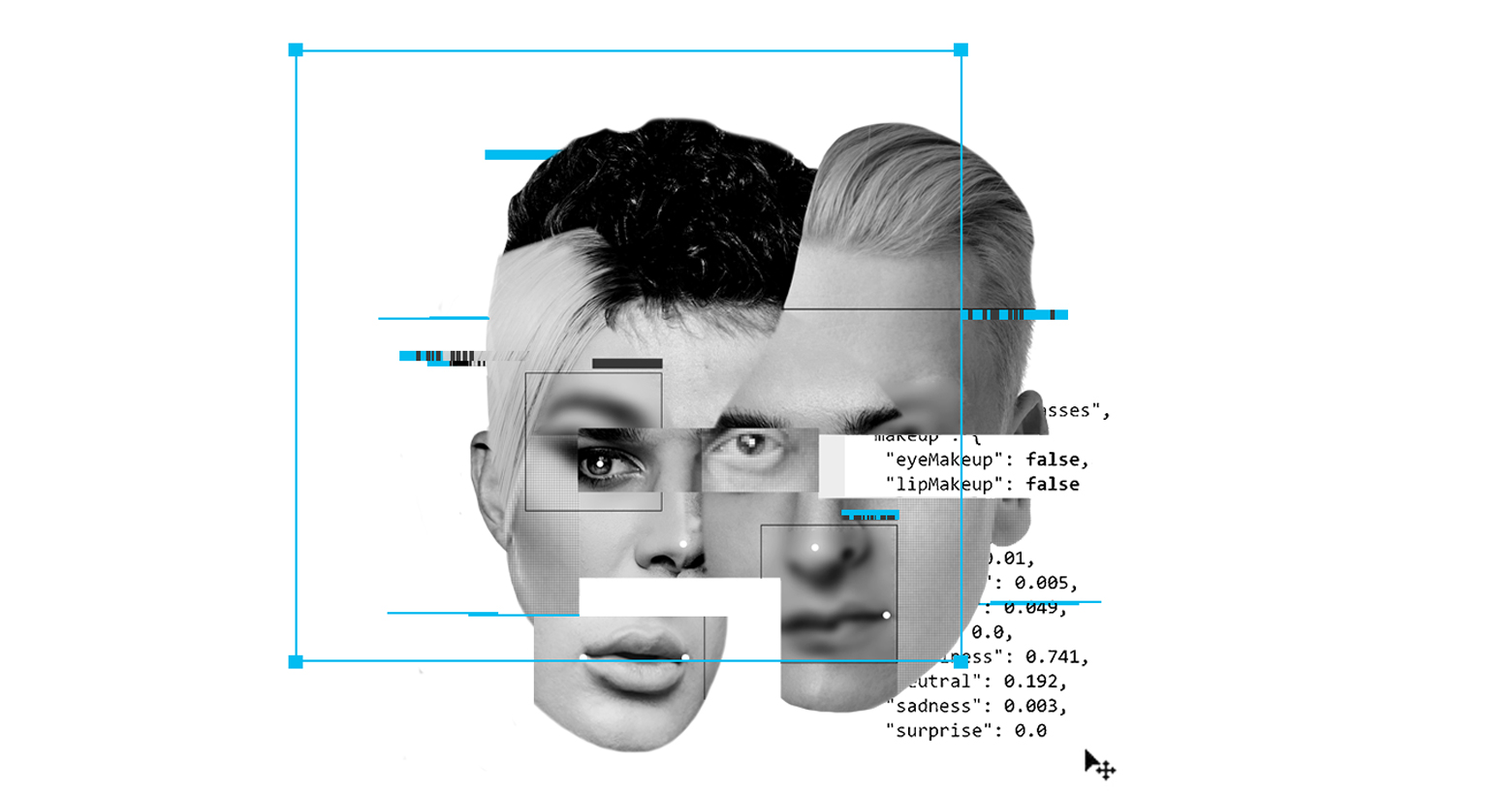

情感識別技術(Emotion Recognition Technology)實際上是一種新興的技術,使用人工智能從面部表情中檢測情緒,也是數十億美元的產業。然而該技術背后的科學支撐頗有爭議,系統中存在“偏見”。

從食品到游戲行業的各種公司使用ERT測試用戶對它們產品的反應。當然可用在其他場景,比如在職場、機場安防或邊防識別人員情緒,以便維持秩序,還可監督學生做家庭作業等。想想也是不錯的。

但是,人臉識別技術正在受到公眾的關注,因為它涉及到隱私及歧視問題。最近在奈飛上映的獲獎電影《Coded Bias》記錄了一個發現,許多人臉識別技術不能準確檢測深色皮膚的人臉。管理ImageNet(一個用于視覺對象識別軟件研究的大型可視化數據庫)的團隊最近也不得不模糊了150萬張圖片,為了回應隱私問題。

曾披露,人臉識別技術中有“算法偏見”和歧視性數據庫,導致包括微軟、亞馬遜和IBM在內的大型科技公司停止銷售該類技術。該技術在英國警務中的應用也面臨法律指控。在歐盟,由40多個民間社會組織組成的聯盟呼吁禁止使用人臉識別技術。

像其他形式的人臉識別一樣,ERT也出現了關于偏見、隱私和大規模監管的問題。但ERT還出現了另一個問題,支撐它的情感科學是有爭議的。大多數ERT系統是基于“基本情緒”理論的,該理論認為,情感是與生俱來的,世界各地的人都以同樣的方式表達情感。

然而,該理論慢慢地有些站不住腳了。人類學研究表明文化和社會不同,人們情緒的表達方式不同。2019年心理科學協會(Association for Psychological Science)對“基本情緒”理論的證據進行了審查,結論是人們所普遍認為的一個人的情緒可以很容易地從他們的面部表情中推斷出來沒有科學依據。簡而言之,ERT沒有堅實可靠的科學理論基礎。

此外,ERT中含有種族歧視的代碼。正在進行的研究中已經顯示該系統認為不管這個人的表情如何,黑人的臉比白人的臉更顯憤怒。

人工智能研究員黛博拉·拉吉(Deborah Raji)在接受麻省理工科技評論(MIT Technology Review)采訪時說,“這項技術有兩種情況‘傷害’到人們,一種是系統不起作用,識別有色人種的錯誤率高,使人們面臨很大的風險;另一種情況是當它發揮作用時,即系統已經很成熟了,便很容易作為某種工具騷擾人們的生活。”

所以即使人臉識別技術可以去除偏見,也很準確,也未必公平公正。我們會看到很多不和諧,比如當人臉識別技術用在有歧視的警局和司法系統時,會發生什么;當它們在一個不和諧的世界中有效運行時,它們也有可能是危險的。

人臉識別技術所帶來的挑戰至今沒有明確的答案。要解決ERT的問題,就必須從抽象的理論轉向生活的實踐。我們需要集體審視系統中有爭議的情感科學理論,并分析潛在的種族歧視。我們還需要問自己,即使ERT可以準確地讀取每個人的內心感受,我們是否想要在生活中被如此親密的監控?這些都是需要大家深思熟慮的,投入精力和行動的問題。