谷歌讓AI芯片學會“下崽”,下一代TPU就讓AI自己設計

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

設計一塊AI芯片有多難?

這么說吧,圍棋的復雜度10360,而芯片則是102500,你感受一下……

一般來說,工程師們設計一塊芯片,少則需要幾周,多則好幾個月。

現在,AI生產力來了!

AI自己動手,竟然用6小時就設計出一塊芯片。

最近,這項谷歌的研究登上了Nature雜志。

布局時間縮短數倍

小小的一塊芯片包括了數十億個晶體管,由它們組成的數千萬個邏輯門就是標準單元,此外還有數千個存儲塊,稱為宏塊。

確定它們的位置,也就是布局規劃,對芯片設計至關重要。

因為這直接關系到如何布線,進而影響著芯片的處理速度和電源效率。

但是,光是放置宏塊這一步就非常耗時,為了給標準單元留出更多空間,每一次迭代都需要幾天或幾周時間。

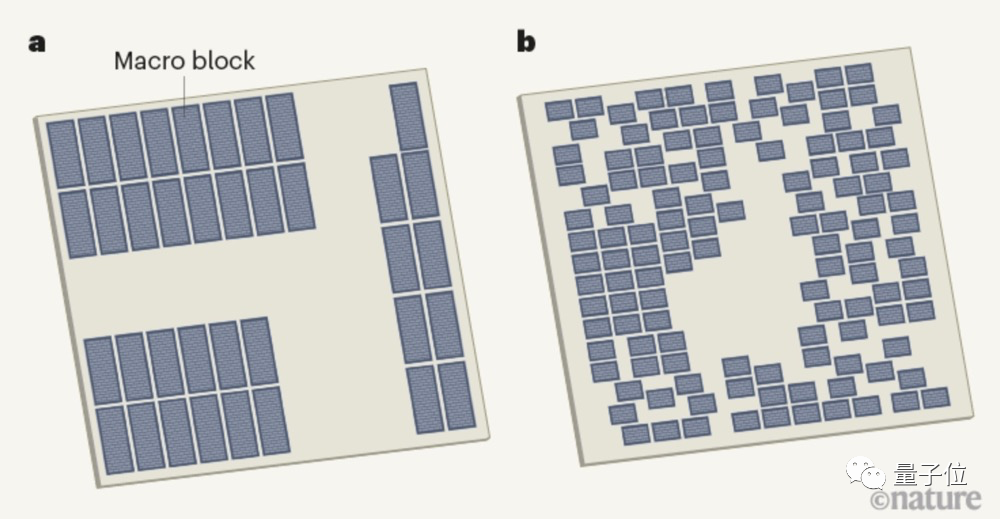

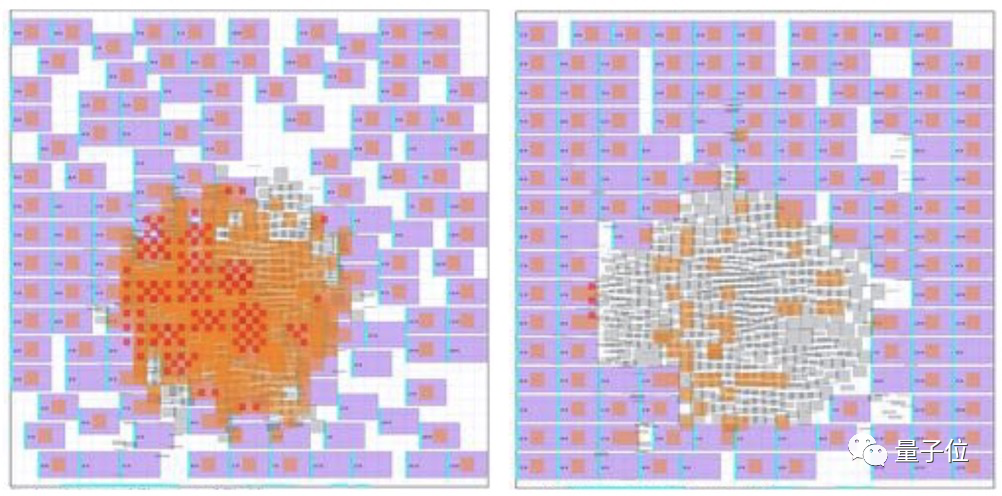

△人類設計和AI設計芯片的平面圖(灰色塊為宏塊)

完成整個布局,則要花費數周甚至數月。

現在,谷歌的研究人員提出了一種具有泛化能力的芯片布局方法。

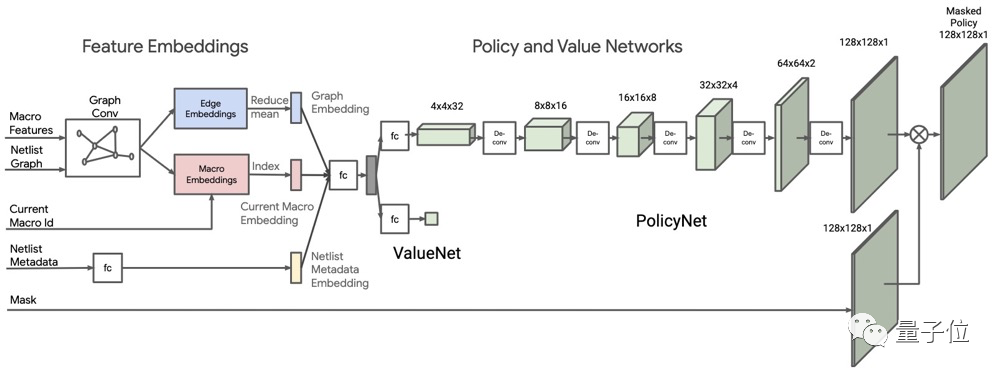

它能夠基于深度強化學習,從之前的布局中進行學習,然后生成新的設計方案。整體架構是這樣的:

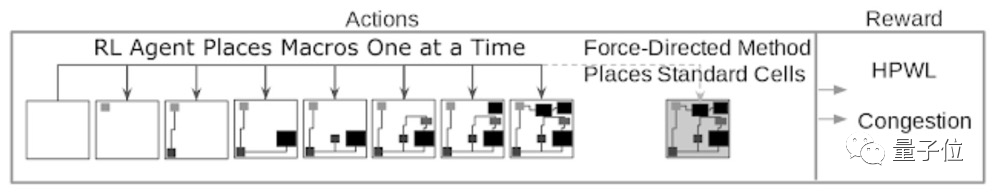

由于AI模型需要學習10萬個芯片布局,為了保證速度,研究人員設計了一種獎勵機制,基于線路長度和布線擁塞的近似代價函數進行計算。

具體來說,需要將宏和標準單元映射到一個平面畫布上,形成具有數百萬到數十億節點的「芯片網表」。

然后,AI模型會對功率、性能和面積(PPA) 等進行優化,并且輸出概率分布。

下圖分別是零樣本生成和基于預訓練策略微調的效果,其中每個小矩形代表一個宏塊。在預訓練策略中,中間留出了用于放置標準單元的空間。

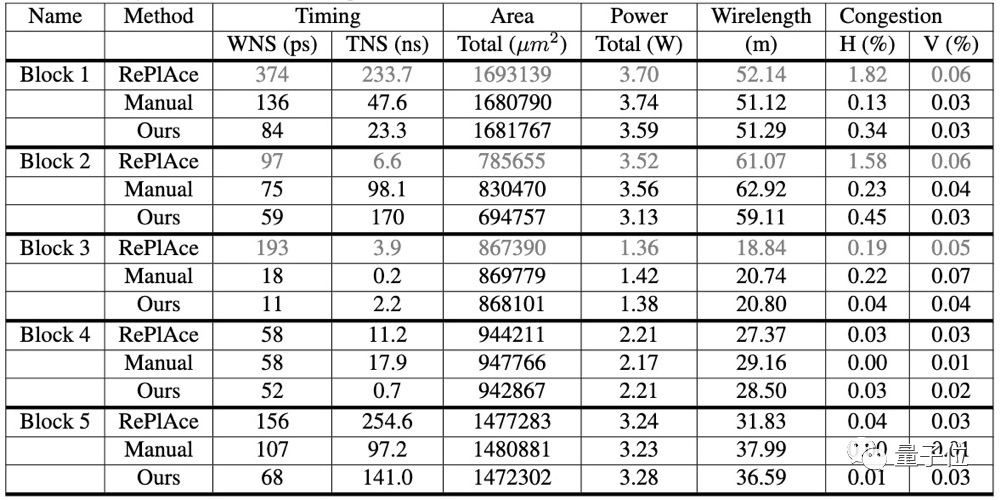

與其他方法相比,谷歌的新方法大大減少了設計時間,只需不到6小時,就能實現性能優化的布局。

谷歌:效果不錯,已經用上了

研究團隊對不同策略下的布局效果進行了可視化展示,從圖中可以看到,預訓練策略微調的結果要明顯優于零樣本生成。

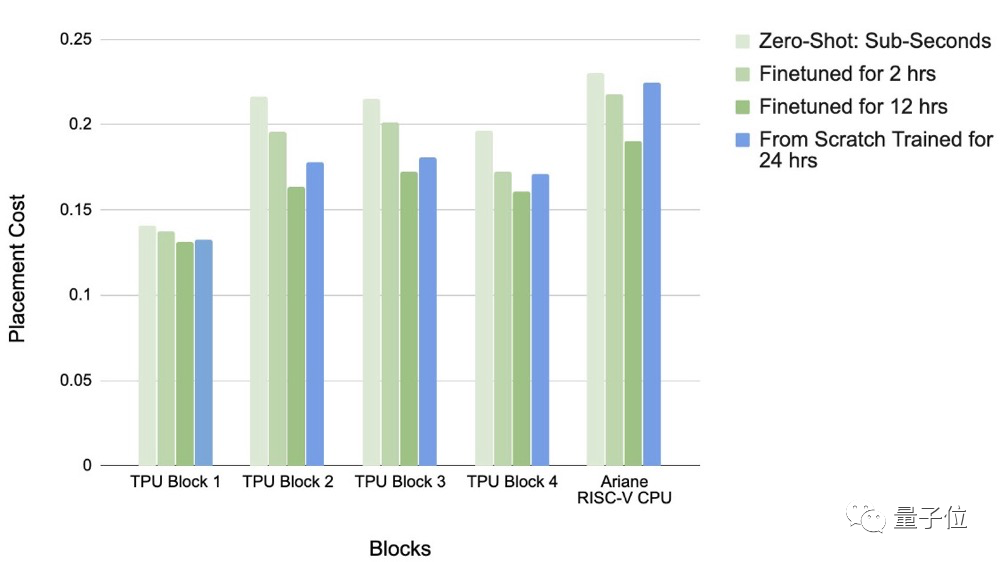

并且,從不同訓練時長的效果對比可以看到,在訓練2-12小時的情況下,預訓練策略要優于零樣本生成。

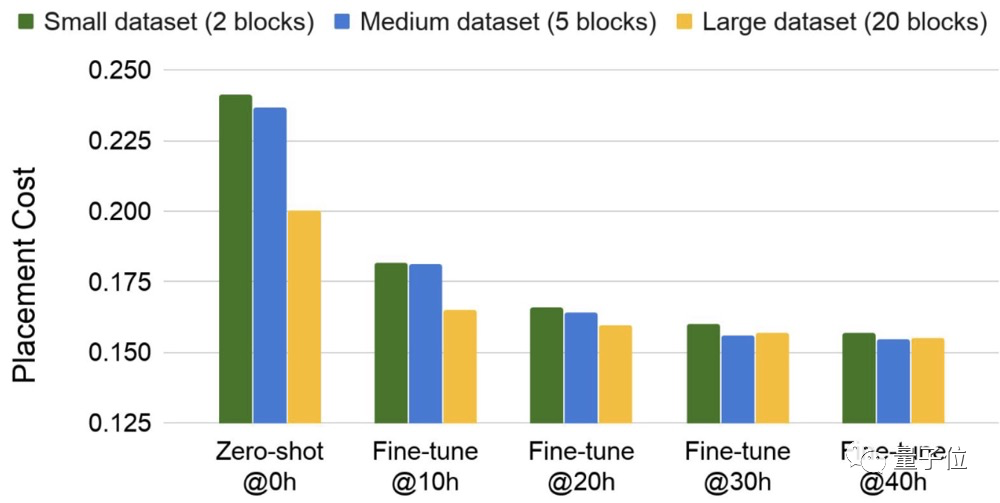

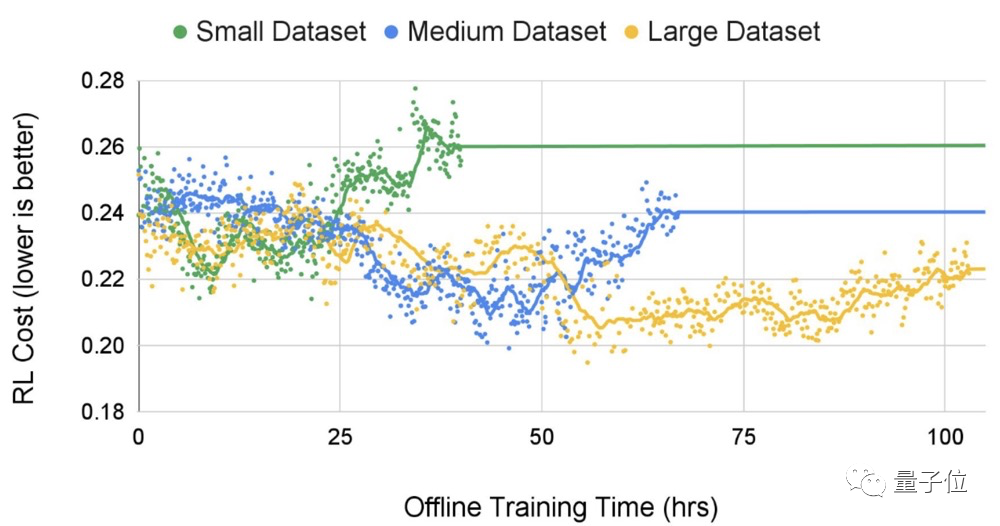

在不同規模的數據集上進行測試,研究人員發現,隨著數據集規模的擴大,生成布局的質量和收斂時間的結果更優。

谷歌表示,

這一方法適用于任何類型的芯片。

目前已經被用于生產下一代Google TPU(加速器芯片)。