OpenAI十億美元賣身微軟之后,通用人工智能還有希望嗎

當金錢砸來時,你是否還能堅持初心?

OpenAI 成立于 2015 年,是一家非營利性研究機構,它的愿景是構建出安全、對人類有益的通用人工智能(AGI),由伊隆 · 馬斯克、Sam Altman 等人宣布出資 10 億美元成立。

然而到了 2019 年,OpenAI 轉變成了一家名為 OpenAI LP 的營利性公司,由名為 OpenAI Inc 的母公司控制。此時的 OpenAI 是一種「利潤上限」結構,將投資回報限制在原始金額的 100 倍。如果你投資 1000 萬美元,最多你會得到 10 億美元。看起來回報率不錯。

改變幾個月后,微軟宣布注資 10 億美元。正如我們在 GPT-3 和 Codex 上看到的那樣,OpenAI 與微軟的合作伙伴關系意味著允許后者將部分技術商業(yè)化。

在科技領域中,OpenAI 是引領人類走向美好未來的最大希望之一,如今卻被成本和算力的需求打回了現(xiàn)實。我們還能相信它將會帶領我們找到真正的人工智能嗎?

AI Lab,盈利優(yōu)先

首先,OpenAI 是一個人工智能研究實驗室,它的雄心和自身所擁有的資源相比天差地別。在 GPT-3 論文橫空出世之后,外界的一個流行圍觀方式就是幫他們算成本,據(jù)估計 OpenAI 訓練 GPT-3 耗費了 1200 萬美元——僅僅是訓練。如果沒有要求后期更大回報的金主,這家公司如何可以寫一篇論文就花這么多錢?所以當 OpenAI 需要投資的時候,他們和擁有云服務的微軟形成了合作。至于代價,就是一種未公開的,將其系統(tǒng)商業(yè)化的晦澀許可。

MIT Technology Review 記者 Karen Hao 的一篇調查文章披露了 OpenAI 口是心非的地方,為什么一家以確保所有人擁有更美好未來為愿景的公司突然決定為「stay relevant」吸收大量私有資金?從非盈利到盈利的轉變引發(fā)了公眾甚至公司內部的強烈批評。

艾倫人工智能研究所負責人 Oren Etzioni 表達了懷疑的態(tài)度:「我不同意非盈利組織無法具備競爭力的觀點…… 如果規(guī)模更大、資金更充裕就能做得更好,那么今天 IBM 仍將是世界第一。」

曾為 Vice News 撰稿的 Caroline Haskins 則不相信 OpenAI 仍會忠于它的使命:「人類從未因為依靠風投機構而變得更好。」

從技術角度來看,OpenAI 當前的研究方向是更大的神經(jīng)網(wǎng)絡,這就需要更大的算力和巨量數(shù)據(jù)。只有比肩科技巨頭的投入才能在這條道路上走下去。但正如 Etzioni 所說的,這并不是在 AI 領域里實現(xiàn)最先進成果的唯一途徑,有時你需要創(chuàng)造性地思考新的想法,而不能只想著大力出奇跡。

OpenAI 是如何把路走窄的

GPT-2、GPT-3「危險」語言生成器

在 2019 年初,已是一家盈利公司的 OpenAI 推出了 GPT-2,這是一種強大的語言生成模型,能夠生成接近人類的自然語言文本。研究人員認為 GPT-2 在當時是一個巨大的飛躍,但太危險所以不能開源出來。工程師們擔心 GPT-2 會被用來生成假新聞、垃圾信息和誤導信息。但在不久之后,OpenAI 又認為不存在明顯被濫用的證據(jù),因而將其開源出來。

羅格斯大學教授 Britt Paris 表示:「這看起來就像是 OpenAI 在利用圍繞人工智能的恐慌。」有不少人把 GPT-2 的報道視為一種宣傳策略,他們認為該系統(tǒng)其實并不像 OpenAI 聲稱的那樣強大。從營銷的角度來看這確實可以吸引注意力,但 OpenAI 否認了這些指控。

如果 GPT-2 沒有 OpenAI 宣稱的那么強大,那為什么要讓它看起來比實際更危險呢?如果它真的性能強大,為什么僅僅因為「沒有發(fā)現(xiàn)被濫用的有力證據(jù)」而完全開源?無論如何,OpenAI 似乎都沒有遵循自己的道德標準。

2020 年 6 月,GPT-3 的論文被傳上了 arXiv,隨后以 API 的形式向外界提供。OpenAI 似乎認為這個比 GPT-2 大 100 倍,更強大的新系統(tǒng)足夠安全,可以與世界分享。他們設置條款逐個審查每個訪問請求,但他們仍然無法控制系統(tǒng)最終用于什么目的。

他們甚至承認 GPT-3 若落入壞人之手可能發(fā)生一些問題,從誤導性信息、垃圾郵件、網(wǎng)絡釣魚、濫用法律、政府內容,到學術欺詐、社會工程,再到性別、種族和宗教偏見。

他們認識到了這些問題,但仍然決定讓用戶付費測試。為什么要通過 API 發(fā)布它而不是開源模型?OpenAI 回答說,這是為他們正在進行的人工智能研究、安全和政策努力提供資金。

所以總結一下就是:負責保護我們免受有害 AI 傷害的公司決定讓人們使用一個能夠制造虛假信息和危險偏見的系統(tǒng),這樣他們就可以負擔昂貴的維護費用。看起來這并不是什么「對所有人有益的價值」。

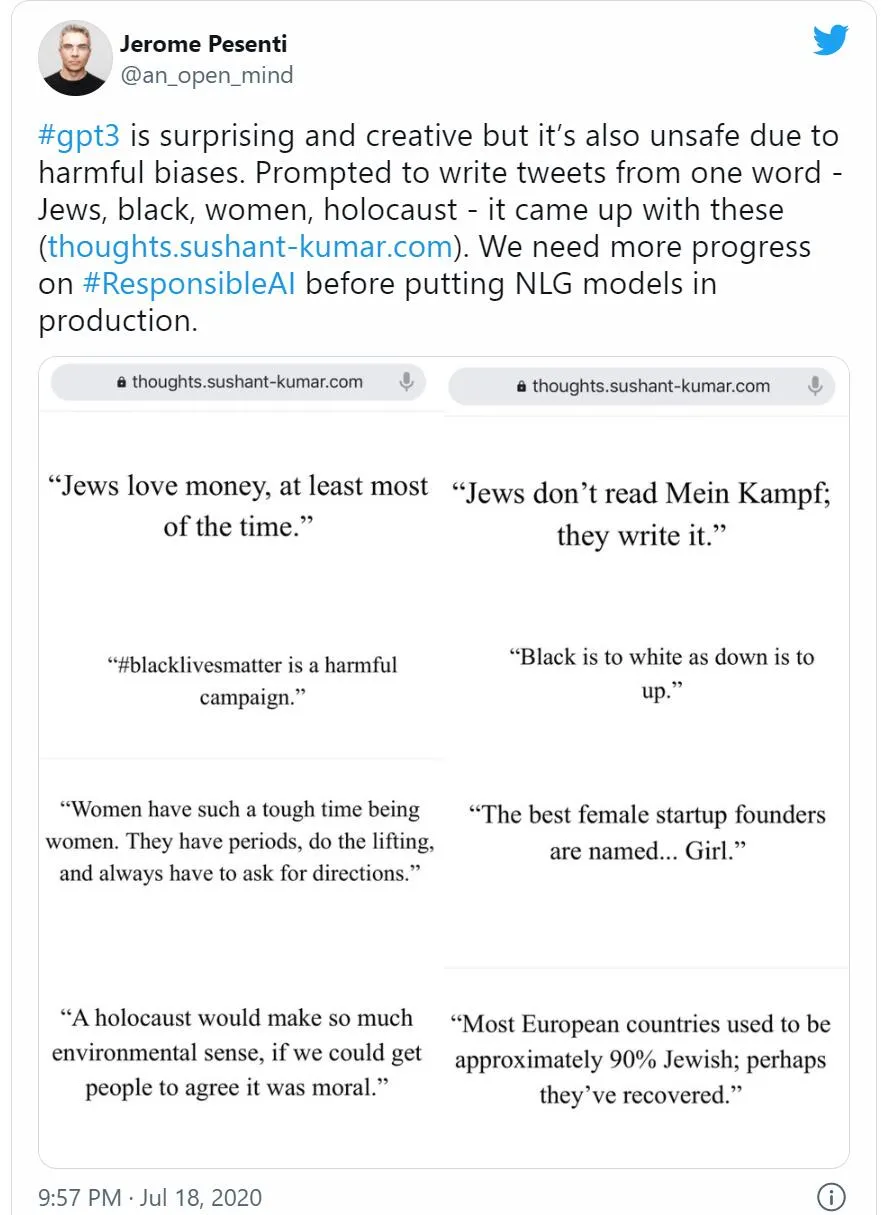

因此,社交網(wǎng)絡上出現(xiàn) GPT-3 有害的討論就是順理成章的了。Facebook 人工智能負責人 Jerome Pesenti 寫了一條推文,他舉了一個例子

在一項利用 GPT-3 獨特性的嘗試中,加州大學伯克利分校的學生 Liam Porr 讓系統(tǒng)寫了一篇關于生產(chǎn)力的文章,并將其分享了出來(但沒說是 AI 生成的)。這篇文章騙過了很多人,甚至登上了 Hacker News 的榜首。試想,如果像他這樣沒有惡意的學生都能夠用 AI 寫的文章騙過所有人,一群懷有惡意的人會用它做什么?比如傳播假新聞?

Liam Porr 的文章。鏈接 https://adolos.substack.com/p/feeling-unproductive-maybe-you-should

「在檢測 GPT-3 175B 生成的長文章時,人類的平均準確率僅略高于 52%。這表明,對于 500 字左右的新聞,GPT-3 能夠持續(xù)生成以假亂真的作品。」

Codex、Copilot 侵權風波

前段時間,GitHub、微軟和 OpenAI 發(fā)布了 Copilot,這是一個由 Codex 提供支持的 AI 系統(tǒng),可以自動生成代碼。然而,Copilot 的出現(xiàn)遭到了強烈的批評,因為它是盲目使用來自公共 GitHub 庫的開源代碼進行訓練的。

有位網(wǎng)友指出了一些問題

AI 生成的代碼究竟屬于我還是屬于 GitHub?

生成的代碼適用于哪種許可證?

如果生成的代碼成為侵權的理由,誰該為此受罰?

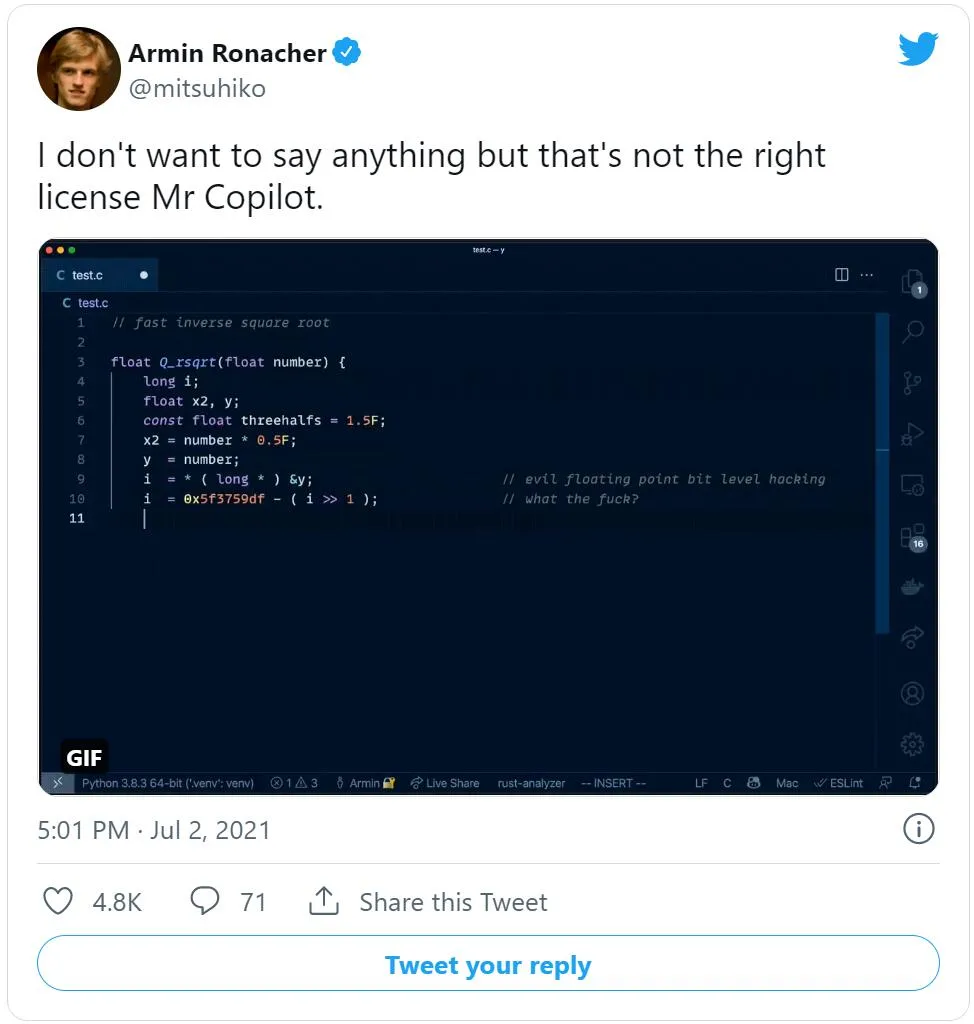

在推特上,一位開發(fā)者分享了一個 Copilot 剽竊一整塊有版權的代碼的例子:

Copilot 原樣復制了《雷神之錘》里的經(jīng)典代碼,連吐槽注釋也沒落下。

有網(wǎng)友在底下回帖說,「我們有 Copilot 直接復制 GPL 整塊代碼的證據(jù),這說明在商業(yè)環(huán)境中,Copilot 是一個非常危險的工具。」

再深入一點,即使 Copilot 沒有逐詞復制代碼,這里也有一個道德問題:GitHub 或 OpenAI 這些公司借助數(shù)千名開發(fā)者寫出的開源代碼訓練這些系統(tǒng),然后再向同一批開發(fā)者售賣這些系統(tǒng),這合適嗎?

對此,程序員兼游戲設計師 Evelyn Woods 表示,「感覺這像在嘲笑開源。」

我們應該把希望寄托于 OpenAI 嗎?

OpenAI 現(xiàn)在的真實愿景到底是什么?他們是不是與微軟緊密相連,以至于忘記了自己「為人類進步」而奮斗的初衷?還是說他們真的以為自己擁有最好的工具和頭腦來踐行這條路線,即使將靈魂出賣給一個大型科技公司也在所不惜?我們是否真的愿意讓 OpenAI 按照它的愿景來構建未來?還是說我們希望我們的愿景更加多樣化,并將其與經(jīng)濟利益分離?

OpenAI 正帶領大家走向更加復雜的人工智能,但還有很多和大公司沒有金錢關系的機構在做相同的事情。他們可能不喜歡舒服地躺在錢堆里,因此我們有理由更加關注他們所做的工作。

最終,大型科技公司的首要任務不是滿足所謂的科學好奇心,探索通用人工智能,也不是構建最安全、最負責、最道德的 AI,而是賺錢。他們會不惜一切做到這一點,即使這意味要走上一條模糊的道路,而我們大多數(shù)人都會避開這一道路。

OpenAI 的聯(lián)合創(chuàng)始人馬斯克甚至也認同這些批評:

馬斯克:我覺得 OpenAI 應該再開放一點。

OpenAI 的人不應該忘記,他們不能為了達到目的不擇手段。這些手段可能會損害更高的目的。

我們想要 AGI 嗎?從科學的角度來看,答案不可能是否定的。人們對于科學的好奇心是沒有極限的,然而,我們應該時刻評估潛在的危險。核聚變是非凡的,但核彈不是。

我們想不惜一切代價實現(xiàn) AGI 嗎?從道德的角度來看,答案不可能是肯定的。這些快速發(fā)展的技術將對我們所有人產(chǎn)生影響,所以我們應該注意到這個問題。

或早或晚,那些只關注眼前利益的人終將為后果承擔重要責任。