打開AI的黑匣子:“可解釋的”人工智能(XAI)認知攻略!

如今,企業組織越來越依賴人工智能和機器學習模型進行決策,可以說這些決策正在影響我們生活的方方面面,例如,銀行使用人工智能來確定是否向客戶提供信貸以及信貸額度;醫療放射科部署人工智能來幫助區分健康組織和腫瘤;人力資源團隊使用人工智能從海量簡歷中篩選合適的應聘者。

2019年,歐盟出臺的《人工智能道德準則》中明確提出,人工智能的發展方向應該是“可信賴的”,能夠包含安全、隱私和透明、可解釋等多個方面。但隨著人工智能技術不斷普及,由此產生的風險也浮出水面,主要體現在兩大方面:

- 信任危機,即能否信任和依賴人工智能算法輸出的結果。

- 道德危機,Deepfake技術的出現在帶來新鮮感的同時,也引發了人們對于深度學習和人工智能技術濫用的擔憂。

“黑盒”人工智能

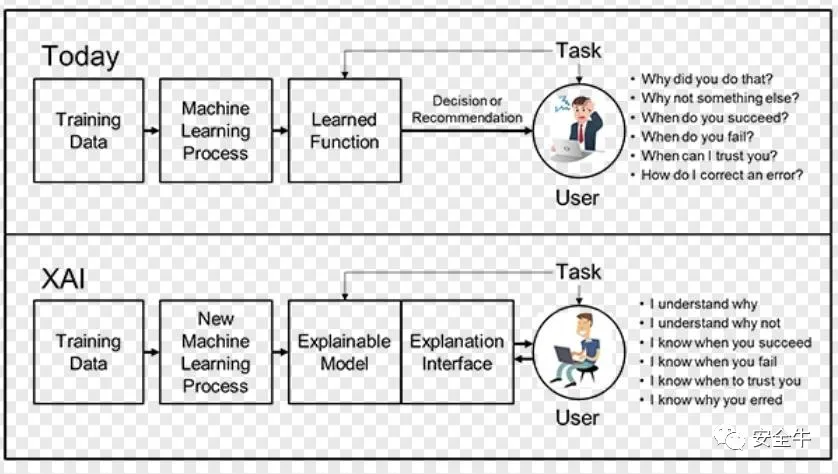

如今,許多機器學習應用程序不允許人們完全理解其功能或背后的邏輯,以實現稱為“黑盒”的效果,鑒于此,如今的機器學習模型大多是“黑盒”。

這個特性被認為是人工智能技術應用的最大問題之一,它讓機器決策變得不透明,甚至專家或開發人員自己也常常難以理解,這也降低了企業對特定領域的機器學習和人工智能的信任感。

【黑盒AI和XAI】

可以說,傳統的“黑盒”人工智能程序存在以下問題:

- 難以驗證輸出是否“正確”;

- 難以理解人工智能系統“哪里出錯”,然后進行改進;

- 難以理解創作者的偏見和不公。

因此,了解人工智能算法預測背后的原因至關重要,這不僅可以增強人們對人工智能算法的信心,還可以提供對模型的見解或允許對開發的算法執行調試過程。

公眾愈發有興趣了解這些算法背后的過程,原因之一是各種國際法(例如歐盟GPDR)的引入提高了公眾對隱私的敏感度,這些法律對隱私領域施加了高水平的保護,同時在信息處理過程中要求了更高的透明度,這也是人工智能算法目前正在努力實現的目標。

所有這一切都轉化為對人工智能算法透明度日益增長的需求。而人工智能背景下對透明度的需求也進一步推動了所謂的“可解釋的”人工智能(XAI)的發展,它代表了一組技術,可以理解和呈現機器學習模型和人工智能算法的透明愿景。

什么是“可解釋的”人工智能?

“可解釋的”人工智能并不是一個新的研究領域,它是自80年代以來就存在的支持復雜AI系統的推理架構,可以看作是人工智能設計的自然結果。

人工智能的未來可能取決于它允許人們與機器協作解決復雜問題的能力。與任何高效協作一樣,這需要良好的溝通、信任和理解,而可解釋的人工智能旨在應對這些挑戰。

簡單來說,可解釋的人工智能是組織用來幫助人們更好地理解模型為何做出某些決策及其工作原理的一組工具和技術。XAI是:

- 一組最佳實踐:它利用數據科學家多年來一直使用的一些最佳程序和規則來幫助其他人了解模型是基于哪些數據進行訓練的,還揭示了模型可能暴露于哪些偏見來源;

- 一組設計原則:研究人員越來越關注簡化AI系統的構建,使其本質上更易于理解;

- 一組工具:隨著系統變得更容易理解,可以通過將這些知識融入其中來進一步完善訓練模型,并通過向其他人提供這些知識以納入他們的模型。

XAI為什么很重要?

對于組織而言,通過模型監控和人工智能問責制全面了解人工智能決策過程,而不是盲目信任它們,這一點至關重要。可解釋的人工智能可以幫助人類理解和解釋機器學習(ML)算法、深度學習和神經網絡。

ML模型通常被認為是無法解釋的黑匣子;深度學習中使用的神經網絡是人類最難理解的部分;偏見(通常基于種族、性別、年齡或位置)一直是訓練AI模型所面臨的長期風險。此外,由于生產數據與訓練數據不同,人工智能模型性能可能會受到影響甚至降低。這使得持續監控和管理模型以促進人工智能可解釋性變得至關重要。

可解釋的人工智能有助于促進最終用戶的信任、模型可審計性和人工智能的高效使用,同時還降低了使用人工智能所面臨的合規性、法律、安全和聲譽風險。此外,借助可解釋的人工智能,企業可以排除故障并提高模型性能,同時幫助利益相關者了解人工智能模型的行為。

其優勢可以概括為:

- 簡化模型評估過程,同時提高模型透明度和可追溯性;

- 系統地監控和管理模型以優化業務成果,不斷評估和改進模型性能;

- 加快獲得AI結果的時間;

- 降低模型治理的風險和成本;

可解釋的人工智能是實施“負責任的”人工智能的關鍵要求之一,具有公平性、模型可解釋性和問責制。為了實現負責任地采用人工智能,組織需要通過構建基于信任和透明度的人工智能系統,將道德原則嵌入人工智能應用程序和流程中。

XAI的應用實例

如今,可解釋的人工智能正在改變各種垂直市場的游戲規則:

- 醫療衛生:加速診斷、圖像分析和資源優化,提高患者護理決策的透明度和可追溯性,同時還能簡化藥品審批流程。

- 金融服務:通過透明的貸款和信貸審批流程改善客戶體驗,加快信用風險、財富管理和金融犯罪風險評估,加速解決潛在的投訴和問題,提高對定價、產品推薦和投資服務的信任度。

- 刑事司法:優化預測和風險評估流程。在DNA分析、監獄人口分析、欺詐檢測和犯罪預測方面使用可解釋的人工智能加速解決問題。檢測訓練數據和算法中的潛在偏差。

可解釋的人工智能的五個注意事項:

- 公平和消除偏見:管理和監控公平,掃描用戶部署以查找潛在的偏見;

- 模型偏離緩解:分析模型并根據最合乎邏輯的結果提出建議。當模型偏離預期結果時發出警報;

- 模型風險管理:量化和減輕模型風險。當模型表現不佳時發送警報。了解當偏差持續存在時會發生什么;

- 生命周期自動化:構建、運行和管理模型作為集成數據和AI服務的一部分。統一平臺上的工具和流程以監控模型和共享結果,解釋機器學習模型的依賴關系;

- 多云就緒:跨混合云部署AI項目,包括公共云、私有云和本地。通過可解釋的AI促進信任和信心。

當今時代,人們迫切需要可解釋的人工智能,而“負責任”和“可解釋”的人工智能也確實將會是取得利益雙方信任及滿足未來合規需求的基石,但想要實現這一目標無疑是道阻且長的。

【本文是51CTO專欄作者“安全牛”的原創文章,轉載請通過安全牛(微信公眾號id:gooann-sectv)獲取授權】