華人團隊用Transformer做風(fēng)格遷移,速度快、可試玩,網(wǎng)友卻不買賬

在圖像渲染領(lǐng)域,神經(jīng)繪畫(Neural painting)指的是為一張給定圖像生成一系列筆畫(stroke),并借助神經(jīng)網(wǎng)絡(luò)對其進行非真實性重建。如下圖第一行每張圖像的左下角為真實圖像,以及重建后的非真實圖像;第二行為漸進的繪畫過程。

對于神經(jīng)繪畫任務(wù),雖然基于強化學(xué)習(xí)(RL)的智能體可以一步步地生成筆畫序列,但訓(xùn)練一個穩(wěn)健的 RL 智能體并不容易。另一方面,筆畫優(yōu)化方法在一個大的搜索空間中迭代地搜索一系列筆畫參數(shù)。因此,這種低效率的搜索方法極大地限制了基于 RL 方法的泛化性和實用性。

上個月,在一篇 ICCV 2021 Oral 論文中,來自百度 VIS 團隊和羅格斯大學(xué)等機構(gòu)的研究者將神經(jīng)繪畫視作一個集合預(yù)測問題,提出了全新的、基于 Transformer 的框架——Paint Transformer,從而利用前饋網(wǎng)絡(luò)來預(yù)測筆畫集合的參數(shù)。就其效果而言,研究者提出的模型可以并行地生成一系列筆畫,并幾乎能夠?qū)崟r地得到尺寸為 512×512 的重建繪畫。

更重要的是,由于訓(xùn)練 Paint Transformer 沒有可用的數(shù)據(jù)集,研究者設(shè)計了一個自訓(xùn)練的 pipeline,這樣既可以在不使用任何現(xiàn)成數(shù)據(jù)集的情況下訓(xùn)練,又依然能夠?qū)崿F(xiàn)極好的泛化能力。實驗結(jié)果表明,Paint Transformer 在訓(xùn)練和推理成本更低的情況下,實現(xiàn)了較以往方法更好的性能。

- 論文地址: https:// arxiv.org/pdf/2108.0379 8.pdf

- 項目地址: https:// github.com/wzmsltw/Pain tTransformer

研究者在 Hugging Face 上提供了一個試玩界面,用戶只需上傳圖像即可生成動態(tài)重建過程和重建后的繪畫。小編也嘗試上傳了一張圖像,生成效果如下所示:

原圖與重建后的繪畫。

動態(tài)重建過程如下:

試玩地址: https:// huggingface.co/spaces/a khaliq/PaintTransformer

不過,雖然 Paint Transformer 的效果不錯,但一些 reddit 網(wǎng)友似乎并不買賬。有人認為,「這么簡單的任務(wù)根本不需要使用機器學(xué)習(xí)或神經(jīng)網(wǎng)絡(luò)來解決。」

更有網(wǎng)友表示,「我曾使用 Processing,僅用 50 行 Scala 代碼就實現(xiàn)了類似的結(jié)果。」

方法

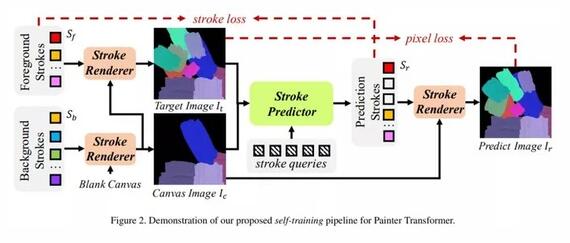

研究者將神經(jīng)繪畫視作一個漸進的筆畫預(yù)測過程。在每一步并行地預(yù)測多個筆畫,以前饋的方式最小化當(dāng)前畫布和目標圖像之間的差異。就其結(jié)構(gòu)而言,Paint Transformer 由兩個模塊組成,分別是筆畫預(yù)測器(Stroke Predictor)和筆畫渲染器(Stroke Renderer)。

圖 2Paint Transformer 的自訓(xùn)練 pipeline。

如上圖 2 所示,給定一張目標圖像 I_t 和中間畫布圖像 I_c,筆畫預(yù)測器生成一系列參數(shù)以確定當(dāng)前筆畫集合 S_r。接著,筆畫渲染器在 S_r 中為每個筆畫生成筆畫圖像,并將它們畫在畫布 I_c 上,從而生成結(jié)果圖像 I_r。這一過程可以用以下公式(1)來描述:

在 Paint Transformer 中,只有筆畫預(yù)測器包含可訓(xùn)練的參數(shù),而筆畫渲染器是無參數(shù)和可微的模塊。為了訓(xùn)練筆畫預(yù)測器,研究者提出了一個利用隨機合成筆畫的自訓(xùn)練 pipeline。

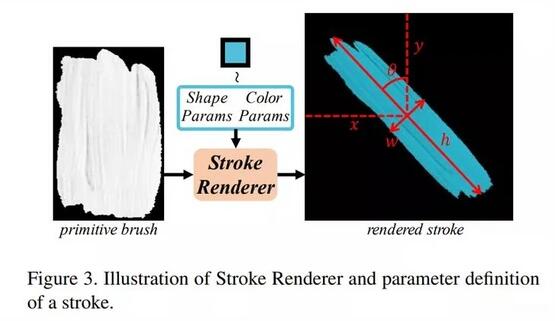

筆畫定義與渲染器

該研究主要考慮了直線筆畫,這種筆畫可以通過形狀參數(shù)和顏色參數(shù)來表征。如下圖 3 所示,一個筆畫的形狀參數(shù)包括:中心點坐標 X 和 Y,高度 h,寬度 w 和渲染角θ。

筆畫渲染器和參數(shù)定義。

對于神經(jīng)繪畫任務(wù)而言,可微渲染是基于筆畫參數(shù)合成筆畫圖像并由此實現(xiàn)筆畫預(yù)測器端到端訓(xùn)練的一個重要問題。但是,對于該研究中的特定筆畫定義,研究者沒有采用神經(jīng)網(wǎng)絡(luò),而是使用了基于筆畫渲染器的幾何變換,從而如預(yù)期一樣不需要訓(xùn)練并且是可微的。筆畫渲染器可以用以下公式(3)來描述:

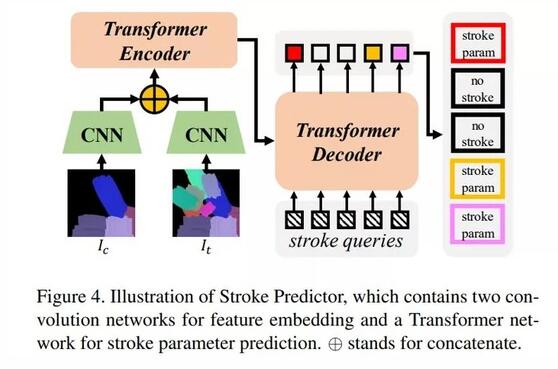

筆畫預(yù)測器

筆畫預(yù)測器的目標是為了預(yù)測一系列「cover 中間畫布圖像和目標圖像之間差異」的筆畫。此外,為了達到可以模擬真實繪畫過程的抽象程度,研究者希望筆畫預(yù)測器在預(yù)測很少筆畫的同時,依然可以 cover 大部分的差異區(qū)域。

為了實現(xiàn)這一目標,他們在 DETR 的啟發(fā)下,提出了一個基于 Transformer 的預(yù)測器。該預(yù)測器輸入 I_c 和 I_t,生成一個筆畫集合,可以用以下公式(5)來描述:

如下圖 4 所示,筆畫預(yù)測器以 I_c 和 I_t ∈ R^3×P ×P 作為輸入,首先采用兩個獨立的卷積神經(jīng)網(wǎng)絡(luò)來提取它們的特征映射 F_c 和 F_t ∈ R^C×P/4×P/4。

損失函數(shù)

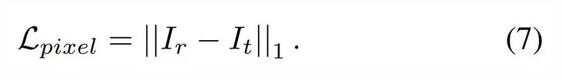

研究者介紹了像素損失、筆畫之間差異的測量以及筆畫損失。

首先是像素損失。神經(jīng)繪畫的一個直觀目標是重新創(chuàng)建目標圖像。因此,I_r 和 I_t 之間的像素損失 L_pixel 在圖像級別受到懲罰:

然后是筆畫損失。訓(xùn)練期間,有效真值筆畫的數(shù)量是變化的。因此,按照 DETR,在預(yù)定義最大筆畫數(shù) N 的情況下,研究者首先需要在 N 筆畫的預(yù)測集 ¯S_r 和真值集 S_g 之間生成匹配機制以計算損失。

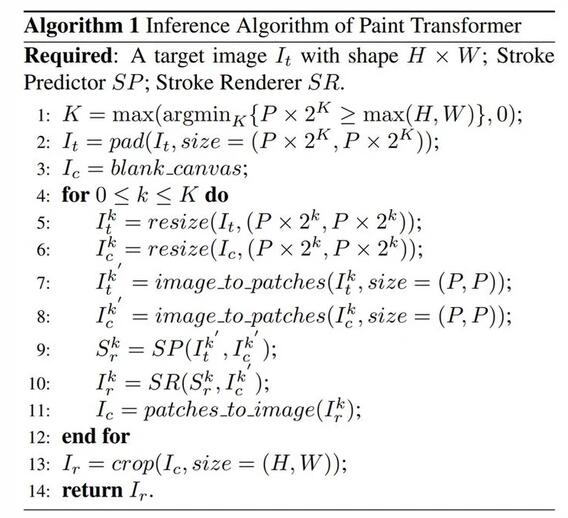

推理

為了模仿人類畫家,研究者設(shè)計了一種從粗到精(coarse-to-fine)的算法,在推理過程中生成繪畫結(jié)果。Paint Transformer 的推理算法如下所示:

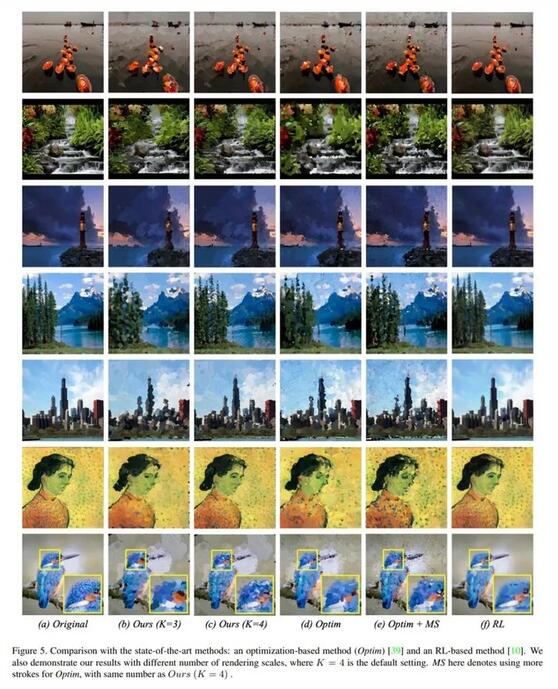

實驗

定性比較。如下圖 5 所示,研究者將 Paint Transformer 分別與基于優(yōu)化和基于強化學(xué)習(xí)的 SOTA 筆畫繪畫生成方法進行了比較。其中,相較于基于優(yōu)化的方法,Paint Transformer 可以生成渲染力更強、更清晰的結(jié)果。不過,Paint Transformer 的生成效果明顯不如基于強化學(xué)習(xí)的方法。

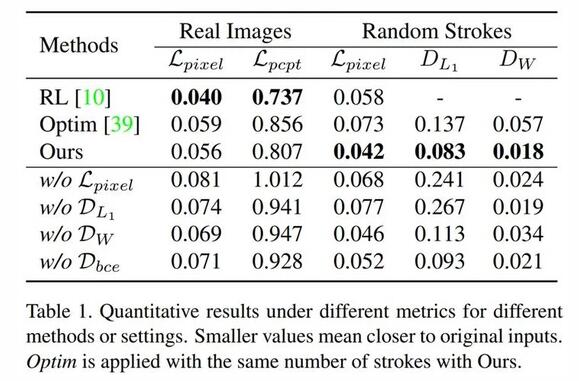

定量比較。如下表 1 所示,定量比較的結(jié)果與定性比較保持一致。借助生動的畫筆紋理,Paint Transformer 能夠較基于優(yōu)化的方法更好地表征原始內(nèi)容。Zhewei Huang 等人論文《 Learning to paint with model-based deep reinforcement learning 》中提出的方法實現(xiàn)了最佳內(nèi)容保真度,但在抽象處理上較弱。

數(shù)值結(jié)果表明,Paint Transformer 可以成功地預(yù)測筆畫,并優(yōu)于其他方法。

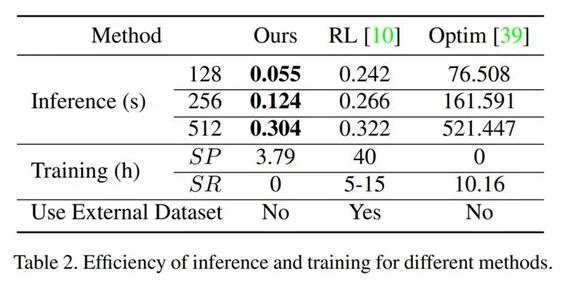

效率比較。如下表 2 所示,研究者在一個英偉達 2080Ti 上評估了訓(xùn)練與推理時間。在推理期間,Paint Transformer 以前饋的方式并行地生成一系列筆畫,因而運行速度明顯快于優(yōu)化基線方法,也略快于強化學(xué)習(xí)基線方法;對于訓(xùn)練而言,研究者僅需要幾個小時就可以訓(xùn)練一個筆畫預(yù)測器,從總訓(xùn)練時長方面比基于優(yōu)化和強化學(xué)習(xí)的方法更方便。并且,無模型筆畫渲染器和無數(shù)據(jù)筆畫預(yù)測器可以高效和方便地使用。

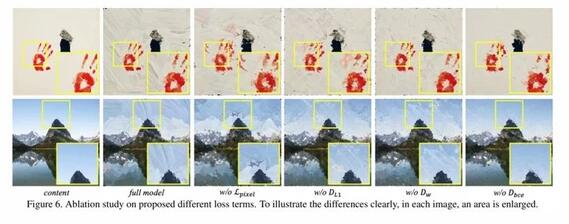

消融實驗結(jié)果如下圖 6 所示:

風(fēng)格化繪畫。Paint Transformer 可以方便地與藝術(shù)風(fēng)格遷移方法融合,從而生成更吸引人和風(fēng)格化的繪畫。研究者使用 LapStyle 和 AdaAttN 等現(xiàn)有風(fēng)格遷移方法,在風(fēng)格化內(nèi)容圖像上生成自然的繪畫。如下圖 8 所示,借助這種富有想象力的方式,研究者生成了具有豐富顏色和紋理的風(fēng)格化繪畫。