百倍訓練效率提升,微軟通用語言表示模型T-ULRv5登頂XTREME

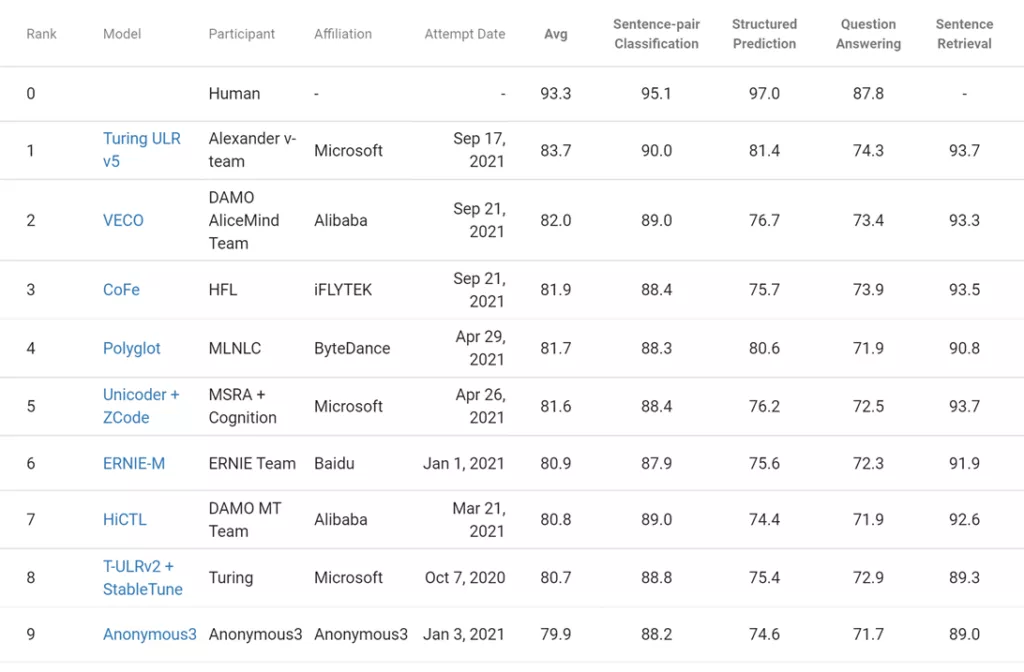

剛剛,微軟打造的最新圖靈通用語言表示模型 T-ULRv5 模型再次成為 SOTA 模型,并在 Google XTREME 公共排行榜上位列榜首。

這項研究由 Microsoft Turing 團隊和 Microsoft Research 合作完成,T-ULRv5 XL 模型具有 22 億參數,以 1.7 分的平均分優于當前性能第二的模型(VECO)。這也是該系列模型在排行榜上的四個子類別任務中最新技術。

XTREME 排行榜:T-ULRv5 位居榜首。

這些結果證明了 T-ULRv5 具有強大的能力,此外,其訓練速度比前幾代模型快 100 倍。

這一結果標志著微軟重返排行榜榜首,此前微軟的 T-ULRv2 模型也曾位居 XTREME 排行榜首。為了實現這一最新結果,研究人員將 XLM-E 模型擴大到具有 22 億參數的 XL 模型,并將其與數據、架構和優化策略方面的突破相結合,以生成最終的預訓練模型。此外,研究人員還部署了稱為 XTune 的先進微調技術。

XTREME(Cross-lingual TRansfer Evaluation of Multilingual Encoders)基準涵蓋 40 種類型不同的語言,跨越 12 個語言家族,包括九個任務,這些任務需要對不同層次的語法或語義進行推理。之所以選擇 XTREME 的語言作為基準,是為了最大限度地增加語言的多樣性、現有任務的覆蓋面和訓練數據的可用性。

XTREME 包含的任務涵蓋了一系列的范例,包括句子文本分類、結構化預測、句子檢索和跨語言問答。因此,要使模型在 XTREME 基準測試中取得成功,模型必須學習適用于標準跨語言遷移設置的表示。

有關基準測試、語言和任務的完整描述,請參閱論文《 XTREME: A Massively Multilingual Multi-task Benchmark for Evaluating Cross-lingual Generalization 》。

T-ULRv5:高質量且高效的模型

T-ULRv5 是 Turing 模型家族的最新成員,是微軟在大規模 AI 方面的代表作。這一跨語言模型結合了微軟近期對 XLM-E 的研究,它能夠編碼來自 94 種語言的文本,并在共享向量空間中表示。大規模神經網絡模型領域的前沿研究有很多條探索路線,其中之一就是模型大小,一般大模型往往比小模型表現更好。

在沒有其他方面創新的情況下增加模型大小通常會導致對高成本計算的低效使用,比如更好的詞匯量、更高質量的數據、新的訓練任務和目標、創新的網絡架構和訓練優化等等。這一次,研究者在這些方面引入并整合了突破性創新,使得 T-ULRv5 成為高質量且高效的模型。

此外,T-ULRv5 還引入了一些重要創新,與其他訓練的多語言模型區分開來,使得 SOTA 模型的訓練效率大大提高。

模型架構、預訓練和任務

T-ULRv5 同為 transformer 架構,該架構在新興的基礎模型和多語言模型(如 mBERT、mT5、XLM-R 和之前版本的 T-ULRv2)中很受歡迎。具體而言,這次預訓練的最大變體 T-ULRv5 XL 具有 48 個 transformer 層、1536 個 hidden dimension size、24 個注意力頭、500000 個 token 的多語言詞匯量,以及參數量總共為 22 億。

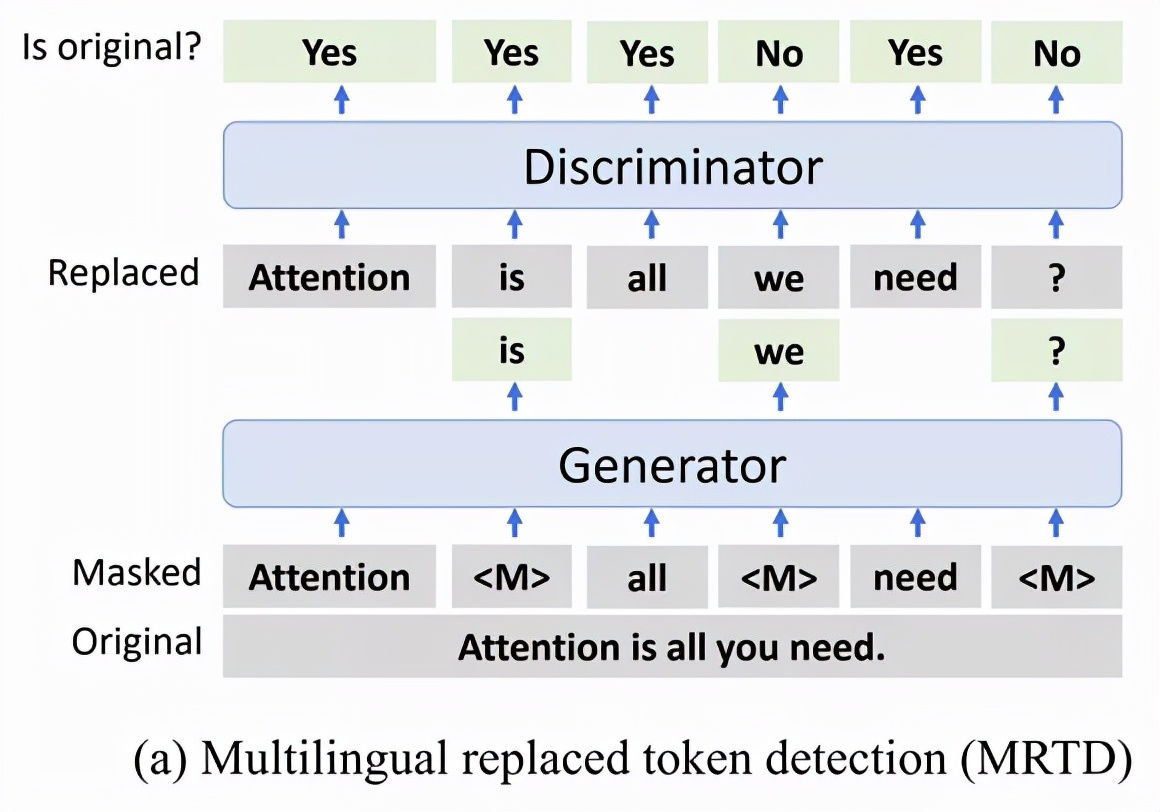

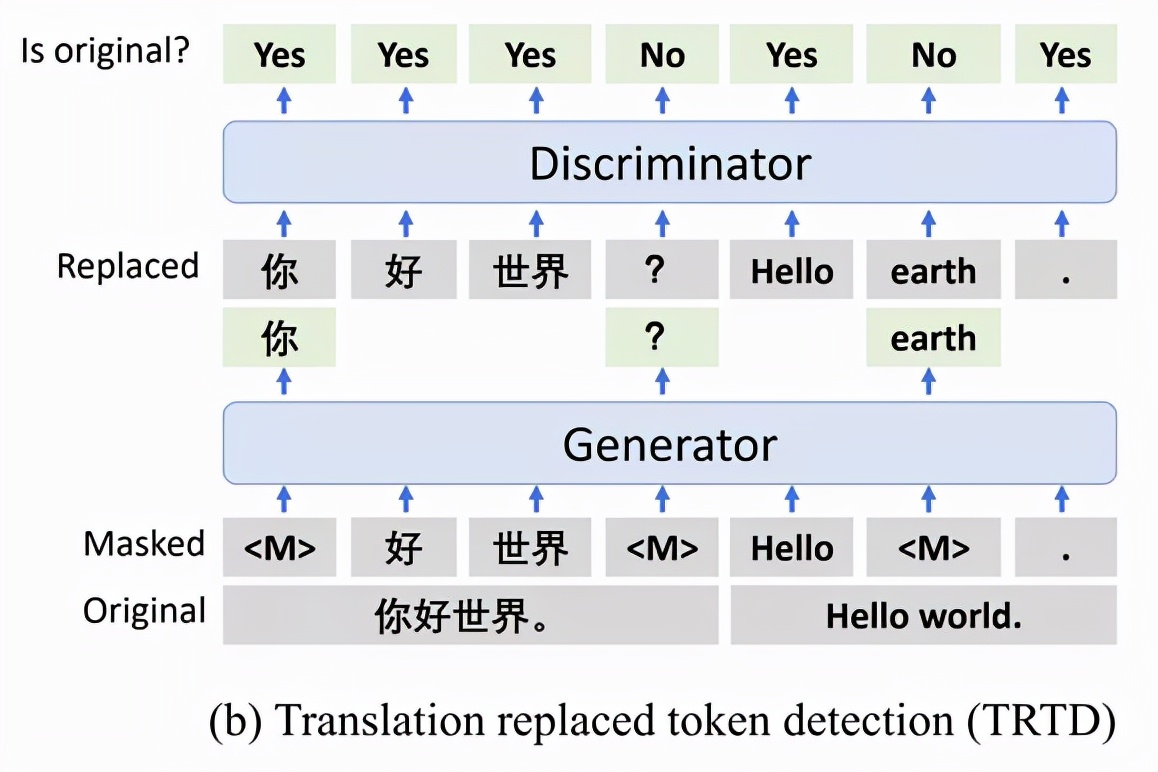

與此前的 InfoXLM 有所不同,T-ULRv5 背后的技術 XLM-E 是啟發于 ELECTRA 的。它沒有選擇 InfoXLM 的 MMLM(多語言掩碼語言建模)和 TLM(翻譯語言建模)預訓練任務,而是采用了兩個新任務 MRTD(多語言替換 token 檢測)和 TRTD(翻譯替換 token 檢測),目標是區分真實輸入 token 和損壞的 token。

圖 2:MRTD 預訓練任務。生成器預測輸入中的掩碼 tokens,鑒別器預測每個 token 是否被生成器樣本替換。

圖 3:TRTD 預訓練任務。生成器預測輸入中翻譯對上的掩碼 tokens,鑒別器預測每個 token 是否被生成器樣本替換。

和 ELECTRA 一樣,T-ULRv5 的訓練涉及兩個 transformer 編碼器,分別用作生成器和鑒別器。但和僅在英語數據集上訓練的 ELECTRA 不同,T-ULRv5 在大規模多語言數據集上進行了訓練,包括平行文本語料庫。

研究者讓模型通過使生成器預測單語輸入和翻譯對上的掩碼 tokens,以更好地學習跨語言對齊和共享表征。完成預訓練后,僅使用鑒別器作為文本編碼器對下游任務進行微調。

訓練效率提高 100 倍

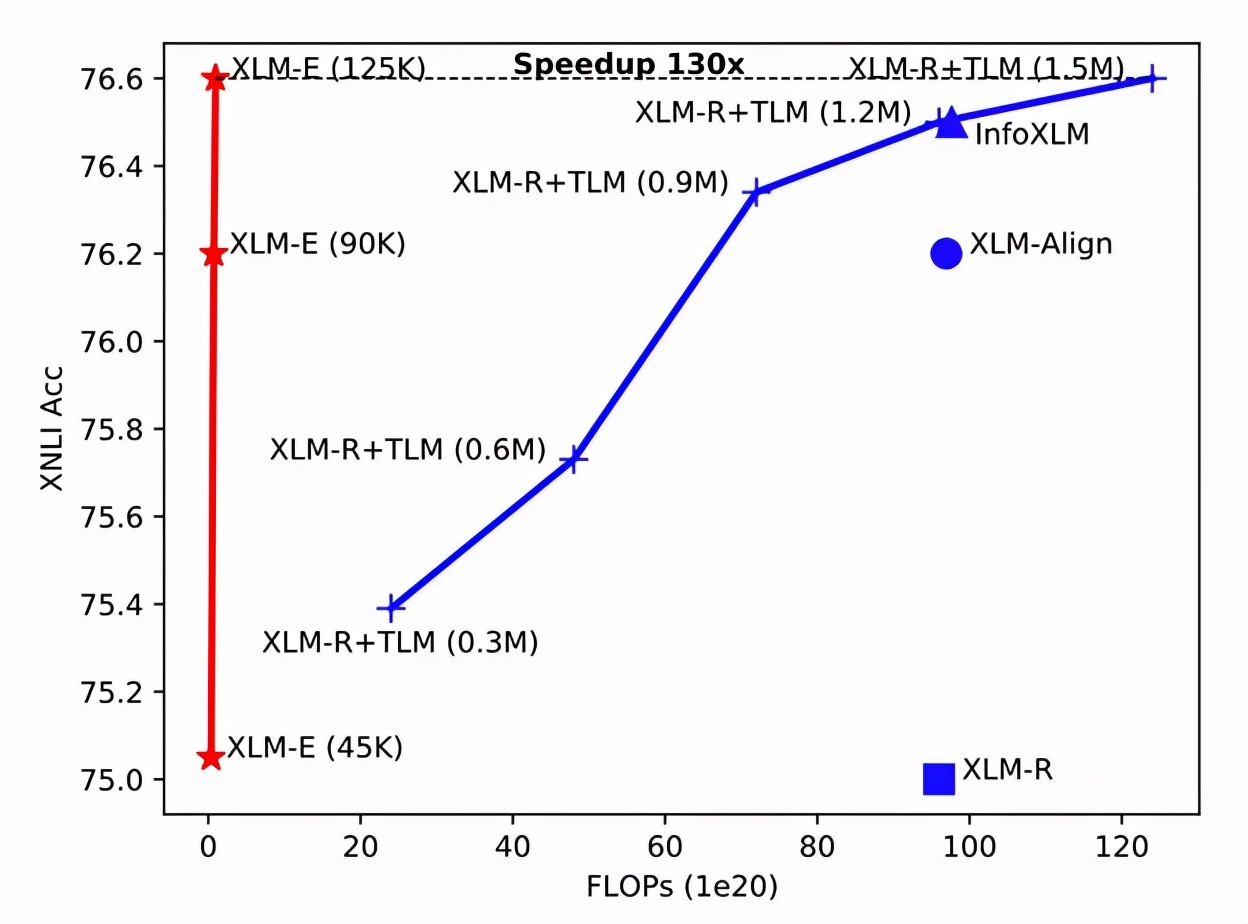

現有的基于掩碼語言建模 (MLM) 的跨語言預訓練方法通常需要大量計算資源,成本非常昂貴。相比之下,XLM-E 的訓練速度明顯更快,它在各種跨語言理解任務上的表現優于基線模型,而且計算成本要低得多。例如,使用相同的語料庫、代碼庫和模型大小(12 層),研究者將 XLM-E(在圖 4 中用紅線表示)與 Facebook 多語言 XLM-R 模型的內部版本進行了比較翻譯語言建模(XLM-R + TLM,在圖 4 中用藍線表示)。

可以觀察到, XLM-E 的訓練速度提高了 130 倍以達到相同的 XNLI 精度。12 層的 XLM-E 基礎模型在 64 個 NVIDIA A100 GPU 上僅用了 1.7 天就完成了訓練。

在 22 億參數的情況下,性能最佳的 T-ULRv5 XL 模型受益于 XLM-E 顯著提高的訓練效率,用不到兩周的時間在 256 個 NVIDIA A100 GPU 上完成了訓練。引入新的 TRTD 任務與 RTD 任務以及網絡架構的變化相結合,提升了模型的收斂速度和質量。

圖 4。

多語言訓練數據

T-ULRv5 性能的改進,一部分來自更好的訓練數據和更大的詞匯量。訓練一個支持 94 種語言、具有 22 億參數的模型,需要高數量、高質量的數據集。在多語言語料庫中,許多語料是來自網絡,從而使得語料庫在高資源語言和低資源語言之間存在很大的表示差異,特別是在數據量、清潔度和多樣性方面。研究人員在數據工程和清理步驟上投入了大量精力,以大規模生成高質量的數據集來支持 T-ULRv5 訓練。

擴大詞匯量

隨著數據集的更新,研究者還構建了一個包含 500000 個 token 的新詞匯表,比 T-ULRv2 大兩倍,這進一步提高了 T-ULRv5 模型在語言上的性能。關于詞匯擴展的工作,感興趣的讀者,可以參考論文《Allocating Large Vocabulary Capacity for Cross-lingual Language Model Pre-training》獲得更多細節。

微軟表示,研究人員正在探索多語言技術,通過解決諸如缺乏訓練數據、語言建模的高成本以及多語言系統的復雜性等障礙來幫助實現人工智能的簡單化。T-ULRv5 是一個重要里程碑,因為其跨語言可遷移性和 zero-shot 應用程序范式為開發跨語言系統提供了一個更高效和可擴展的框架。