手把手教你 JS 逆向搞定字體反爬并獲取某招聘網站信息

今日網站

小編已加密:aHR0cHM6Ly93d3cuc2hpeGlzZW5nLmNvbS8= 出于安全原因,我們把網址通過base64編碼了,大家可以通過base64解碼把網址獲取下來。

字體反爬

字體反爬:一種常見的反爬技術,是網頁與前端字體文件配合完成的反爬策略,最早使用字體反爬技術的有58同城、汽車之家等等,現在很多主流的網站或APP也使用字體反爬技術為自身的網站或APP增加一種反爬措施。

字體反爬原理:通過自定義的字體來替換頁面中某些數據,當我們不使用正確的解碼方式就無法獲取正確的數據內容。

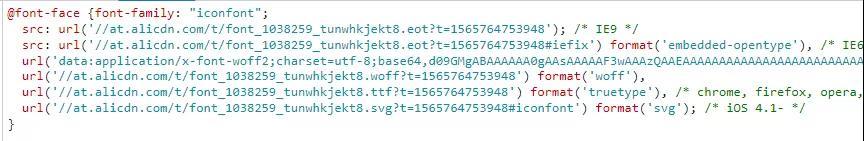

在HTML中通過@font-face來使用自定義字體,如下圖所示:

其語法格式為:

- @font-face{

- font-family:"名字";

- src:url('字體文件鏈接');

- url('字體文件鏈接')format('文件類型')

- }

字體文件一般是ttf類型、eot類型、woff類型,woff類型的文件運用比較廣泛,所以大家一般碰到的都是woff類型的文件。

以woff類型文件為例,其內容是怎樣的呢,又是以什么編碼方式使得數據與代碼一一對應的呢?

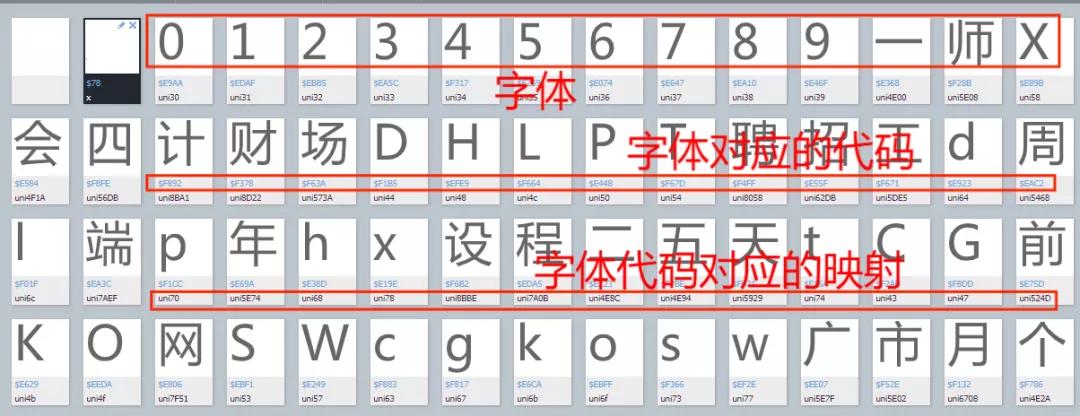

我們以某招聘網站的字體文件為例,進入百度字體編譯器并打開字體文件,如下圖所示:

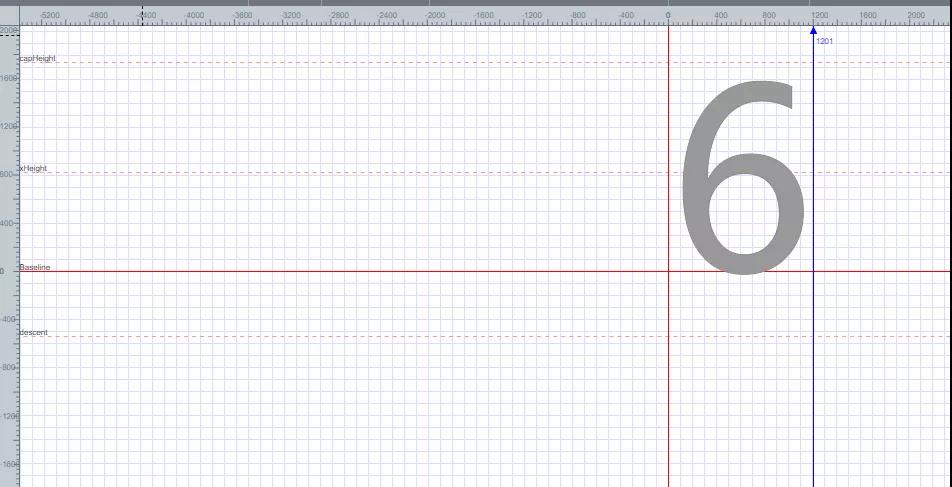

隨機打開一個字體,如下圖所示:

可以發現字體6放在一個平面坐標里面,根據平面坐標的每個點來得出字體6的編碼,這里就不解釋如何得出字體6的編碼了。

如何解決字體反爬呢?

首先映射關系可以看作為字典,大致有兩種常用的方法:

第一種:手動把一組編碼和字符的對應關系提取出來并用字典的形式展示,代碼如下所示:

- replace_dict={

- '0xf7ce':'1',

- '0xf324':'2',

- '0xf23e':'3',

- .......

- '0xfe43':'n',

- }

- for key in replace_dict:

- 數據=數據.replace(key,replace_dict[key])

數據=數據.replace(key,replace_dict[key])

首先定義字體與其對應的代碼一一對應的字典,再通過for循環把數據一一替換。

注意:這種方法主要適用于字體映射少的數據。

第二種:首先下載網站的字體文件,再把字體文件轉換為XML文件,找到里面的字體映射關系的代碼,通過decode函數解碼,然后將解碼的代碼組合成一個字典,再根據字典內容將數據一一替換,由于代碼比較長,這里就不寫示例代碼了,待會在實戰演練中會展示這種方法的代碼。

好了,字體反爬就簡單講到這里,接下來我們正式爬取某招聘網站。

實戰演練

自定義字體文件查找

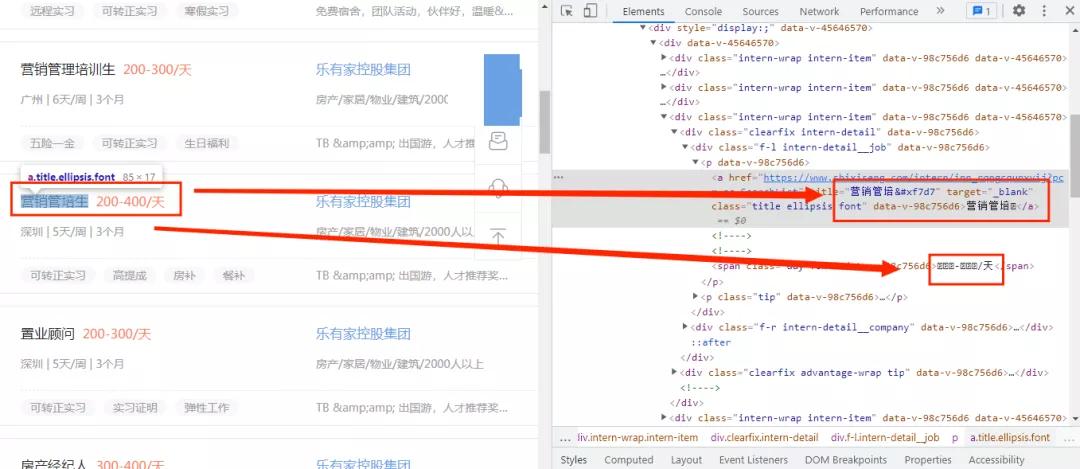

首先進入某招聘網并打開開發者模式,如下圖所示:

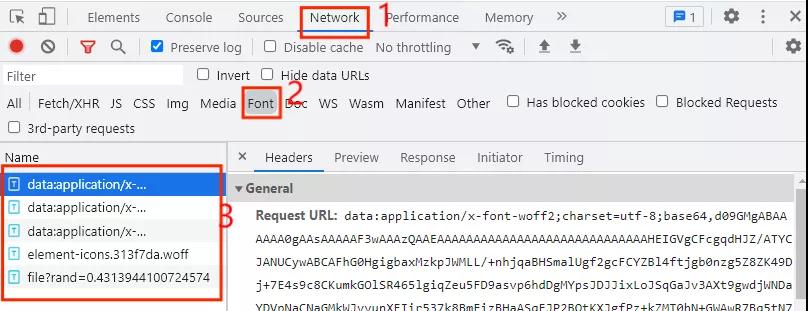

這里我們看到代碼中只有生字不能正常函數,而是用來代碼來替代,初步判定為使用了自定義的字體文件,這時就要找到字體文件了,那么字體文件在哪里找呢,首先打開開發者模式,并點擊Network選項,如下圖所示:

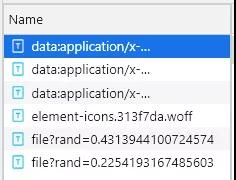

一般情況下,字體文件放在Font選卡中,我們發現這里一共有5個條目,那么哪個是自定義字體文件的條目呢,當我們每次點擊下一頁的時候,自定義字體文件就會執行一次,這時我們只需要點擊網頁中的下一頁即可,如下圖所示:

可以看到多了一個以file開頭的條目,這時可以初步判定該文件為自定義字體文件,現在我們把它下載下來,下載方式很簡單,只需要把file開頭的條目的URL復制并在網頁上打開即可,下載下來后在百度字體編譯器打開,如下圖所示:

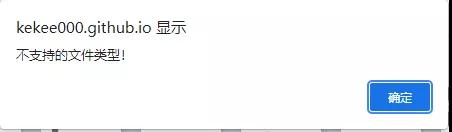

這時發現打開不了,是不是找錯了字體文件,網站提示說不支持這種文件類型,那么我們把下載的文件后綴改為.woff在打開試試,如下圖所示:

這時就成功打開了。

字體映射關系

找到自定義字體文件了,那么我們該怎么利用呢?這時我們先自定義方法get_fontfile()來處理自定義字體文件,然后在通過兩步來把字體文件中的映射關系通過字典的方式展示出來。

字體文件下載與轉換;

字體映射關系解碼。

字體文件下載與轉換

首先自定義字體文件更新頻率是很高的,這時我們可以實時獲取網頁的自定義字體文件來防止利用了之前的自定義字體文件從而導致獲取數據不準確。首先觀察自定義字體文件的url鏈接:

- https://www.xxxxxx.com/interns/iconfonts/file?rand=0.2254193167485603

- https://www.xxxxxx.com/interns/iconfonts/file?rand=0.4313944100724574

- https://www.xxxxxx.com/interns/iconfonts/file?rand=0.3615862774301839

可以發現自定義字體文件的URL只有rand這個參數發生變化,而且是隨機的十六位小于1的浮點數,那么我們只需要構造rand參數即可,主要代碼如下所示:

- def get_fontfile():

- rand=round(random.uniform(0,1),17)

- url=f'https://www.xxxxxx.com/interns/iconfonts/file?rand={rand}'

- response=requests.get(url,headers=headers).content

- with open('file.woff','wb')as f:

- f.write(response)

- font = TTFont('file.woff')

- font.saveXML('file.xml')

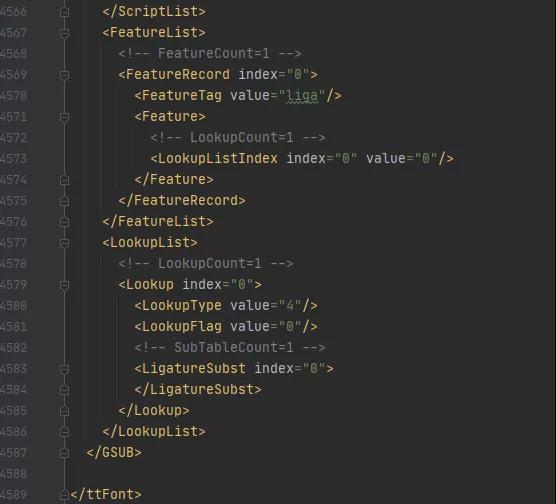

首先通過random.uniform()方法來控制隨機數的大小,再通過round()方法控制隨機數的位數,這樣就可以得到rand的值,再通過.content把URL響應內容轉換為二進制并寫入file.woff文件中,在通過TTFont()方法獲取文件內容,通過saveXML方法把內容保存為xml文件。xml文件內容如下圖所示:

字體解碼及展現

該字體.xml文件一共有4589行那么多,哪個部分才是字體映射關系的代碼部分呢?

首先我們看回在百度字體編碼器的內容,如下圖所示:

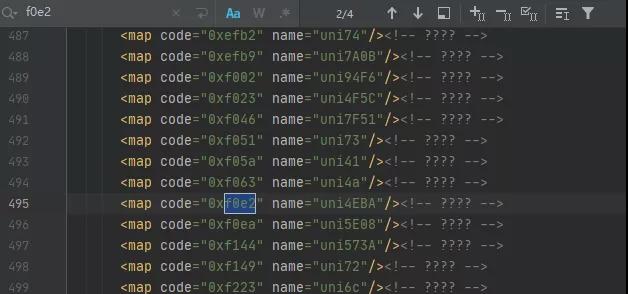

漢字人對應的代碼為f0e2,那么我們就在字體.xml文件中查詢人的代碼,如下圖所示:

可以發現一共有4個結果,但仔細觀察每個結果都相同,這時我們可以根據它們代碼規律來獲取映射關系,再通過解碼來獲取對應的數據值,最后以字典的形式展示,主要代碼如下所示:

- with open('file.xml') as f:

- xml = f.read()

- keys = re.findall('<map code="(0x.*?)" name="uni.*?"/>', xml)

- values = re.findall('<map code="0x.*?" name="uni(.*?)"/>', xml)

- for i in range(len(values)):

- if len(values[i]) < 4:

- values[i] = ('\\u00' + values[i]).encode('utf-8').decode('unicode_escape')

- else:

- values[i] = ('\\u' + values[i]).encode('utf-8').decode('unicode_escape')

- word_dict = dict(zip(keys, values))

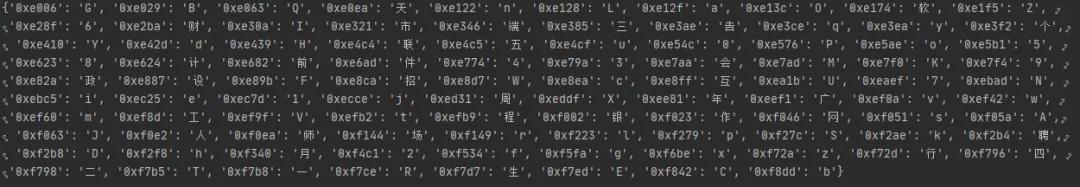

首先讀取file.xml文件內容,找出把代碼中的code、name的值并分別設置為keys鍵,values值,再通過for循環把values的值解碼為我們想要的數據,最后通過zip()方法合并為一個元組并通過dict()方法轉換為字典數據,運行結果如圖所示:

獲取招聘數據

在上一步中,我們成功把字體映射關系轉換為字典數據了,接下來開始發出網絡請求來獲取數據,主要代碼如下所示:

- def get_data(dict,url):

- response=requests.get(url,headers=headers).text.replace('&#','0')

- for key in dict:

- response=response.replace(key,dict[key])

- XPATH=parsel.Selector(response)

- datas=XPATH.xpath('//*[@id="__layout"]/div/div[2]/div[2]/div[1]/div[1]/div[1]/div')

- for i in datas:

- data={

- 'workname':i.xpath('./div[1]/div[1]/p[1]/a/text()').extract_first(),

- 'link':i.xpath('./div[1]/div[1]/p[1]/a/@href').extract_first(),

- 'salary':i.xpath('./div[1]/div[1]/p[1]/span/text()').extract_first(),

- 'place':i.xpath('./div[1]/div[1]/p[2]/span[1]/text()').extract_first(),

- 'work_time':i.xpath('./div[1]/div[1]/p[2]/span[3]/text()').extract_first()+i.xpath('./div[1]/div[1]/p[2]/span[5]/text()').extract_first(),

- 'company_name':i.xpath('./div[1]/div[2]/p[1]/a/text()').extract_first(),

- 'Field_scale':i.xpath('./div[1]/div[2]/p[2]/span[1]/text()').extract_first()+i.xpath('./div[1]/div[2]/p[2]/span[3]/text()').extract_first(),

- 'advantage': ','.join(i.xpath('./div[2]/div[1]/span/text()').extract()),

- 'welfare':','.join(i.xpath('./div[2]/div[2]/span/text()').extract())

- }

- saving_data(list(data.values()))

首先自定義方法get_data()并接收字體映射關系的字典數據,再通過for循環將字典內容與數據一一替換,最后通過xpath()來提取我們想要的數據,最后把數據傳入我們自定義方法saving_data()中。

保存數據

數據已經獲取下來了,接下來將保存數據,主要代碼如下所示:

- def saving_data(data):

- db = pymysql.connect(host=host, user=user, password=passwd, port=port, db='recruit')

- cursor = db.cursor()

- sql = 'insert into recruit_data(work_name, link, salary, place, work_time,company_name,Field_scale,advantage,welfare) values(%s,%s,%s,%s,%s,%s,%s,%s,%s)'

- try:

- cursor.execute(sql,data)

- db.commit()

- except:

- db.rollback()

- db.close()

啟動程序

好了,程序已經寫得差不多了,接下來將編寫代碼運行程序,主要代碼如下所示:

- if __name__ == '__main__':

- create_db()

- get_fontfile()

- for i in range(1,3):

- url=f'https://www.xxxxxx.com/interns?page={i}&type=intern&salary=-0&city=%E5%85%A8%E5%9B%BD'

- get_data(get_dict(),url)