ICLR 2022:AI如何識別“沒見過的東西”

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

這回域外物體檢測方向出了一個新模型VOS,合作團隊來自威斯康星大學麥迪遜分校,論文已收錄到ICLR 2022中。

這一模型在目標檢測和圖像分類上均達到目前最佳性能,FPR95指標比之前最好的效果還降低了7.87%之多。

要知道深度網絡對未知情況的處理一直是個難題。

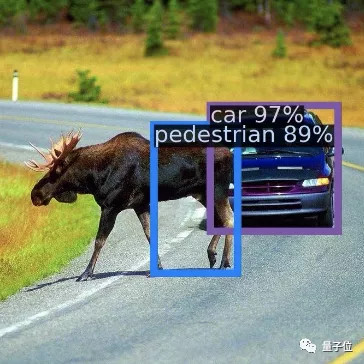

例如在自動駕駛中,識別已知物體(例如汽車、停車標志)的檢測模型經常“指鹿為馬”,對域外物體(OOD)會產生高置信度的預測。

就像下圖中的一頭駝鹿,在Faster-RCNN模型下被識別成了行人,還有89%的置信度。

因此域外物體的檢測無疑成為了AI安全方面一個很重要的話題。

我們來看看這個模型是怎么對域外物體做出判斷的。

VOS如何檢測域外物體

在理解VOS之前,不得不提一下域外物體檢測困難的原因。

其實也很好理解,畢竟神經網絡只是學習訓練和測試時的數據,遇到沒見過的東西時自然不認識。

為了解決這個問題,得想辦法讓網絡認識“未知”的事物。這怎么辦?

VOS想到的辦法是,給模型模擬一個域外物體用來學習。

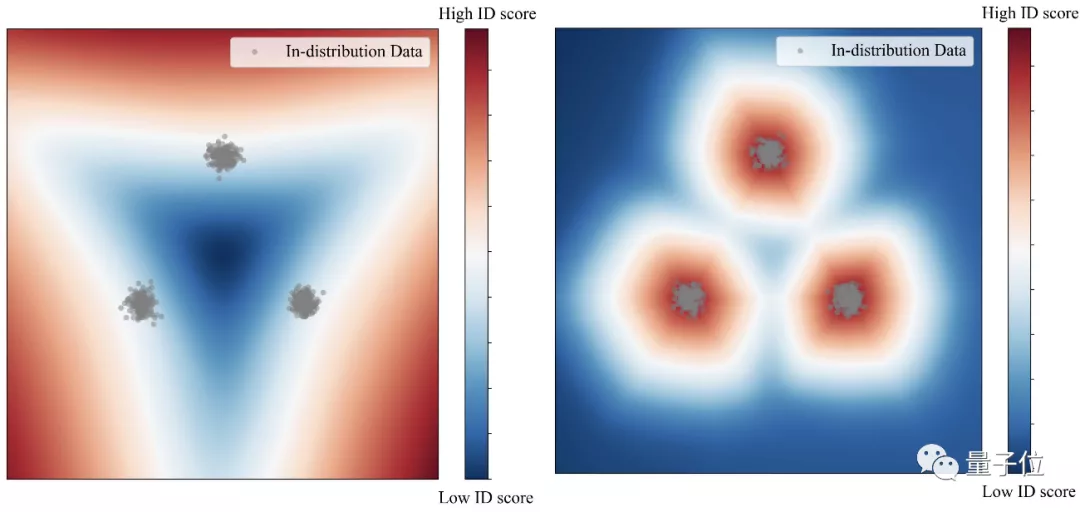

例如下圖中的檢測情況,其中三團灰點是我們的目標。在沒有模擬域外物體時(左),模型只能在大范圍內圈住目標。

而在用模擬域外物體訓練后(右),模型可以緊湊準確的鎖定目標,形成更合理的決策邊界。

而一旦目標鎖定更精確,只要在這個范圍之外,其他物體就可以都判為域外物體。

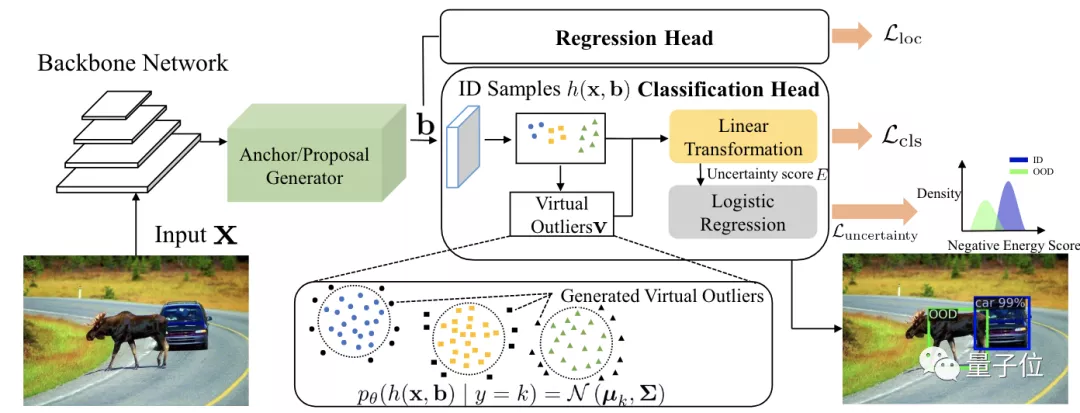

基于這個想法,VOS的團隊構建了這樣的框架:

以一個Faster-RCNN網絡為基礎,在分類頭中加入一部分模擬域外物體的數據,和訓練集中的數據放在一起,共同構建標準化的不確定性損失函數。

而這些模擬域外物體的數據從哪里來呢?在結構圖中可以看出,這些點都來自目標區域(藍色圓點、黃色方點和綠色三角點)周圍,也就是低似然區域。

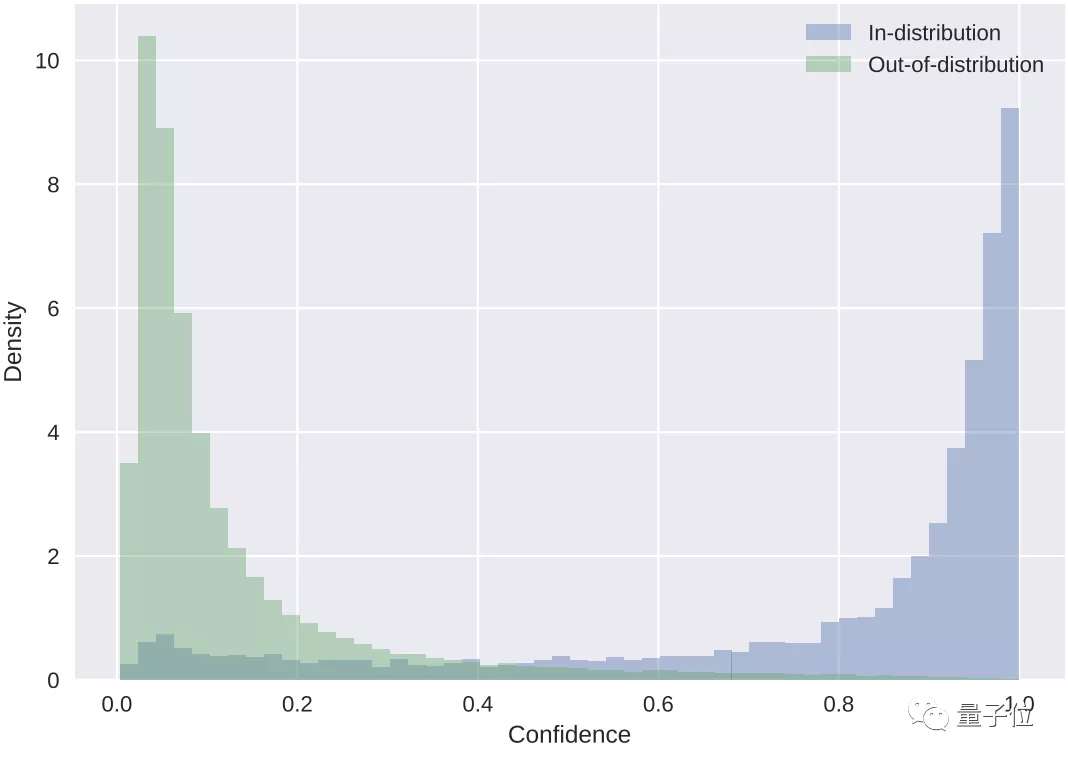

最后根據置信度的計算,藍色代表目標檢測數據,綠色代表域外物體。

以此判斷出圖像中的車和駝鹿。

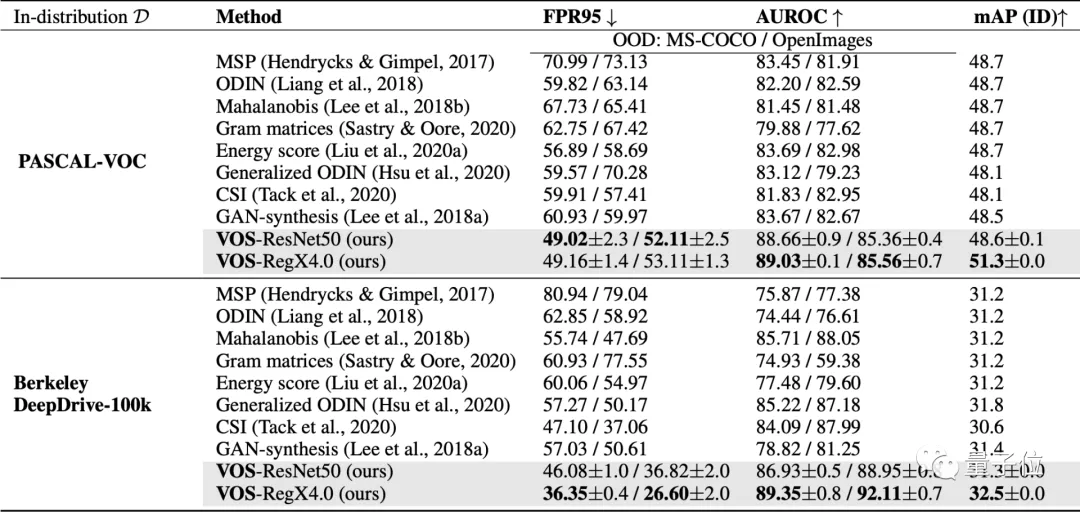

再和許多其他域外物體檢測方法做一下比較,就可以看出VOS的優勢。

各項指標中箭頭向下代表該項數據越小越好,反之代表該項越大越好。

其中FPR95這項最為突出,描述的是OOD樣本分類正確率在95%時,OOD樣本被錯分到ID樣本中的概率。

這項成績相較于之前最好的成績降了7.87%。

與現有的其他方法相比,也展現出了VOS的優勢。

它作為一個通用學習框架,可以適用于目標檢測和圖像分類兩種任務。而之前的方法主要靠圖像分類來驅動。

目前該模型已經在GitHub上開源。

作者簡介

該模型主要由杜學峰、蔡沐等人提出。

杜學峰本科畢業于西安交通大學,目前在威斯康星大學麥迪遜分校攻讀CS博士。

主要研究方向是可信機器學習,包括域外物體檢測、對抗魯棒性、噪聲標簽學習等。

蔡沐,本科也畢業于西安交通大學,目前為威斯康星大學麥迪遜分校CS博二學生。

研究興趣集中在深度學習、計算機視覺,尤其是三維場景理解(點云檢測)和自監督學習。

該篇論文的通訊作者是Sharon Yixuan Li,目前在威斯康星大學麥迪遜分校任計算機科學助理教授,之前還曾在Facebook AI任研究員。