干掉ISP,特斯拉“純視覺路線”的關鍵一躍

對特斯拉死磕的“純視覺路線”,筆者一直是持質疑態度的。質疑的點在于:算法的進步,能彌補攝像頭物理性能的局限性嗎?比如,視覺算法足夠牛逼時,攝像頭就有測距能力了?晚上就能看見了?

前一個疑問,在2021年7月份被打消——當時,特斯拉被曝已開發出“純視覺測距”技術。而后一個疑問,則持續存在。

筆者甚至一度認為,如果把攝像頭類比為人眼、把視覺算法類比為人的大腦中“跟眼睛配合的那一部分功能”,那么,“視覺算法足夠牛逼時,就可以不需要激光雷達”這種觀點就相當于說“只要我的腦子足夠聰明,眼睛高度近視也沒關系”。

但前段時間,馬斯克提到的HW 4.0將“干掉ISP”的計劃,卻顛覆了筆者的認知。在接受Lex采訪時,馬斯克說,接下來特斯拉全車攝像頭的原始數據不會再經過 ISP 的處理,而直接輸入 FSD Beta 的 NN 推理,這將讓攝像頭變得超緊急強大。

帶著這一話題,筆者跟地平線BPU算法負責人羅恒、于萬智駕CTO劉煜、均聯智行首席架構師汪浩偉、摯途科技首席科學家黃浴、車右智能聯合創始人等諸多業內專家都做了一系列交流,然后明白,自己先前的那些質疑,純屬“自作聰明”。

視覺算法的進步,確實在一步步拓展著攝像頭物理物理性能的邊界。

一.何為ISP?

ISP 的全稱 Image Signal Processor,即圖像信號處理器,是車載攝像頭的重要構成組件,主要作用是對前端圖像傳感器CMOS輸出的信號進行運算處理,把原始數據“翻譯”成人眼可以看懂的圖像。

通俗地說,只有依賴于ISP,駕駛員才能借助攝像頭“看”到現場細節。

基于第一性原理,自動駕駛公司也用ISP,主要是根據周圍環境的實際情況對攝像頭數據進行白平衡、動態范圍調整、濾波等操作,以獲得最佳質量的圖像。例如,調節曝光以適應明暗變化,調節焦距以專注在不同距離的物體等等,盡量地讓相機性能接近人眼。

(圖為特斯拉的FSD芯片)

不過,讓相機“盡量接近人眼”顯然還無法滿足自動駕駛的需求——算法需要攝像頭在強光及弱光等人眼也“失靈”的場合下也能正常工作。為了實現這一目標,有的自動駕駛公司不得不專門定制能增強攝像頭在強光、弱光及干擾情況下性能的ISP。

2020年4月8日,阿里達摩院宣布依托其獨有的3D降噪和圖像增強算法自主研發出用于車載攝像頭的ISP,保障自動駕駛車輛在夜間擁有更好的“視力”,“看”得更清晰。

據達摩院自動駕駛實驗室的路測結果顯示,使用該ISP,車載攝像頭在夜間這個最富有挑戰的場景下,圖像物體檢測識別能力相比業內主流處理器有10%以上的提升,原本模糊不清的標注物也得以清晰識別。

二.干掉ISP的動機及“可行性”

然而,ISP的設計初衷是為了在多變的外部環境下獲得一張“好看”的圖片,但這究竟是不是自動駕駛最需要的圖片形式,業界尚無定論。按馬斯克Elon 的說法,神經網絡不需要漂亮的圖片,它需要的是傳感器直接獲取的原始數據、是原始光子計數(Raw photon counts)。

在馬斯克看來,無論ISP采用何種處理方法,總有一部分原始光子在通過鏡頭到達CMOS、轉換成可見光子的過程中會被丟失。

關于原始光子丟失與未丟失的差別,摯途首席科學家黃浴說:“光子轉化成電子信號時候,確實有噪聲被抑制了,更不用說ISP對原來的電信號做了很多處理。”

車右智能聯合創始人在《From photon to control——從光子到控制,Tesla的技術口味越來越重》一文中拿人眼對感知信息的處理做類比,做了比較詳盡的解釋,在此摘要如下:

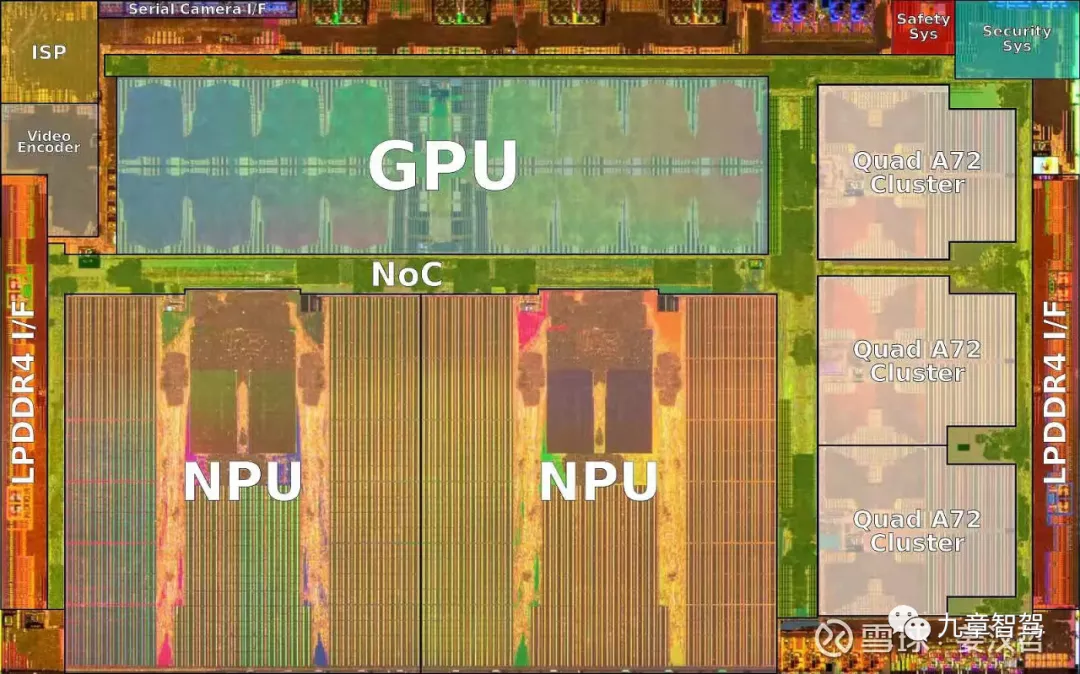

(圖片摘自公眾號“車右智能”)如上圖所示,人類的視覺系統和電子成像系統在邏輯上是完全一致的。視網膜顏色和像素矩陣其實是更可以代表外部客觀世界的信息,而真正的人類感知顏色,是需要大腦(等同于ISP和更高層的后端處理)的參與的。

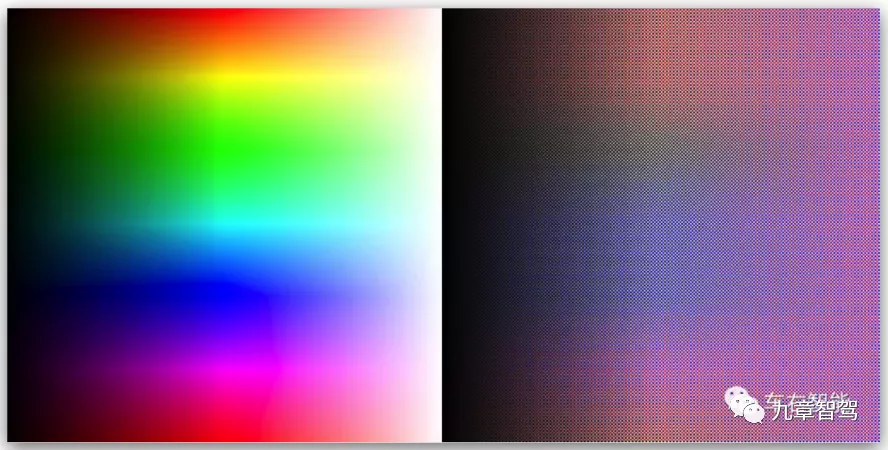

(圖片摘自公眾號“車右智能”)

上圖左側是一幅標準的帶有飽和度漸變和強度漸變的顏色圖,右側是其對應的帶元顏色的原始圖幅。對比可見,以人類視覺感官為核心而設計的成像系統會給我們提供愉悅和符合人類主觀的圖像信息,卻未必全真反映客觀的真實世界。

馬斯克認為,為了做得“更好看”、更適合“給人看”,很多原本很有用的數據卻在ISP負責的“后期處理”環節被處理掉了。但如果只是為了給機器看,這些被處理掉了的數據其實也是有用的,因此,如果“后期處理”這一步可以被省略,則有效信息量便會增加。

按于萬CTO劉煜的解釋,馬斯克的邏輯是:

1.由于有了更豐富的原始數據,未來,相機的探測范圍可能比人眼大,即光照強度很低或者很高的時候,我們人眼可能就看不見了(因為太黑或者太亮),但機器仍然可以測光子數量,因而仍然能有圖像輸出;

2.相機對光照強度的分辨率可能更高,即看上去很類似的兩個光點,人眼可能分辨不出那么細小的亮度或者顏色差別,但是機器或許可以。

某AI四小龍工程師的解釋是:好的攝像頭的動態范圍比人眼大很多(在相對靜止狀態下),即攝像頭能觀測到的“從最亮到最暗”的范圍,比人眼所能觀測的更寬。在極暗的條件下,人眼看不到什么東西(幾乎沒有光子),但是攝像頭的CMOS可以接收到很多光子,因而能看到黑暗狀態下的事物。

多位專家在接受《九章智駕》采訪時均表述認可馬斯克的邏輯。

地平線BPU算法負責人羅恒解釋道:“特斯拉現在的數據標注有人工標注和機器自動標注兩種,其中,人工標注其實并不全是基于當前的圖像信息,也包含了人類對世界的知識,這種情況下,機器同樣有概率利用信息更豐富的原始數據;而機器自動標注是結合事后觀測、結合大量幾何分析一致性得出的,如果使用原始數據,機器有很大概率找到更多的相關性,做出更準確的預測。”

除此之外,均聯智行首席架構師汪浩偉解釋道:“特斯拉在原始圖像數據進入DNN網絡前就對其做了拼合,因此,就不需要對每個攝像頭的感知結果做后處理。”

通過干掉ISP來提升攝像頭在夜間的識別能力,這看起來跟阿里達摩院自研ISP的思路是相反的啊。那么,這兩者矛盾嗎?

據曾某自動駕駛公司視覺算法專家解釋:兩家的訴求其實是相同的。在本質上,無論阿里達摩院還是特斯拉,都是希望通過芯片和算法的配合來提升攝像頭的能力。

但兩者的區別在于,阿里達摩院的思路是,為了人眼能看到,對原始數據進行了各類算法處理和增強;而特斯拉則是去除了算法中為了“照顧”人眼所做的那部分數據處理,轉而開發了用于增加攝像頭在弱光下及強光等環境下的算法所需的數據及相應能力。

除此之外,馬斯克還說,不經 ISP 處理可以實現 13 毫秒的延遲下降,因為有 8 個攝像頭,每個攝像頭 ISP 處理會產生 1.5 - 1.6 毫秒的延遲。

一旦馬斯克這一設想經過實踐驗證是可行的,其他芯片廠商應該也會“跟進”。甚至,有的芯片廠商已經在這么做了。

如安霸中國區總經理馮羽濤1月份在接受焉知采訪時就提到:“如果客戶想把原始數據直接喂進神經網絡進行處理,CV3 完全可以支持這種方法”。

三.攝像頭的“物理性能”也需要提升

并非所有人都完全相信馬斯克這一計劃。

某頭部Robotaxi公司技術VP說:“特斯拉說的也沒錯,但我覺得算法的開發難度會非常大、周期會很長,然后開發的時間可能會非常久。如果加個激光雷達,首先可以直接把三維的問題解決了,拿純視覺去構建三維當然也可以,但要消耗很多算力。”

車右智能聯合創始人認為,馬斯克是個“煽動大師”,“他的宣傳方式是把你搞暈,讓你不由自主地產生技術崇拜”。

他說:“有的圖像學專家認為放棄所有ISP級別的后處理是不現實的,比如獲取強度和顏色的debayer圖像,會給后續的NN識別head造成很多困難。”

在《車右智能》最近的一篇文章中提到,原始數據染過ISP直接進入神經網絡的方案在哪種場景下可行?是可以兼容特斯拉現有的攝像頭還是需要更好的視覺傳感器?是否存在于FSD beta全部的NN head任務還是局部NN head任務?這都是不確定的答案。

我們再回頭筆者開頭提出的那個問題:視覺算法的提升,能突破攝像頭的物理性能本身的瓶頸嗎?

某視覺算法背景的Robotaxi公司CEO說:“逆光或者是車輛從隧道里出來突然面對強光時的感知,人眼很難解決,攝像頭也不行,這個時候,就必須要有激光雷達了。”

劉煜認為,理論上,如果你不計成本,可以造一個攝像頭,性能是可以超過人眼的,“但我們現在這些車上用的這種低成本的攝像頭,似乎還遠沒有達到這個性能級別。”

言外之意,解決攝像頭在弱光或強光下的感知,并不能僅靠視覺算法的提升,還得圍繞著攝像頭的物理性能“做文章”。

如攝像頭若要在夜間探測目標,就無法通過可見光成像,而是得基于紅外熱成像原理來做(夜視攝像頭)。

某“AI四小龍”工程師認為,photon to control非常有可能意味著特斯拉跟HW 4.0芯片搭配的攝像頭會升級成多光譜。

這位工程師說:當前,行車攝像頭都將非可見光部分濾去,但現實中,物體發出的光線光譜非常廣泛,可以用來進一步區分物體特征。比如白色的貨車和白云,在紅外波段可以被輕易區分;有行人或者大型動物防撞,用紅外攝像頭會比較容易,因為恒溫動物身體發出的紅外線是很容易區分的。

《車右智能》在文章中也提到了這樣一個問題:Tesla是否會針對photon to control的概念而更新相機硬件,推出真正的光量子相機,或者還是基于現有的camera進行ISP旁路? 與此同時,作者也指出,如果攝像頭硬件也要升級,“那特斯拉將不得不從頭開始完全重新訓練其神經網絡算法,因為輸入是如此的不同”。

此外,無論攝像頭技術如何進步,可能都無法擺脫鳥屎、泥水等臟污的影響。

激光雷達采用的是主動光源,先發光、再接收光,像素點很大,一般的臟污很難將其完全遮擋掉。據某激光雷達廠商提供的數據,在表面有臟污的情況下,其激光雷達的探測距離只衰減15%以內;而且,有臟污的時候,系統會自動發出警報。但攝像頭是被動傳感器,每個像素點很小,很小的灰塵技能擋住幾十個像素,因此,在表面有臟污的時候就直接“瞎了”。

如果不能解決這個問題,那試圖通過視覺算法的進步來省掉激光雷達的成本,豈不是個妄想?

幾點補充:

1.芯片廠商怎么設計只是問題的一個方面,但客戶如果沒能力充分利用好原始數據,他們也無法繞過ISP。

2.哪怕芯片廠商和客戶都有能力繞過ISP,在今后相當長一段時間里,多數廠商仍然會保留ISP,一個關鍵原因在于,在L2階段,駕駛責任主體依然是人,而ISP處理后的信息顯示到屏幕上,方便交互,也可以給駕駛員“安全感”。

3.要不要繞過ISP,仍然是“純視覺派”與“激光雷達派”兩種技術路線之爭的延續,對此,上文提到的Robotaxi公司技術VP的觀點很有啟發性:

其實純視覺方案跟激光雷達方案并不是拼“誰行誰不行”,真正拼的就是純視覺方案算法開發能開發到激光雷達方案這種水平要多長時間,以及激光雷達的成本降到跟純視覺方案成本差不多的時候需要多長時間。簡言之,是前者的技術進步快,還是后者的成本降得更快。

當然,若日后純視覺派需要增加傳感器,而激光雷達派需要減少傳傳感器,算法受到的影響有多大、修改算法需要多長時間、成本如何,這些都是有待進一步觀察的問題。