Meta研究人員做出AI新嘗試:教機器人無需地圖或訓練實現物理導航

Meta Platforms公司人工智能部門日前表示,他們正在教AI模型如何在少量訓練數據支持下學會在物理世界中行走,目前已經取得了快速進展。

這項研究能夠顯著縮短AI模型獲得視覺導航能力的時間。以前,實現這類目標要需要利用大量數據集配合重復“強化學習”才能實現。

Meta AI研究人員表示,這項關于AI視覺導航的探索將給虛擬世界帶來重大影響。而項目的基本思路并不復雜:幫助AI像人類那樣,單純通過觀察和探索實現在物理空間導航。

Meta AI部門解釋道,“比如,如果要讓AR眼鏡指引我們找到鑰匙,就必須想辦法幫助AI理解陌生的、不斷變化的環境布局。畢竟這是非常細化的小需求,不可能永遠依賴于極占算力資源的高精度預置地圖。人類不需要了解咖啡桌的確切位置或長度就能不產生任何碰撞、輕松繞著桌角走動。”

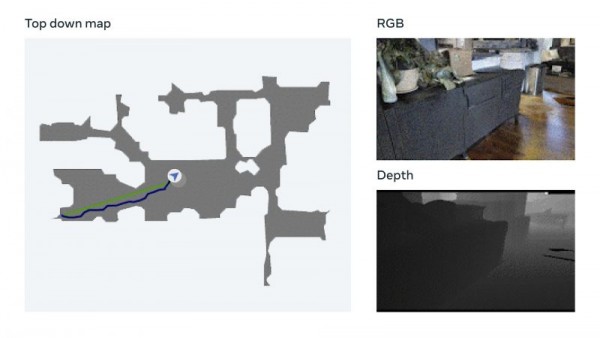

為此,Meta決定將精力集中在“具身AI”身上,即通過3D模擬中的交互機制訓練AI系統。在這一領域,Meta表示已經建立起一套值得期待的“點目標導航模型”,無需任何地圖或GPS傳感器即可在新環境中導航。

該模型使用一種名為視覺測量的技術,允許AI根據視覺輸入跟蹤自身當前位置。Meta表示,這項數據增強技術能夠快速訓練出有效的神經模型,且無需人工數據注釋。Meta還提到,他們已經在自家Habitat 2.0具身AI訓練平臺(利用Realistic PointNav基準任務運行虛擬空間模擬)上完成了測試,成功率達到94%。

Meta方面解釋道,“雖然我們的方法還沒有完全解決數據集中的所有場景,但這項研究已經初步證明,現實環境的導航能力不一定需要顯式映射來實現。”

為了在不依賴地圖的情況下進一步完善AI導航訓練,Meta建立了一套名為Habitat-Web的訓練數據集,其中包含10萬多種由人類演示的不同對象-目標導航方法。通過運行在網絡瀏覽器上的Habitat模擬器就能順利接入Amazon.com的Mechanical Turk服務,用戶能夠以遠程方式安全操作虛擬機器人。Meta表示,由此產生的數據將作為訓練素材,幫助AI代理獲得“最先進的結果”。掃視房間了解整體空間特點、檢查角落是否有障礙物等,都是值得AI向人類學習的高效對象搜索行為。

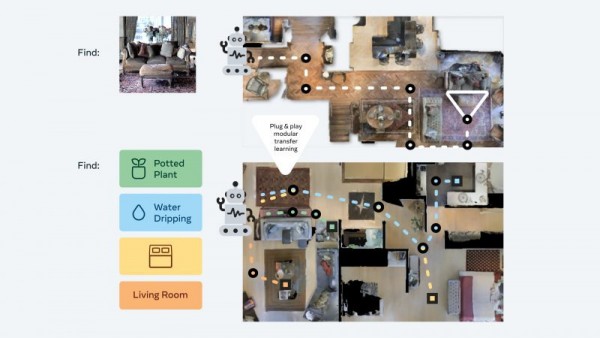

此外,Meta AI團隊還開發出所謂“即插即用”模塊化方法,可以通過一套獨特的“零樣本體驗學習框架”幫助機器人在多種語義導航任務和目標模式中實現泛化。通過這種方式,AI代理在缺少資源密集型地圖和訓練的前提下仍可獲得基本導航技能,無需額外調整即可在3D環境中執行不同任務。

Meta公司解釋道,這些代理在訓練中會不斷搜索圖像目標。它們會收到一張在環境中隨機位置拍攝的照片,然后通過自主導航嘗試找到拍攝點位。Meta研究人員們表示,“我們的方法將訓練數據削減至1/12.5,成功率則比最新的遷移學習技術還高出14%。”

Constellation Research公司分析師Holger Mueller在采訪中表示,Meta的這項最新進展有望在其元宇宙發展計劃中發揮關鍵作用。他認為,如果未來虛擬世界能夠成為常態,那AI必須有能力理解這個新空間,而且理解的成本還不能太高。

Mueller補充道,“AI理解物理世界的能力需要由基于軟件的方法獲得擴展。Meta目前走的就是這條路,而且在具身AI方面取得了進步,開發出無需訓練即可自主理解周邊環境的軟件。我很期待看到這方面成果在實踐層面的早期應用。”

這些現實用例可能已經離我們不遠了。Meta公司表示,下一步計劃就是把這些成果從導航推進到移動操作,開發出能夠執行特定任務的AI代理(比如識別出錢包并將其交還給主人)。