一文讀懂“語言模型”

自然語言處理(NLP)近年來發生了革命性的變化,特別預訓練語言模型的開發和使用,在許多應用方面都取得了顯著的成績。預訓練語言模型有兩個主要優點:一個是可以顯著提高許多 NLP 任務的準確性。例如,可以利用 BERT 模型來獲得比人類更高的語言理解能力,可以利用 GPT-3模型來生成類似于人類文字的生成文本。第二個優點是通用的語言處理工具。如果在傳統的自然語言處理中進行基于機器學習的任務,需要標記大量的數據來訓練模型。相比之下,目前只需要標記少量數據就可以對預先訓練好的語言模型進行微調即可。

自然語言處理是計算機科學、人工智能和語言學的一個分支領域,其應用包括機器翻譯、閱讀理解、對話系統、文檔摘要、文本生成等。

人們利用數學手段建立語言模型主要有兩種方法: 一種是基于概率論,另一種是基于形式語言理論,這兩種方法也可以結合使用。從基本框架的觀點來看,語言模型屬于第一類。在形式上,語言模型是一個定義在單詞序列(一個句子或一個段落)上的概率分布,是基于概率論、統計學、信息論和機器學習的自然語言文本建模工具。近年來,通過深度學習得到的神經語言模型,特別是最近開發的預訓練語言模型,已經成為自然語言處理的基礎技術。

本文從計算機科學的歷史發展和未來趨勢出發,對語言建模,特別是預訓語言建模進行了簡要介紹,突出了基本概念,直觀地解釋了技術成就和基本挑戰。首先,介紹了馬爾科夫和香農研究的語言建模基本概念(基于概率論)。接下來,討論了喬姆斯基提出的語言模型(基于形式語言理論) ,描述了作為傳統語言模型擴展的神經語言模型的定義。然后,解釋了預訓練語言模型的基本思想,討論了神經語言建模方法的優點和局限性,最后對語言模型的未來發展趨勢進行了預測。

馬爾可夫與語言模型

安德烈 · 馬爾科夫可能是第一個研究語言模型的科學家,盡管當時還沒有“語言模型”這個術語。

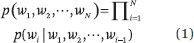

假設 w1,w2,... ,wN 是一個單詞序列,然后,單詞序列的概率可以計算如下:

設 p (w1 | w0) = p (w1),不同類型的語言模型使用不同的方法計算條件概率 p (wi | w1,w2,... ,wi-1),學習和使用語言模型的過程稱為語言建模。N-gram 模型是一個基本模型,它假設每個位置上的單詞只取決于前面 n-1位置上的單詞。也就是說,該模型是一個 n-1階的馬爾可夫鏈。

馬爾可夫在1906年研究了馬爾可夫鏈。首先考慮的模型非常簡單,只有兩個狀態和這兩個狀態之間的轉換概率。如果根據轉移概率在兩個狀態之間跳躍,那么訪問兩個狀態的頻率將收斂到期望值,這是馬爾可夫鏈的遍歷定理。在接下來的幾年里,他擴展了該模型,并證明了上述結論仍然適用于更一般的情況。

為了提供一個具體的例子,馬爾科夫在1913年將他提出的模型應用到普希金的詩歌小說《尤金 · 奧涅金》中。他移除了空格和標點符號,并將小說的前兩萬個俄語字母分為元音和輔音,從而得到了小說中的一系列元音和輔音。然后,馬爾科夫用紙和筆計算元音和輔音之間的轉換概率。然后,利用這些數據驗證了最簡單的馬爾可夫鏈特征。

馬爾可夫鏈最初應用在語言領域,這是非常有趣的,研究的例子就是最簡單的語言模型。

香農與語言模型

1948年,克勞德 · 香農發表了開創性論文《The Mathematical Theory of Communication》 ,這是信息論領域的奠基之作。在論文中,基于約翰·馮·諾伊曼的建議,香農從統計力學那里借用了“熵”這個術語,引入了熵和交叉熵的概念,并研究了 n-gram 模型的性質。

熵表示一個概率分布的不確定性,而交叉熵表示一個概率分布相對于另一個概率分布的不確定性。熵是交叉熵的一個下界。

假設語言(單詞序列)是由隨機過程生成的數據,那么,N-gram 的概率分布熵定義如下:

其中 p (w1,w2,... ,wn)表示 n-gram中 w1,w2,... ,wn 的概率。N-gram 概率分布與數據“真實”概率分布的交叉熵定義如下:

其中 q (w1,w2,... ,wn)表示 n-gram的 w1,w2,... ,wn 和 p (w1,w2,... ,wn)表示 n-gram的 w1,w2,... ,wn 的真實概率。

以下關系包括:

香農-麥克米倫-布萊曼定理指出,當語言的隨機過程滿足平穩性和遍歷性條件時,下列關系成立:

換句話說,當單詞序列長度達到無窮大時,語言的熵就可以定義了。熵是一個常數,可以根據語言的數據進行估計。

如果一種語言模型能夠比另一種語言模型更準確地預測一個詞序列,那么它應該具有較低的交叉熵。因此,香農的工作為語言建模提供了一個評價工具。語言模型不僅可以模擬自然語言,還可以模擬正式語言和半正式語言。

喬姆斯基與語言模型

幾乎在同一時代,喬姆斯基在1956年提出了語法的喬姆斯基譜系,用來表示語言的句法。他指出,有限狀態語法(也稱為了 n-gram 模型)在描述自然語言方面存在局限性。

喬姆斯基的理論斷言,一種語言由一組有限或無限的句子組成,每個句子是一組有限長度的單詞,單詞來自一個有限的詞匯,語法是一組生成規則,可以生成語言中的所有句子。不同的語法可以產生不同復雜度的語言,并形成層次結構。

能夠生成有限狀態機可以接受的句子的語法是有限狀態文法或正則文法,而能夠生成非確定性下推自動機可以接受的句子的語法是上下文無關文法。有限狀態文法被恰當地包含在無上下文文法中。

有限馬爾可夫鏈(或 n-gram 模型)的“文法”是有限狀態文法。有限狀態文法在生成英語句子方面確實有局限性。例如,英語表達式之間存在著語法關系,例如(i)和(ii)中的下列關系。

- (i) If S1, then S2.

- (ii) Either S3, or S4.

- (iii) Either if S5, then S6, or if S7, then S8

原則上,這些關系可以無限期地組合在一起,以產生正確的英語表達方式(例如,示例 iii )。然而,有限狀態文法不能描述所有的組合,并且,在理論上,有些英語句子不能被覆蓋。因此,喬姆斯基認為用有限狀態文法(包括 n-gram 模型)描述語言有很大的局限性。相反,他指出,上下文無關文法可以更有效地為語言建模。在他的影響下,在接下來的幾十年里,無上下文的文法在自然語言處理中得到了廣泛的應用。盡管喬姆斯基的理論現在對自然語言處理沒有太大的影響,但是它仍然具有重要的科學價值。

神經語言模型

2001年,Yoshua Bengio 和他的合著者提出了最早的神經語言模型之一,從而開啟了語言建模的新紀元。眾所周知,本吉奧、杰弗里 · 辛頓和揚 · 勒庫恩憑借他們在概念和工程方面的突破,使深度神經網絡成為計算的關鍵部分,獲得了2018年的圖靈獎。

N-gram 模型的學習能力有限。傳統方法是從語料庫中用平滑法估計模型中的條件概率 p (wi | wi-n + 1,wi-n + 2,... ,wi-1)。然而,模型中的參數數目是指數級 O (V^n) ,其中 V 表示詞匯量。當 n 增加時,由于訓練數據的稀疏性,模型的參數不能準確地學習。

Bengio 等人提出的神經語言模型從兩個方面對 n-gram 模型進行了改進。首先,一個實值向量,稱為詞嵌入,用來表示一個詞或詞的組合。一個詞嵌入的維數要比“one-hot 向量”的維數低得多,在one-hot 向量中,與該詞對應的元素是一個,而其他元素是零。

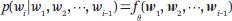

詞嵌入作為一種“分布式表示”,可以比one-hot向量表示一個詞語具有更高的效率, 并擁有泛化能力、魯棒性和可擴展性。其次,用神經網絡表示語言模型,大大減少了模型中的參數數量。條件概率由神經網絡決定:

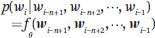

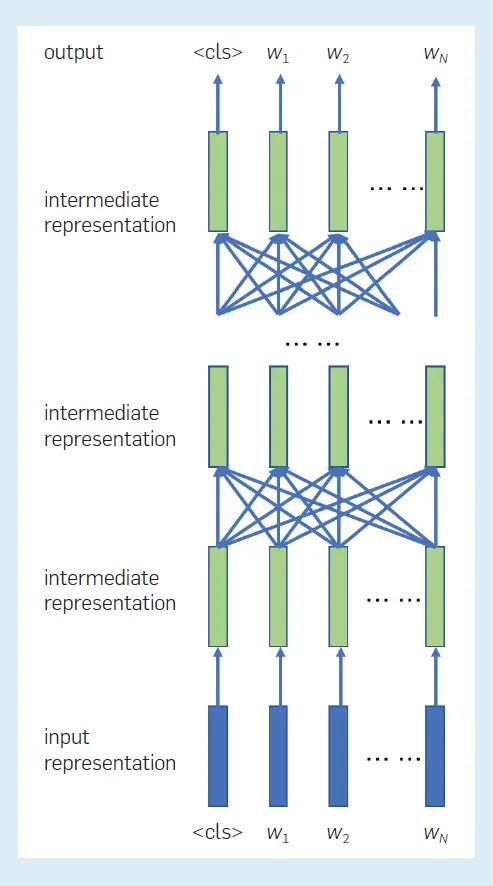

其中(wi-n + 1,wi-n + 2,... ,wi-1)表示單詞 wi-n + 1,wi-n + 2,... ,wi-1的嵌入; f (·)表示神經網絡; θ 表示網絡參數。模型中的參數個數僅為 O (V)。圖1顯示了模型中表征之間的關系。每個位置都有一個中間表示,該表示依賴于前面 n-1位置上的單詞嵌入 ,這適用于所有位置。然后,使用位于當前位置的中間表示為該位置生成一個單詞。

圖1,初始神經語言模型中表征之間的關系

在 Bengio 等人的工作之后,大量的詞嵌入方法和神經語言建模方法被開發了出來,并從不同的角度帶來了改進。

詞嵌入的代表性方法包括 Word2Vec。代表性的神經語言模型是遞歸神經網絡(RNN)的語言模型,包括長短期記憶(LSTM)語言模型。在一個 RNN 語言模型中,每個位置的條件概率由一個 RNN 決定:

其中 w1,w2,... ,wi-1表示單詞 w1,w2,... ,wi-1的嵌入; f (·)表示 RNN; θ 表示網絡參數。RNN 語言模型不再具有馬爾可夫假設,每個位置上的單詞都依賴于前面所有位置上的單詞。神經網絡中的一個重要概念是其中間表征或狀態。詞與詞之間的依賴擁有屬性是 RNN 模型中狀態與狀態之間的依賴關系。模型的參數在不同的位置共享,但在不同的位置所得到的表征不同。

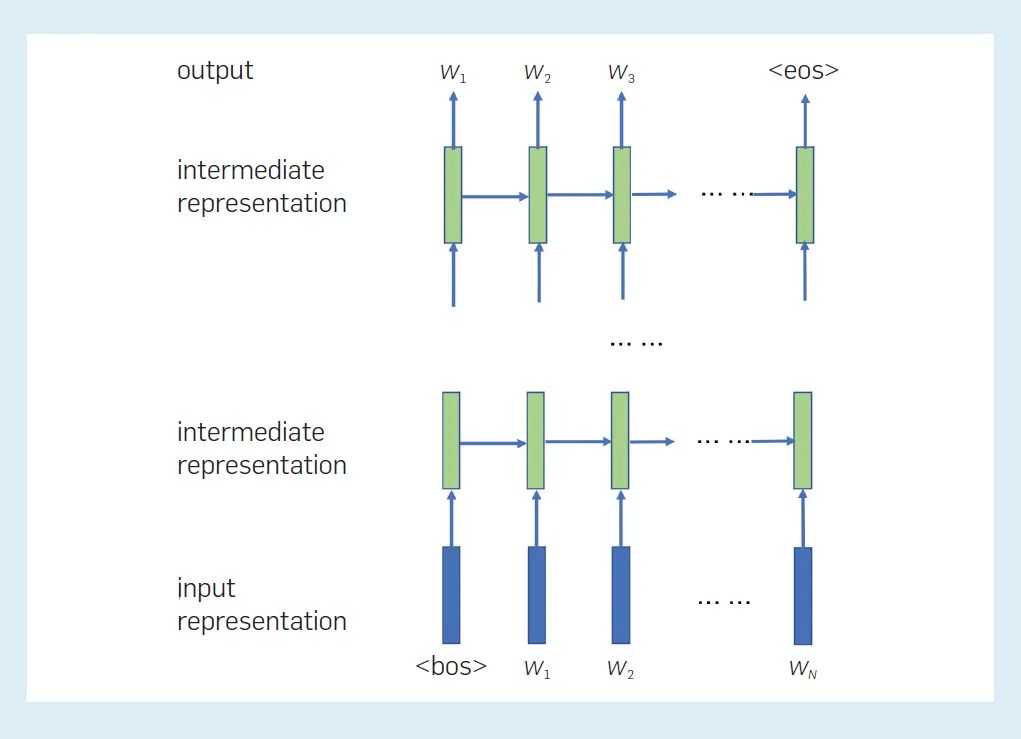

圖2顯示了 RNN 語言模型中表征之間的關系。每個層在每個位置都有一個中間表征,它表示到目前為止單詞序列的“狀態”。在當前位置的當前層的中間表征形式由在前一位置的同一層的中間表征形式和在當前位置的下一層的中間表征形式決定。當前位置的最終中間表征用于計算下一個單詞的概率。

圖2,RNN 語言模型中表征之間的關系。在這里,表示一個句子的開始和結束。

語言模型可以用來計算語言的概率(詞序列)或生成語言。在后一種情況下,自然語言的句子或文章可以從語言模型中隨機抽樣,從大量數據中學習的 LSTM 語言模型可以生成相當自然的句子。

語言模型的擴展是一種條件語言模型,它計算給定條件下單詞序列的條件概率。如果條件是另一個單詞序列,那么問題就變成了從一個單詞序列到另一個單詞序列的轉換ーー也就是所謂的序列到序列問題。機器翻譯、文本摘要、生成式對話都是這樣的任務。如果給定的條件是一幅圖片,那么問題就變成了從一幅圖片到一個詞序列的轉換,圖片說明就是這樣一個任務。

條件語言模型可用于各種各樣的應用程序。在機器翻譯中,該系統將一種語言中的句子轉換成另一種語言中的句子,并且具有相同的語義。在對話生成中,系統對用戶的話語產生響應,兩條信息形成一輪對話。在文本摘要中,系統將長篇文本轉換為短篇文本,使后者代表前者的中心思想。模型的條件概率分布所代表的語義因應用而異,并從應用的數據中學習。

序列到序列模型的研究為新技術的發展做出了貢獻。一個代表性的序列到序列模型是由 Vaswani 等人開發的transformer。transformer完全基于注意力機制,并利用注意力在編碼器和解碼器之間進行編碼、解碼和信息交換。目前,幾乎所有的機器翻譯系統都采用transformer模型,機器翻譯已經達到了幾乎可以滿足實際需要的水平。由于transformer在語言表征上的優越性,現在幾乎所有的預訓練語言模型都采用了transformer的體系結構。

預訓練語言模型

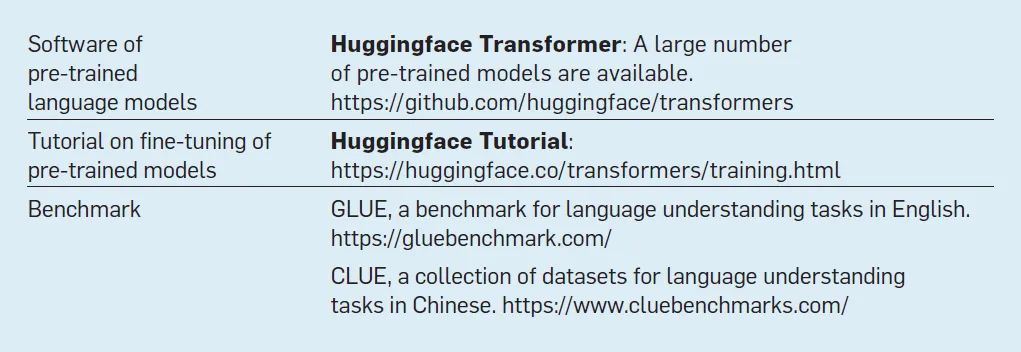

預訓練語言模型的基本思想如下。首先,基于一個已實現的語言模型,例如,transformer的編碼器或解碼器。模型的學習分為兩個階段: 預訓練階段,用一個非常大的語料庫通過非監督式學習訓練模型的參數; 微調階段,用預訓練的模型應用于一個特定的任務,并通過監督式學習進一步調整模型的參數。表1中的鏈接為學習和使用預訓練的語言模型提供了資源。

表1. 用于學習和使用預訓練語言模型的資源

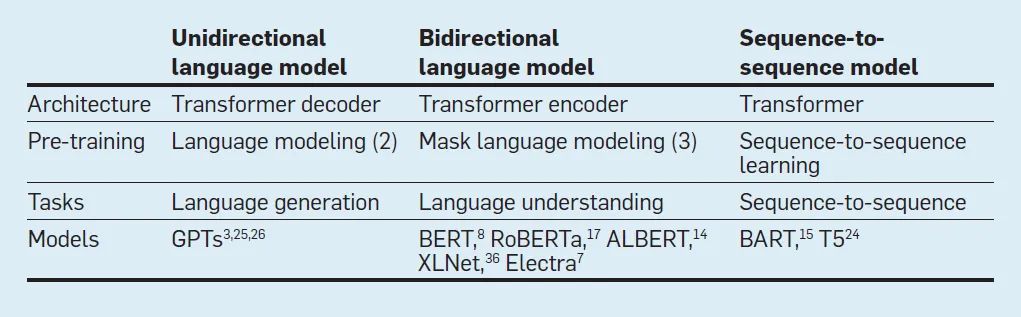

有三種類型的預訓練語言模型: 單向、雙向和序列到序列。由于篇幅所限,本文僅涉及前兩種類型。所有主要的預訓練語言模型都采用了transformer的體系結構,表2提供了現有預訓語言模型的摘要。

表2. 現有預訓練語言模型的摘要

transformer具有很強的語言表達能力,一個非常大的語料庫包含了豐富的語言表達式(這樣的未標記數據可以很容易地獲得) ,訓練大規模的深度學習模型已經變得更加有效。因此,預訓練的語言模型可以有效地表示語言的詞匯、句法和語義特征。預訓練語言模型,如 BERT 和 GPT系列 (GPT-1、 GPT-2和 GPT-3)已經成為當前自然語言處理的核心技術。

預訓練語言模型的應用給自然語言處理帶來了巨大的成功。在語言理解任務(如閱讀理解)的準確性方面,BERT 已經甚至超過了人類。“微調”后的 GPT-3在文本生成任務中也達到了驚人的流暢程度。需要注意的是,結果僅僅表明機器在這些任務中的表現更好,而不是 BERT 和 GPT-3能夠比人類更好地理解語言,因為這也取決于如何進行基準測試。正如從歷史中學到的那樣,對人工智能技術的能力有正確的理解和預期對該領域的健康成長和發展至關重要。

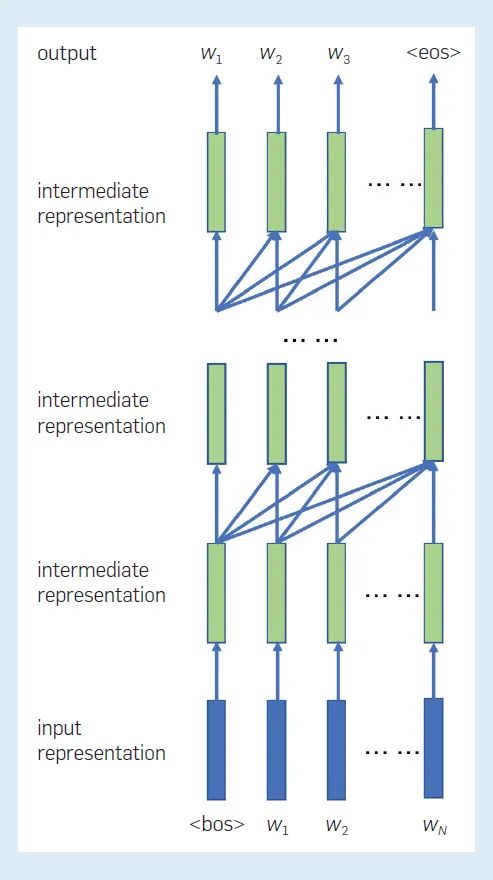

Radford 等和 Brown 等開發的 GPT系列具有以下結構。輸入是一系列單詞 w1,w2,... ,wN,首先,通過輸入層,創建一個輸入表征序列,表示為矩陣 H (0)。通過 L 變壓器譯碼層后,生成一系列中間表征,表示為矩陣 H (L)。

最后,根據每個位置的最終中間表示,計算每個位置的單詞概率分布。GPT 的預訓練與傳統的語言建模相同。目的是預測詞序的可能性。對于給定的詞序列 w = w1,w2,... ,wN,我們計算并最小化交叉熵或負對數似然來估計參數:

其中 θ 表示 GPT系列模型的參數。

圖3顯示了 GPT系列模型中表征之間的關系。每個位置的輸入表示由單詞嵌入和“位置嵌入”組成,每個位置上每個層的中間表征形式是從下面位于前一個位置的層中間表征形式創建的。一個詞的預測或生成是在從左到右每個位置的反復執行。換句話說,GPT是一種單向語言模型,其中單詞序列是從一個方向建模的。(注意,RNN 語言模型也是單向語言模型。)因此,GPT 更適合于解決自動生成句子的語言生成問題。

圖3,GPT系列模型中表征之間的關系。在這里,表示一個句子的開始和結束。

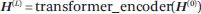

BERT 由 Devlin 等人開發的,具有以下體系結構。輸入是一個單詞序列,可以是單個文檔中的連續句子,也可以是兩個文檔中連續句子的串聯。這使得該模型適用于以一個文本作為輸入的任務(例如文本分類) ,以及以兩個文本作為輸入的任務(例如回答問題)。首先,通過輸入層,創建一個輸入表示序列,表示為矩陣 H (0)。在通過 L Transformer編碼器層之后,創建一個中間表示序列,表示為 H (L)

最后,根據每個位置的最終中間表征,可以計算出每個位置的單詞概率分布。BERT 的預訓練被稱為掩碼語言建模。假設單詞序列是 w = w1,w2,... ,wN。序列中的幾個單詞被隨機屏蔽,也就是說,變成一個特殊的符號[屏蔽]。產生一個新的單詞序列,其中被屏蔽的單詞集被表示為w'。學習的目標是通過計算和最小化下列負對數似然估計參數來恢復被掩蓋的單詞:

其中 θ 表示 BERT 模型的參數,δi 的值為1或0,表示位置 i 處的單詞是否被屏蔽。請注意,掩碼語言建模已經是一種不同于傳統語言建模的技術。

圖4顯示了 BERT 模型中表征之間的關系。每個位置的輸入表示由詞語嵌入、“位置嵌入”等組成。每個位置的每個層的中間表征是從下面所有位置的層的中間表征創建的。單詞的預測或生成是在每個掩蔽位置獨立進行的,也就是說,BERT 是一個雙向的語言模型,其中的詞序列是從兩個方向建模的。因此,BERT 可以自然地應用于語言理解問題,其輸入是一個完整的單詞序列,輸出通常是一個標簽或標簽序列。

圖4,BERT 模型中表征之間的關系。這里,表示一個特殊的符號,表示整個輸入序列。

對預訓練語言模型的直觀解釋是,該機器在預訓練過程中進行了大量基于大型語料庫的單詞卡片或完形填空練習,從單詞中捕捉各種句子構成模式,然后從句子中構成文章,表達和記憶模型中的模式。文本不是用單詞和句子隨機創建的,而是基于詞匯、句法和語義規則構建的。GPT系列和 BERT 可以分別使用transformer的譯碼器和編碼器來實現語言的組合性。(組合性是語言最基本的特征,喬姆斯基譜系中的文法也是這一特征的模型。)換句話說,GPT系列 和 BERT 在訓練前已經獲得了相當多的詞匯、句法和語義知識。因此,當在微調中適應特定任務時,只需少量標記數據即可完善模型,以實現高性能。例如,發現不同的 BERT 層具有不同的特性。底層主要表示詞匯知識,中層主要表示句法知識,頂層主要表示語義知識。

預訓練的語言模型(沒有進行微調) ,如 BERT 和 GPT-3,包含了大量的實際知識。例如,它們可以用來回答諸如“但丁出生在哪里?”,并進行簡單的推理,例如,“什么是48加76?”然而,語言模型本身并沒有推理機制。他們的“推理”能力是基于聯想而不是真正的邏輯推理。因此,他們在需要復雜推理的問題上表現不佳,包括論證推理,數值和時間推理,以及語意推理。將推理能力和語言能力整合到自然語言處理系統中將是未來的一個重要課題。

未來展望

當代科學(腦科學和認知科學)對人類語言處理機制(語言理解和語言生成)的理解有限。在可預見的未來,很難看到重大突破的發生,而且有永遠不會突破的可能性存在。另一方面,我們希望不斷促進人工智能技術的發展,開發對人類有用的語言處理機器。

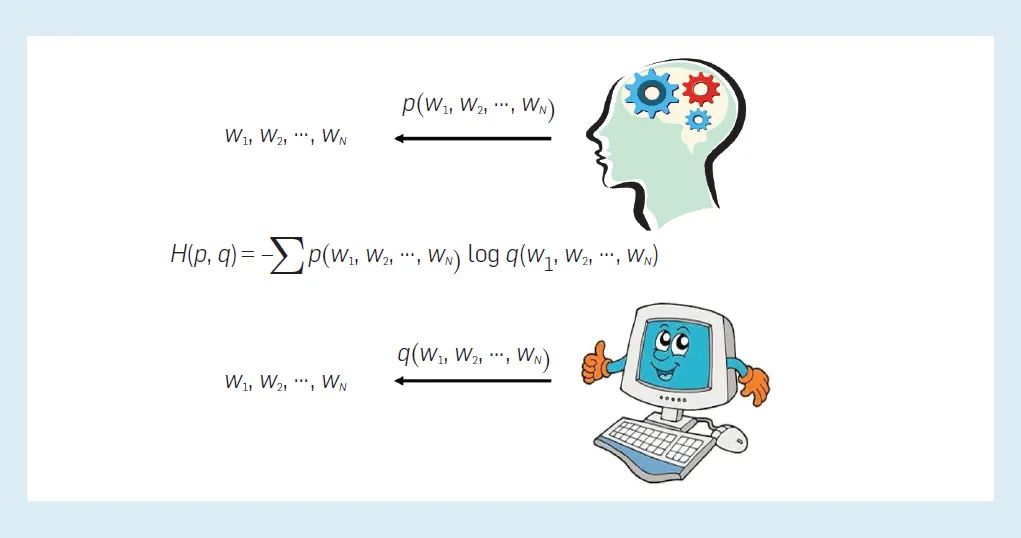

神經語言建模似乎是迄今為止最成功的方法。語言建模的基本特征沒有改變,也就是說,它依賴于在一個包含所有單詞序列的離散空間中定義的概率分布。學習過程就是找到最優模型,以便用交叉熵預測語言數據的最高準確性(見圖5)。神經語言建模的優勢在于,它可以利用復雜的模型、大數據和強大的計算能力非常精確地模擬人類語言行為。從 Bengio 等人提出的原始模型到 RNN 語言模型和 GPT系列 以及BERT 等預訓練語言模型,神經網絡的結構變得越來越復雜(參見圖1,2,3,4) ,而預測語言的能力變得越來越高(交叉熵變得越來越小)。然而,這并不一定意味著模型具有與人類相同的語言能力,這種方法的局限性也是不言而喻的。

圖5,這臺機器通過調整其“大腦”內部的神經網絡參數來模擬人類的語言行為最終,它可以像人類一樣處理語言。

還有其他可能的發展道路嗎?目前還不清楚。可以預見的是,神經語言建模方法仍有很多改進的空間。目前的神經語言模型在表示能力和計算效率(功耗)方面與人腦還有很大差距。根據研究,一個成年人的大腦工作時間只有12W; 與之形成鮮明對比的是,GPT-3模型的訓練耗費了幾千千兆次/秒的時間。是否能夠開發出一個更好的語言模型來更接近人類語言處理是未來研究的一個重要方向。技術改進的機會仍然很多,仍然可以從腦科學的有限發現中得到啟發。

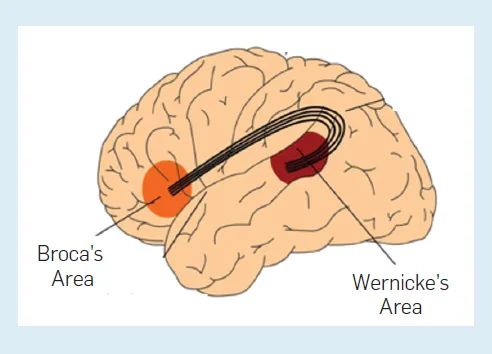

人類的語言處理被認為主要在大腦皮層的兩個區域進行: Broca 區和Wernicke區(圖6)。前者負責語法,后者負責詞匯。腦損傷導致失語的典型病例有兩例。在 Broca 區受傷的病人只能說零星的話而不是句子,而在Wernicke區受傷的病人可以構建語法正確的句子,但是這些詞往往缺乏意義。一個自然的假設是,人類的語言處理是在兩個大腦區域并行進行的。是否有必要采用更加人性化的處理機制是一個值得研究的課題。語言模型不能明確地使用語法,也不能無限地組合語言,這是人類語言的一個重要屬性,將語法更直接地納入語言模型的能力將是一個需要研究的問題。

圖6,人腦中負責語言處理的區域。

腦科學家認為,人類語言理解是一個在潛意識中激活相關概念表征并在意識中生成相關圖像的過程。表征包括視覺、聽覺、觸覺、嗅覺和味覺,它們是視覺、聽覺、觸覺、嗅覺和味覺的內容,通過一個人在成長和發展過程中的經驗,在大腦的各個部分被記住。因此,語言的理解與人們的經驗密切相關。生活中的基本概念,如貓和狗,是通過視覺、聽覺、觸覺等傳感器的輸入來學習的。聽到或看到“貓”和“狗”這兩個詞也會激活人腦中相關的視覺、聽覺和觸覺表征。機器能否從大量的多模態數據(語言、視覺、語音)中學習更好的模型,從而更智能地處理語言、視覺和語音呢?多模態語言模型將是未來研究的重要課題。

結論

語言模型的歷史可以追溯到100多年前,馬爾科夫、香農和其他人沒有預見到他們所研究的模型和理論會在以后產生如此巨大的影響,甚至可能是意想不到的。未來100年中語言模型將如何發展?它們仍將是人工智能技術的重要組成部分嗎?這超出了我們的想象和預測。我們可以看到的是,語言建模技術在不斷發展,在未來的幾年中,更強大的模型很可能取代 BERT 和 GPT。