一個(gè)項(xiàng)目幫你了解數(shù)據(jù)集蒸餾Dataset Distillation

數(shù)據(jù)集蒸餾研究簡介

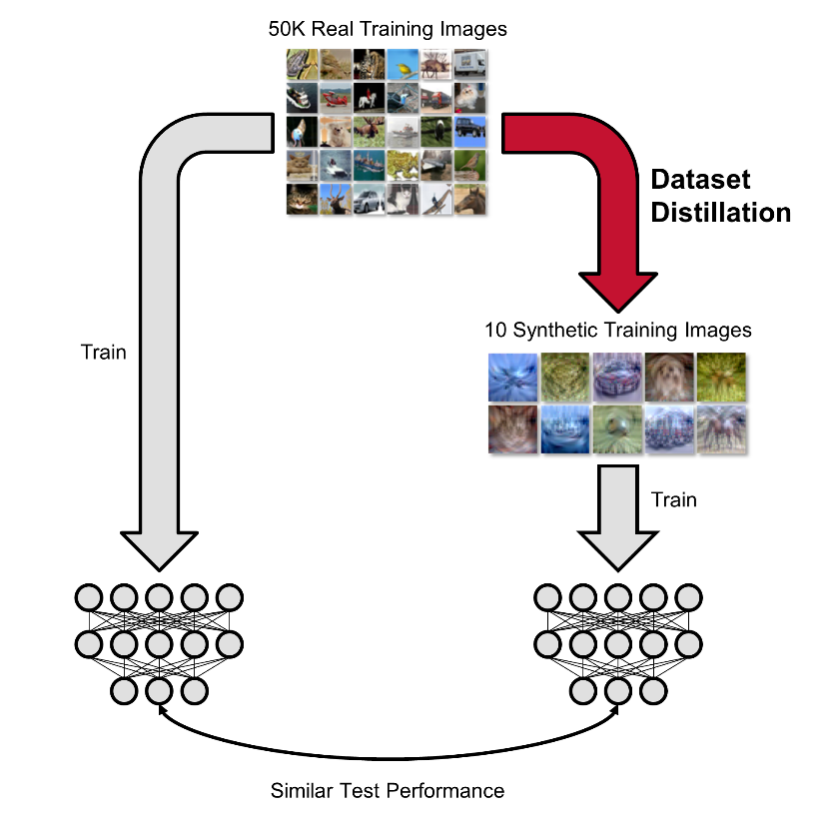

數(shù)據(jù)集蒸餾是合成小數(shù)據(jù)集的任務(wù),以便在其上訓(xùn)練的模型在原始大數(shù)據(jù)集上實(shí)現(xiàn)高性能。數(shù)據(jù)集蒸餾算法將要蒸餾的大型真實(shí)數(shù)據(jù)集(訓(xùn)練集)作為輸入,并輸出一個(gè)小的合成蒸餾數(shù)據(jù)集,該數(shù)據(jù)集通過在單獨(dú)的真實(shí)數(shù)據(jù)集(驗(yàn)證 / 測(cè)試集)上在該蒸餾數(shù)據(jù)集上訓(xùn)練的測(cè)試模型進(jìn)行評(píng)估。

數(shù)據(jù)集蒸餾問題設(shè)定

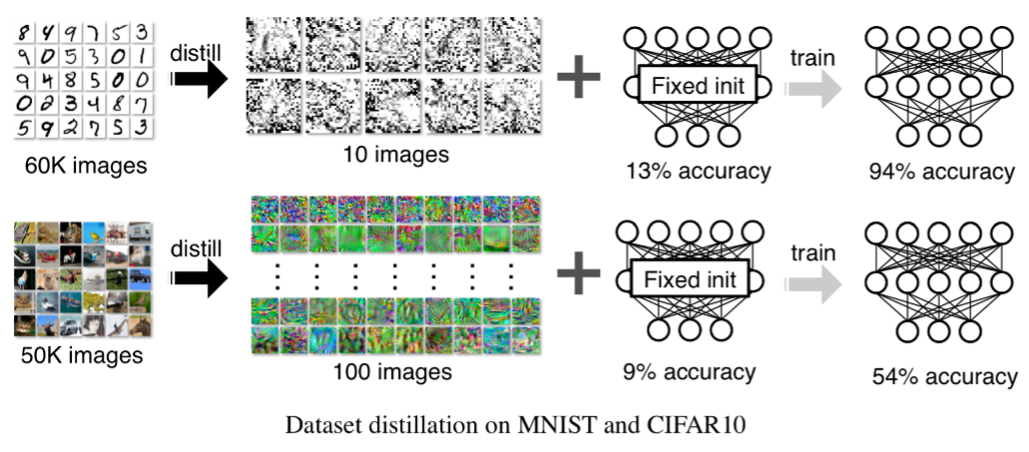

這項(xiàng)任務(wù)最初是在 Dr. Tongzhou Wang 2018 年的論文 Dataset Distillation [1] 中介紹的,改論文同時(shí)提出了通過優(yōu)化步驟使用反向傳播的算法。由于最初算法的局限性,當(dāng)時(shí)僅僅可以在一些簡單數(shù)據(jù)集如 MNIST,CIFAR-10 上進(jìn)行蒸餾操作且準(zhǔn)確率比較低。這也是最初的 Dataset Distillation 沒有被一些 AI 頂會(huì) (NeurIPS/ICCV/ICLR) 收錄的原因。

最初的數(shù)據(jù)集蒸餾效果

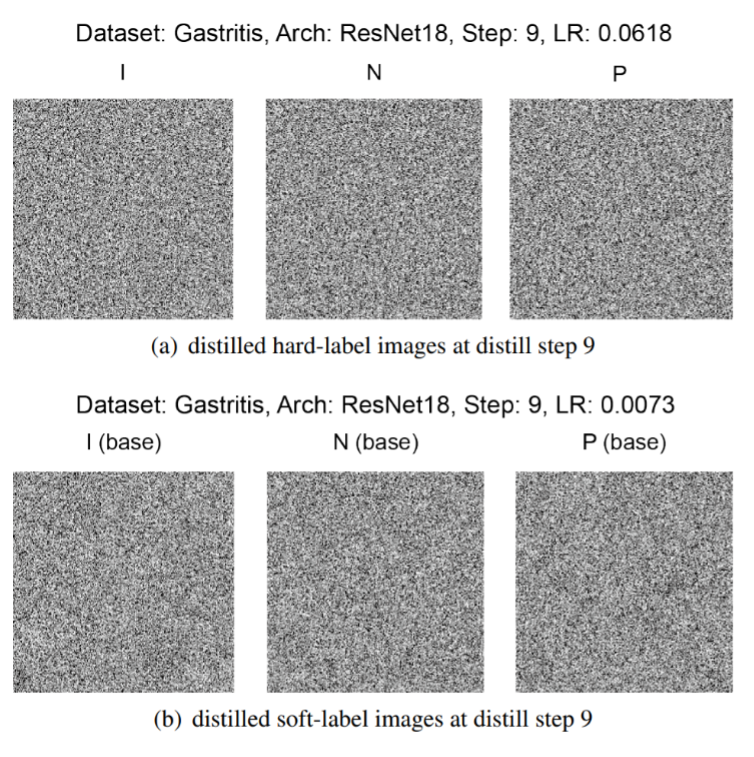

一個(gè)好的小型蒸餾數(shù)據(jù)集不僅對(duì)數(shù)據(jù)集理解有用,而且具有各種應(yīng)用(例如,隱私保護(hù),持續(xù)學(xué)習(xí),神經(jīng)架構(gòu)搜索等)。其中,Dr. Guang Li 最先將數(shù)據(jù)集蒸餾應(yīng)用于醫(yī)學(xué)圖像領(lǐng)域,并對(duì)其在隱私保護(hù)方面的特性做了探索,該研究通過將十幾萬張胃部 X 光圖像蒸餾到只有 3 張并達(dá)到了很好的胃炎檢測(cè)效果,研究成果發(fā)表于 ICIP 2020 [2].

匿名化的胃部 X 光蒸餾圖像

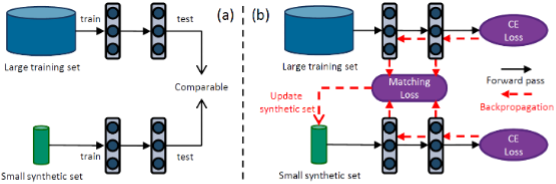

2021 年后,數(shù)據(jù)集蒸餾在研究界、許多研究所和實(shí)驗(yàn)室中越來越受到關(guān)注。現(xiàn)在每年都有更多的論文發(fā)表。這些精彩的研究一直在不斷改進(jìn)數(shù)據(jù)集蒸餾并探索其各種變體和應(yīng)用。其中最具有突破性的研究之一是由 Dr. Bo Zhao 在 ICLR 2021 中提出的 Dataset Condensation,該論文首次提出通過梯度匹配策略來蒸餾數(shù)據(jù)集并大大提升了測(cè)試準(zhǔn)確率以及泛化能力 [3].

基于梯度匹配的數(shù)據(jù)集縮合算法

最近由 CMU,MIT,UC Berkeley 的學(xué)者們發(fā)表的一篇論文首次實(shí)現(xiàn)了對(duì) ImageNet 的蒸餾并又一次大幅提升了蒸餾數(shù)據(jù)集的測(cè)試效果, 該成果發(fā)表于 CVPR 2022 [4]。

ImageNet 上的蒸餾效果

對(duì)于目前數(shù)據(jù)集蒸餾領(lǐng)域的巨大進(jìn)展 Dr. Tongzhou Wang 表示非常驚喜并在推特上對(duì) Awesome-Dataset-Distillation 項(xiàng)目進(jìn)行了介紹。

Dr. Tongzhou Wang 在推特上對(duì)數(shù)據(jù)集蒸餾項(xiàng)目的介紹

在 Awesome-Dataset-Distillation 項(xiàng)目完成后,短短一個(gè)月的時(shí)間在 GitHub 上已經(jīng)獲得了 300Star,受到了國內(nèi)外很多知名學(xué)者的關(guān)注。此外,上個(gè)月被外媒選為八月份最受關(guān)注的 AI 研究之一。

- 數(shù)據(jù)集蒸餾的項(xiàng)目地址:?https://github.com/Guang000/Awesome-Dataset-Distillation?

- Dr. Guang Li (Hokkaido University) :?https://www-lmd.ist.hokudai.ac.jp/member/guang-li/?

- Dr. Bo Zhao (The University of Edinburgh):?https://bozhaonanjing.wixsite.com/mysite?

- Dr. Tongzhou Wang (MIT):??https://www.tongzhouwang.info/?

?[1] Wang, Tongzhou, et al. "Dataset distillation." arXiv preprint arXiv:1811.10959.

[2] Li, Guang, et al. "Soft-label anonymous gastric x-ray image distillation." ICIP 2020.

[3] Zhao, Bo, et al. "Dataset Condensation with Gradient Matching." ICLR 2021.

[4] Cazenavette, George, et al. "Dataset distillation by matching training trajectories." CVPR 2022.