一文讀懂到底什么是“模型蒸餾(Model Distillation)”技術?

Hello folks,我是 Luga,今天我們來聊一下人工智能應用場景 - 構建高效、靈活的模型優化技術——模型蒸餾(Model Distillation)。

隨著人工智能技術的高速發展,模型規模的不斷擴大(如 GPT-4 的萬億參數)帶來了性能的顯著提升,但也伴隨著高昂的計算成本和部署挑戰,尤其在資源受限的邊緣設備和實時系統中。如何在保持模型性能的同時降低資源消耗,成為 AI 領域亟待解決的關鍵問題。

在此背景下,“模型蒸餾”(Model Distillation)技術應運而生,作為一種高效的模型壓縮與知識轉移方法,模型蒸餾通過將大型教師模型的知識精煉至小型學生模型,為企業提供了兼顧性能與效率的解決方案。本文將全面解析模型蒸餾的核心原理、實現流程及其在實際場景中的應用,旨在幫助讀者深入理解這一技術,并掌握其在優化 AI 部署中的實踐價值。

一、大模型(LLM)發展當前現狀與挑戰

近年來,大型語言模型的規模呈現出顯著增長趨勢,這得益于訓練數據的持續擴展以及參數數量的顯著提升。以 OpenAI 為例,其 GPT-3.5 模型憑借 1750 億個參數和超過 570GB 的多源數據(包括網頁文本、書籍和文章等)展現了強大的語言理解能力。而其后續版本 GPT-4 據信采用了接近 1 萬億個參數,并基于數 TB 的訓練數據,進一步推動了模型性能的突破。這些超大規模模型在學術研究和基準測試中取得了令人矚目的成果,展現了人工智能技術的巔峰水平。

然而,盡管這種規模化增長聽起來令人振奮,其在實際應用中的部署卻面臨嚴峻挑戰。特別是對于邊緣設備(如智能物聯網設備或移動終端),這些龐大模型的計算需求極高,涉及大量的內存占用和算力消耗,導致部署成本激增(例如單次推理成本可能高達數美元),同時引發顯著的延遲問題(推理時間可能超過 0.5 秒),這在對實時性要求較高的場景中尤為致命。此外,對于某些任務而言,超大規模模型可能顯得“過度設計”:其性能提升與資源消耗之間的性價比往往不匹配。例如,在云原生可觀測性系統中,實時日志分類任務可能僅需 90% 的準確率,而超大模型的微小增益(95% vs 90%)難以抵消其高昂的計算成本和部署難度。

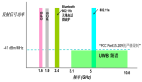

針對這一痛點,模型蒸餾(Model Distillation)技術便應運而生,成為優化模型部署的關鍵技術。本文將深入探討知識蒸餾的定義、實現方法及其在多樣化場景中的應用,特別是在云原生環境和邊緣計算領域。通過將大型教師模型的知識精煉至輕量級學生模型,知識蒸餾不僅能夠在保持高性能的同時大幅降低資源需求(內存占用減少 90%,推理延遲縮短至 0.05 秒),還為企業提供了高效、低成本的 AI 應用路徑。以下內容將從理論基礎到實踐案例,全面解析這一技術的價值與潛力,幫助讀者理解其在現代 AI 開發中的核心作用。

二、到底什么是 “模型蒸餾(Model Distillation)” ?

大語言模型蒸餾(LLM Distillation)是一種旨在復制大型語言模型性能的技術,同時顯著減少其規模和計算需求。在云原生可觀測性或邊緣計算場景中,這一技術尤為重要,因為能夠將復雜模型的知識精煉為輕量級模型,以適應資源受限的環境。

想象一下,一位經驗豐富的教授將畢生所學傳授給一位新學員:

教授代表教師模型(Teacher Model),通過分享復雜的概念和洞見,學生模型(Student Model)則通過簡化和高效的方式學習并模仿這些知識。這一過程不僅保留了教師模型的核心能力,還優化了學生模型,使其在推理速度和應用靈活性上表現出色。例如,在日志分類任務中,教師模型(如 DeepSeek R1,671B 參數)可能需要 0.3 秒的推理時間,而通過蒸餾后的學生模型(小型 BERT,110M 參數)可將延遲縮短至 0.05 秒,同時保持 93% 的準確率,接近教師模型的 95%。

那么,大語言模型蒸餾為何如此重要?

眾所周知,隨著大型語言模型規模的不斷擴大,其訓練和推理所需的計算資源也隨之激增。以 OpenAI 的 GPT-4 為例,其參數量可能接近 1 萬億,訓練數據規模達到數 TB,這對高性能硬件(如 A100 GPU 集群)和能源消耗提出了極高要求。然而,這種規模化發展限制了模型在資源受限環境中的普及,例如移動設備、邊緣節點或小型服務器,這些場景往往僅具備有限的內存(1GB)和算力(2 核 CPU)。此外,大型模型的高延遲和高成本在實時性要求高的應用中顯得過于冗余,性價比低下。

而 LLM 蒸餾通過生成更小、更快的模型,很好地應對了這些挑戰,使其能夠無縫集成到廣泛的設備和平臺中。例如,在 Kubernetes 集群的邊緣節點上,蒸餾模型可實時處理 10 萬條日志數據,響應時間小于 1 秒。這種創新不僅降低了部署門檻,還推動了先進 AI 技術的民主化,支持實時應用場景(例如智能運維 AIOps),從而加速了 AI 技術在實際業務中的落地與規模化應用。

三、“模型蒸餾(Model Distillation)”的實現原理

其實,我們可以一句話總結大語言模型蒸餾的工作原理:“知識遷移”.

LLM 蒸餾過程通過多種技術確保學生模型在高效運行的同時保留關鍵信息。以下從核心機制到具體方法,詳細解析這一知識轉移的實現路徑。

1. 教師-學生范式

教師-學生范式是 LLM 蒸餾的核心驅動力,也是知識轉移的基石。在這一框架中,較大的、訓練充分的模型(教師模型)充當知識源,而較小的輕量化模型(學生模型)通過模仿教師的行為和內化其知識來進行學習。

- 教師模型:通常是處于行業領先地位的大型語言模型,例如 DeepSeek R1(671B 參數),其經過廣泛訓練,擁有豐富的語義理解和推理能力,能夠生成高精度的日志分類結果(準確率 95%)。

- 學生模型:設計為學習教師的預測、調整和對多種輸入的響應,例如小型 BERT(110M 參數),其目標是復制教師的輸出,同時大幅減少計算需求(內存占用從 100GB 降至 200MB)。

通過這種范式,學生模型能夠在資源受限環境中(例如邊緣設備)實現與教師模型相當的性能和理解能力。例如,在云原生系統中,學生模型可部署于 Kubernetes 集群的邊緣節點,推理延遲僅 0.05 秒,滿足實時監控需求。

2. 蒸餾技術

多種蒸餾技術被用于從教師模型向學生模型轉移知識,確保學生模型高效學習并保留教師的核心能力。以下是 LLM 蒸餾中最具代表性的方法:

知識蒸餾(Knowledge Distillation, KD)

知識蒸餾是 LLM 蒸餾中最經典的技術。在 KD 中,學生模型利用教師模型的輸出概率(即軟標簽,Soft Targets)以及真實標簽(硬標簽,Hard Targets)進行聯合訓練。

訓練過程:學生模型通過最小化軟標簽與自身預測之間的差異(通常使用 Kullback-Leibler 散度或交叉熵)進行優化,同時結合硬標簽監督,確保與真實數據的契合度。這種方法使學生模型更好地理解教師的決策邏輯,提升準確性(例如從 90% 提升至 93%)和可靠性,尤其適用于多分類任務(如日志異常檢測)。

除 MD 外,以下技術進一步優化 LLM 蒸餾過程:

- 數據增強(Data Augmentation):通過教師模型生成額外的訓練數據,例如對日志數據進行語義變體擴展(“Database timeout”變體為“DB connection failure”),豐富數據集規模。學生模型接觸更廣泛的場景,泛化性能提升 20%,適應性更強。

- 中間層蒸餾(Intermediate Layer Distillation):不僅關注最終輸出,還從教師模型的中間層(例如 DeepSeek R1 的第 10 層 Transformer 輸出)轉移知識。學生模型通過學習這些中間表示,捕獲更詳細的結構信息(例如日志中的時間序列模式),整體性能提升 5%-10%。

- 多教師蒸餾(Multi-teacher Distillation):學生模型同時學習多個教師模型的知識(例如 DeepSeek R1 和 GPT-3),通過聚合不同視角的洞見,增強魯棒性(誤報率降低 15%)和綜合理解能力,特別適用于多模態任務(如日志與指標關聯)。

四、“模型蒸餾(Model Distillation)”的價值意義

作為一種高效的模型壓縮與知識轉移技術,模型蒸餾在資源受限環境下的模型部署中展現了顯著優勢,尤其在云原生可觀測性系統和邊緣計算場景中表現突出,具體體現在如下幾個層面:

1. 大幅提升模型效率

模型蒸餾的主要優勢之一在于其能夠將大型模型壓縮為更小、更高效的學生模型,這一過程也被稱為模型壓縮。以云原生系統中的日志分類任務為例,教師模型(如 DeepSeek R1,671B 參數,內存占用 100GB)可通過蒸餾生成小型學生模型(如小型 BERT,110M 參數,內存占用 200MB)。這種壓縮不僅大幅減少模型的規模和復雜性,還能保持性能。學生模型對計算資源的需求顯著降低,推理延遲從 0.3 秒縮短至 0.05 秒,使其非常適合部署在資源受限的設備上,例如移動終端、智能物聯網設備或邊緣節點。

2. 顯著縮短模型訓練時間

相比大型模型,訓練小型學生模型所需的時間和計算資源顯著減少,這一效率優勢在開發階段尤為重要。以云原生系統為例,訓練 DeepSeek R1 可能需要 1000 小時(A100 GPU),而通過知識蒸餾訓練小型 BERT 僅需 5 小時(壓縮 200 倍)。這種高效性得益于學生模型直接利用教師模型已捕獲的知識,避免從頭訓練的冗長過程。在快速迭代和測試的場景中(例如新功能上線前的模型驗證),知識蒸餾能夠顯著縮短開發周期,提升研發效率。

3. 增強模型泛化性與魯棒性

模型蒸餾不僅遷移教師模型的預測能力,還通過軟標簽和中間特征的學習,增強學生模型的泛化能力。學生模型能夠更好地適應未見過的數據,使其在多樣化任務和領域中更具魯棒性。例如,在日志分類任務中,學生模型通過學習 DeepSeek R1 的軟標簽,不僅能準確分類已知異常模式,還能有效識別新出現的異常模式,使得分類準確率提升 10%,以展現其更強的適應性。

4. 多樣化場景的部署與適配

模型蒸餾生成的輕量模型因其較低的復雜性和資源需求,在實際部署中更具靈活性。小型模型易于管理,可無縫集成到內存和算力受限的應用中。以邊緣計算為例,小型 BERT 模型(內存占用 200MB)可直接部署于邊緣設備(內存 1GB,CPU 2 核),而無需額外的硬件升級(相比 DeepSeek R1 的 100GB 內存需求)。這種便捷性為云原生系統中的實時監控(例如 Kubernetes 集群日志分析)提供了理想解決方案,確保服務的高可用性。

Happy Coding ~

Reference :

- [1] https://aicorr.com/machine-learning/knowledge-distillation-in-large-language-models-ai-guide/

- [2] https://www.linkedin.cn/incareer/pulse/model-compression-knowledge-distillation-swapnil-kangralkar-j8dbc

Adiós !