從手工作業到工業革命!Nature文章:生物圖像分析被深度學習徹底改變的五個領域

一立方毫米,聽起來不大,也就是一粒芝麻的大小,但在人類的大腦中,這點兒空間卻能夠容納由1.34億個突觸相連接的大約5萬條神經線(neural wires)。

為了生成原始數據,生物科學家需要使用連續超薄切片電鏡的方法,在11個月內對數以千計的組織碎片進行成像。

而最終獲得的數據量也達到了驚人的1.4 PetaBytes(即1400TB,相當于大約200萬張CD-ROM的容量) ,對于研究人員來說這簡直就是個天文數字。

哈佛大學的分子和細胞生物學家Jeff Lichtman表示,如果用純手工作業,人類根本不可能手動追蹤所有的神經線,地球上甚至都沒有足夠多的人能夠真正有效地完成這項工作。

顯微鏡技術的進步帶來了大量的成像數據,但數據量太大,人手不足,這也是連接組學(Connectomics,一門研究大腦結構和功能連接的學科),以及其他生物領域學科中的常見現象。

但計算機科學的使命正是為解決這類人力資源不足的問題,尤其是經過優化的深度學習算法,可以從大規模數據集中挖掘出數據模式。

麻省理工學院布羅德研究所和哈佛大學劍橋分校的計算生物學家Beth Cimini表示,過去幾年中,深度學習在生物學領域有著巨大的推動作用,并開發了很多研究工具。

下面是Nature編輯總結深度學習帶來變革的五個生物學圖像分析領域。

大規模連接組學

深度學習使研究人員能夠從果蠅、老鼠甚至人類身上生成越來越復雜的連接體。

這些數據可以幫助神經科學家理解大腦是如何工作的,以及大腦結構在發育和疾病過程中是如何變化的,但神經連接并不容易繪制。

2018年,Lichtman與谷歌在加州山景城的連接組學負責人Viren Jain聯手,為團隊所需的人工智能算法尋找解決方案。

連接組學中的圖像分析任務實際上是非常困難的,你必須能夠追蹤這些細線、細胞的軸突和樹突,還要跨越很長的距離,傳統的圖像處理方法在這項任務中會出現很多錯誤,基本上對這項任務沒有用處。

這些神經線可能比一微米還細,延伸數百微米甚至跨越毫米級的組織。

而深度學習算法不僅能夠自動化地分析連接組學數據,同時還能保持很高的精度。

研究人員可以使用包含感興趣特征的標注數據集來訓練復雜的計算模型,以便能夠快速識別其他數據中的相同特征。

歐洲分子生物學實驗室的計算機科學家Anna Kreshuk認為,使用深度學習算法的過程類似于「舉個例子」,只要例子夠多,你就能把所有問題都解決掉。

但即使是使用深度學習,Lichtman和Jain團隊還要完成一項艱巨的任務:繪制人類大腦皮層的片段。

在收集數據階段,僅僅拍攝5000多個超薄的組織切片就花了326天。

兩名研究人員花了大約100個小時來手動標注圖像和追蹤神經元,創建了一個ground truth數據集以訓練算法。

使用標準數據訓練后的算法就可以自動將圖像拼接在一起,識別出神經元和突觸,并生成最終的連接體。

Jain的團隊為解決這個問題也投入了大量的計算資源,包括數千個張量處理單元(TPU) ,還耗費了幾個月時間來預處理100萬TPU小時所需的數據。

雖然研究人員已經獲取到當下能收集到最大規模的數據集,能夠在非常精細的水平進行重建,但這個數據量大約只占人類大腦的0.0001%

隨著算法和硬件的改進,研究人員應該能夠繪制出更大的大腦區域,同時能夠分辨出更多的細胞特征,比如細胞器,甚至蛋白質。

至少,深度學習提供了一種可行性。

虛擬組織學

組織學(histology)是醫學上的一個重要工具,用于在化學或分子染色的基礎上診斷疾病。

但是整個過程費時費力,通常需要幾天甚至幾周的時間才能完成。

先將活組織檢查切成薄片,染色顯示細胞和亞細胞特征,然后病理學家通過閱讀結果并對之進行解釋。

加州大學洛杉磯分校的計算機工程師Aydogan Ozcan認為可以通過深度學習的方式對整個過程進行加速。

他訓練了一個定制的深度學習模型,通過計算機模擬給一個組織切片上染色,將同一切片上數以萬計的未染色和染色的樣本喂給模型,并讓模型計算出它們之間的差異。

虛擬染色除了有時間優勢(瞬間就能完成)外,病理學家通過觀察發現,虛擬染色和傳統染色幾乎毫無區別,專業人士也無法分辨。

實驗結果表明,該算法可以在幾秒鐘內復制乳腺癌生物標志物HER2的分子染色,而該過程在組織學實驗室通常需要至少24小時。

三位乳腺病理學家組成的專家小組對這些圖像進行了評價,認為它們的質量和準確性與傳統的免疫組織化學染色相當。

Ozcan看到了將虛擬染色商業化后在藥物研發中的應用前景,但他更希望借此消除組織學對有毒染料和昂貴染色設備的需求。

尋找細胞

如果你想從細胞圖像中提取數據,那你必須知道細胞在圖像中的實際位置,這一過程也稱為細胞分割(cell segmentation)。

研究人員需要在顯微鏡下觀察細胞,或者在軟件中一張一張地勾勒出細胞的輪廓。

加州理工學院的計算生物學家Morgan Schwartz正在尋求自動化處理的方法,隨著成像數據集變得越來越大,傳統的手工方法也遇到了瓶頸,有些實驗如果不自動化就無法進行分析。

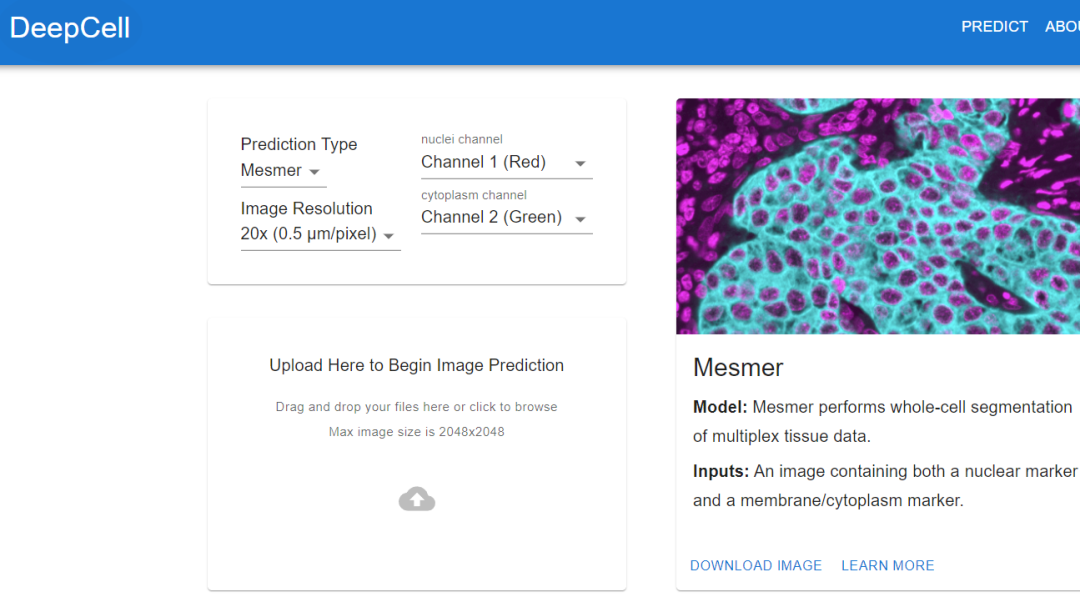

Schwartz的研究生導師、生物工程師David Van Valen創建了一套人工智能模型,并發布在了deepcell.org網站上,可以用來計算和分析活細胞和保存組織圖像中的細胞和其他特征。

Van Valen與斯坦福大學癌癥生物學家Noah Greenwald等合作者一起還開發了一個深度學習模型Mesmer,可以快速、準確地檢測不同組織類型的細胞和細胞核。

據Greenwald說,研究人員可以利用這些信息來區分癌癥組織和非癌組織,并尋找治療前后的差異,或者基于成像的變化來更好地了解為什么一些患者會有反應或者沒有反應,以及確定腫瘤的亞型。

定位蛋白質

人類蛋白質圖譜項目利用了深度學習的另一個應用:細胞內定位。

斯坦福大學的生物工程師Emma Lundberg表示,在過去幾十年間,該項目生成了數百萬張圖像,描繪了人體細胞和組織中的蛋白質表達。

剛開始的時候,項目參與者需要手動對這些圖像進行標注,但這種方法不可持續,Lundberg開始尋求人工智能算法的幫助。

過去幾年,她開始在Kaggle挑戰賽中發起眾包解決方案,科學家和人工智能愛好者為了獎金會完成各種計算任務,兩個項目的獎金分別為3.7萬美元和2.5萬美元。

參賽者會設計有監督的機器學習模型,并對蛋白質圖譜圖像進行標注。

Kaggle挑戰賽獲得的成果也讓項目成員大吃一驚,獲勝的模型性能比Lundberg先前在蛋白質定位模式的多標簽分類方面要高出約20% ,并且可以泛化到細胞系(cell line)中,還取得了新的行業突破,對存在于多個細胞位置的蛋白質進行準確的分類。

有了模型,生物實驗就可以繼續推進,人類蛋白質的位置很重要,因為相同的蛋白質在不同的地方表現不同,知道一種蛋白質是在細胞核還是在線粒體中,這有助于理解它的功能。

追蹤動物行為

Mackenzie Mathis是瑞士洛桑聯邦理工學院校園生物技術中心的神經科學家,長期以來一直對大腦如何驅動行為感興趣。

為此,她開發了一個名為DeepLabCut的程序,使神經科學家能夠從視頻中追蹤動物的姿勢和精細動作,并將「貓咪視頻」和其他動物的記錄轉化為數據。

DeepLabcut提供了一個圖形用戶界面,研究人員只需點擊一個按鈕,就可以上傳并標注視頻并訓練深度學習模型。

今年4月,Mathis的團隊擴展了該軟件,可以同時為多種動物估計姿勢,這對人類和人工智能來說都是一個全新的挑戰。

將DeepLabCut訓練后的模型應用到狨猴身上,研究人員發現,當這些動物靠得很近時,它們的身體會排成一條直線,看向相似的方向,而當它們分開時,它們傾向于面對面。

生物學家通過識別動物的姿勢,來了解兩種動物是如何交互、注視或觀察世界的。