Meta元宇宙出狠活!一個攝像頭就能捏出個會動的虛擬化身

運動中的人類新視圖合成是一個極具挑戰性的計算機視覺問題。

以往的2D圖片轉三維模型都是在靜態的情況下,但如果輸入的是一段人類運動的視頻,該如何生成自由視角的視頻?

如果這個問題解決了,那就可以在AR/VR應用中的自動化實現虛擬化身建模。

現有的一些研究工作通常需要復雜的任務設置,包括多個輸入視頻、三維監督或預訓練模型,這些苛刻的要求都限制了模型的泛化性,無法很好地推廣到新用戶的輸入上。

為了解決這些局限性,Meta提出了一個新視圖合成框架HVS-Net,可以從任意人類的未見視圖中生成逼真的渲染。視圖的捕獲過程只需要一個具有稀疏RGB-D的單視圖傳感器,類似于一個低成本的深度相機。

論文鏈接:?https://www.phongnhhn.info/HVS_Net/img/HVSNet.pdf?

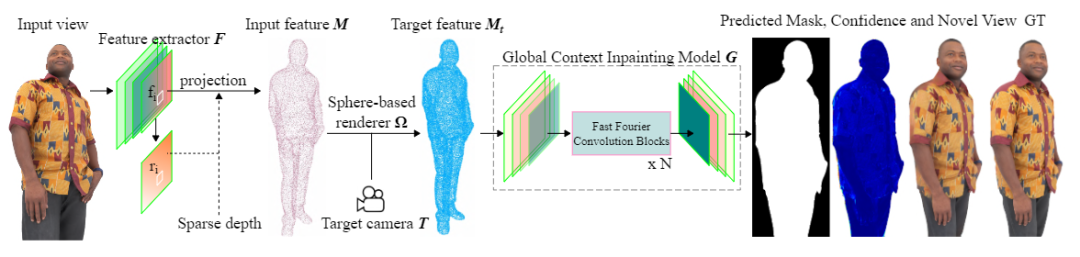

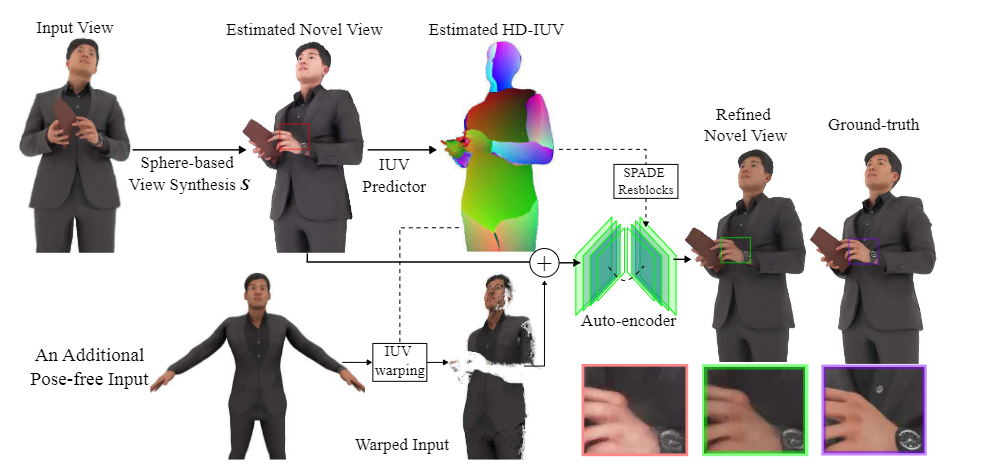

論文中提出了一個架構來學習基于球體(sphere-based)的神經渲染所獲得的新視圖中的稠密特征,并使用全局上下文繪畫模型來創建完整的渲染圖。

此外還包括一個增強網絡(enhancer network)利用整體保真度,甚至在原始視圖的遮擋區域,產生具有精細細節的清晰渲染。

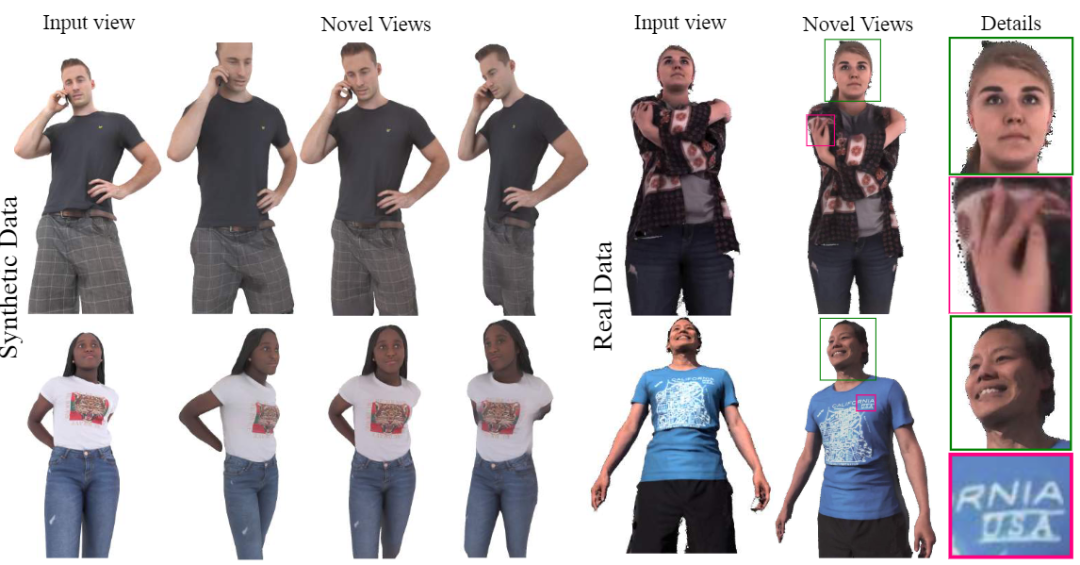

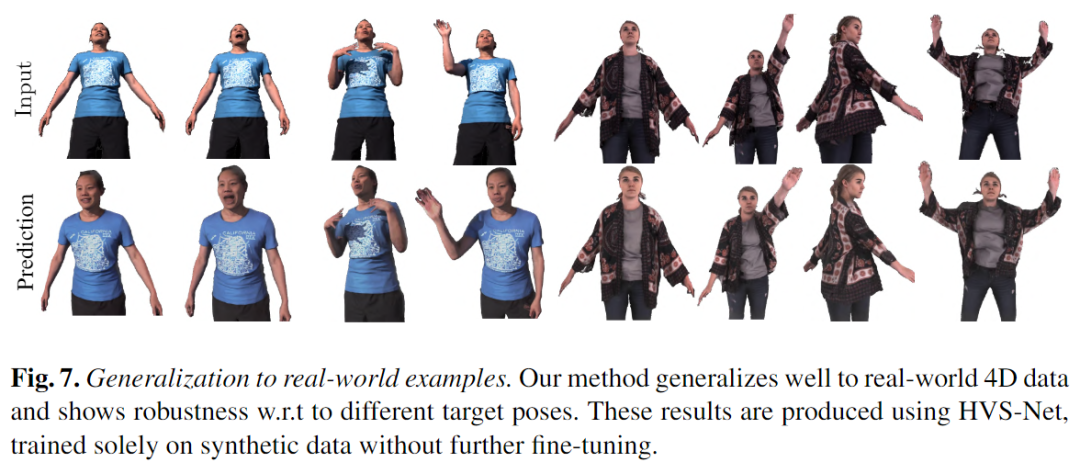

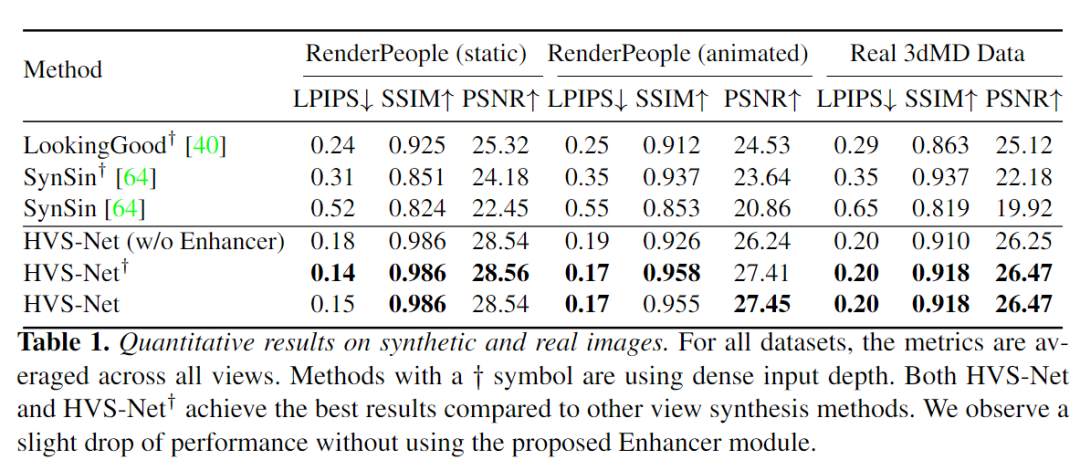

實驗結果顯示,該方法在單一稀疏的RGB-D輸入的情況下仍然可以生成高質量的合成和真實人類的新視圖,并且能夠泛化到未見過的新人物、新的姿勢并忠實地重建面部表情。

該方法不僅優于先前的人類視圖合成方法,而且對不同稀疏度的輸入都具有魯棒性。

一鍵生成虛擬化身

剛性物體(rigid objects)或動態場景的新視圖合成是最近非常活躍的研究課題,在各種任務中都取得了極大的性能提升。

但對運動中的人類的新視圖進行合成需要處理具有各種變形的動態場景的方法,特別是在那些具有精細細節的區域,如面部或衣服。

除此之外,常見的動態合成模型通常依賴于多視圖輸入,需要多個相機拍照,更多的相機參數,推理時間也很長(每幀可能需要幾分鐘)。

Meta提出的人類新視圖合成網絡HVS-Net僅使用一個消費級RGB-D傳感器就能生成高保真的衣著人類的渲染圖像。

網絡有如下5個設計目標:

1、在測試時能夠對新的人物進行泛化,無需重新訓練;

2、能夠處理訓練集中不包含的新姿勢;

3、無論是來自物體還是人物自身的遮擋,模型都應該能夠處理;

4、能夠捕捉面部表情;

5、給定一個單流、稀疏的RGB-D輸入,能夠實時生成高保真的圖像。

HVS-Net將人的上半身的單一稀疏RGB-D圖像和目標攝像機姿勢作為輸入,并從目標視角生成高分辨率的渲染。

與以前的方法相比,第一個關鍵區別是HVS-Net利用深度作為一個額外的輸入流。

雖然輸入的深度是稀疏的和有噪聲的,但它仍然使模型能夠利用輸入視圖中的信息,從而簡化了新視圖的合成。

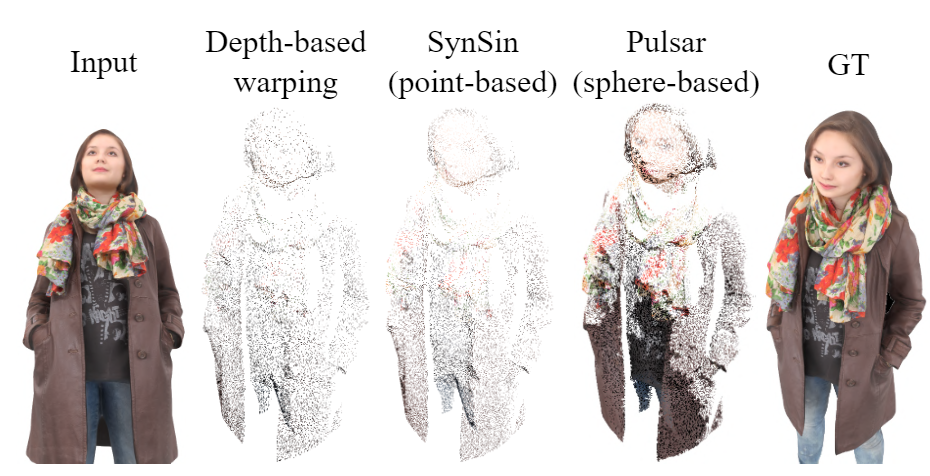

為了說明輸入的稀疏性,研究人員選擇了一個基于球體的神經渲染器,與簡單地從一個視圖到另一個視圖進行幾何扭曲相比,該渲染器使用一個能夠學習的半徑來創建一個更密集的、扭曲的圖像。

即使是被原始傳感器正確觀察到的像素也是稀疏的,從一個視角看兩個相鄰的像素,無論它們之間相差多少,只能得到它們各自深度的信號。

這也意味著,如果是從側面來看,兩個像素的深度差距會更大,但這些「間距」不是無限大的,所以可以通過基于球形的渲染器來解決這個問題。

考慮到從原始視點出發的每個像素的深度以及相機參數,這些點自然可以被投影到一個新的視圖,這也使得使用基于深度的扭曲或可微分的點或球體的渲染器是開發視圖合成的第一步的最佳選擇。投影的過程能夠自動糾錯(除了傳感器的噪聲),且不受訓練誤差的影響。

視圖合成模型生成目標視圖的稠密特征,并使用全局上下文繪畫網絡渲染來自目標攝像機視圖的結果RGB圖像。

當與編碼器-解碼器架構結合并進行端對端訓練時,該方法能夠合成未見過的個體的新視圖,并對主要輸入視圖中不可見的區域進行繪制。

雖然這種方法在最小的遮擋情況下效果很好,但在有嚴重遮擋的情況下,無論是人的手在身體前面移動或者拿著某個物體,都很難產生高質量的渲染。

因此,研究人員建議用戶額外輸入一個無遮擋圖像,并通過在兩個輸入之間建立精確的稠密對應關系,將其扭曲成目標的新視圖。

通過訓練一個緊湊的Enhancer網絡來完善最初估計的新視圖,預測新視圖和無遮擋圖像之間的對應關系,使用一個新的HD-IUV模塊對渲染圖進行精煉處理,可以呈現出更清晰的結果。

然后利用生成的圖像和ground-truth數據對之間的光度(photometric)損失來端到端地訓練整個pipeline

此外,模型還使用立體渲染來鼓勵近距離的視點之間的視圖一致的結果。

為了更好地訓練HVS-Net,還需要依靠高質量合成的人類掃描結果,從不同的角度進行捕捉動畫和渲染。

這項工作的一個關鍵貢獻是,模型可以很好地推廣到由3DMD掃描系統捕獲的真實數據,其面部或衣服的細節還原水平之高是前所未有的。

在實驗部分,研究人員僅使用合成數據集RenderPeople對該方法進行訓練,數據集中的人物穿著各種服裝,在某些情況下拿著杯子、袋子或手機等物體,雖然涵蓋了各式各樣的外觀和物體互動情況,但所有這些數據都是靜態的,所以姿勢空間的覆蓋率是不足的。

研究人員通過引入額外的姿勢變化來增強數據集,即對所有的網格進行非剛性配準(non-rigid registration)后使用一組預定義的動作將之制作成動畫。

最后使用Blender為每幀25個視圖合并一套高質量的標準RGB-D渲染圖以及對應的IUV圖。

除了合成測試集,研究人員還收集了一個真實世界的測試數據集,其中包括運動中的人物的3dMD 4D掃描圖。3dMD 4D掃描儀是一個全身掃描儀,可以在60Hz的頻率下捕獲未配準的體積點云。

真實數據集僅用作測試,以了解該方法在處理合成數據和真實數據之間的領域差距上的能力。

3dMD的數據不包括物體的相互作用,但一般來說噪聲比較多,而且有復雜的面部表情。

實驗結果證實了HVS-Net中球體半徑預測器的有效性,使得模型在輸入點云密度方面更加穩健。

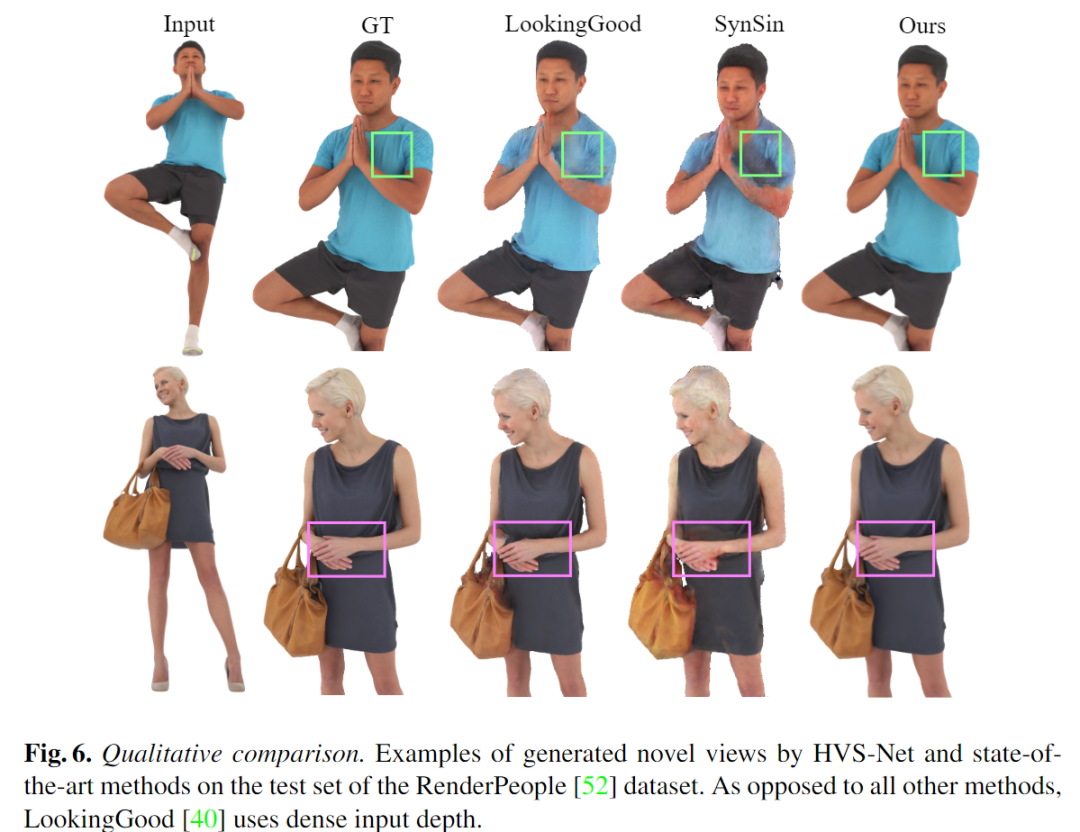

作為對比,盡管使用密集的深度圖作為LookingGood的輸入,但如果目標姿勢與輸入視點有很大偏差,該方法仍難以產生真實的結果,而SynSin不僅在遮擋區域表現不佳,而且在人的脖子周圍也產生了偽影。

相比之下,HVS-Net方法不僅能夠呈現可信的、真實的新視圖,而且還能創造出忠實于輸入視圖的視圖,重點是,HVS-Net在輸入信息更少的情況下對兩個主體的頭發進行相當準確的預測。