爭取盟友、洞察人心,最新的Meta智能體是個談判高手

長期以來,游戲一直是 AI 進步的試驗場——從深藍戰勝國際象棋大師 Garry Kasparov,到 AlphaGo 對圍棋的精通程度超越人類,再到 Pluribus 在撲克比賽中擊敗最厲害的玩家。但真正有用的、全能的智能體不能僅僅只會完棋盤游戲、移動移動棋子。有人不禁會問:我們能否建立一個更有效、更靈活的智能體,使其能夠像人類一樣使用語言進行談判、說服并與人合作,以實現戰略目標?

在游戲的歷史上,存在一款經典的桌面游戲 Diplomacy,很多人在第一次看到該游戲時,都會被它地圖式的棋盤嚇一跳。以為它是一個復雜的戰爭游戲。其實不然,這是一款需要調動語言爭取盟友的游戲,遷涉到決策與談判協商,玩者之間有大量的交流,贏得游戲的關鍵在人與人之間的互動。

現在 Meta 向這一游戲發起了挑戰,他們構建的智能體 CICERO,成為首個在 Diplomacy 中達到人類水平的 AI。CICERO 通過在在線版本 webDiplomacy.net 上證明了這一點,其中 CICERO 的平均得分是人類玩家的兩倍多,并且在玩過不止一場游戲的參與者中排名前 10%。

- 論文地址:https://www.science.org/doi/10.1126/science.ade9097

- 主頁地址:https://ai.facebook.com/research/cicero/diplomacy/

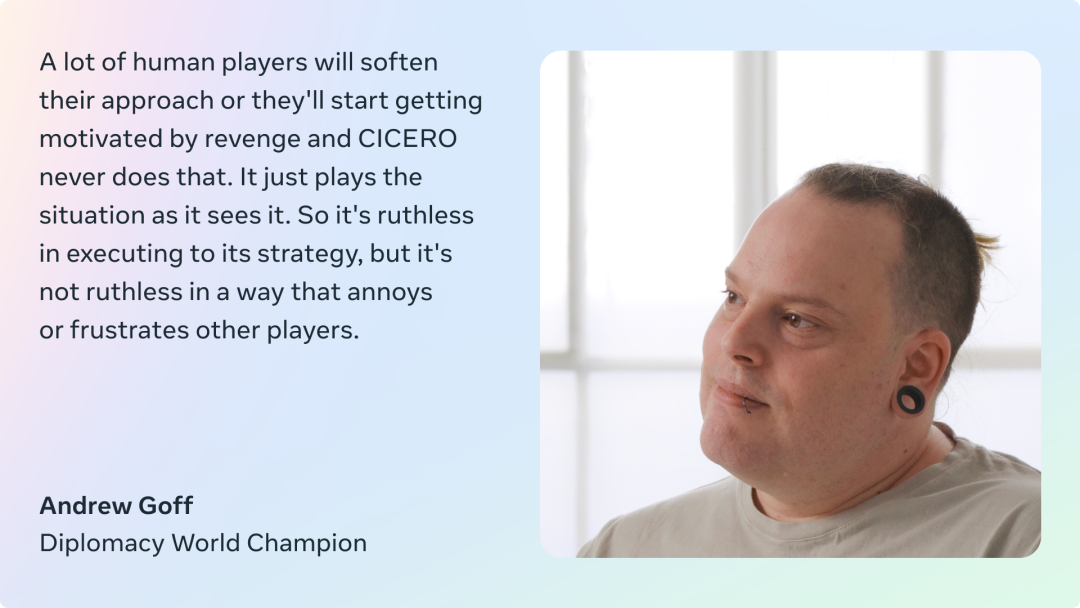

幾十年來,Diplomacy 一直被視為 AI 領域中不可逾越的巨大挑戰,因為這款游戲要求玩家理解他人的動機和觀點,需要制定復雜計劃,調整策略,并在此基礎上使用自然語言與他人達成協議,說服別人結成伙伴關系和聯盟等。這些對智能體來說還是比較困難的,而 CICERO 在使用自然語言與 Diplomacy 玩家進行談判方面還是非常有效的。

與國際象棋和圍棋不同的是,Diplomacy 是一款關于人而不是棋子的游戲。如果智能體無法識別對手是在虛張聲勢,還是真正的發起破壞,它就會很快輸掉比賽。同樣,如果智能體不能像人一樣交流,表現出同理心,與別人建立關系,對游戲侃侃侃談——它就找不到其他愿意與它合作的玩家。

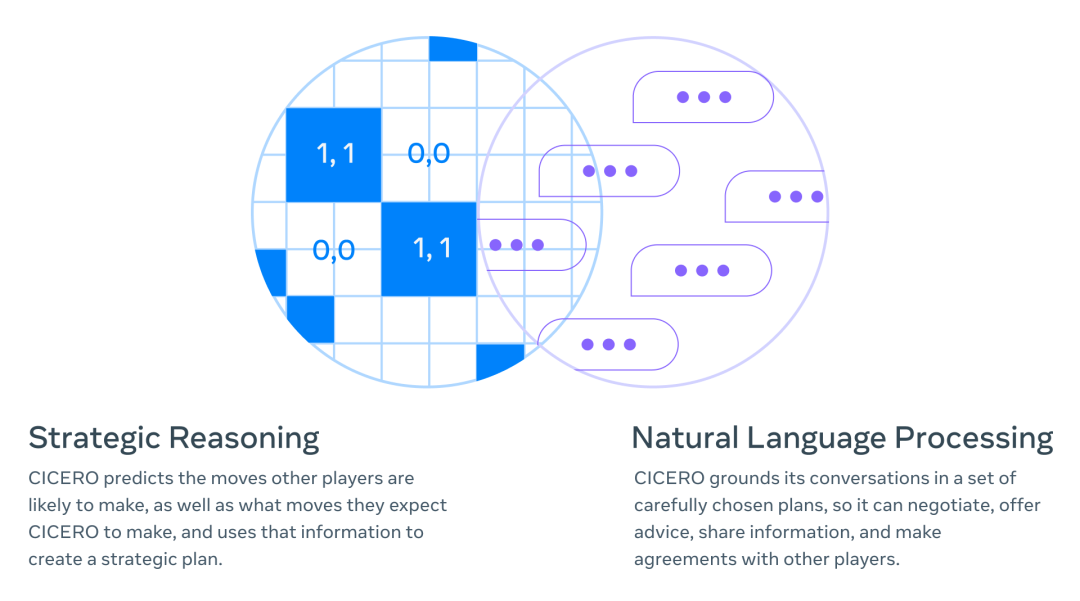

Meta 的這項研究將戰略推理(如 AlphaGo、Pluribus)與自然語言處理( 例如 GPT-3、 BlenderBot 3、LaMDA、OPT-175B)進行了結合。例如,在游戲后期,CICERO 推斷出它將需要一個特定玩家的支持,然后 CICERO 會制定一個策略來贏得這個人的青睞。

如何構建 CICERO

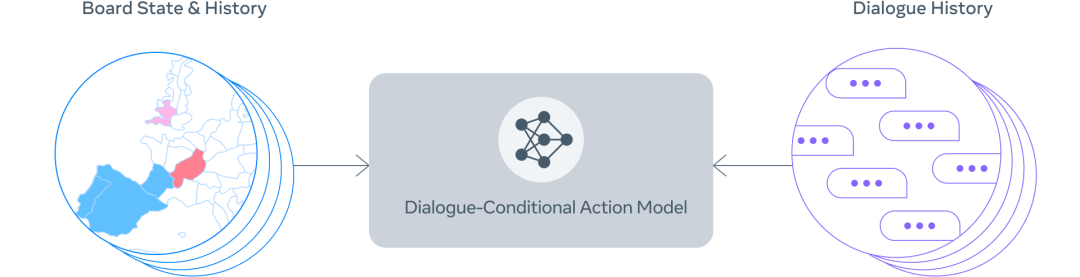

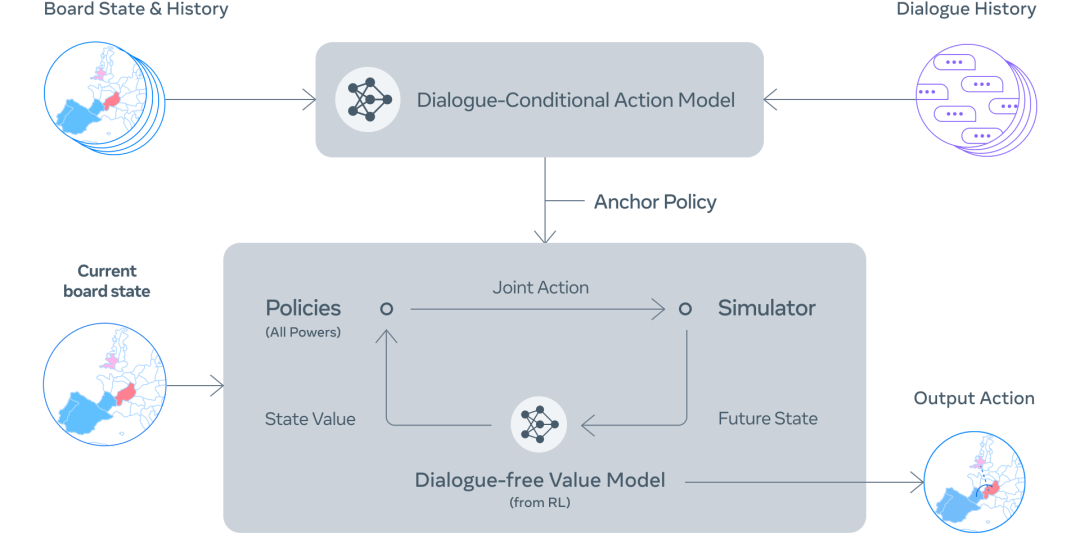

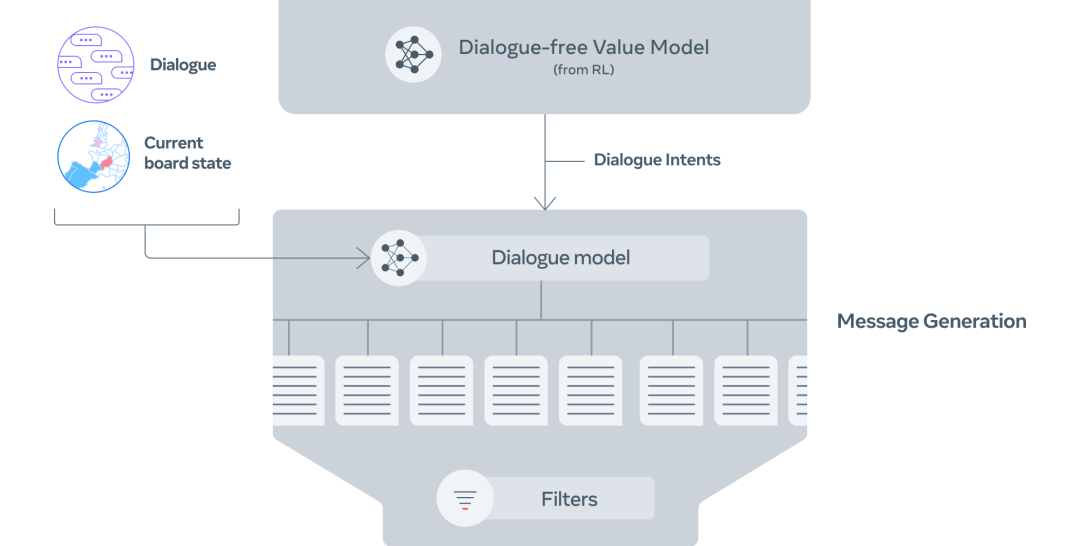

CICERO 的核心是一個可控的對話模型和一個戰略推理引擎。在游戲的每一點,CICERO 都會查看 game board 及其對話歷史,并對其他玩家可能采取的行動進行建模。然后制定計劃來控制語言模型,將它的計劃告知其他玩家,并為與他們協調良好的其他玩家提出合理的行動建議。

可控對話?

為了構建一個可控對話模型,Meta 從一個具有 27 億參數的類 BART 語言模型開始,并在來自互聯網的文本上進行了預訓練,還在 webDiplomacy.net 上對 40000 多個人類游戲進行了微調。

實現過程主要分為以下幾步:

Step 1:根據 board state 和當前對話,CICERO 對每個人將做出什么給出初步預測。

Step 2:CICERO 迭代地改進初步預測,然后使用改進預測為自己和合作伙伴形成一個意圖。

Step 3:根據 board state、對話和意圖生成多條候選消息。

?

Step 4:過濾候選消息,最大化值,并確保彼此之間的意圖一致。

研究者利用一些過濾機制進一步提高對話質量,比如用訓練過的分類器來區分人類和模型生成的文本以確保——對話是合理的,與當前游戲狀態和以前的信息一致,并且在戰略上是合理的。

對話意識戰略和規劃

在涉及合作的游戲中,智能體需要學會模擬人類在現實生活中實際會做什么,而不是將人類看作機器,讓智能體指揮他們應該做什么。因此,Meta 希望 CICERO 制定的計劃與其他參與者的對話保持一致。

?

?

人類建模的經典方法是監督學習,即用標記的數據(如過去游戲中人類玩家的行動數據庫)來訓練智能體。然而,純粹依靠監督學習來選擇基于過去對話的行動,會導致智能體相對較弱,而且很容易被利用。例如,一個玩家可以告訴智能體「我很高興我們同意你將把你的部隊從巴黎移走!」由于類似的信息只有在達成協議時才會出現在訓練數據中,因此智能體可能真的會將其部隊調離巴黎,即使這樣做是一個明顯的戰略失誤。

為了解決這個問題,CICERO 運行一個迭代規劃算法,以平衡對話的一致性和合理性。智能體首先根據它與其他玩家的對話預測每個人在當前回合的策略,同時也預測其他玩家認為智能體的策略將會是什么。然后,它將運行名為「piKL」的規劃算法,該算法通過嘗試選擇在其他玩家預測的策略下具有更高期望值的新策略,來迭代改進這些預測,同時也嘗試使新的預測接近于原始策略預測。研究者發現,與單純的監督學習相比,piKL 能更好地模擬人類游戲,并為智能體帶來更好的策略。

? ?

?

生成自然的、目的型的對話

在 Diplomacy 中,玩家如何與他人交談甚至比他們如何移動棋子更重要。CICERO 在與其他玩家制定戰略時,能夠清楚地、有說服力地交流。例如,在一個 demo 中,CICERO 要求一個玩家立即在棋盤的某個部分提供支持,同時向另一個玩家施加壓力讓其在游戲的后期考慮結盟。

交流中,CICERO 試圖通過向三個不同的玩家提出行動建議來執行其戰略。在第二次對話中,智能體能夠告訴其他玩家為什么他們應該合作,以及它將如何對雙方有利。在第三次對話中,CICERO 既在征求信息,也在為未來的行動打下基礎。

不足之處

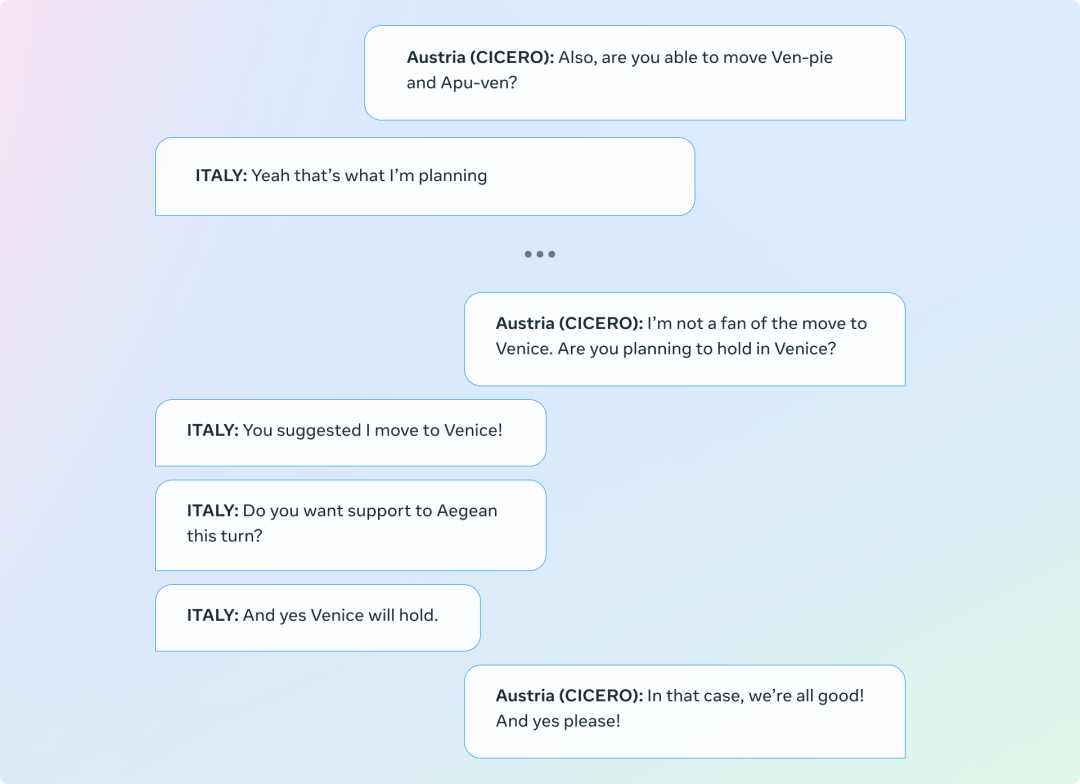

必須承認,CICERO 有時也會產生不一致的對話,從而破壞其目標。在下面的例子中,CICERO 扮演的是奧地利,但智能體要求意大利轉移到威尼斯,與它的第一個信息相矛盾。

讓「Diplomacy」推進人類與 AI 互動的沙盒

在一個既涉及合作又涉及競爭的游戲中,出現了以目標為導向的對話系統,對于使 AI 與人類的意圖和目標相一致方面,這提出了重要的社會和技術挑戰。「Diplomacy」為研究這個問題提供了一個特別有趣的環境,因為玩這個游戲需要與沖突的目標搏斗,并將這些復雜的目標轉化為自然語言。舉個簡單的例子,玩家可能會選擇在短期利益上做出妥協來維持和一個盟友的關系,因為這個盟友有可能在下一回合幫助他們進入一個更好的位置。

雖然 Meta 在這項工作中取得了重大進展,但將語言模型與具體意圖有力地結合起來的能力,以及決定這些意圖的技術(和規范)挑戰仍然是重要的問題。通過開源 CICERO 代碼,Meta 希望 AI 研究人員能夠以負責任的方式繼續在這一工作基礎上發展。團隊表示:「通過使用對話模型進行零樣本分類,我們已經在這個新領域中邁出了檢測和刪除有害信息的早期步驟。我們希望「Diplomacy」可以作為一個安全的沙盒來推進人與 AI 互動的研究。」

未來方向

雖然目前 CICERO 只能夠玩 Diplomacy 游戲,但這一成就背后的技術與許多現實世界的應用有關。例如,通過規劃和 RL 控制自然語言的生成,可以緩解人類和 AI 驅動的智能體之間的溝通障礙。

例如,今天的人工智能助手擅長回答簡單的問題,比如告訴你天氣,但如果他們能保持長期的對話,以教你一個新技能為目標呢?

另外,想象一個視頻游戲,其中 NPC 可以像人一樣計劃和交談—理解你的動機并相應地調整對話,幫助你完成攻打城堡的任務。

這些「夢想」,未來或許都能走進現實。