阿里「殺手锏」級語音識別模型來了!推理效率較傳統模型提升10倍,已開源

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

阿里達摩院,又搞事兒了。

這兩天,它們發布了一個全新的語音識別模型:

Paraformer。

開發人員直言不諱:這是我們“殺手锏”級的作品。

——不僅識別準確率“屠榜”幾大權威數據集,一路SOTA,推理效率上相比傳統模型,也最高可提升10倍。

值得一提的是,Paraformer剛宣布就已經開源了。

語音輸入法、智能客服、車載導航、會議紀要等場景,它都可以hold住。

怎么做到的?

Paraformer:從自回歸到非自回歸

我們知道語音一直是人機交互重要研究領域。

而當前語音識別基礎框架已從最初復雜的混合語音識別系統,演變為高效便捷的端到端語音識別系統。

其中最具代表性的模型當屬自回歸端到端模型Transformer,它可以在識別過程中需逐個生成目標文字,實現了較高準確率。

不過Transformer計算并行度低,無法高效結合GPU進行推理。

針對該問題,學術界近年曾提出并行輸出目標文字的非自回歸模型。

然而這種模型也存在著建模難度和計算復雜度高,準確率有待提升的問題。

達摩院本次推出的Paraformer,首次在工業級應用層面解決了端到端識別效果與效率兼顧的難題。

它屬于單輪非自回歸模型。

對于這一類模型,現有工作往往聚焦于如何更加準確地預測目標文字個數,如較為典型的Mask CTC,采用CTC預測輸出文字個數。

但考慮到現實應用中,語速、口音、靜音以及噪聲等因素的影響,如何準確的預測目標文字個數以及抽取目標文字對應的聲學隱變量仍然是一個比較大的挑戰。

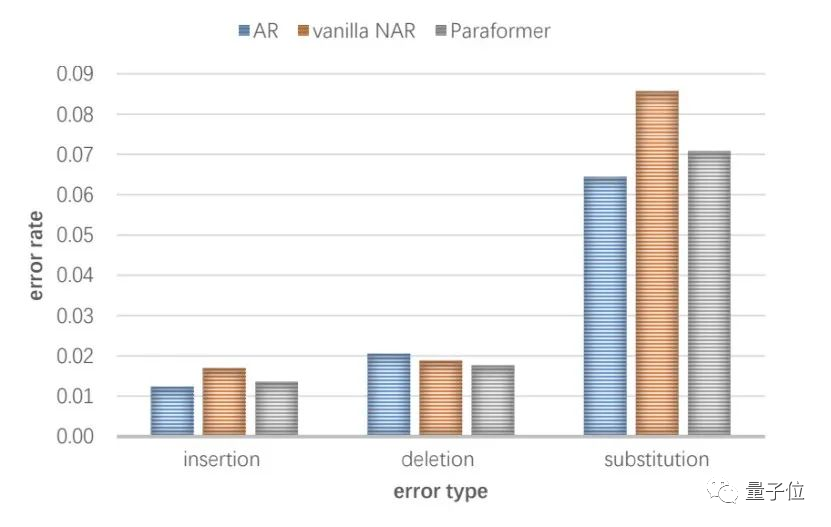

另外一方面,通過對比自回歸模型與單輪非自回歸模型在工業大數據上的錯誤類型(如下圖所示,AR與vanilla NAR),大家發現相比于自回歸模型,非自回歸模型在預測目標文字個數(插入錯誤+刪除錯誤)方面差距較小,但是替換錯誤顯著的增加。

阿里達摩院認為這是由于單輪非自回歸模型中條件獨立假設導致的語義信息丟失。與此同時,目前非自回歸模型主要停留在學術驗證階段,還沒有工業大數據上的相關實驗與結論。

Paraformer是如何做的呢?

針對第一個問題,阿里達摩院采用一個預測器(Predictor)來預測文字個數并通過Continuous integrate-and-fire (CIF)機制來抽取文字對應的聲學隱變量。

針對第二個問題,受啟發于機器翻譯領域中的Glancing language model(GLM),他們設計了一個基于GLM的 Sampler模塊來增強模型對上下文語義的建模。

除此之外,團隊還設計了一種生成負樣本策略來引入MWER區分性訓練。

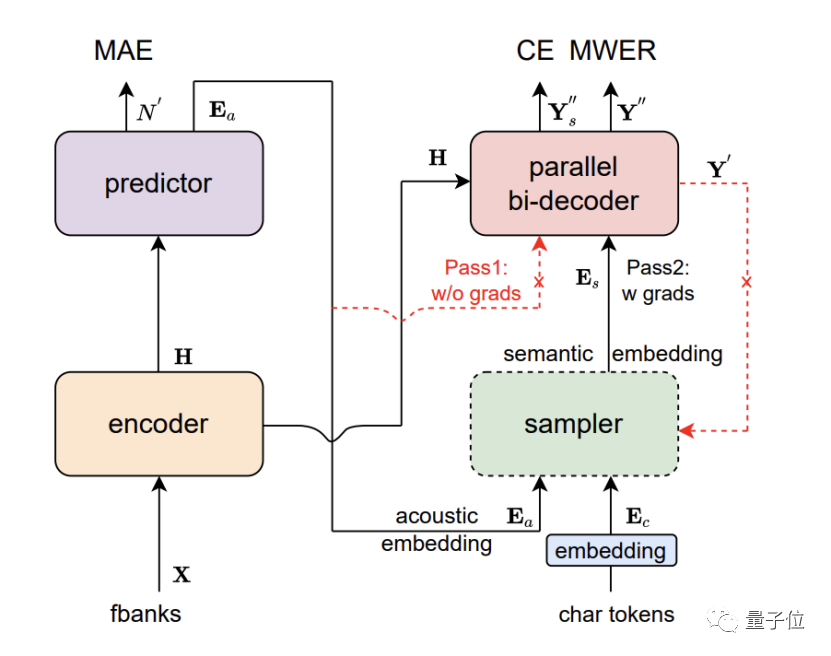

最終,Paraformer由Encoder、Predictor、Sampler、Decoder與Loss function五部分組成。

核心點主要包含以下幾點:

- Predictor模塊:基于CIF 的Predictor 預測語音中目標文字個數以及抽取目標文字對應的聲學特征向量;

- Sampler:通過采樣,將聲學特征向量與目標文字向量變換成含有語義信息的特征向量,配合雙向的Decoder來增強模型對于上下文的建模能力;

- 基于負樣本采樣的MWER訓練準則。

效果SOTA,推理效率最高提10倍

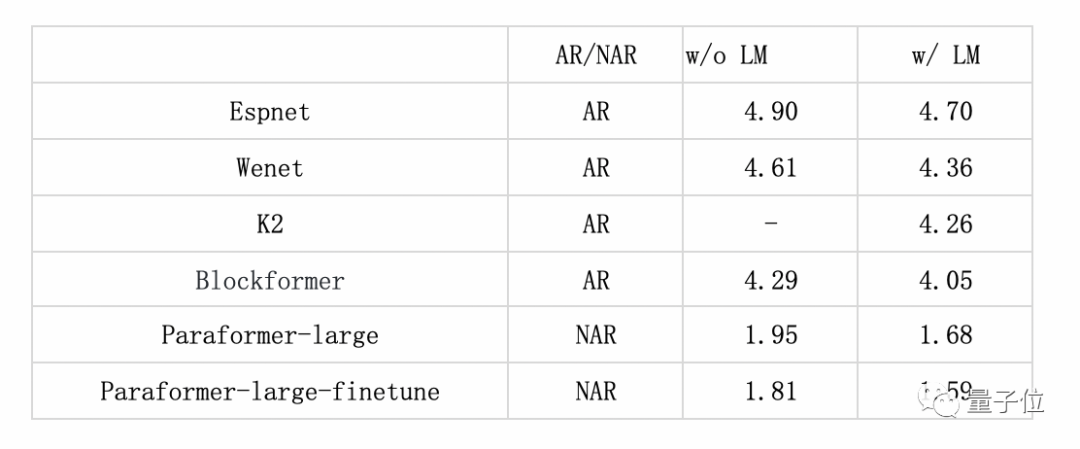

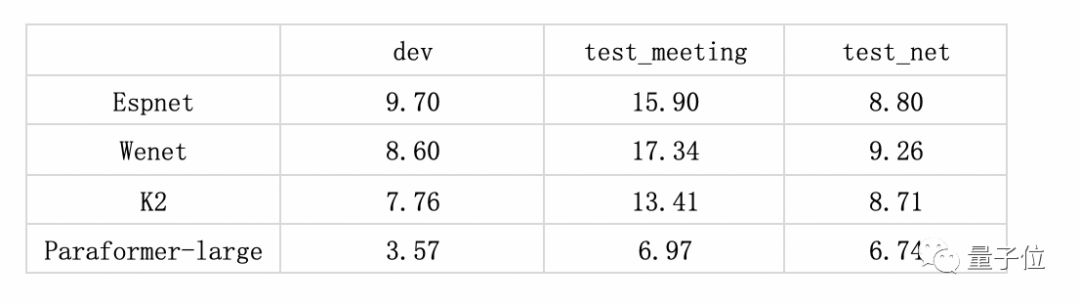

最終,在學術界常用的中文識別評測任務AISHELL-1、AISHELL-2及WenetSpeech等測試集上, Paraformer-large模型均獲得了最優效果。

在AISHELL-1上,Paraformer在目前公開發表論文中,為性能(識別效果&計算復雜度)最優的非自回歸模型,且Paraformer-large模型的識別準確率遠遠超于目前公開發表論文中的結果(dev/test:1.75/1.95)。

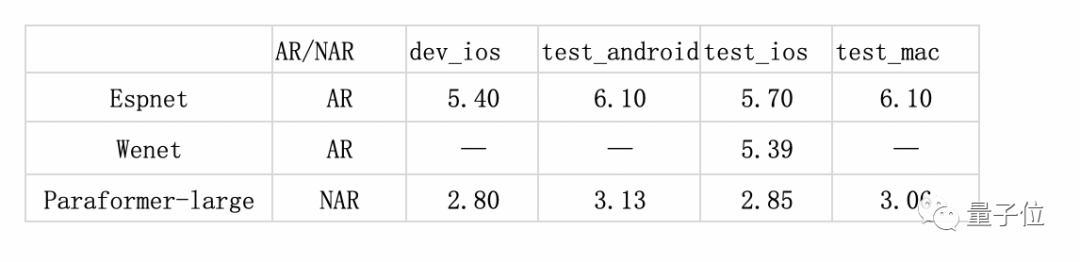

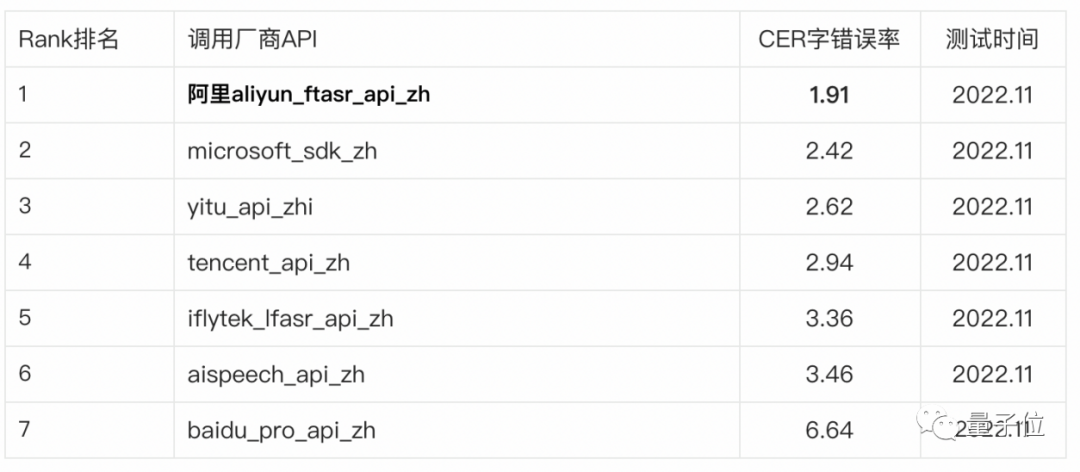

在專業的第三方全網公共云中文語音識別評測SpeechIO TIOBE白盒測試中,Paraformer-large識別準確率超過98%,是目前公開測評中準確率最高的中文語音識別模型。

配合GPU推理,不同版本的Paraformer可將推理效率提升5~10倍。

同時,Paraformer使用了6倍下采樣的低幀率建模方案,可將計算量降低近6倍,支持大模型的高效推理。

體驗地址:?https://www.modelscope.cn/models/damo/speech_paraformer-large_asr_nat-zh-cn-16k-common-vocab8404-pytorch/summary?

論文地址:??https://arxiv.org/abs/2206.08317