在 CARLA自動駕駛模擬器中添加真實智體行為

arXiv論文“Insertion of real agents behaviors in CARLA autonomous driving simulator“,22年6月,西班牙。

由于需要快速prototyping和廣泛測試,仿真在自動駕駛中的作用變得越來越重要。基于物理的模擬具有多種優勢和益處,成本合理,同時消除了prototyping、駕駛員和弱勢道路使用者(VRU)的風險。

然而,主要有兩個局限性。首先,眾所周知的現實差距是指現實和模擬之間的差異,阻礙模擬自主駕駛體驗去實現有效的現實世界性能。其次,缺乏關于真實智體(人類)行為的實證知識,包括后補司機或乘客以及其他道路使用者,如車輛、行人或自行車手。

智體模擬通常是預編程確定、概率隨機或基于真實數據生成的,但并不表示與特定模擬場景交互的真實智體行為。本文提出一個初步框架,實現真實智體和模擬環境(包括自主車輛)之間的實時交互,并從多個視圖的模擬傳感器生成合成序列數據,用于訓練依賴行為模型的預測系統。

該方法將沉浸式虛擬現實(VR)和人體運動捕捉(HMC)系統與CARLA集成,用于自動駕駛。其中描述硬件和軟件架構,并討論所謂的行為差距。

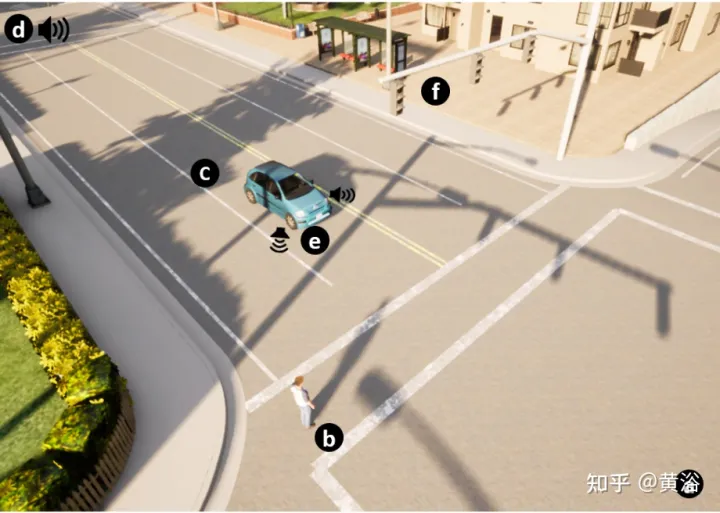

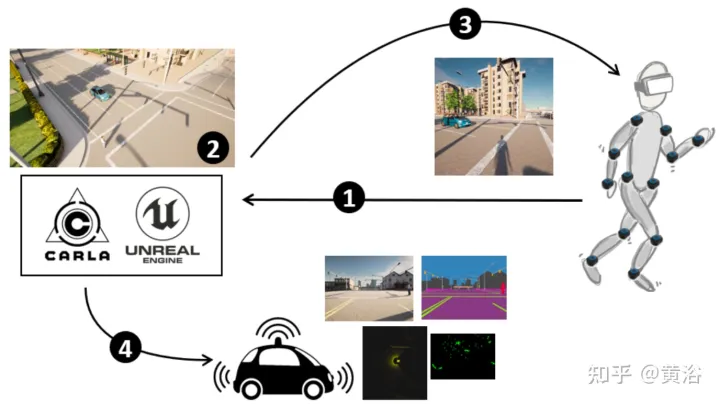

如圖所示是該方法概覽:(1) CARLA- UE配有頭部(VR耳機)和身體(動作捕捉系統)姿勢。(2) 生成場景,包括自動駕駛車輛和數字化的行人。(3) 為行人提供環境(通過VR耳機)。(4) 自動車輛傳感器感知環境,包括行人。

下面介紹CARLA自動駕駛模擬器中浸入式VR系統的功能。

通過利用UE4提供的功能和外部硬件(如VR眼鏡和一組運動傳感器)進行行為和交互研究,實現完全行人浸入。

CARLA開源模擬器是在UE4上實現的,UE4提供了高質量的渲染、逼真的物理環境和互操作插件的生態系統。CARLA模擬動態交通場景,并提供UE4創建的虛擬世界與場景內運行的道路智體之間的接口。CARLA被設計成一個服務器-客戶端系統來實現這一點,服務器運行模擬程序并渲染場景。客戶端和服務器之間的通信通過sockets完成。

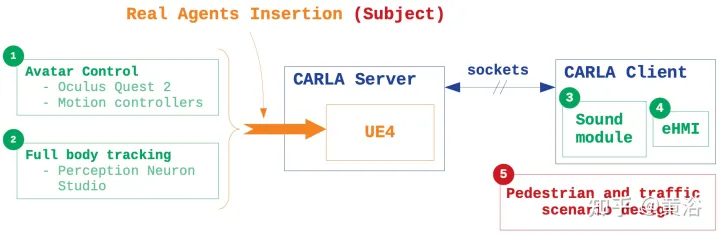

在模擬中插入真實智體行為的主要特征基于五點(如圖所示):1)Avatar控制:CARLA blueprint庫,收集所有角色和屬性的架構,修改行人blueprint,在人和虛擬世界之間創建浸入可移動的VR界面;2) 身體跟蹤:用一組慣性傳感器和專有的外部軟件通過真實場景捕捉主體運動以及運動感知,通過.bvh文件將Avatar的運動集成到模擬器中;3) 聲音設計:由于CARLA是一個無音頻模擬器,在環境中引入位置聲音,增強沉浸感;4) eHMI集成:實現自動駕駛車輛狀態和意圖信息的通信,做交互研究;5) 場景模擬:在CARLA客戶端內設計交通場景,控制車輛和行人的行為。

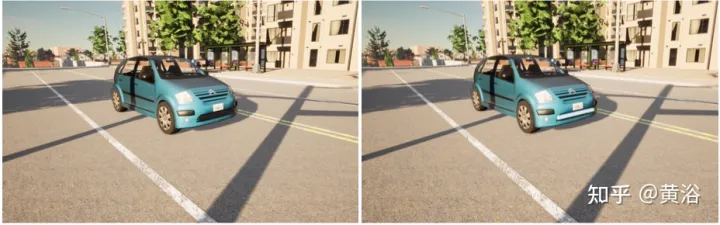

道路使用者之間的通信是交通環境中的一個重要因素。實驗中為自動駕駛車輛提供了外部人機界面(eHMI),將其狀態和意圖傳達給實際道路使用者。

如圖所示,提出的eHMI設計由沿汽車前部的光帶組成。左圖無eHMI,右圖帶eHMI。這可以研究當行人軌跡與虛擬場景車輛軌跡匯聚時,界面對決策的影響。

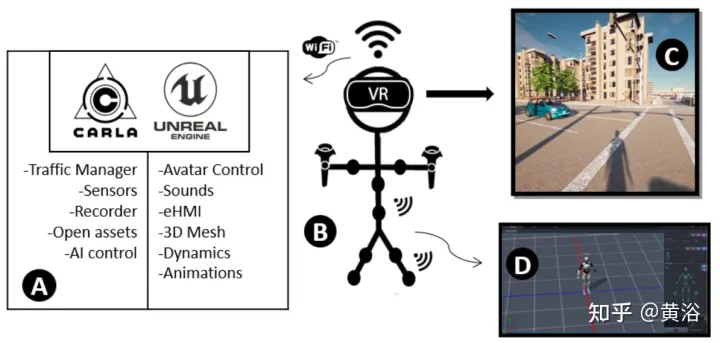

整個系統架構如圖:

CARLA提供了不同的選項來模擬交通和特定的交通場景。用交通管理模塊填充具有真實城市交通狀況的模擬。每輛車的控制在特定線程執行。通過同步消息傳遞管理與其他層的通信。

通過設置強制特定行為參數來控制交通流。例如,可以允許汽車超速、忽略紅綠燈條件、忽略行人或強制改變車道。

主體集成到包括一個城市3-D模型地圖的模擬器。每個地圖都基于一個OpenDRIVE文件,描述完整注釋的道路布局。該功能允許設計自己的地圖,在真實和虛擬環境中再現相同的流量場景,評估模擬器真實行為的集成,并能夠通過比較交互結果來進行現場研究。

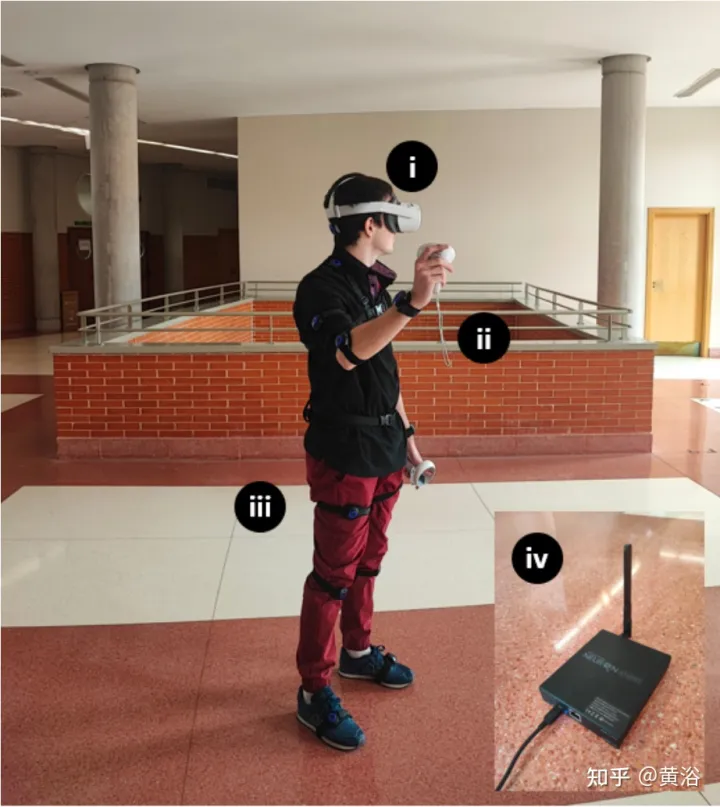

硬件設置如圖:在實驗過程中,用Oculus Quest 2作頭戴式設備(HMD),Meta創建,6GB RAM處理器、兩個可調1832 x 1920透鏡、90Hz刷新率和256 GB的內存。Quest 2具有Wi-Fi 6、藍牙5.1和USB Type-C連接、SteamVR支持和3D揚聲器。對于全身跟蹤,用帶有慣性跟蹤器的PNS封裝解決方案。該套件包括獨立的VR耳機、2個運動控制器、17個Studio慣性人體傳感器、14組straps、1個充電箱和1個Studio收發器。

由于CARLA build和Quest 2僅依賴Windows,VR Immersion System目前依賴UE4.24和Windows 10操作系統。用TCP sockets插件,編輯器的所有參與者位置和其他有用參數從Python API發送,集成每個參與者的聲音或自動駕駛車輛的eHMI。”VR Preview”在HMD啟動游戲。Perception Neuron Studio與Axis Studio合作,Axis Studio一次支持最多3個主題,同時支持23個身體和手指傳感器。

如圖是交互交通狀況的模擬:(a) 3D世界設計。(b) 行人匹配執行者Avatar。(c) 自動駕駛汽車。(d) 環境聲音和智體聲音。(e) eHMI。(f) 交通燈和交通標志。