國產AI服務器產品、技術及分類

本文參考自“專題研究:ChatGPT服務器,深度拆解”,詳細介紹了AI服務器分類,主要技術和廠商產品,第一篇參考文章“ChatGPT服務器,深度拆解(2023)”。

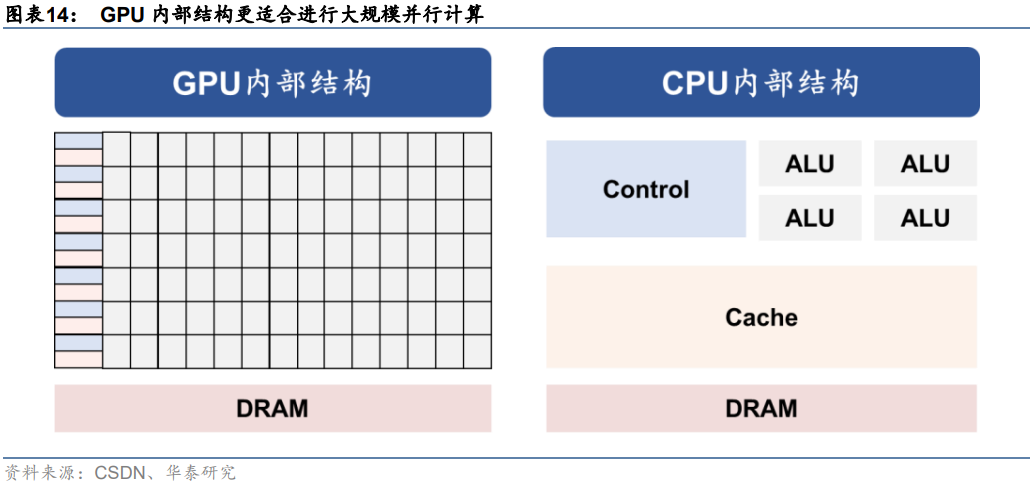

AI服務器采取GPU架構,相較CPU更適合進行大規模并行計算。通用服務器采用CPU作為計算能力來源,而AI服務器為異構服務器,可以根據應用范圍采用不同的組合方式,如CPUGPU、CPUTPU、CPU其他加速卡等,主要以GPU提供計算能力。

從ChatGPT模型計算方式來看,主要特征是采用了并行計算。對比上一代深度學習模型RNN來看,Transformer架構下,AI模型可以為輸入序列中的任何字符提供上下文,因此可以一次處理所有輸入,而不是一次只處理一個詞,從而使得更大規模的參數計算成為可能。而從GPU的計算方式來看,由于GPU采用了數量眾多的計算單元和超長的流水線,因此其架構設計較CPU而言,更適合進行大吞吐量的AI并行計算。

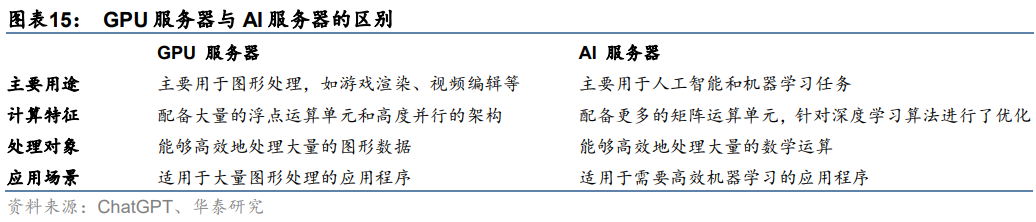

深度學習主要進行矩陣向量計算,AI服務器處理效率更高。從ChatGPT模型結構來看,基于Transformer架構,ChatGPT模型采用注意力機制進行文本單詞權重賦值,并向前饋神經網絡輸出數值結果,這一過程需要進行大量向量及張量運算。而AI服務器中往往集成多個AI GPU,AI GPU通常支持多重矩陣運算,例如卷積、池化和激活函數,以加速深度學習算法的運算。因此在人工智能場景下,AI服務器往往較GPU服務器計算效率更高,具備一定應用優勢。

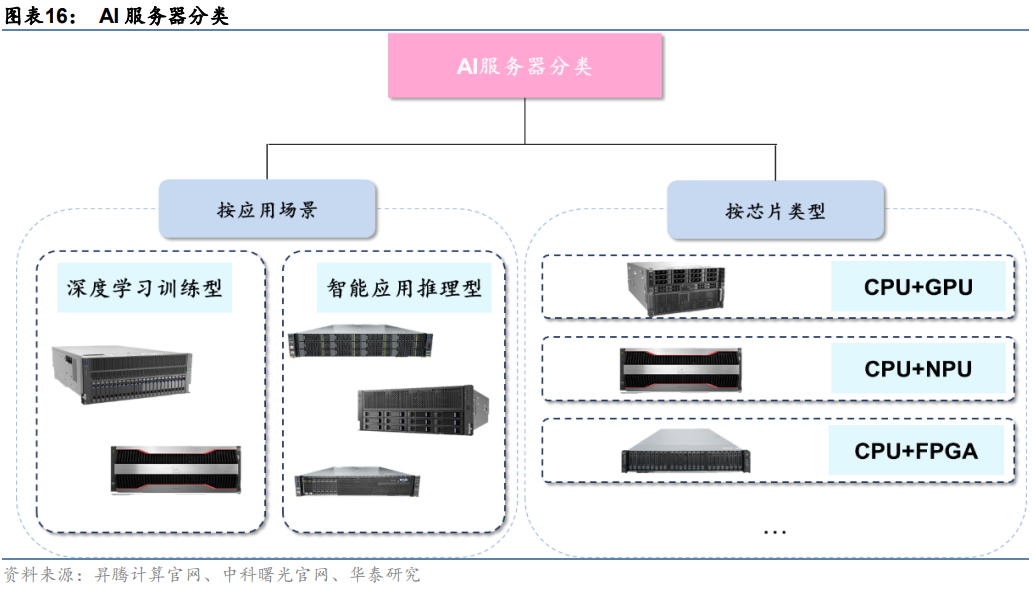

AI服務器分類方式有兩種:

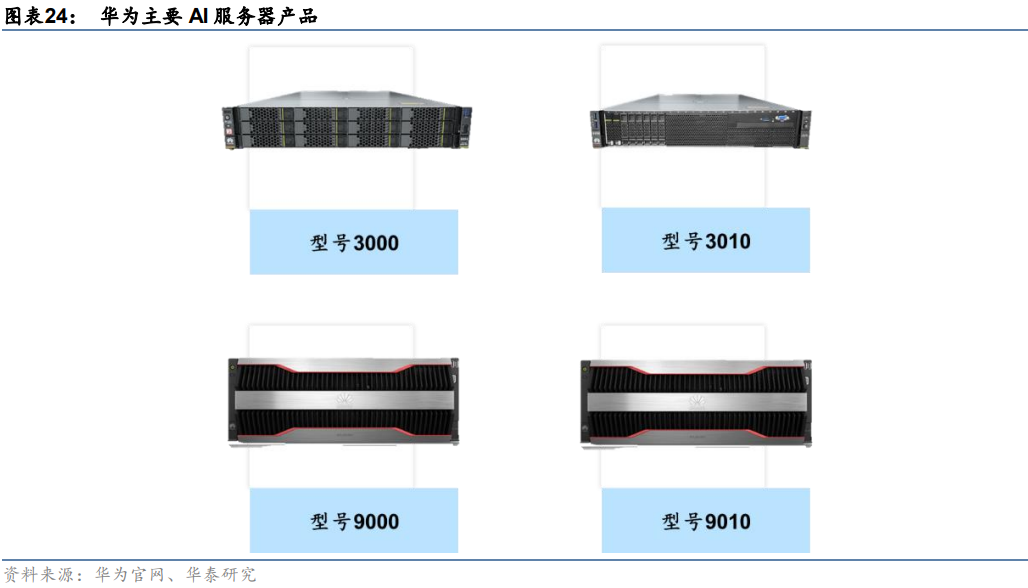

1)按應用場景:AI服務器按照應用場景可以分為深度學習訓練型和智能應用推理型。訓練任務對服務器算力要求較高,需要訓練型服務器提供高密度算力支持,典型產品有中科曙光X785-G30和華為昇騰Atlas 800(型號9000、型號9010)。推理任務則是利用訓練后的模型提供服務,對算力無較高要求,典型產品有中科曙光X785-G40和華為昇騰Atlas 800(型號3000、型號3010)。

2)按芯片類型:AI服務器為異構服務器,可以根據應用范圍調整計算模塊結構,可采用CPU+GPU、CPU+FPGA、CPU+TPU、CPU+ASIC或CPU+多種加速卡等組合形式。目前,產品中最常見的是CPU+多塊GPU的方式。

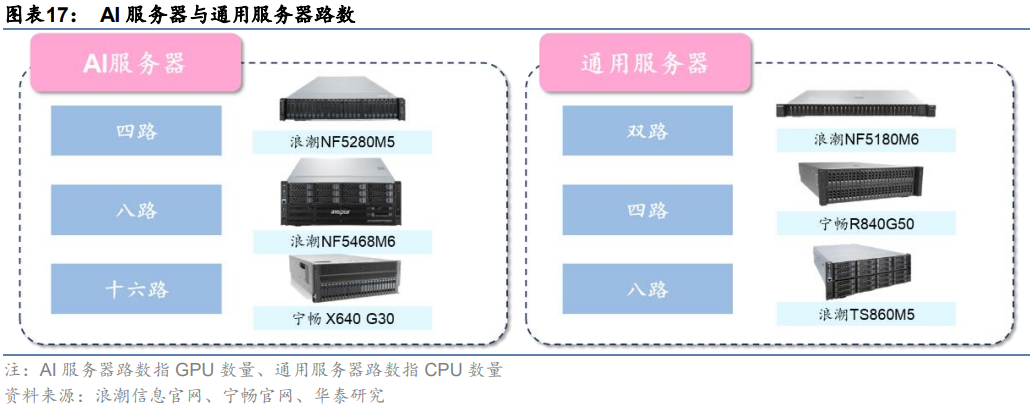

常見的AI服務器分為四路、八路、十六路。一般來說,通用服務器主要采用以CPU為主導的串行架構,更擅長邏輯運算;而AI服務器主要采用加速卡為主導的異構形式,更擅長做大吞吐量的并行計算。按CPU數量,通用服務器可分為雙路、四路和八路等。雖然AI服務器一般僅搭載1-2塊CPU,但GPU數量顯著占優。按GPU數量,AI服務器可以分為四路、八路和十六路服務器,其中搭載8塊GPU的八路AI服務器最常見。

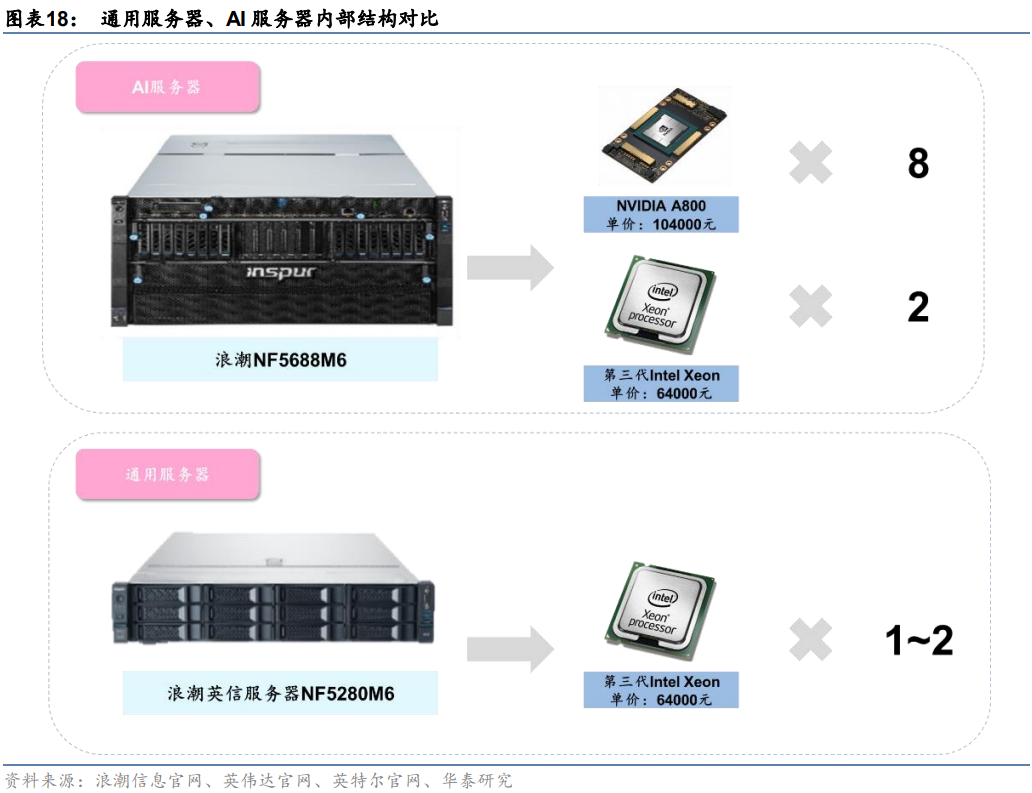

AI服務器采用多芯片組合,算力硬件成本更高。我們以典型服務器產品為例拆解硬件構成,可以更清晰地理解兩類服務器硬件架構區別:以浪潮通用服務器NF5280M6為例,該服務器采用1~2顆第三代Intel Xeon可擴展處理器,據英特爾官網,每顆CPU售價約64000萬元,故該服務器芯片成本約64000~128000;以浪潮AI服務器NF5688M6為例,該服務器采用2顆第三代Intel Xeon可擴展處理器+8顆英偉達A800 GPU的組合,據英偉達官網,每顆A800售價104000元,故該服務器芯片成本約96萬元。

GPT模型訓練需要大算力支持,或將帶來AI服務器建設需求。我們認為,隨著國內廠商陸續布局ChatGPT類似產品,GPT大模型預訓練、調優及日常運營或將帶來大量算力需求,進而帶動國內AI服務器市場放量。

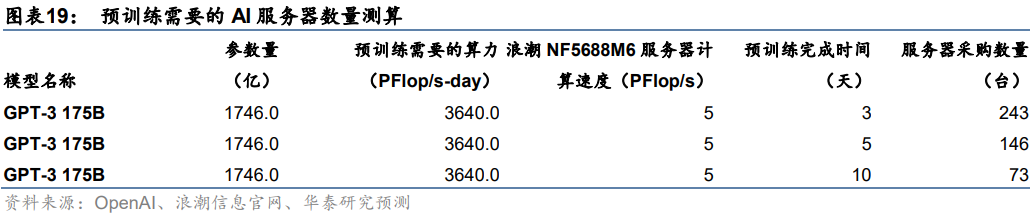

以GPT-3 175B模型預訓練過程為例,據OpenAI,進行一次GPT-3 175B模型的預訓練需要的算力約3640 PFlop/s-day。我們假設以浪潮信息目前算力最強的AI服務器NF5688M6(PFlop/s)進行計算,在預訓練期限分別為3、5、10天的假設下,單一廠商需采購的AI服務器數量分別為243、146、73臺。

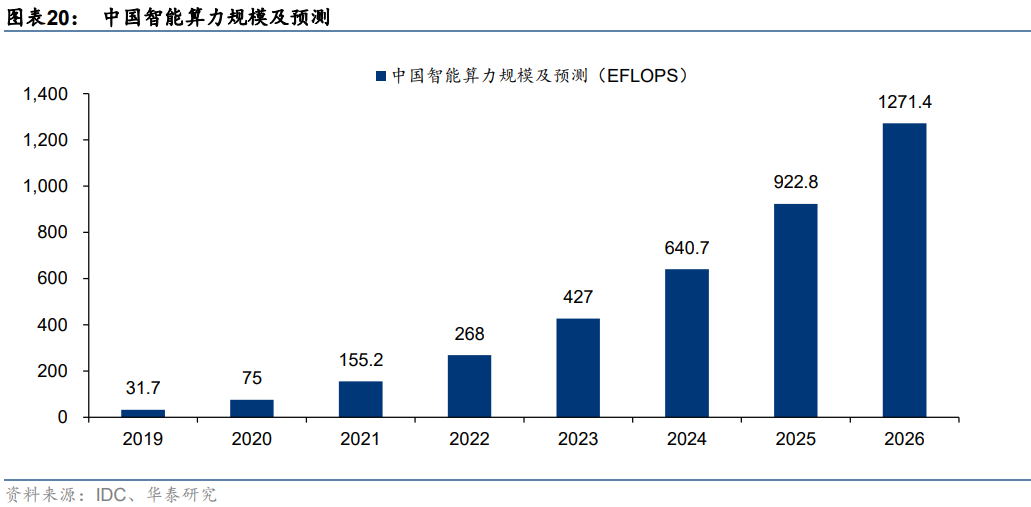

AI大模型訓練需求火熱,智能算力規模增長有望帶動AI服務器放量。據IDC數據,以半精度(FP16)運算能力換算,2021年中國智能算力規模約155.2EFLOPS。隨著AI模型日益復雜、計算數據量快速增長、人工智能應用場景不斷深化,未來國內智能算力規模有望實現快速增長。IDC預計2022年國內智能算力規模將同比增長72.7%至268.0 EFLOPS,預計2026年智能算力規模將達1271.4 EFLOPS,2022-2026年算力規模CAGR將達69.2%。我們認為,AI服務器作為承載智能算力運算的主要基礎設施,有望受益于下游需求放量。

國產廠商布局豐富產品矩陣,占據全球AI服務器市場領先地位

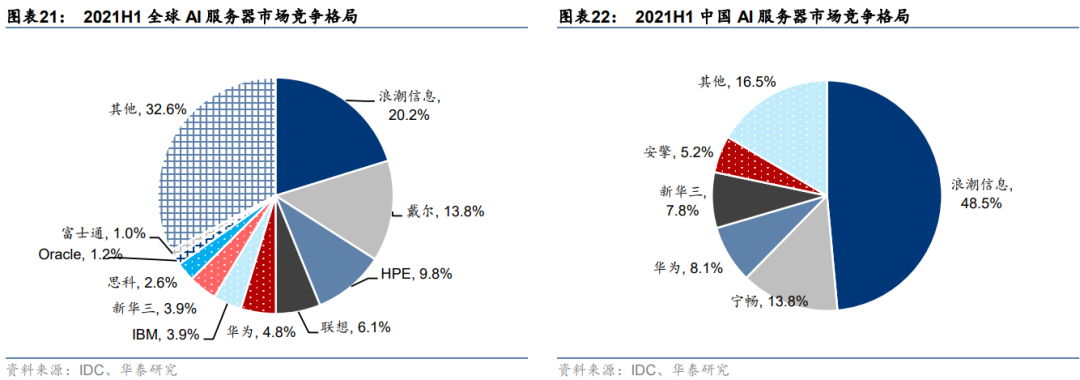

浪潮信息、聯想、華為等國產廠商在全球AI服務器市場占據領先地位。全球市場來看,AI服務器市場份額TOP10廠商中,國產廠商占據4席,累計市場份額超35%,其中浪潮信息以20.2%的份額排名第一。國內市場來看,AI服務器市場集中度較高,排名前三的供應商為浪潮信息、寧暢和華為,CR3達70.40%。我們認為,國產廠商憑借強大產品競爭力,已經在國際市場占據一定領先地位,未來隨著AI算力需求釋放,有望充分受益于產業成長機遇。

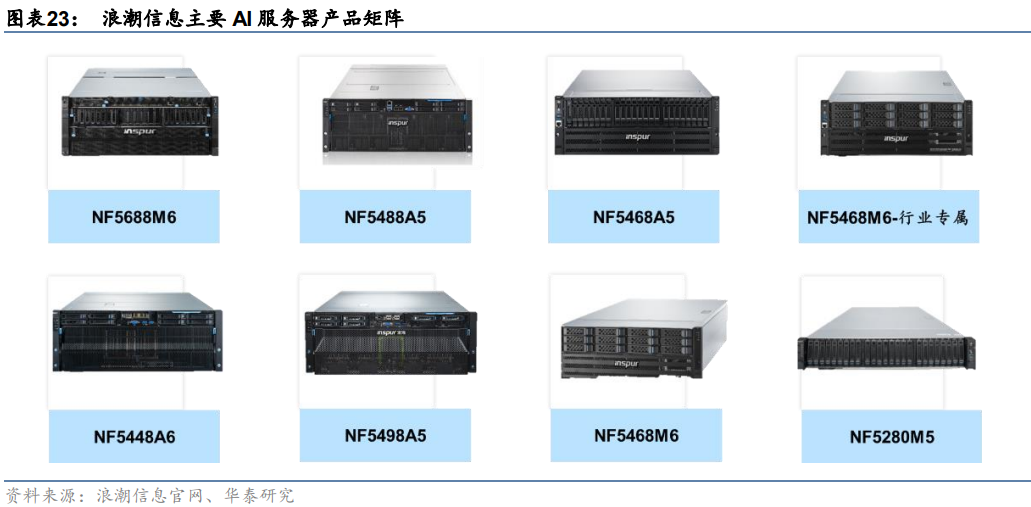

浪潮信息:AI服務器產品矩陣豐富,產品力獲國際認可。目前公司AI服務器主要產品型號包括NF5688M6、NF5488A5等,據公司官網,2021年上述兩款AI服務器在國際權威AI基準測試MLPerf榜單中,獲得醫學影像分割、目標物體檢測、自然語言理解、智能推薦等7項訓練冠軍,可滿足包括自然語言理解等在內的多項AI訓練需求。此外,公司在AI領域的積累還包括AI資源平臺、AI算法平臺等,具備大量算力解決方案實施經驗。

華為:AI服務器融合自研加速卡與英特爾CPU。公司AI服務器為Atlas 800推理服務器系列,旗下有型號3000、型號3010、型號9000和型號9010。其中,型號3000基于昇騰310芯片,型號3010基于Intel處理器,型號9000基于華為鯤鵬920+昇騰910處理器,型號9010基于Intel處理器+華為昇騰910芯片。旗艦級芯片加持下,產品最高擁有2.24 PFLOPS FP16的高密度算力,并在設計結構優化下,芯片間跨服務器互聯時延可縮短10~70%。

新華三AI服務器覆蓋各訓練負載要求,結合軟件平臺構建AI完整生態。公司主要產品型號包括R4900 G5、R5300 G5、R5500 G5等,可分別針對不同訓練負載要求,滿足大小規模的推理/訓練任務。軟件層面,公司通過新華三傲飛AI/HPC融合管理平臺,全面提升AI作業效率約32%。2022年,新華三被國際權威分析機構Forrester認定為大型人工智能系統成熟廠商,可以提供可靠的服務器解決方案。同時,新華三AI服務器在MLPerf測評中共斬獲86項世界第一。

龍頭廠商有望充分受益于算力需求釋放。我們認為,隨著ChatGPT待動大模型訓練熱潮,以人工智能訓練為代表的智能算力需求逐步釋放,有望帶動AI服務器放量。拆解AI服務器成本來看,GPU等算力芯片為核心組件,先進算力產品受美國出口管制影響,但可通過采購A800實現基本替代。我們認為,浪潮信息等國產頭部廠商憑借豐富產品矩陣和強大產品競爭力,占據全球AI服務器市場主要份額,未來有望充分受益于服務器需求釋放。

拆解來看,AI服務器主要成本包括算力芯片、內存、存儲等。據IDC的2018年服務器成本結構拆分數據,芯片成本在基礎型服務器中約占總成本的32%,在高性能或具有更強運算能力的服務器中,芯片相關成本占比可以高達50%-83%。以機器學習型AI服務器為例,其主要成本由GPU、CPU、內存及其他部件組成,其中GPU成本占比最高,達到72.8%。

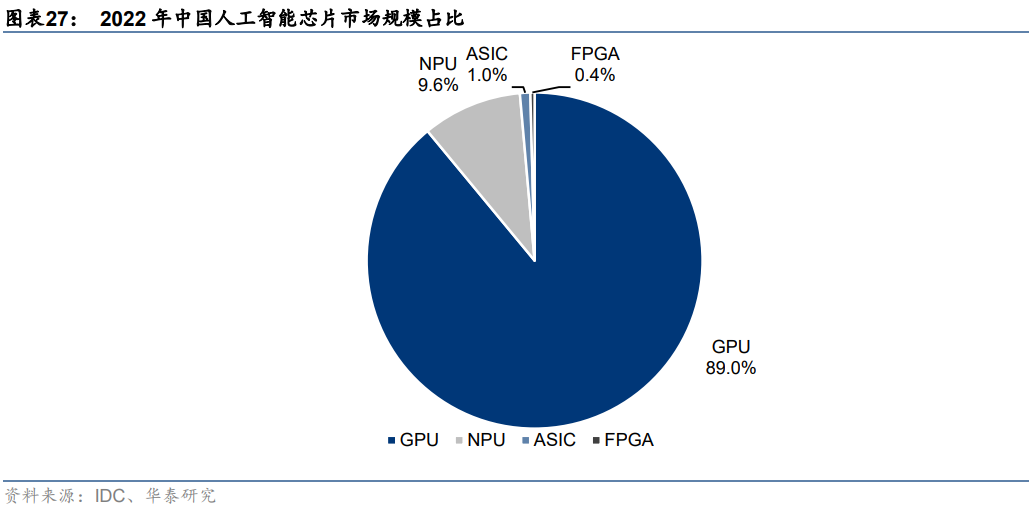

AI服務器算力芯片以GPU為主。據IDC,2022年國內人工智能芯片市場中,GPU芯片占據主要市場份額,達89.0%,主因GPU芯片并行計算架構更加適合于復雜數學計算場景,可以較好支持高度并行的工作負載,因此常用于數據中心的模型訓練,以及邊緣側及端側的推理工作負載。此外,其他主要的人工智能芯片還包括NPU、ASIC、FPGA等。一般而言,AI服務器中算力芯片需求數量取決于服務器設計性能要求,需求種類取決于成本、功耗、算法等指標。常見的算力芯片組合,如8x GPU+2x CPU、4x GPU+ 2x CPU、8x FPGA+1x CPU、4x FPGA+1x CPU等。

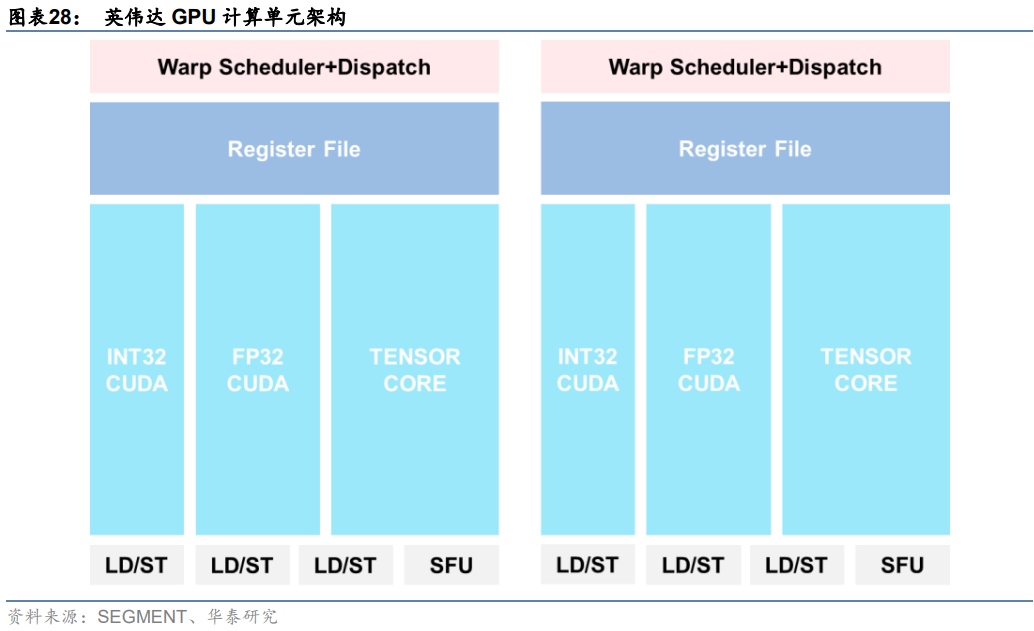

GPU結構:計算單元+顯存。計算單元(Streaming Multiprocessor):計算單元的功能是執行計算。其中每一個SM都有獨立的控制單元、寄存器、緩存、指令流水線。顯存(Global Memory):顯存是在GPU板卡上的DRAM,容量大但速度慢。

1.計算單元底層架構:

顯卡核心構成多樣,不同核心專注不同任務。以英偉達為例,GPU顯卡構成包括TENSOR CORE、CUDA和RT等部分。TENSOR CORE,即張量核心,是英偉達GPU上一塊特殊區域,針對AI矩陣計算設計,可顯著提高AI訓練吞吐量和推理性能。CUDA則是英偉達生態中的通用結構,一般包括多個數據類型,適用于視頻制作,圖像處理,三維渲染等常見圖像處理和計算工作。

2、TOPS和TFLOPS是常見算力衡量單位:

1)OPS:OPS(Operations Per Second)指每秒執行的操作次數,是整數運算的單位,常在INT8、INT4等計算精度下度量算力性能。其中TOPS(Tera Operations Per Second)代表處理器每秒鐘可進行一萬億次(10^12)操作,類似的單位還有諸如GOPS、MOPS,均代表每秒的操作次數。

2)FLOPS:FLOPS(Floating-point Operations Per Second)指每秒所執行的浮點運算次數,常在單精度(FP32)、半精度(FP16)等計算精度下度量算力性能。TFLOPS(Tera Floating-point Operations Per Second)代表處理器每秒鐘可進行一萬億次(10^12)浮點運算。雖然TOPS和TFLOPS數量級一樣,但前者是衡量操作次數,后者是衡量浮點運算,TOPS要結合數據類型精度(如INT8,FP16等)才能與FLOPS轉換。

3.顯存位寬、帶寬與容量:

顯存的主要指標包括位寬、帶寬和容量。顯存本身與CPU的內存類似,將數據在GPU核心與磁盤間傳輸。顯存位寬是顯存在一個時鐘周期內所能傳送數據的位數,決定了顯存瞬時傳輸的數據量。顯存帶寬是指顯示芯片與顯存之間的數據傳輸速率,由顯存頻率和顯存位寬共同決定,體現了顯卡的速度和性能。顯存容量決定了顯存臨時存儲數據的多少。

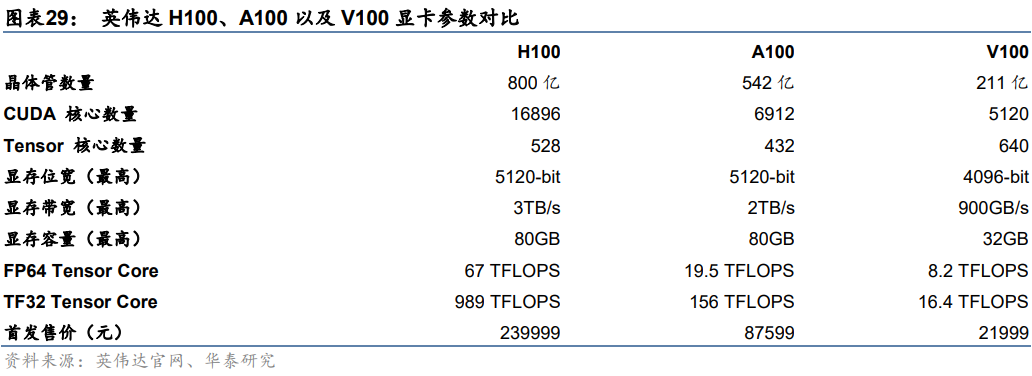

目前主流AI GPU芯片包括英偉達H100、A100以及V100等。全球來看,目前用于人工智能訓練的AI GPU市場以英偉達為主導,公司旗下先進算力產品主要包括H100、A100以及V100。對比雙精度浮點計算性能(FP64 Tensor Core)來看,H100、A100、V100計算速度分別為67 TFLOPS、19.5 TFLOPS、8.2 TFLOPS。從顯存帶寬來看,H100、A100、V100傳輸速度分別為3TB/s、2TB/s、900GB/s。

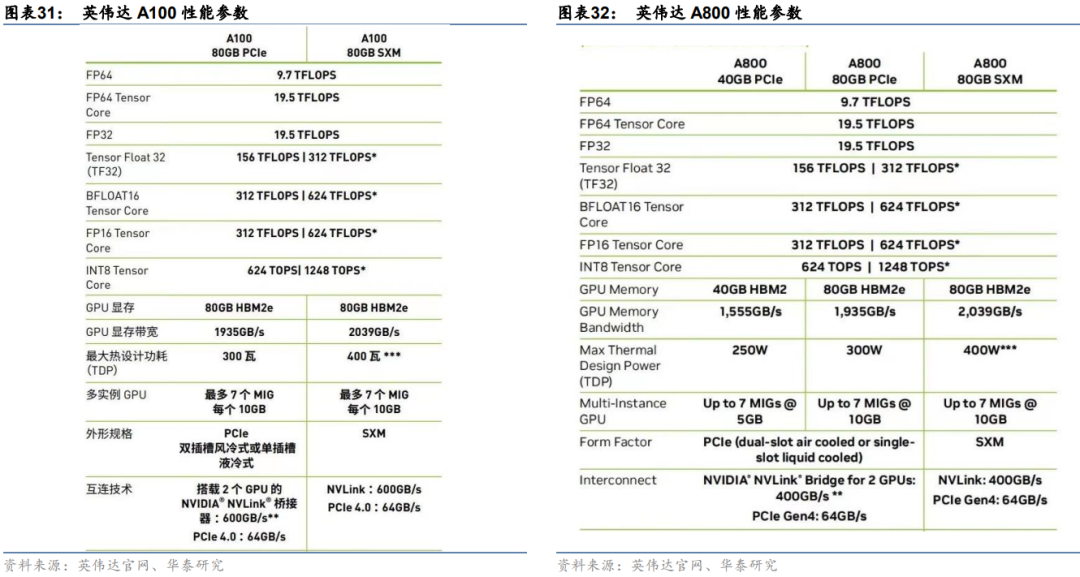

先進算力芯片進口受限或為國產AI服務器的瓶頸之一。2022年10月7日,美國商務部工業與安全局(BIS)宣布了針對中國出口先進芯片的管制新規聲明。聲明規定,滿足輸入輸出(I/O)雙向傳輸速度高于 600GB/s,同時每次操作的比特長度乘以 TOPS 計算出的處理性能合計為 4800 或更多算力的產品,將無法出口至中國。以英偉達A100為例,以TF32性能測算,即156*32=4992>4800,且傳輸速度為600GB/s。基于此,我們可以推斷,性能大于等于A100 GPU的先進算力芯片屬于美國出口限制范圍。

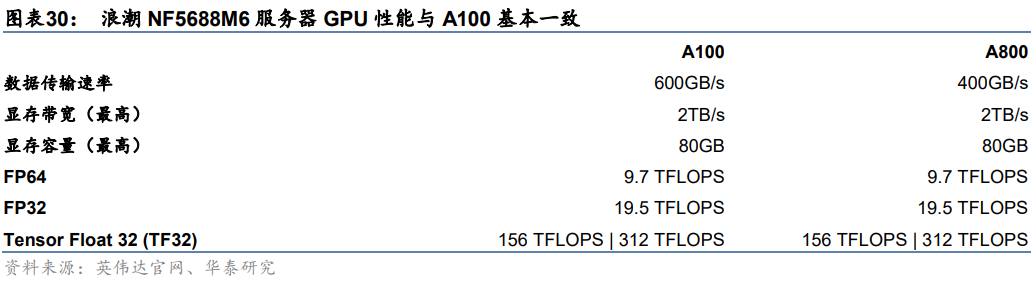

采用英偉達A800服務器或為當前可行替代方案。以浪潮NF5688M6為例,NF5688M6是為超大規模數據中心研發的NVLink AI 服務器,支持2顆Intel最新的Ice Lake CPU和8顆NVIDIA最新的NVSwitch全互聯A800GPU,單機可提供5PFlops的AI計算性能。對比核心硬件來看,NF5688M6采用英偉達中國特供版芯片—A800,在浮點計算能力、顯存帶寬、顯存容量等性能指標上,與先進算力芯片—A100基本一致,主要差異在于芯片的數據傳輸速度,約為A100的三分之二。

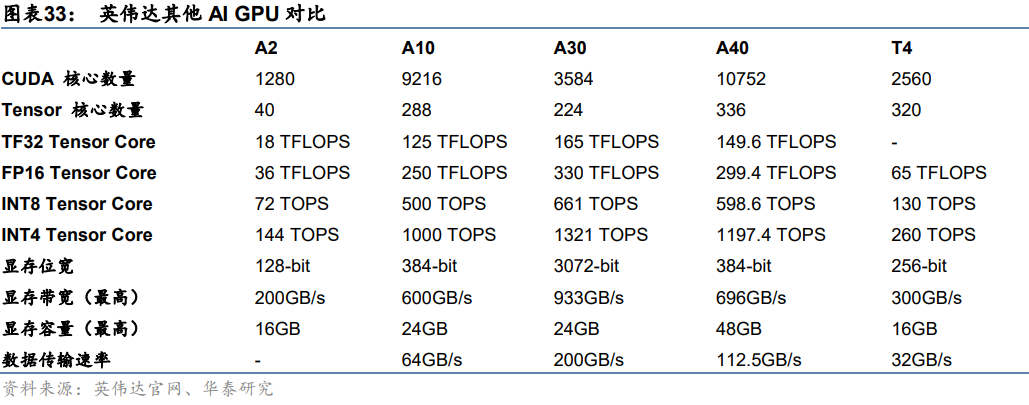

英偉達其他AI GPU芯片均不受出口限制影響。考慮到目前美國GPU芯片限制主要集中在先進算力領域,倘若未來進一步加大限制力度,A800等大算力芯片可能出現進一步被限制的風險。而從英偉達產品線布局來看,除了前面討論的A100、A800、V100、H100等先進算力芯片外,還有A2、A10、A30、A40、T4等。這些芯片中,浮點計算能力最強的型號為A30,輸出性能為82*32=2624<4800,因此不受出口限制影響。

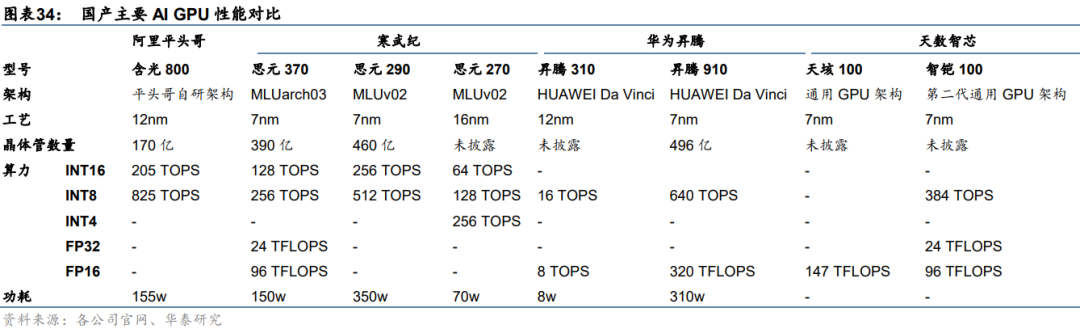

國產AI GPU性能持續升級,國產替代未來可期。目前國產AI GPU廠商主要包括阿里、華為、寒武紀、天數智芯等。隨著國內廠商持續加強GPU研發,產品力不斷升級。以華為昇騰910為例,該款芯片采用7nm制程,集成了超496億個晶體管,可以提供320TFLOPS的FP16計算速度或640TOPS的INT8算力,略高于英偉達A100的FP16計算速度(312TFLOPS,不采用英偉達稀疏技術)。我們認為,單純從芯片算力性能來看,部分國產芯片已經能夠追趕海外主流芯片。隨著國產生態逐步打磨,GPU性能提升有望推動國產化替代。

總結:

1、GPT模型需要什么樣的算力?

ChatGPT采用單一大模型路線,對底層算力的需求主要體現在訓練和推理兩個層面,訓練即使用大量數據集,對模型做反復迭代計算,推理即利用模型對輸入信息進行處理并給出結果。據IDC數據,2021年中國人工智能服務器工作負載中,57.6%的負載用于推理,42.4%用于模型訓練。具體來看,算力需求場景包括預訓練、Finetune以及日常運營。根據我們的測算,GPT-3 175B模型需要的預訓練算力約3640 PFlop/s-day、ChatGPT單月運營需要的算力約7034.7 PFlop/s-day、單月Finetune需要的算力至少為1350.4 PFlop/s-day。

2、GPT模型需要什么樣的服務器?

我們認為,服務器類型不斷演化的動力來自:計算架構的變化。從服務器產業發展歷程來看,隨著計算架構從單機到C-S、C-E-S,陸續演化出PC、云計算、邊緣計算等服務器類型。而在AI訓練時代,C-S架構的回歸以及大規模并行計算需求,又帶來AI服務器的擴張。對比傳統服務器來看,AI服務器由于采用GPU等加速卡,更加擅長向量、張量計算,對于AI訓練及推理場景的處理能力更強,且采用多芯片組合架構,單臺服務器芯片成本也較高。

3、GPT模型需要什么樣的算力芯片?

GPT模型的訓練和推理計算主要由AI服務器完成,底層算力芯片主要包括CPU、GPU、FPGA、ASIC等。常見的算力芯片組合,如8x GPU+2x CPU、4x GPU+ 2x CPU、8x FPGA+1x CPU、4x FPGA+1x CPU等。據IDC,2022年國內人工智能芯片市場中,GPU芯片占據主要市場份額,達89.0%。目前海外主流AI GPU芯片包括英偉達H100、A100以及V100等。

4、美國先進算力芯片出口限制對GPT產業的影響?

受美國先進算力芯片出口限制政策影響,目前國內只能采購性能低于A100的AI GPU,如英偉達A800系列等。此外,英偉達A系列、T系列性能更低的前代版本尚且不受影響。考慮到部分國產AI GPU如華為昇騰在FP16浮點計算性能上已經實現對英偉達A100的加速追趕,未來隨著國產生態打磨,AI GPU國產替代有望加速。

5、AI服務器產業鏈相關公司有哪些?

- 1)能夠采購到海外高性能芯片的廠商:浪潮信息等;

- 2)采用海光/寒武紀芯片的廠商:中科曙光;

- 3)采用華為昇騰芯片的廠商:拓維信息等;

- 4)底層芯片供應商:海光信息、寒武紀、景嘉微等。