AI繪畫新思路:國產開源50億參數新模型,合成可控性、質量實現(xiàn)飛躍

- 論文地址:https://arxiv.org/pdf/2302.09778v2.pdf

- 項目地址:https://github.com/damo-vilab/composer

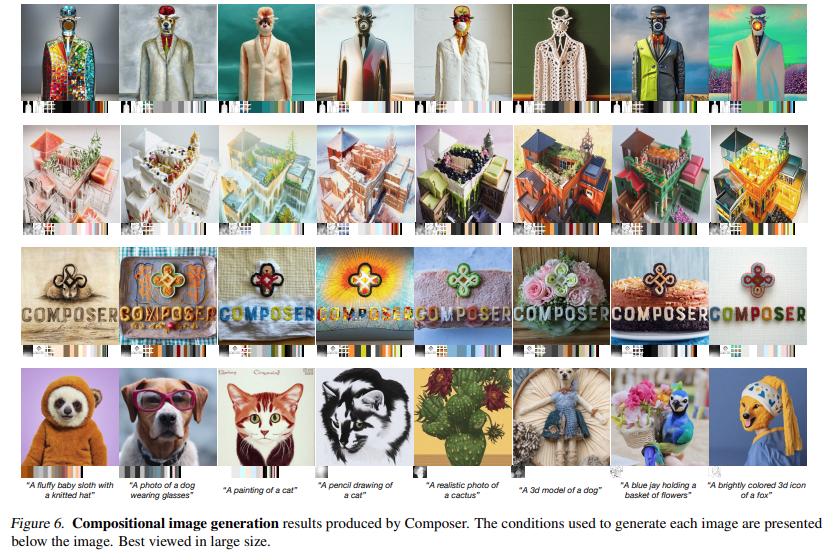

近年來,在大數據上學習的大規(guī)模生成模型能夠出色地合成圖像,但可控性有限。可控圖像生成的關鍵不僅依賴于條件,而且更重要的是依賴于組合性。后者可以通過引入巨大數量的潛在組合來指數級地擴展控制空間(例如 100 個圖像,每個有 8 個表征,產生大約 100^8 種組合)。類似的概念在語言和場景理解領域得到了探索,其中的組合性被稱為組合泛化,即從有限的已知成分中識別或生成潛在的無限數量的新組合的技能。

最新的一項研究提供了一種新的生成范式 —— 可以在靈活控制輸出圖像(如空間布局和調色板)的同時保持合成質量和模型創(chuàng)造力。

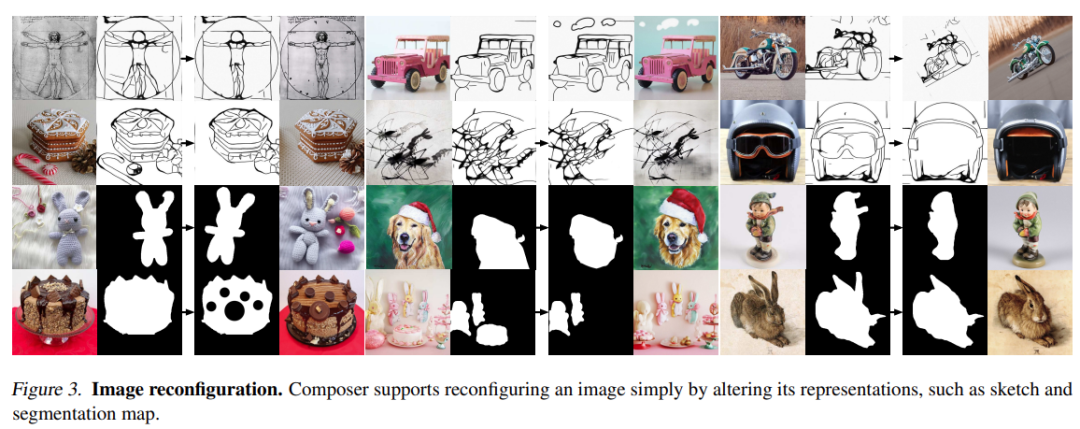

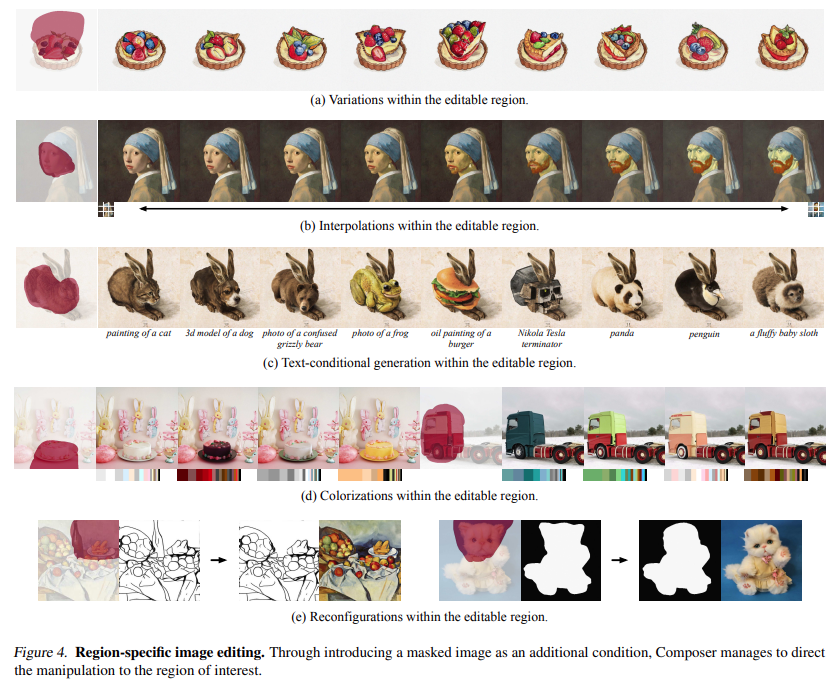

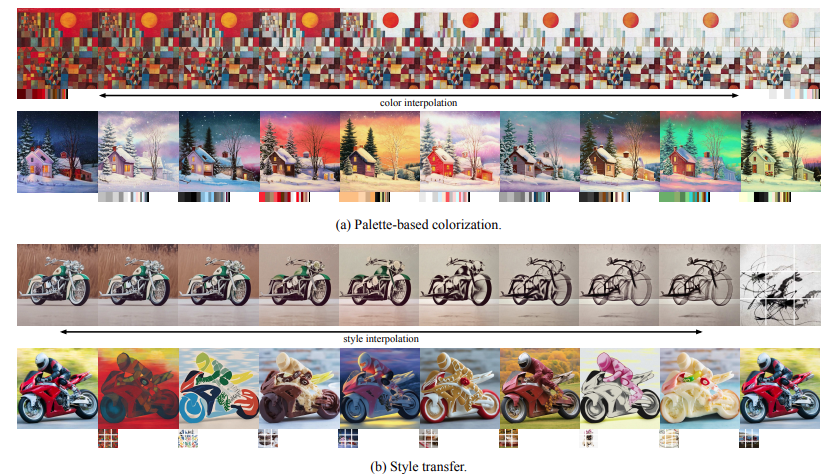

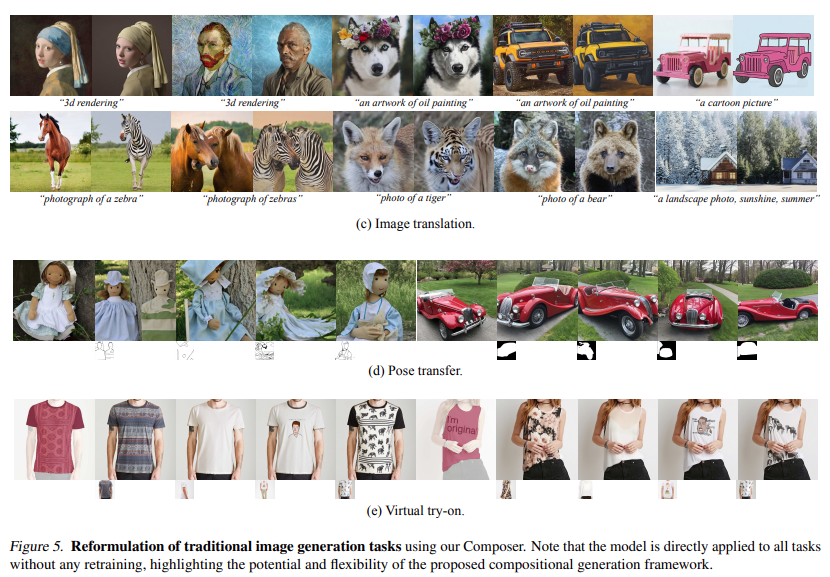

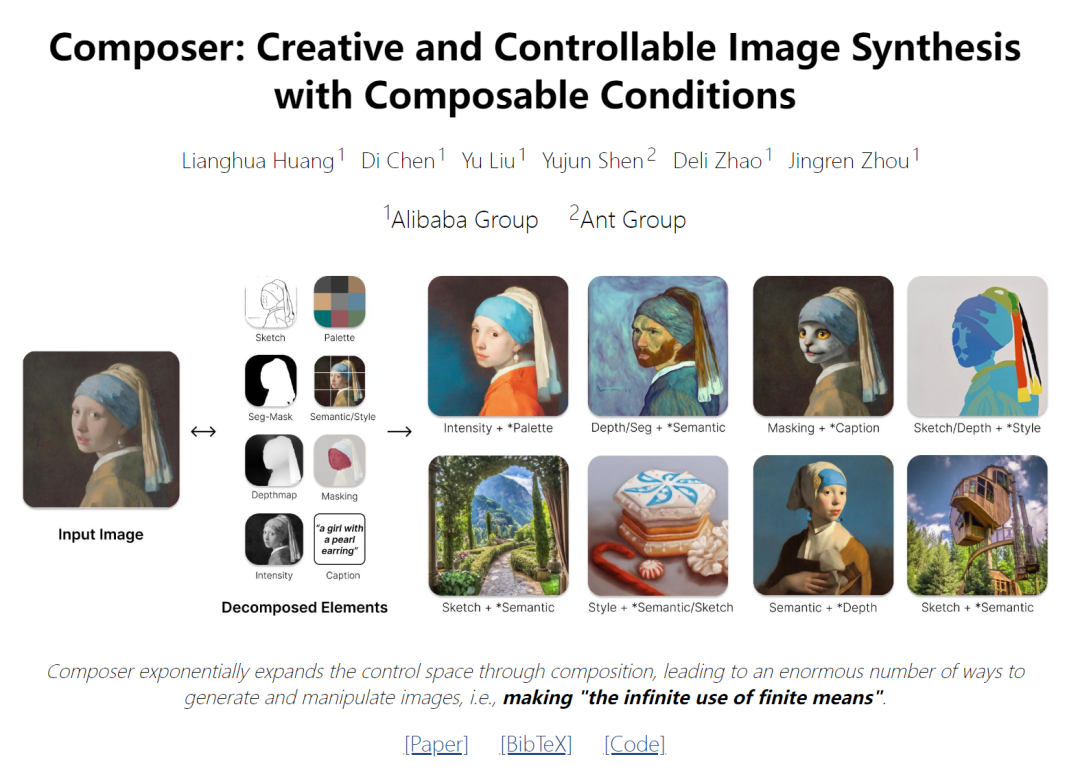

這項研究以組合性為核心思想,首先將圖像分解為具有代表性的因子,然后以這些因子為條件訓練擴散模型,對輸入進行重組。在推理階段,豐富的中間表征形式作為可組合元素,為可定制內容的創(chuàng)建提供了巨大的設計空間 (即與分解因子的數量成指數比例)。值得注意的是,名為 Composer 的方法支持各種級別的條件,例如將文本描述作為全局信息,將深度圖和草圖作為局部指導,將顏色直方圖作為低級細節(jié)等。

除了提高可控性之外,該研究還確認了 Composer 可以作為通用框架,在無需再訓練的情況下促進廣泛的經典生成任務。

方法

本文所介紹的框架包括分解階段(圖像被分為一組獨立的組件)與合成階段(組件利用條件擴散模型重新組合)。這里首先簡要介紹擴散模型和使用 Composer 實現(xiàn)的制導方向,然后將詳細說明圖像分解和合成的實現(xiàn)。

2.1. 擴散模型

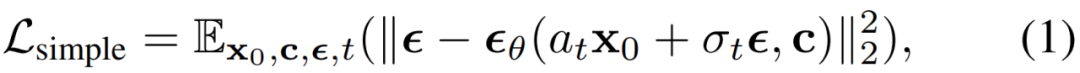

擴散模型是一種生成模型,通過迭代去噪過程從高斯噪聲中產生數據。通常使用簡單的均方誤差作為去噪目標:

其中,x_0 是具有可選條件 c 的訓練數據, 是加性高斯噪聲,a_t、σ_t 是 t 的標量函數,

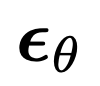

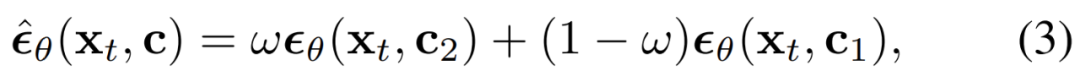

是加性高斯噪聲,a_t、σ_t 是 t 的標量函數, 是具有可學習參數 θ 的擴散模型。無分類器引導在最近的工作中得到了最廣泛的應用,用于擴散模型的條件數據采樣,其中預測的噪聲通過以下方式進行調整:

是具有可學習參數 θ 的擴散模型。無分類器引導在最近的工作中得到了最廣泛的應用,用于擴散模型的條件數據采樣,其中預測的噪聲通過以下方式進行調整:

公式

中, ω 為引導權重。DDIM 和 DPM-Solver 經常被用于加速擴散模型的采樣過程。DDIM 還可以用于將樣本 x_0 反推到其純噪聲潛在 x_T,從而實現(xiàn)各種圖像編輯操作。

引導方向:Composer 是一個可以接受多種條件的擴散模型,可以在無分類器引導下實現(xiàn)各種方向:

c_1 和 c_2 是兩組條件。c_1 和 c_2 的不同選擇表征對條件的不同強調。

(c_2 \ c_1) 內的條件強調為 ω, (c_1 \ c_2) 內的條件抑制為 (1?ω), c1∩c2 內的條件的指導權重為 1.0.。雙向指導:通過使用條件 c_1 將圖像 x_0 反轉到潛在的 x_T,然后使用另一個條件 c_2 從 x_T 采樣,研究能夠使用 Composer 以一種解糾纏的方式操作圖像,其中操作方向由 c_2 和 c_1 之間的差異來定義。

分解

研究將圖像分解為捕捉圖像各個方面的去耦表征,并且描述了該任務中使用的八種表征,這幾種表征都是在訓練過程中實時提取的。

說明(Caption):研究直接使用圖像 - 文本訓練數據中的標題或描述信息(例如,LAION-5B (Schuhmann et al., 2022))作為圖像說明。當注釋不可用時,還可以利用預訓練好的圖像說明模型。研究使用預訓練的 CLIP ViT-L /14@336px (Radford et al., 2021) 模型提取的句子和單詞嵌入來表征這些標題。

語義和風格(Semantics and style):研究使用預先訓練的 CLIP ViT-L/14@336px 模型提取的圖像嵌入來表征圖像的語義和風格,類似于 unCLIP。

顏色(Color):研究使用平滑的 CIELab 直方圖表征圖像的顏色統(tǒng)計。將 CIELab 顏色空間量化為 11 個色調值,5 個飽和度和 5 個光值,使用平滑 sigma 為 10。經驗所得,這樣設置的效果更好。

草圖(Sketch):研究應用邊緣檢測模型,然后使用草圖簡化算法來提取圖像的草圖。草圖捕捉圖像的局部細節(jié),具有較少的語義。

實例(Instances):研究使用預訓練的 YOLOv5 模型對圖像應用實例分割來提取其實例掩碼。實例分割掩碼反映了視覺對象的類別和形狀信息。

深度圖(Depthmap):研究使用預訓練的單目深度估計模型來提取圖像的深度圖,大致捕捉圖像的布局。

強度(Intensity):研究引入原始灰度圖像作為表征,迫使模型學習處理顏色的解糾纏自由度。為了引入隨機性,研究統(tǒng)一從一組預定義的 RGB 通道權重中采樣來創(chuàng)建灰度圖像。

掩碼(Masking):研究引入圖像掩碼,使 Composer 能夠將圖像生成或操作限制在可編輯的區(qū)域。使用 4 通道表征,其中前 3 個通道對應于掩碼 RGB 圖像,而最后一個通道對應于二進制掩碼。

需要注意的是,雖然本文使用上述八種條件進行了實驗,但用戶可以使用 Composer 自由定制條件。

構成

研究使用擴散模型從一組表征中重新組合圖像。具體來說,研究利用 GLIDE 架構并修改其調節(jié)模塊。研究探索了兩種不同的機制來根據表征調整模型:

全局調節(jié):對于包括 CLIP 句子嵌入、圖像嵌入和調色板在內的全局表征,研究將它們投影并添加到時間步嵌入中。此外,研究還將圖像嵌入和調色板投射到八個額外的 token 中,并將它們與 CLIP 詞嵌入連接起來,然后將其用作 GLIDE 中交叉注意的上下文,類似于 unCLIP 。由于條件要么是相加的,要么可以在交叉注意中選擇性地掩蓋,所以在訓練和推理期間可以直接放棄條件,或者引入新的全局條件。

局部化調節(jié):對于局部化表征,包括草圖、分割掩碼、深度映射、強度圖像和掩碼圖像,研究使用堆疊卷積層將它們投射到與噪聲潛在 x_t 具有相同空間大小的均維嵌入中。然后計算這些嵌入的和,并將結果連接到 x_t,然后將其輸入到 UNet。由于嵌入是可添加的,因此很容易適應缺失的條件或合并新的局部化條件。

聯(lián)合訓練策略:設計一種聯(lián)合訓練策略,使模型能夠從各種條件組合中學習解碼圖像,這一點很重要。研究對幾種配置進行了實驗,并確定了一個簡單而有效的配置,其中對每個條件使用獨立的退出概率為 0.5,刪除所有條件的概率為 0.1,保留所有條件的概率為 0.1。對于強度圖像使用 0.7 的特殊退出概率,因為它們包含了關于圖像的絕大多數信息,并且在訓練過程中可能會弱化其他條件。

基本擴散模型產生 64 × 64 分辨率的圖像。為了生成高分辨率圖像,研究訓練了兩個無條件擴散模型用于上采樣,分別將圖像從 64 × 64 提升到 256 × 256,以及從 256 × 256 提升到 1024 × 1024 分辨率。上采樣模型的架構是從 unCLIP 修改的,其中研究在低分辨率層中使用更多通道,并引入自注意塊來擴大容量。此外還引入了一個可選的先驗模型,該模型從字幕生成圖像嵌入。根據經驗,先驗模型能夠在特定的條件組合下提高生成圖像的多樣性。

實驗

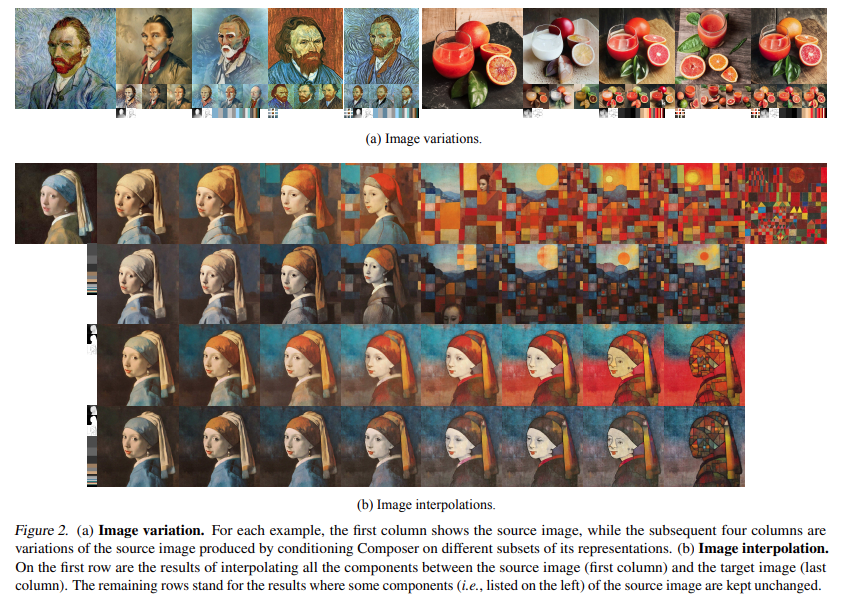

變體:使用 Composer 可以創(chuàng)建與給定圖像相似的新圖像,但通過對其表征的特定子集所進行的條件反射在某些方面有些不同。通過仔細選擇不同表征的組合,人們可以靈活地控制圖像變化的范圍 (圖 2a)。在納入更多的條件后,研究所介紹的方法比僅以圖像嵌入為條件的 unCLIP 生成變體:使用 Composer 可以創(chuàng)建與給定圖像相似的新圖像,但通過對其表征的特定子集進行條件反射,在某些方面有所不同。通過仔細選擇不同表征的組合,人們可以靈活地控制圖像變化的范圍 (圖 2a)。在納入更多的條件后,研究所介紹的方法比僅以圖像嵌入為條件的 unCLIP 的重建準確率更高。