首個超大規模GAN模型!生成速度比Diffusion快20+倍,0.13秒出圖,最高支持1600萬像素

??AIGC爆火的背后,從技術的角度來看,是圖像生成模型的架構發生了巨大的變化。

隨著OpenAI發布DALL-E 2,自回歸和擴散模型一夜之間成為大規模生成模型的新標準,而在此之前,生成對抗網絡(GAN)一直都是主流選擇,并衍生出StyleGAN等技術。

從GAN切換到擴散模型的架構轉變也引出了一個問題:能否通過擴大GAN模型的規模,比如說在 LAION 這樣的大型數據集中進一步提升性能嗎?

最近,針對增加StyleGAN架構容量會導致不穩定的問題,來自浦項科技大學(韓國)、卡內基梅隆大學和Adobe研究院的研究人員提出了一種全新的生成對抗網絡架構GigaGAN,打破了模型的規模限制,展示了 GAN 仍然可以勝任文本到圖像合成模型。

論文鏈接:https://arxiv.org/abs/2303.05511

項目鏈接:https://mingukkang.github.io/GigaGAN/

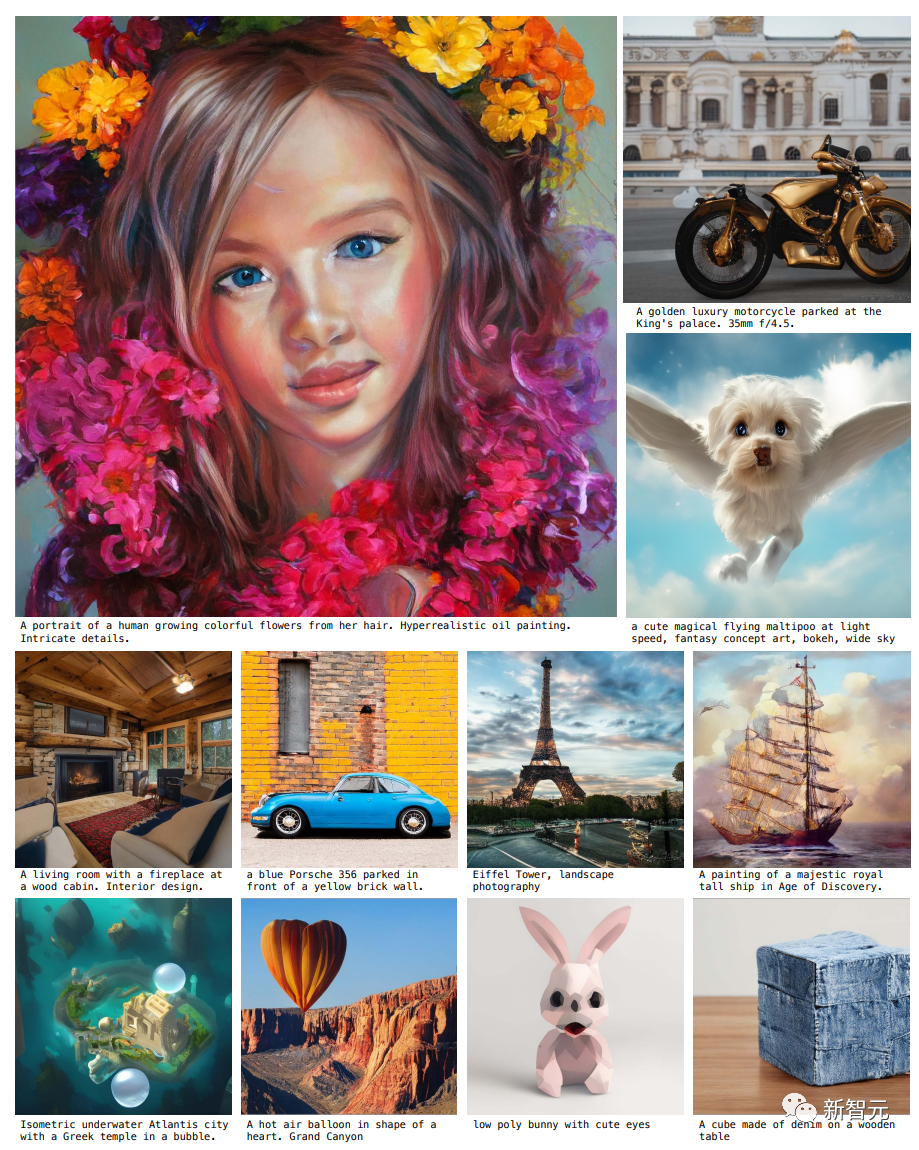

GigaGAN有三大優勢。

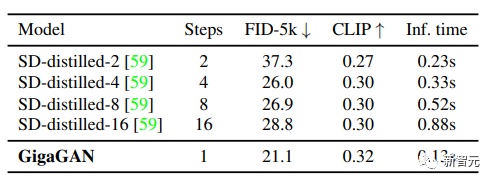

1. 它在推理時速度更快,相比同量級參數的Stable Diffusion-v1.5,在512分辨率的生成速度從2.9秒縮短到0.13秒。

2. 可以合成高分辨率的圖像,例如,在3.66秒內合成1600萬像素的圖像。

3. 支持各種潛空間編輯應用程序,如潛插值、樣式混合和向量算術操作等。

最近發布的一系列模型,如DALL-E 2、Imagen、Parti和Stable Diffusion,開創了圖像生成的新時代,在圖像質量和模型靈活性方面達到了前所未有的水平。

現在占主導地位的范式「擴散模型」和「自回歸模型」,都依賴于迭代推理這把雙刃劍,因為迭代方法能夠以簡單的目標進行穩定的訓練,但在推理過程中會產生更高的計算成本。

與此形成對比的是生成對抗網絡(GAN),只需要一次forward pass即可生成圖像,因此本質上是更高效的。

雖然GAN模型主導了生成式建模的「前一個時代」,但由于訓練過程中的不穩定性,對GAN進行擴展需要仔細調整網絡結構和訓練考慮,因此GANs雖然在為單個或多個對象類別建模方面表現出色,但擴展到復雜的數據集上(更不用說開放世界物體生成了),仍然具有挑戰性。

所以目前超大型的模型、數據和計算資源都主要集中在擴散和自回歸模型上。

在這項工作中,研究人員主要解決以下問題:

GAN能否繼續擴大規模并有可能從這些資源中受益?或者說GAN已經到達極限了?是什么阻礙了GAN的進一步擴展?能否克服這些障礙?

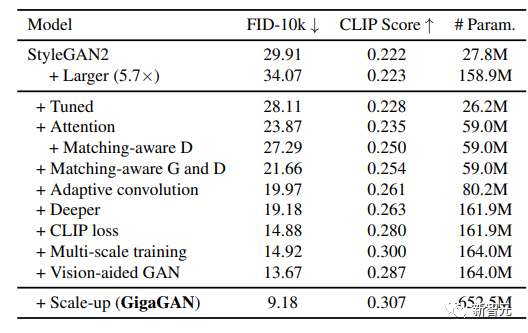

研究人員首先用StyleGAN2進行實驗,觀察到簡單地擴展骨干網會導致不穩定的訓練,在確定了幾個關鍵問題后,提出了在增加模型容量的同時穩定訓練的技術。

首先,通過保留一個濾波器庫(a bank of filters),并采取一個特定樣本的線性組合來有效地擴展生成器的容量。

改編了幾個在擴散模型上下文中常用的技術,并確認它們可以為GANs帶來了類似的性能提升,例如將自注意力機制(僅圖像)和交叉注意力(圖像-文本)與卷積層交織在一起可以提高性能。

此外,研究人員重新引入了多尺度訓練(multi-scaletraining),找到了一個新的方案可以改善圖像-文本對齊和生成輸出的低頻細節。

多尺度訓練可以讓基于GAN的生成器更有效地使用低分辨率塊中的參數,從而具有更好的圖像-文本對齊和圖像質量。

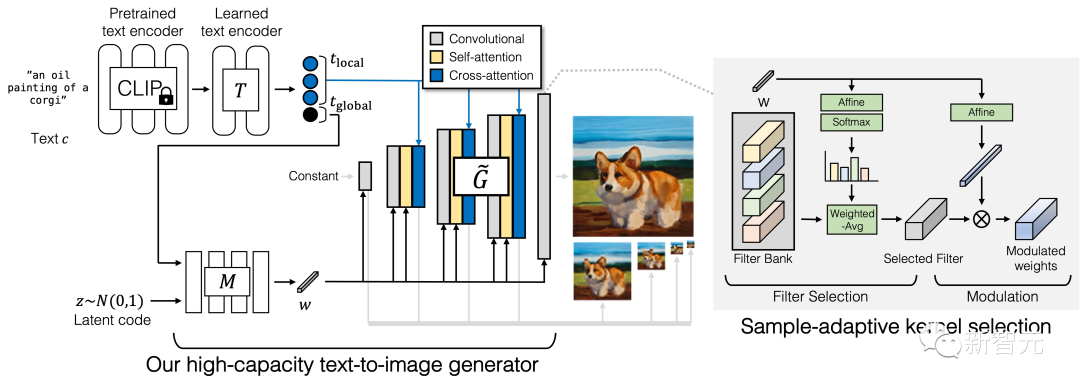

生成器

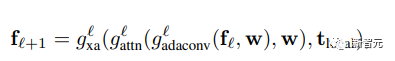

GigaGAN的生成器由文本編碼分支(text encoding branch)、樣式映射網絡(style mapping network)、多尺度綜合網絡(multi-scale synthesis network)組成,并輔以穩定注意力(stable attention)和自適應核選擇(adaptive kernel selection)。

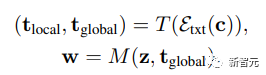

在文本編碼分支中,首先使用一個預先訓練好的 CLIP 模型和一個學習的注意層 T 來提取文本嵌入,然后將嵌入過程傳遞給樣式映射網絡 M,生成與 StyleGAN 類似的樣式向量 w

合成網絡采用樣式編碼作為modulation,以文本嵌入作為注意力來生成image pyramid,在此基礎上,引入樣本自適應核選擇算法,實現了基于輸入文本條件的卷積核自適應選擇。

判別器

與生成器類似,GigaGAN的判別器由兩個分支組成,分別用于處理圖像和文本條件。

文本分支處理類似于生成器的文本分支;圖像分支接收一個image pyramid作為輸入并對每個圖像尺度進行獨立的預測。

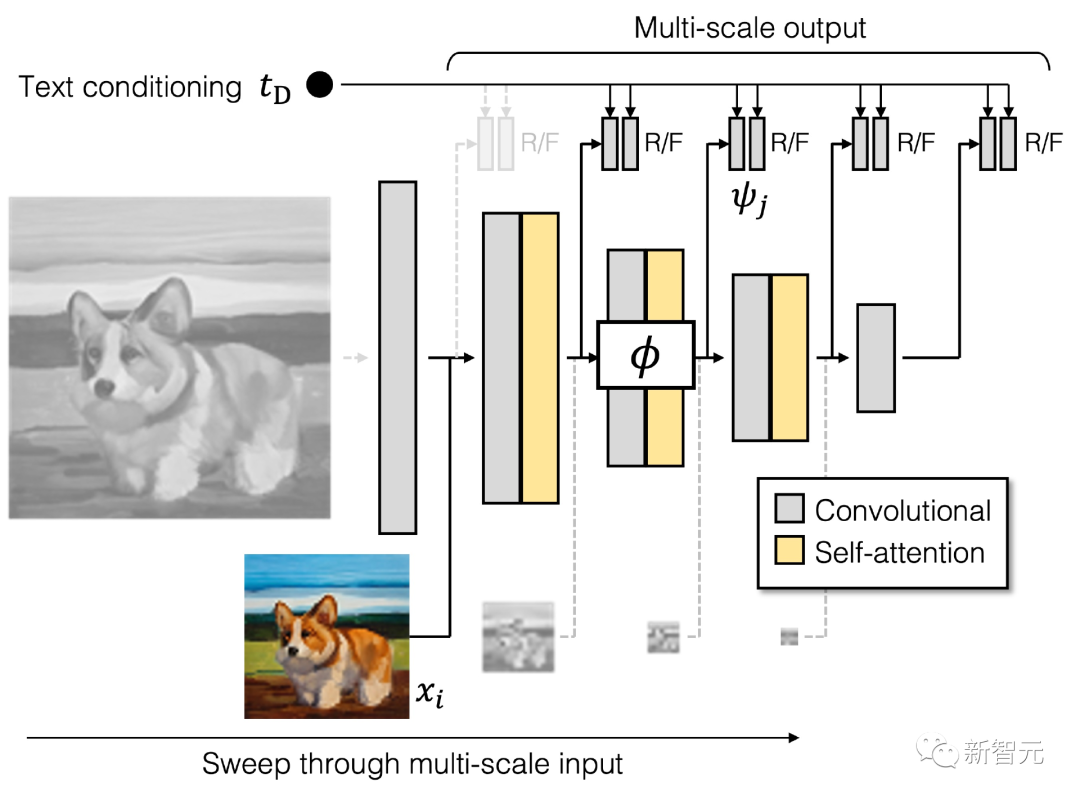

公式中引入了多個額外的損失函數以促進快速收斂。

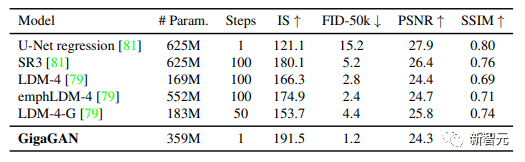

對大規模文本-圖像合成任務進行系統的、受控的評估是困難的,因為大多數現有的模型并不公開可用,即使訓練代碼可用,從頭開始訓練一個新模型的成本也會過高。

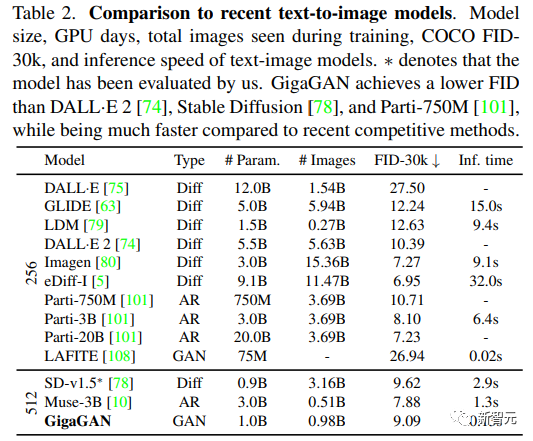

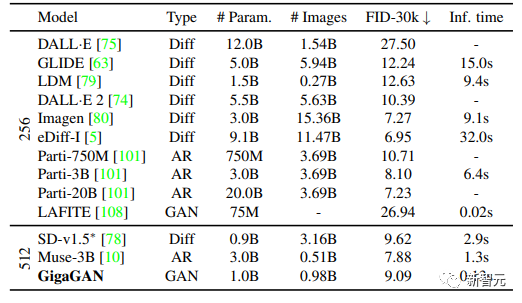

研究人員選擇在實驗中與Imagen、Latent Diffusion Models(LDM)、Stable Diffusion和Parti進行對比,同時承認在訓練數據集、迭代次數、批量大小和模型大小方面存在相當大的差異。

對于定量評價指標,主要使用Frechet Inception Distance(FID)來衡量輸出分布的真實性,并使用CLIP分數來評價圖像-文本對齊。

文中進行了五個不同的實驗:

1. 通過逐步納入每個技術組件來展示提出方法的有效性;

2. 文本-圖像合成結果表明,GigaGAN表現出與穩定擴散(SD-v1.5)相當的FID,同時生成的結果比擴散或自回歸模型快數百倍;

3. 將GigaGAN與基于蒸餾的擴散模型進行對比,顯示GigaGAN可以比基于蒸餾的擴散模型更快地合成更高質量的圖像;

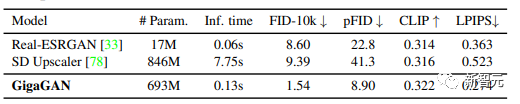

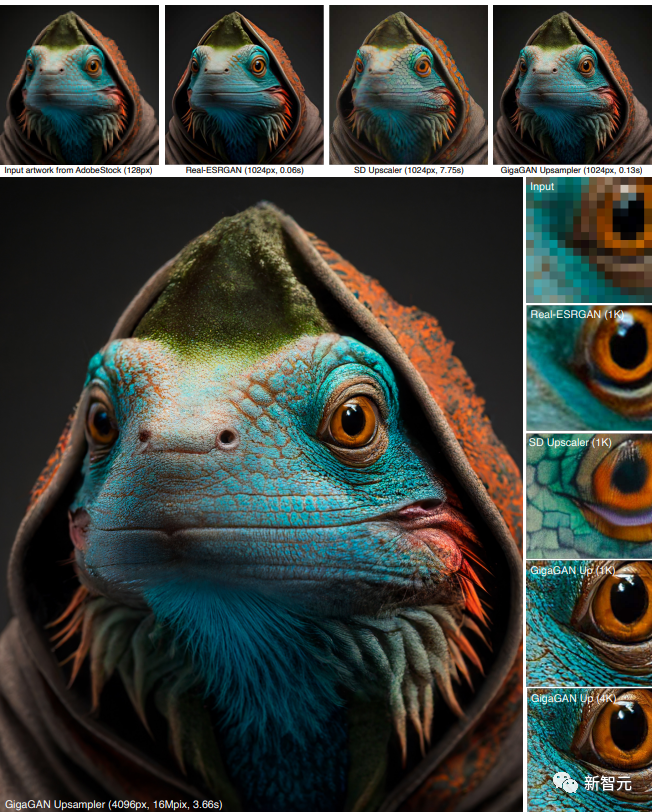

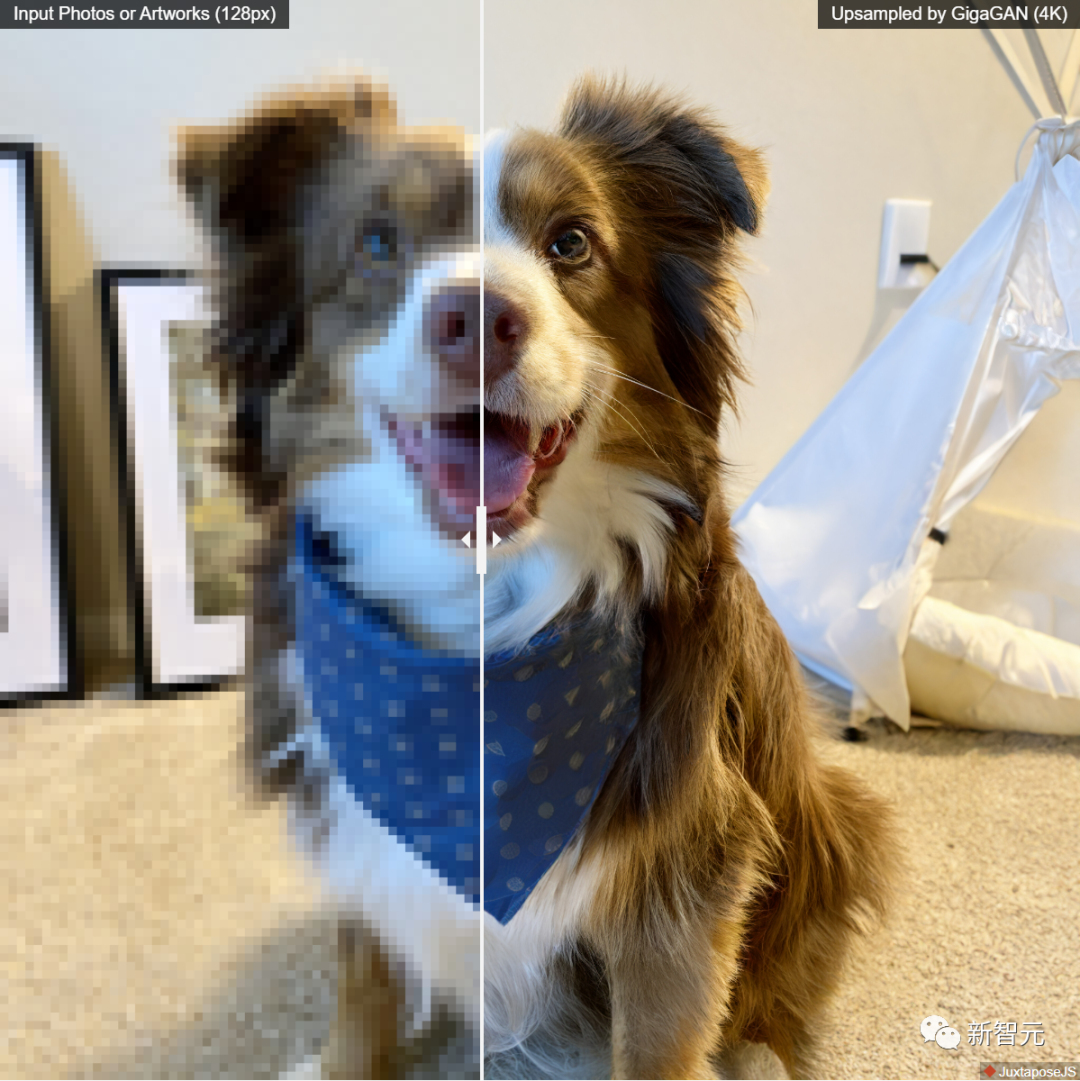

4. 驗證了GigaGAN的上采樣器在有條件和無條件的超分辨率任務中比其他上采樣器的優勢;

5. 結果表明大規模GANs仍然享有GANs的連續和分解潛伏空間的操作,實現了新的圖像編輯模式。

經過調參,研究人員在大規模的數據集,如LAION2B-en上實現了穩定和可擴展的十億參數GAN(GigaGAN)的訓練。

并且該方法采用了多階段的方法,首先在64×64下生成,然后上采樣到512×512,這兩個網絡是模塊化的,而且足夠強大,能夠以即插即用的方式使用。

結果表明,盡管在訓練時從未見過擴散模型的圖像,但基于文本條件的GAN上采樣網絡可以作為基礎擴散模型(如DALL-E 2)的高效、高質量的上采樣器。

這些成果加在一起,使得GigaGAN遠遠超過了以前的GAN模型,比StyleGAN2大36倍,比StyleGAN-XL和XMC-GAN大6倍。

雖然GiGAN的10億參數量仍然低于最近發布的最大合成模型,如Imagen(3B)、DALL-E 2(5.5B)和Parti(20B),但目前還沒有觀察到關于模型大小的質量飽和度。

GigaGAN在COCO2014數據集上實現了9.09的zero-shot FID,低于DALL-E 2、Parti-750M和Stable Diffusion的FID

提示插值(Prompt interpolation)

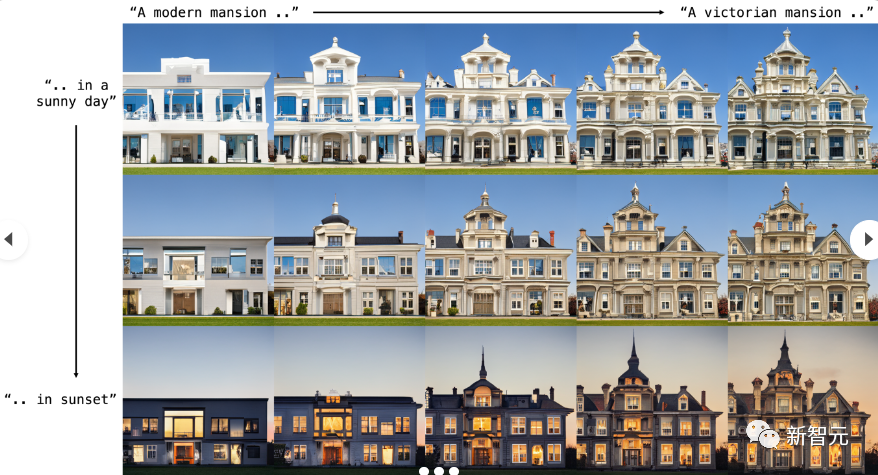

GigaGAN可以在提示之間平滑地插值,下圖中的四個角是由同一潛碼生成,但帶有不同的文本提示。

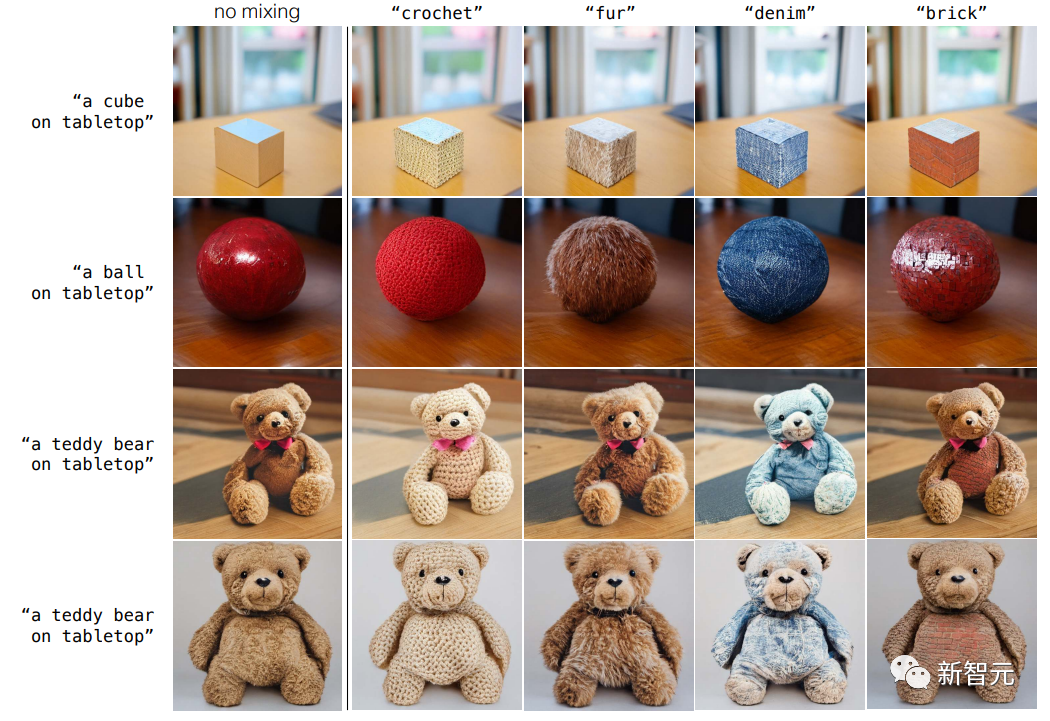

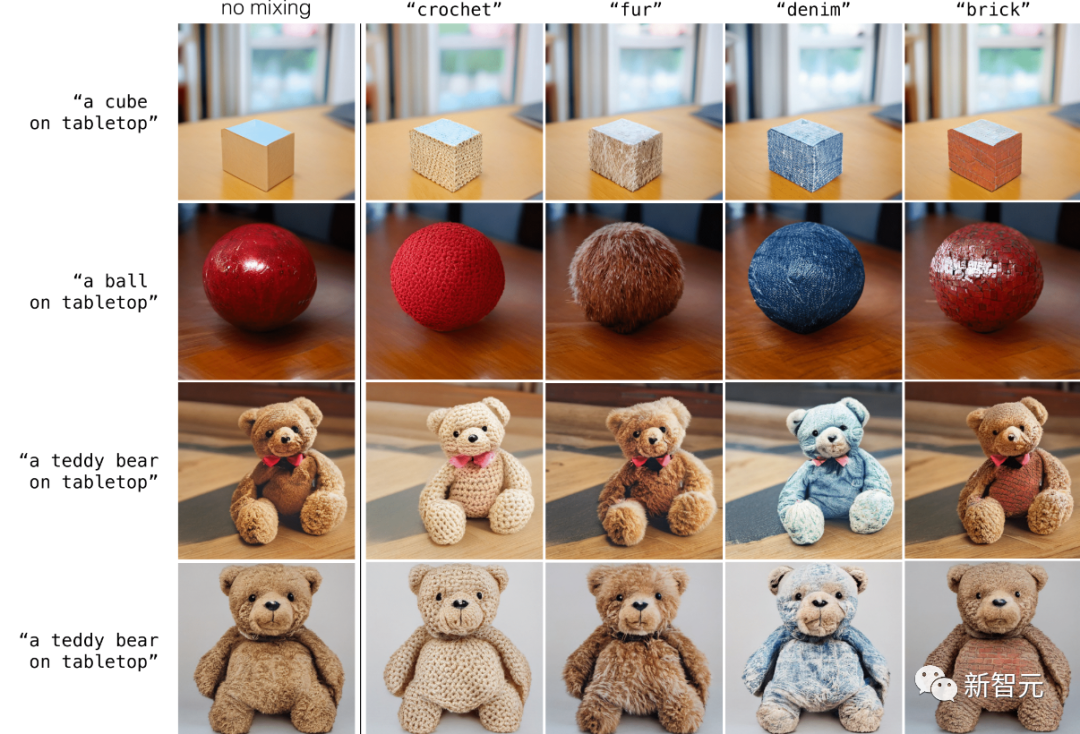

解耦提示混合(Disentangled prompt mixing)

GigaGAN 保留了一個分離的潛空間,使得能夠將一個樣本的粗樣式與另一個樣本的精細樣式結合起來,并且GigaGAN 可以通過文本提示直接控制樣式。

粗到精風格交換(Coarse-to-fine sytle swapping)

基于 GAN 的模型架構保留了一個分離的潛在空間,使得能夠將一個樣本的粗樣式與另一個樣本的精樣式混合在一起。

參考資料:?

https://mingukkang.github.io/GigaGAN/