視覺AI能力大一統!自動化圖像檢測分割,還能可控文生圖,華人團隊出品

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

現在AI圈確實到了拼手速的時候啊。

這不,Meta的SAM剛剛推出幾天,就有國內程序猿來了波buff疊加,把目標檢測、分割、生成幾大視覺AI功能all in one!

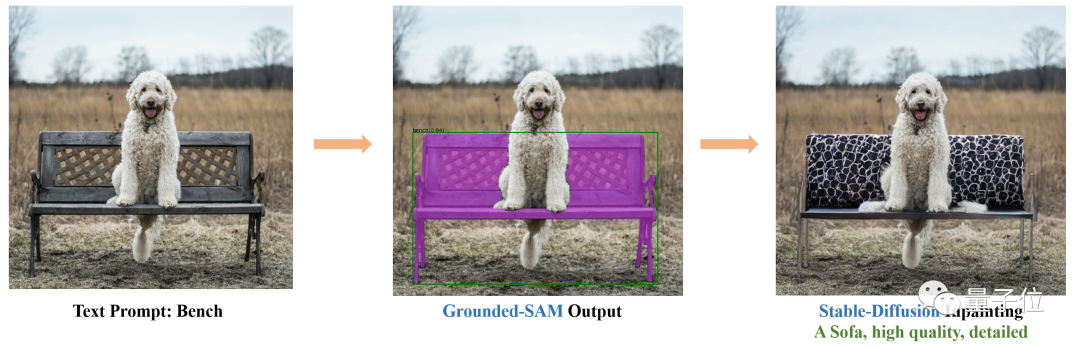

比如基于Stable Diffusion和SAM,就能讓照片中的椅子無縫換成沙發:

換裝、換發色也是so easy:

項目一經發布就讓不少人驚呼:手速也太快了吧!

還有人表示:我和新垣結衣的新結婚照有了。

如上就是Gounded-SAM帶來的效果,項目在GitHub上已攬星1.8k。

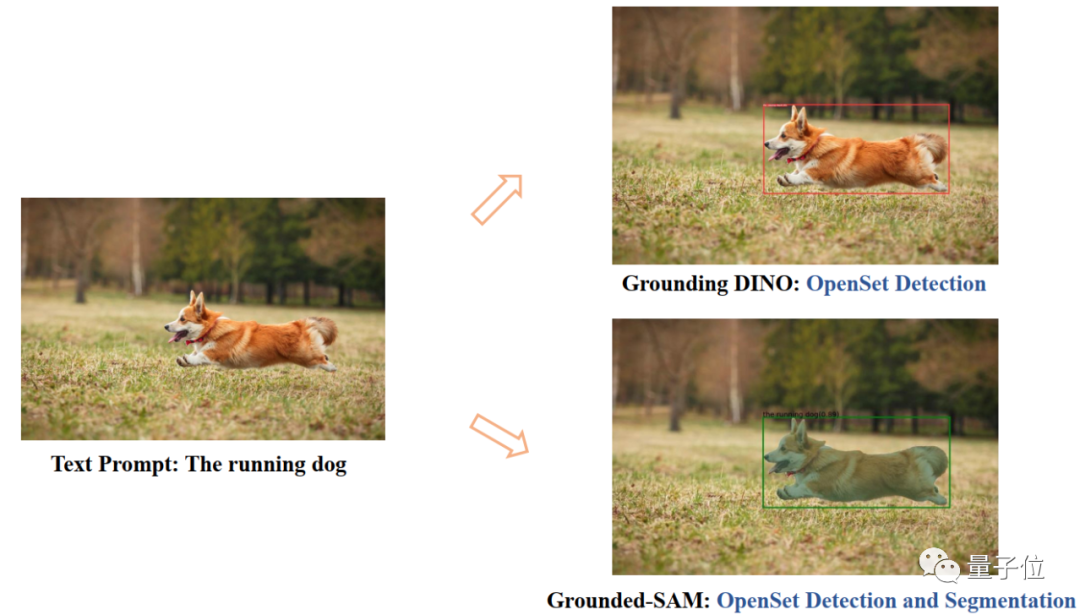

簡單來說,這就是一個zero-shot視覺應用,只需要輸入圖片,就能自動化檢測和分割圖像。

該研究來自IDEA研究院(粵港澳大灣區數字經濟研究院),創始人兼理事長為沈向洋。

無需額外訓練

Grounded SAM主要由Grounding DINO和SAM兩個模型組成。

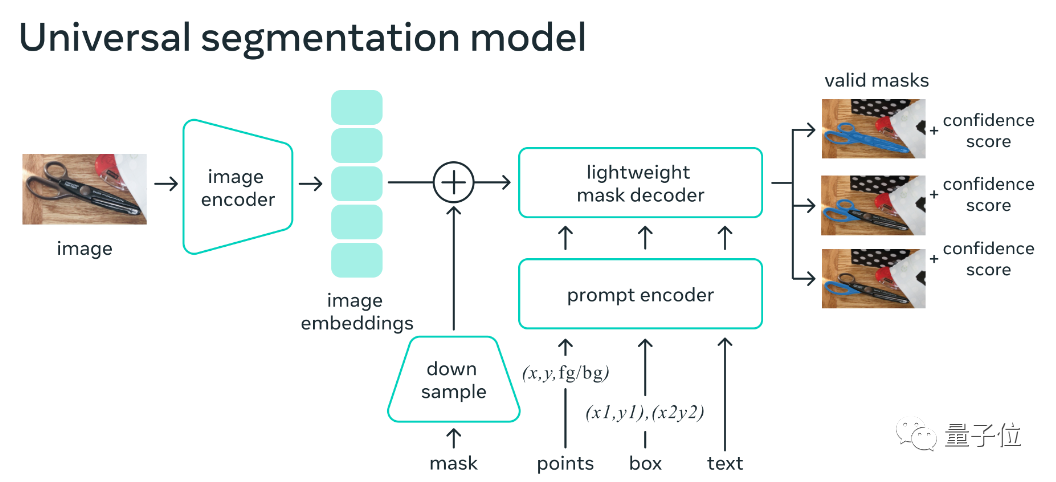

其中SAM(Segment Anything)是4天前Meta剛剛推出的零樣本分割模型。

它可以為圖像/視頻中的任何物體生成mask,包括訓練過程中沒出現過的物體和圖像。

通過讓SAM對于任何提示都返回有效的mask, 能夠讓模型在即使提示是模糊的或者指向多個對象的情況下,輸出也應該是所有可能中一個合理的mask。這一任務用于預訓練模型并通過提示解決一般的下游分割任務。

模型框架主要由一個圖像編碼器、一個提示編碼器和一個快速mask解碼器組成。在計算圖像嵌入后,SAM能夠在50毫秒內根據web中的任何提示生成一個分割。

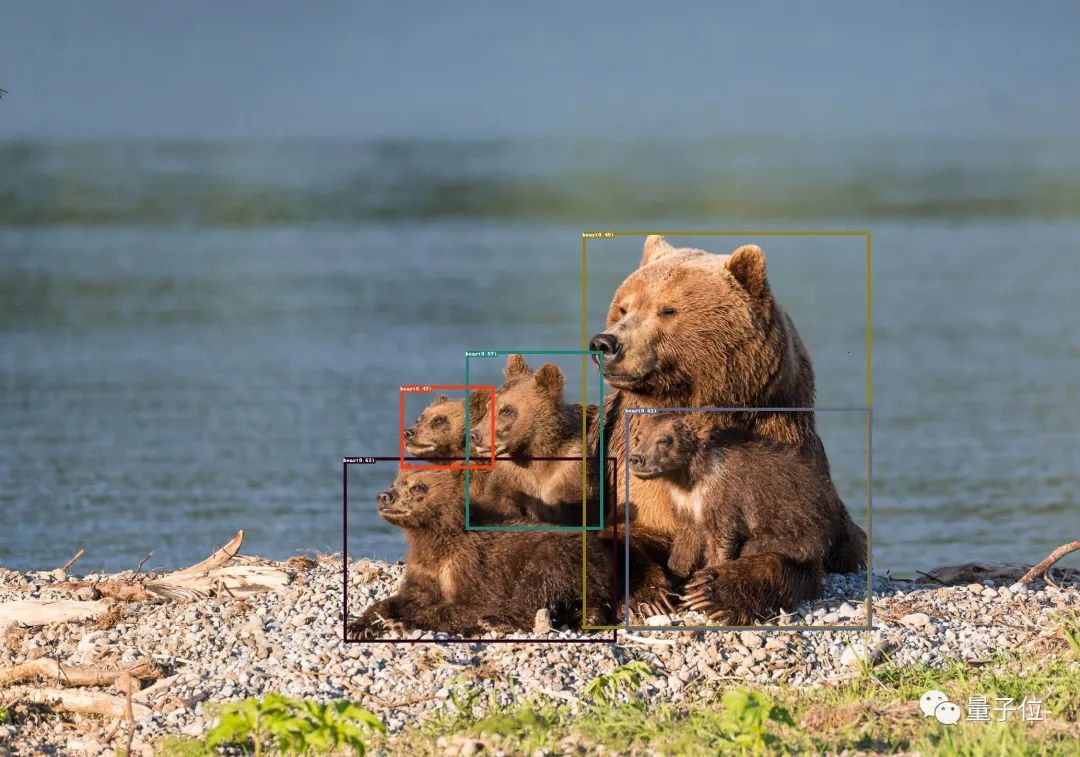

Grounding DINO是該研究團隊已有的成果。

這是一個零樣本檢測模型,能夠生成帶有文字描述的物體box和標簽。

二者結合后,可以通過文本描述找到圖片中的任意物體,然后通過SAM強大的分割能力,細粒度地分割出mask.

在這些能力之上,他們還疊加了Stable Diffusion的能力,也就是開頭所展示的可控圖像生成。

值得一提的是,Stable Diffusion此前也能夠實現類似功能。只要涂抹掉想替換的圖像元素,再輸入文本提示就可以。

這一回,Grounded SAM能夠省去手動選區這個步驟,直接通過文本描述來控制。

另外結合BLIP(Bootstrapping Language-Image Pre-training),生成圖片標題、提取標簽,再生成物體box和mask。

目前,還有更多有趣的功能正在開發中。

比如人物方面的一些拓展:更換衣服、發色、膚色等。

具體食用方法也已在GitHub上給出。項目需要Python 3.8以上版本,pytorch 1.7以上版本,torchvision 0.8以上版本,并要安裝相關依賴項。具體內容可看GitHub項目頁。

該研究團隊來自IDEA研究院(粵港澳大灣區數字經濟研究院)。

公開消息顯示,該研究院是一所面向人工智能、數字經濟產業及前沿科技的國際化創新型研究機構,前微軟亞研院首席科學家、前微軟全球智行副總裁沈向洋博士擔任創始人及理事長。

One More Thing

對于Grounded SAM的未來工作,團隊有幾點展望:

- 自動生成圖像構成新數據集

- 具有分割預訓練的強大基礎模型

- 和(Chat-)GPT合作

- 構成一個自動生成圖像標簽、box和mask的pipeline,并能生成新的圖像。

值得一提的是,該項目的團隊成員中,有不少都是知乎AI領域活躍的答主,這次也在知乎上自答了關于Grounded SAM的內容,感興趣的童鞋可以去留言請教~