Prompt都不需要了,動動手就能玩多模態對話系統,iChat來啦!

夕小瑤科技說 原創

作者 | 智商掉了一地

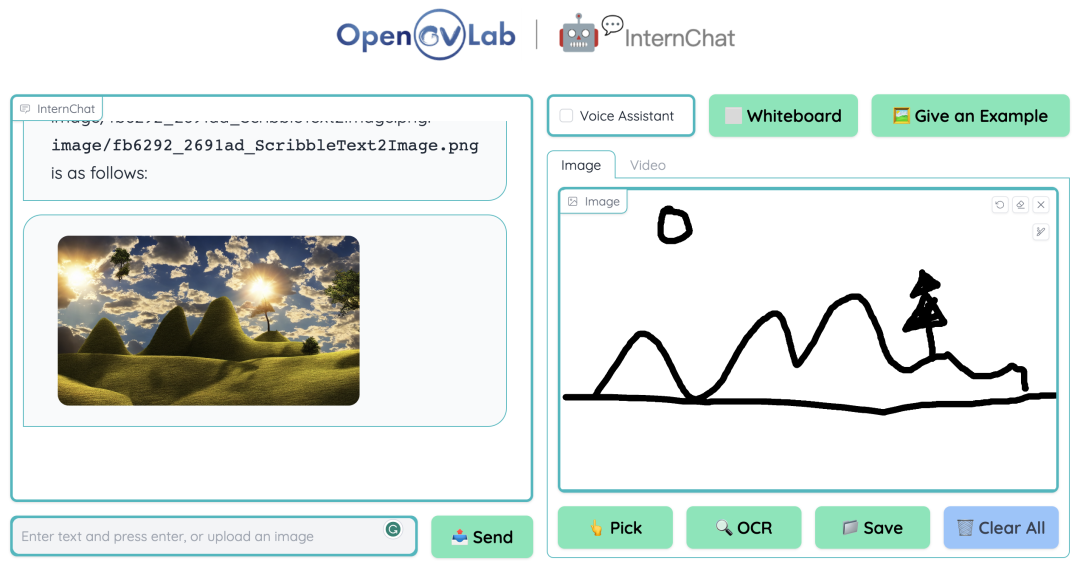

近日有很多團隊基于用戶友好的 ChatGPT 進行再創作,其中不乏有比較亮眼的成果。InternChat工作強調了用戶友好性,這是通過超越語言的方式(光標與手勢)與聊天機器人交互來進行多模態任務的。InternChat 的命名也比較有趣,代表著互動(interaction)、非語言(nonverbal)和聊天機器人(chatbots),可以簡稱為iChat。與現有依賴純語言的交互系統不同,iChat 通過加入指向指令,顯著提高用戶與聊天機器人之間的交流效率。此外,作者還提供了一個名為哈士奇(Husky)的大型視覺語言模型,可以進行 capture 和視覺問答,在僅用 70 億參數的情況下,也能給 GPT-3.5-turbo 留下深刻印象。

不過由于 Demo 網站過于火爆,團隊官方暫時關停了體驗頁面,咱們先通過下面這個視頻來了解這項工作內容吧~

論文題目:

InternChat: Solving Vision-Centric Tasks by Interacting with Chatbots Beyond Language

論文鏈接:

https://arxiv.org/abs/2305.05662

Demo 地址:

https://ichat.opengvlab.com/

項目地址:

https://github.com/OpenGVLab/InternChat/

系統主要特點

作者在項目首頁上提供了一些任務截圖,可以直觀地看到這個交互系統的一些功能與效果:

(a)移除遮蓋的對象

(b)交互式圖像編輯

(c)圖像生成

(d)交互式視覺問答

(e)交互式圖像生成

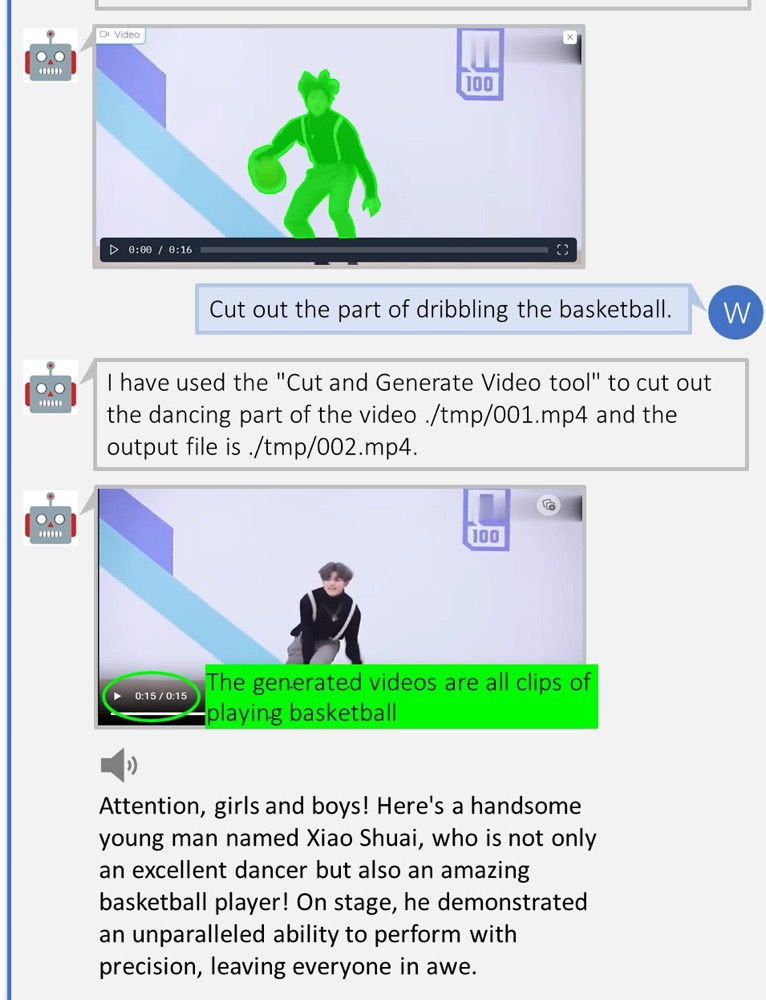

(f)視頻高光解釋

論文速覽

這里首先介紹本文中提及的兩個概念:

- 以視覺為中心的任務:為了讓計算機能夠理解它們從世界中看到的內容并做出相應反應。

- 非語言指令形式的交流:光標和手勢之類的指向動作。

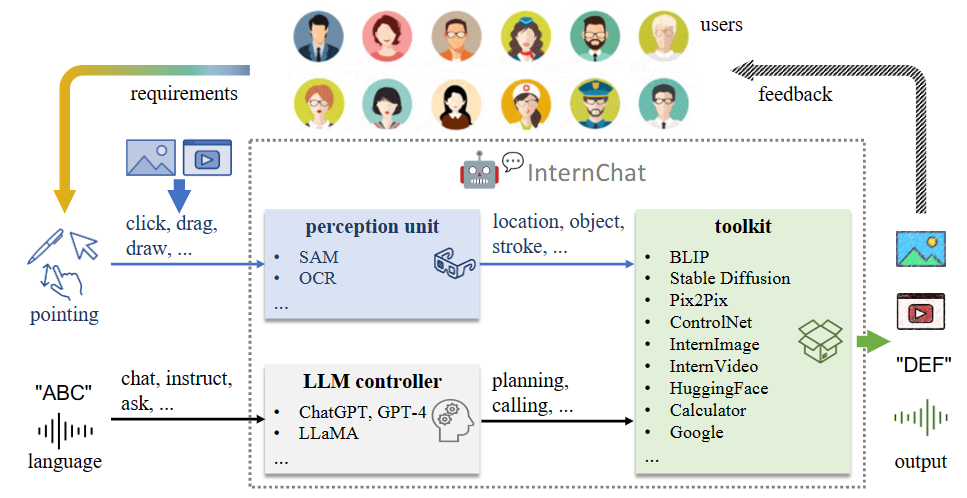

▲圖1 iChat 的整體架構

iChat 結合指向和語言指令的優勢來執行以視覺為中心的任務。如圖 1 所示,這個系統由 3 個主要組件組成:

- 處理圖像或視頻上指向指令的感知單元;

- 具有可以準確解析語言指令的輔助控制機制的 LLM 控制器;

- 集成 HuggingFace 各種在線模型、用戶訓練的私人模型以及其他應用(如計算器、搜索引擎)的開放世界工具包。

它可以在 3 個層級上有效運行,分別是:

- 基礎交互;

- 語言引導的交互;

- 指向-語言增強的交互。

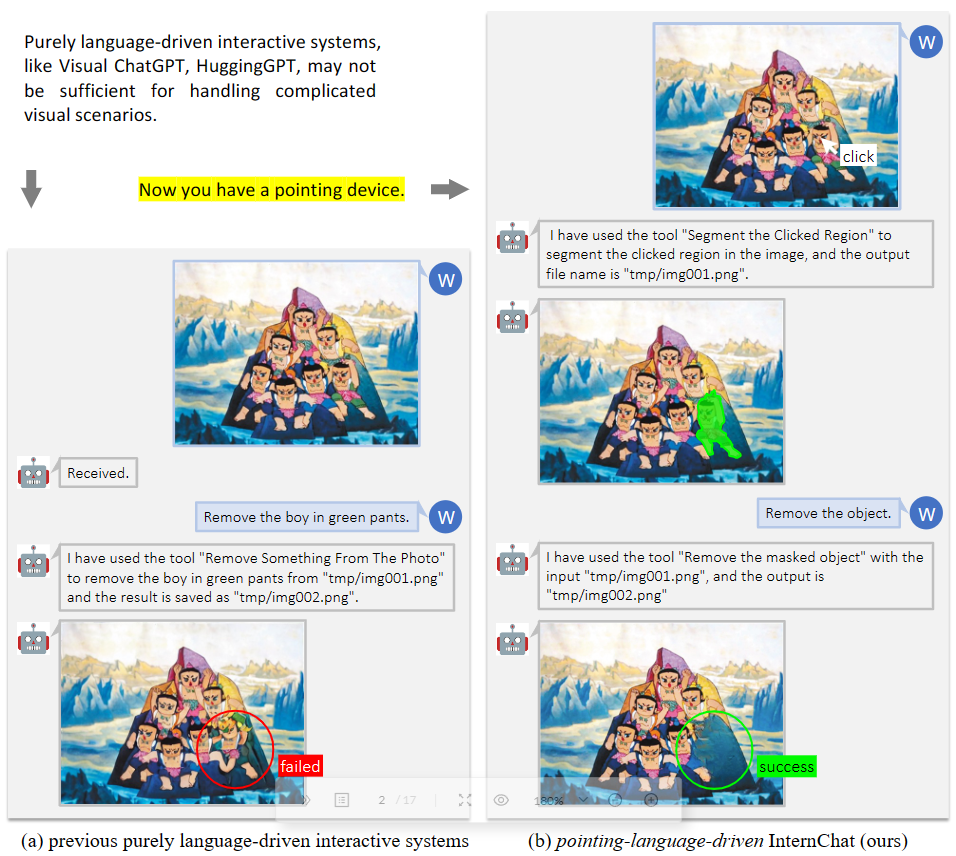

由此,如圖 2 所示,當純語言的系統無法完成任務時,該系統仍可以成功執行復雜的交互任務。

▲圖2 指向-語言驅動的交互系統優勢

實驗

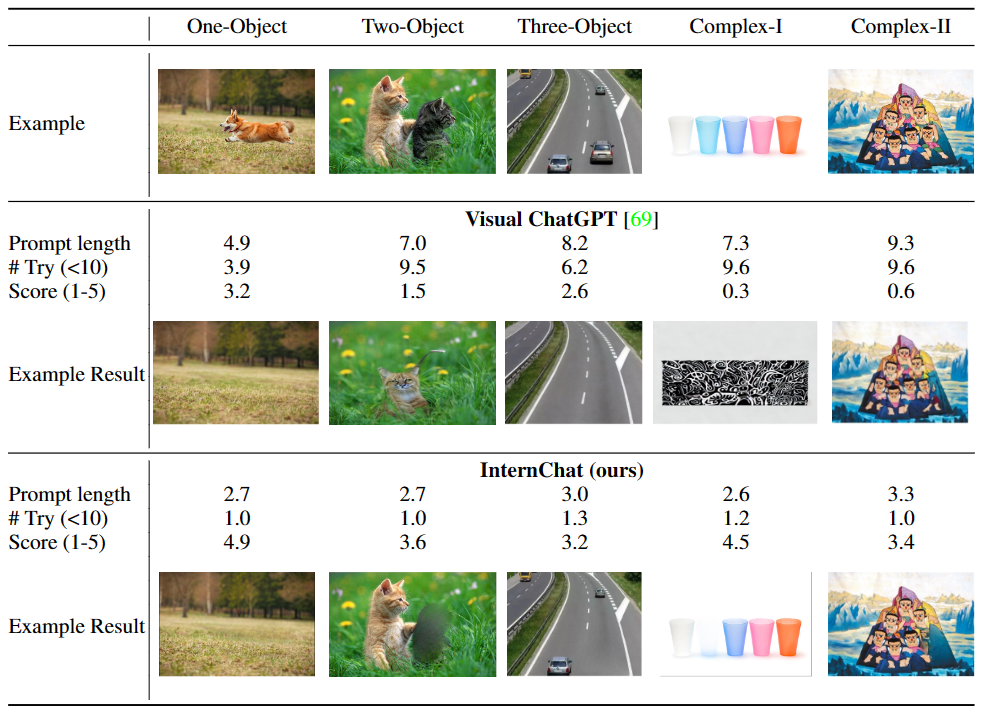

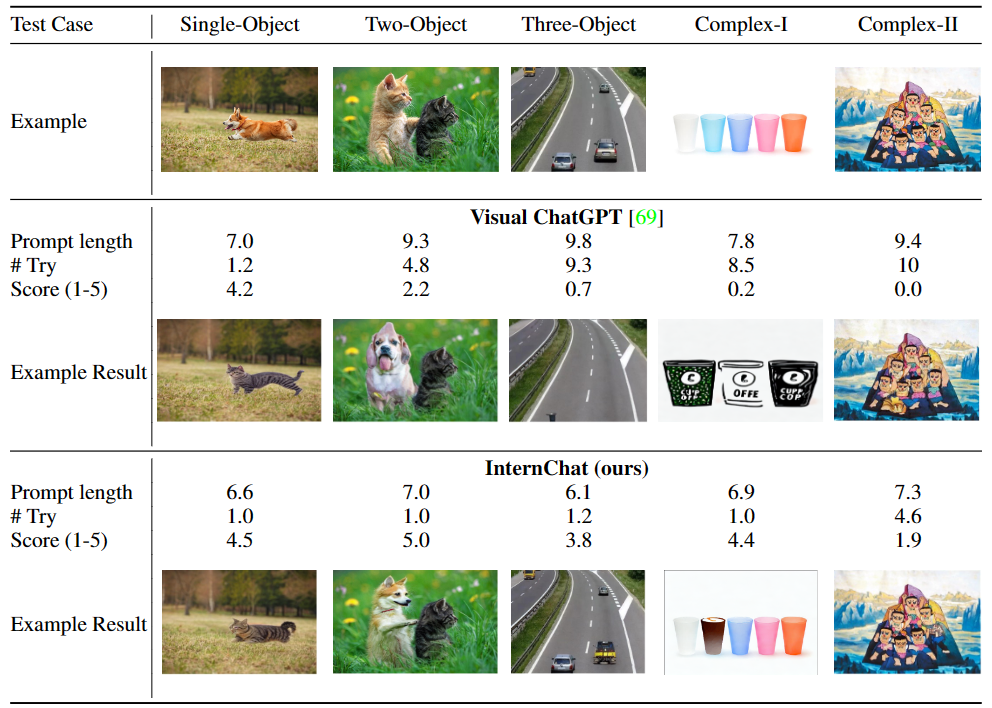

首先我們來看,同時結合語言和非語言指令來提升用于與交互系統之間的溝通效果。為了證明這種混合模式與單純語言指令相比的優點,研究團隊進行了一個用戶調查。參與者與 Visual ChatGPT 和 iChat 聊天,并反饋他們的使用感受。表 1 和 2 的結果表明,iChat 比 Visual ChatGPT 更高效且對用戶友好。

▲表1 “移除某物”的用戶調查

▲表2 “用某物代替某物”的用戶調查

小結

不過,目前該系統仍存在著一些局限性,包括了:

- iChat 的高效性在很大程度上取決于其底層開放源代碼模型的質量和準確性。然而,這些模型可能存在一些局限或偏見,進而對 iChat 的性能造成不利影響。

- 隨著用戶交互變得更加復雜或實例數量增多,系統需要維護準確性和響應時間,這對于 iChat 來說可能具有挑戰性。

- 此外,當前的視覺和語言基礎模型之間缺乏可學習的協作,例如缺乏被指令數據調整的功能。

- iChat 可能會在應對訓練數據之外的新穎或不常見情況時遇到困難,導致性能受到影響。

- 在不同設備和平臺上實現無縫集成可能會面臨挑戰,因為硬件能力、軟件限制和可訪問性要求各不相同。

在項目主頁列出的計劃清單上,目前還有幾項目標尚未達成,其中就有小編每次在新的對話系統上都要體驗的中文交互,目前該系統應該還是暫不支持中文問題,不過這貌似沒辦法,由于多模態數據集多是基于英文的,英漢互譯較為浪費線上資源和處理時間,估計漢化之路還是需要一段時間的。