ControlNet大更新:僅靠提示詞就能精準P圖,保持畫風不變,網友:效果堪比定制大模型

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

Stable Diffusion插件、“AI繪畫細節控制大師”ControlNet迎來重磅更新:

只需使用文本提示詞,就能在保持圖像主體特征的前提下,任意修改圖像細節。

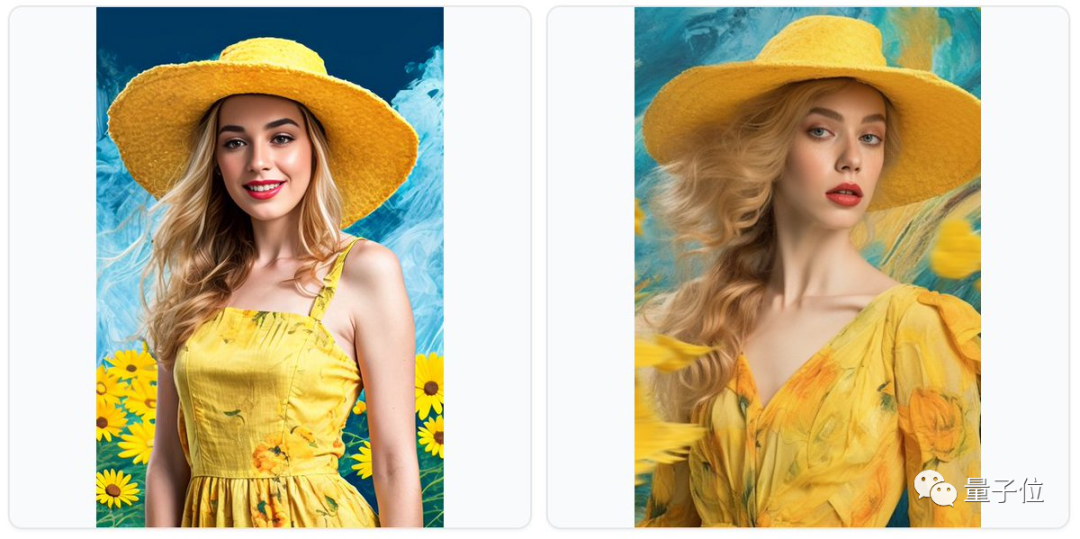

比如給美女從頭發到衣服都換身造型,表情更親和一點:

抑或是讓模特從甜美鄰家女孩切換到高冷御姐,身體和頭部的朝向、背景都換個花樣兒:

——不管細節怎么修改,原圖的“靈魂”都還在。

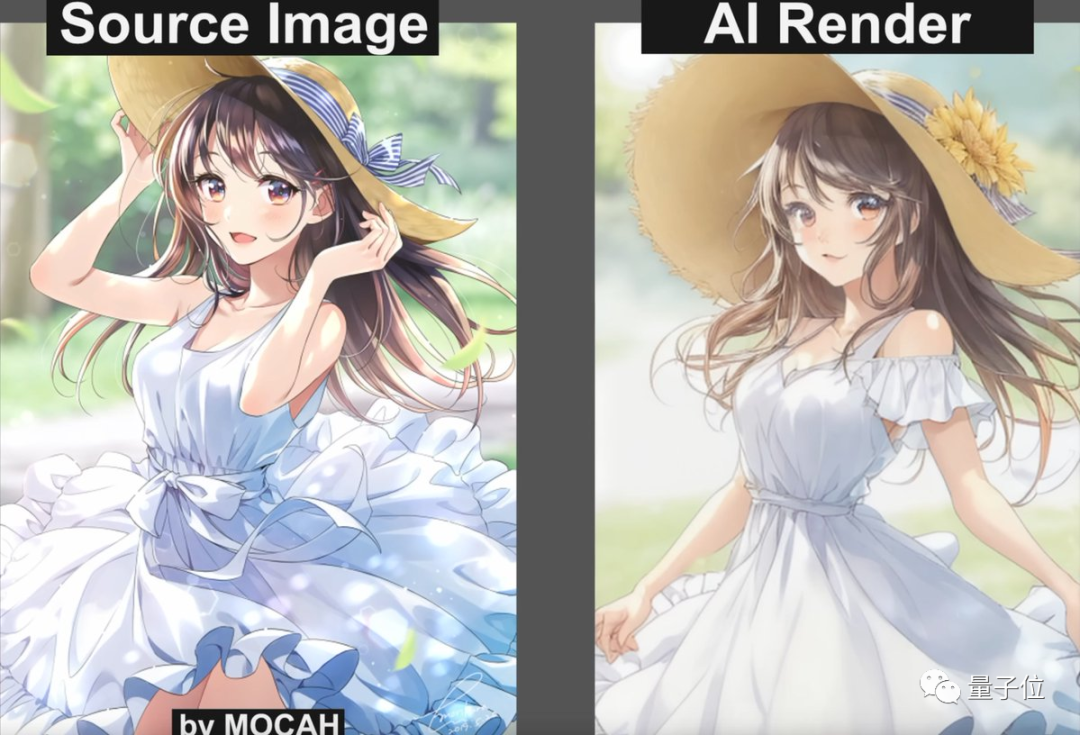

除了這種風格,動漫類型的它也能駕馭得恰到好處:

來自推特的AI設計博主@sundyme就稱:

效果比想象得要好!

只需要一張參考圖就能完成以上轉變,部分圖片幾乎可以達到定制大模型的效果了。

咳咳,各位AI繪畫圈的朋友們,打起精神來,又有好玩的了。

(ps. 第一三張效果圖來自博主@Olivio Sarikas,第二張來自推特博主@sundyme)

ControlNet上新:保留原圖畫風的修圖功能

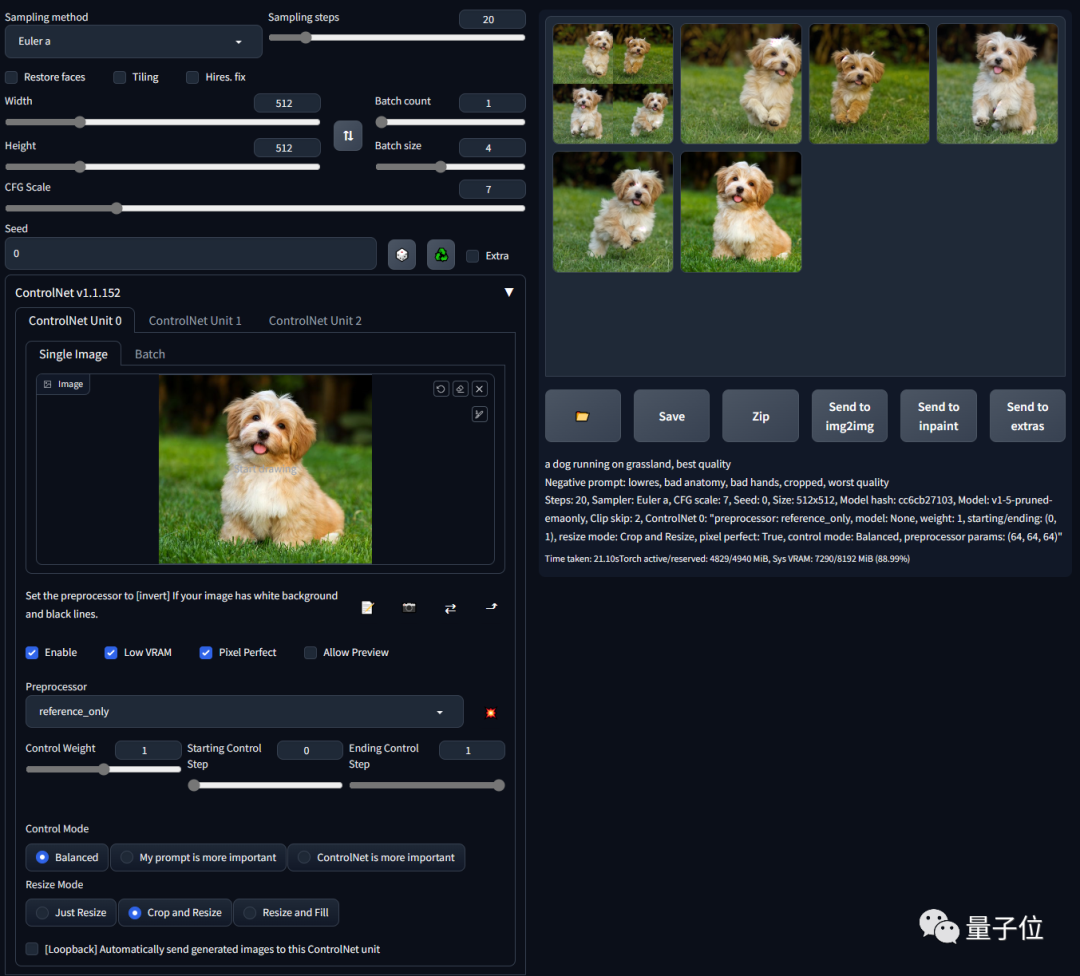

以上更新內容,其實指的是一個叫做“reference-only”的預處理器。

它不需要任何控制模型,直接使用參考圖片就能引導擴散。

作者介紹,這個功能其實類似于“inpaint”功能,但不會讓圖像崩壞。

(Inpaint是Stable Diffusion web UI中的一個局部重繪功能,可以將不滿意、也就是被手工遮罩的地方進行重新繪制。)

一些資深玩家可能都知道一個trick,就是用inpaint來進行圖像擴散。

比如你有一張512x512的狗的圖像,然后想用同一只狗生成另一張512x512的圖像。

這時你就可以將512x512的狗圖像和512x512的空白圖像連接到一張1024x512的圖像中,然后使用inpaint功能,mask掉空白的512x512部分,漫射出具有相似外觀的狗的形象。

在這個過程中,由于圖像只是簡單粗暴的進行拼接,加上還會出現失真現象,所以效果一般都不盡如人意。

有了“reference-only”就不一樣了:

它可以將SD(即“Stable Diffusion”)的注意力層直接鏈接到任何獨立的圖像,方便SD直接讀取這些圖像作為參考。

也就是說,現在你想要在保持原圖風格的前提下進行修改,使用提示詞直接在原圖上就能操作。

如官方示例圖將一只靜立的小狗改成奔跑動作:

你只需要將你的ControlNet升級到1.1.153版本以上,然后選擇“reference-only”作為預處理器,上傳狗的圖片,輸入提示詞“a dog running on grassland, best quality……”,SD就只會用你的這張圖作為參考進行修改了。

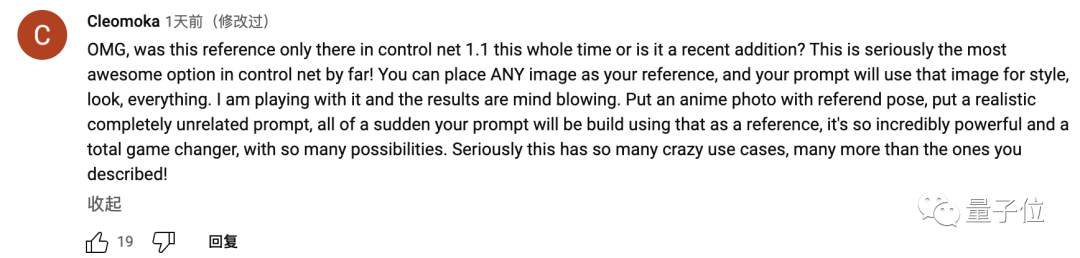

網友:ControlNet迄今最好的一個功能

“reference-only”功能一出,有不少網友就上手體驗了。

有人稱這是ControlNet迄今為止最棒的一個功能:

傳一張帶有人物姿勢的動漫圖片,再寫一句看上去跟原圖完全無關的提示。突然之間,你想要的效果就在原圖的基礎上跑出來了。真的很強,甚至說是達到了改變游戲規則的程度。

還有人稱:

是時候把以前丟棄的廢圖都撿回來重新修復一下了。

當然,認為它也不是那么完美也有(比如開頭第一張效果圖里美女的耳環不對,二張圖里頭發也都是殘缺的),但網友還是表示“總歸方向是對了”。

以下是三位推特博主嘗試的效果,主要都是動漫風,一起欣賞一下:

△來自@新宮ラリのAIイラストニュ

△來自@br_d,左一為原圖

△來自@br_d,上一為原圖

△來自@uoyuki667,左一為原圖

有沒有戳中你的心巴?