清華開源圖文對話大模型!表情包解讀有一手,奇怪的benchmark增加了

什么,最懂表情包的中文開源大模型出現了??!

就在最近,來自清華的一個叫VisualGLM-6B的大模型在網上傳開了來,起因是網友們發現,它連表情包似乎都能解讀!

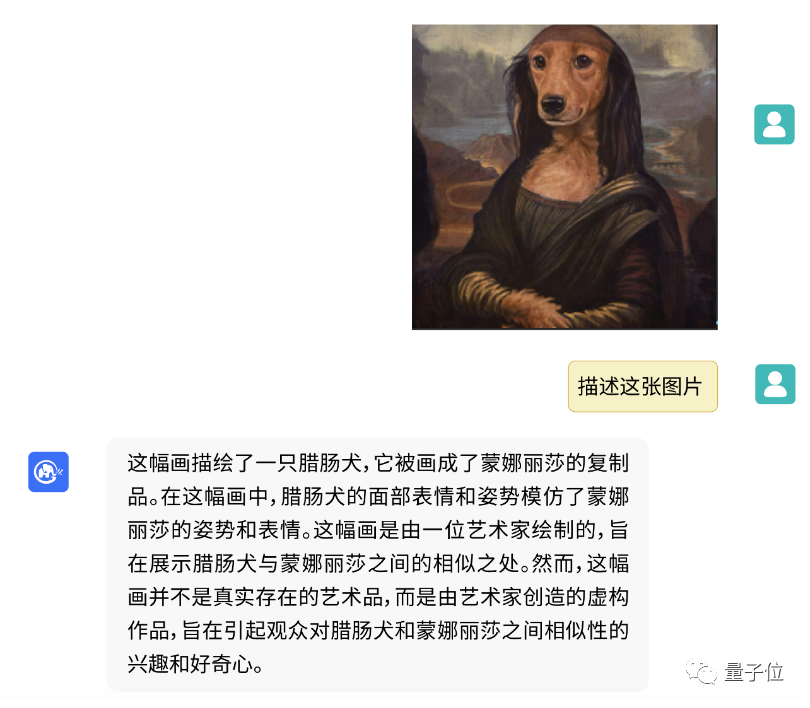

像這個臘腸犬版蒙娜麗莎,它不僅準確理解了這是臘腸犬與蒙娜麗莎的“合體照”,還點出了這只是一幅虛構作品:

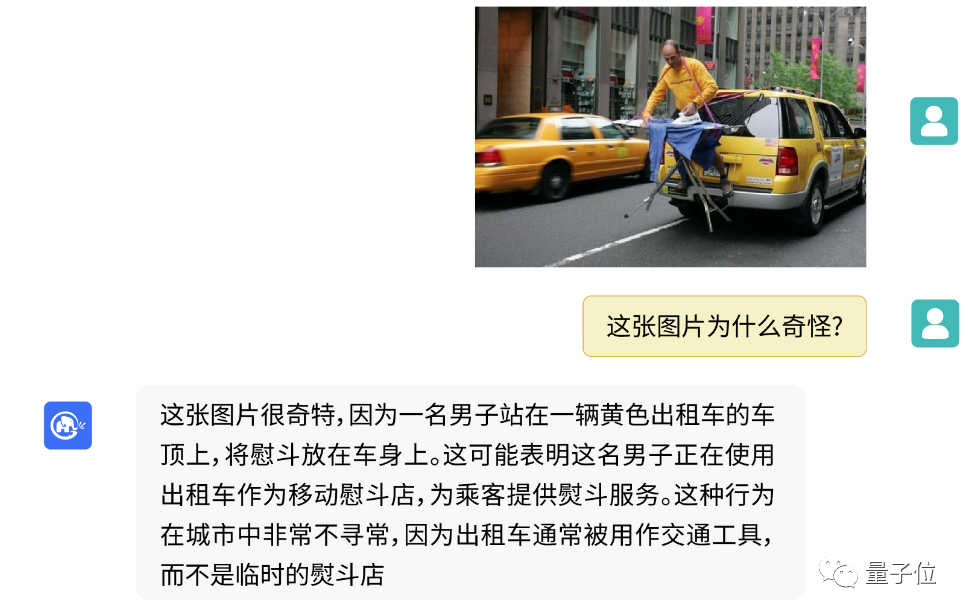

又像是這個正在出租車后熨衣斗的男子,它也一眼看出了“不對勁”的地方:

值得一提的是,在此前GPT-4剛發布時,網友們也同樣將它用來測了測常識理解能力:

就如同弱智吧問題是大模型語言理解能力的benchmark一樣,表情包簡直就是大模型圖片理解能力的benchmark。

要是它真能理解網友們奇奇怪怪的表情包,那AI簡直沒有什么不能get到的信息點了啊!

我們趕緊測試了一波,看看它究竟效果如何。

gif也能看懂,但解讀太過正經

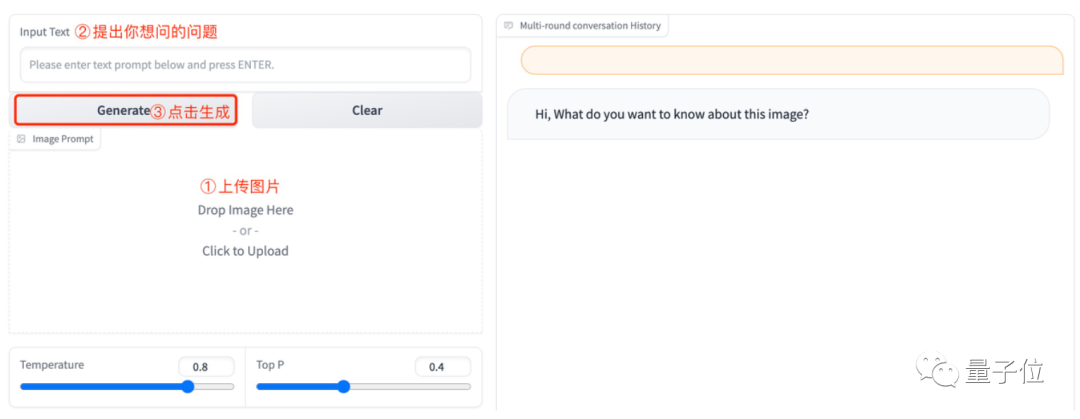

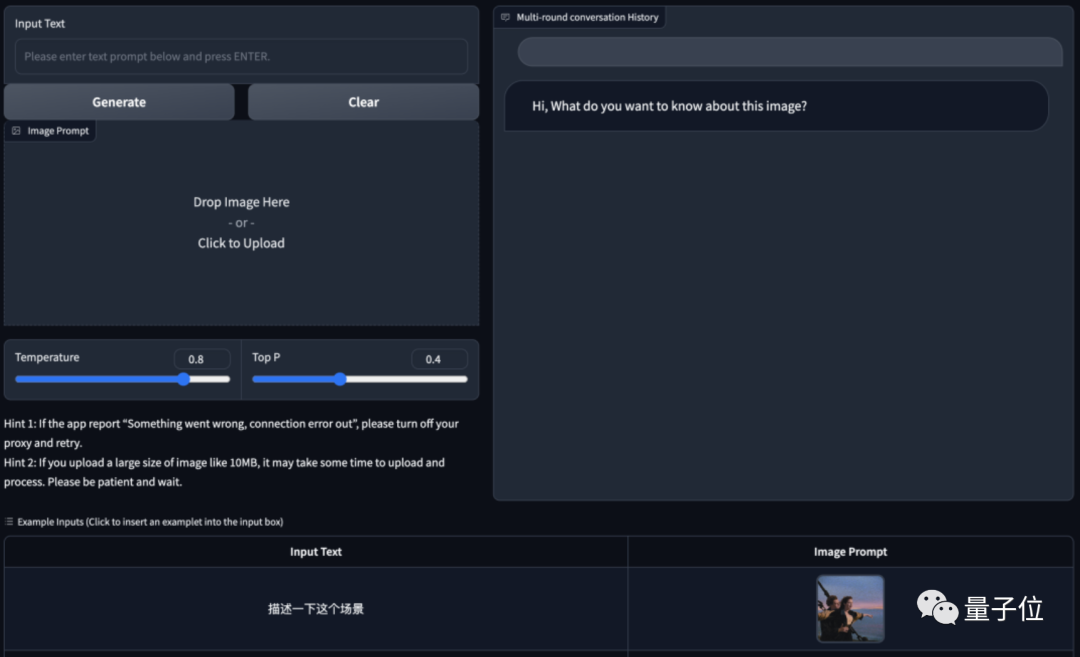

目前,VisualGLM-6B已經推出了網頁端試玩版。

只需要在Hugging Face的試玩界面上傳圖片,再與它進行“對話”,它就能生成理解圖片的結果:

先試試初級難度的表情包。

官方給出了幾個問題示例,例如“描述一下這個場景”、“這是什么東西”、“這張圖片描述了什么”,我們就先嘗試一下這幾個問題。

輸入一只正在聽歌的小貓,讓VisualGLM-6B描述一下表情包中的場景:

還不錯,VisualGLM-6B準確get了小貓享受音樂或使用電子設備這個過程!

再輸入一個章魚哥表情包,問它“這是什么東西”:

也沒問題。看起來能拿給爸媽用了(手動狗頭)。

再試試用吃飯小狗,讓VisualGLM-6B解讀一下這張圖片描述了什么:

看起來初級表情包都沒什么問題,是時候加大力度了。

上傳一個gif試試?第一眼似乎沒有問題:

但再換一個gif試試就會發現,它似乎只理解了第一幀圖像,猜測是不是“主角在試圖抓住或捕捉它”,但實際上只是在扔鈔票:

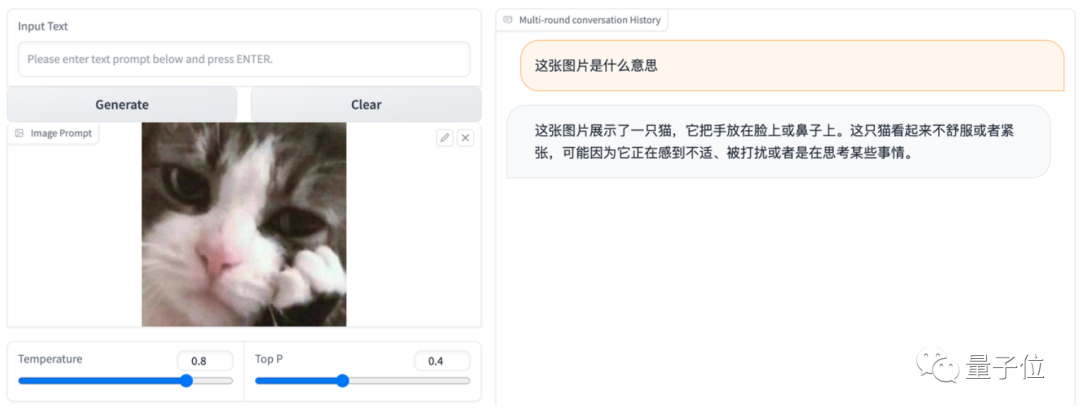

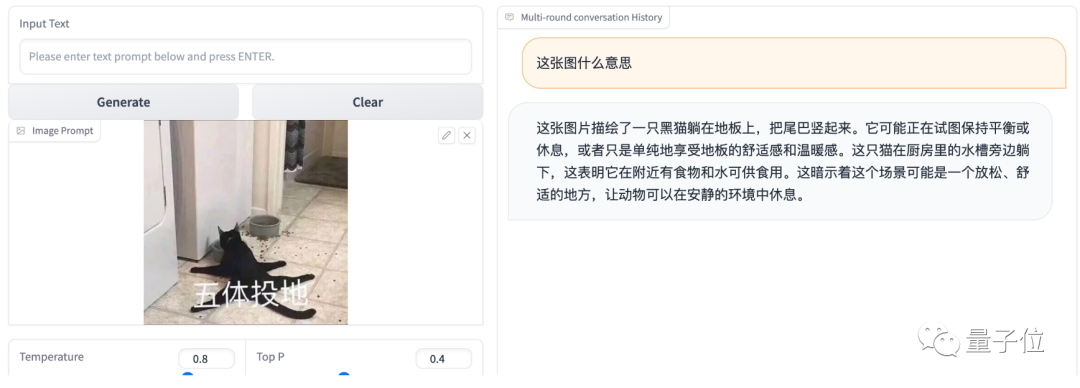

與之前的一些圖片理解AI不同,VisualGLM-6B在解讀時會著重介紹表情包角色中的面部表情,例如“它看起來不舒服或者緊張”:

BUT!當我們再上一點難度,給表情包配上文字之后,它就無法理解表情包的含義了:

尤其是這種靠配文傳達表情包精髓的,VisualGLM-6B就會開始展現“瞎解讀”的功底:

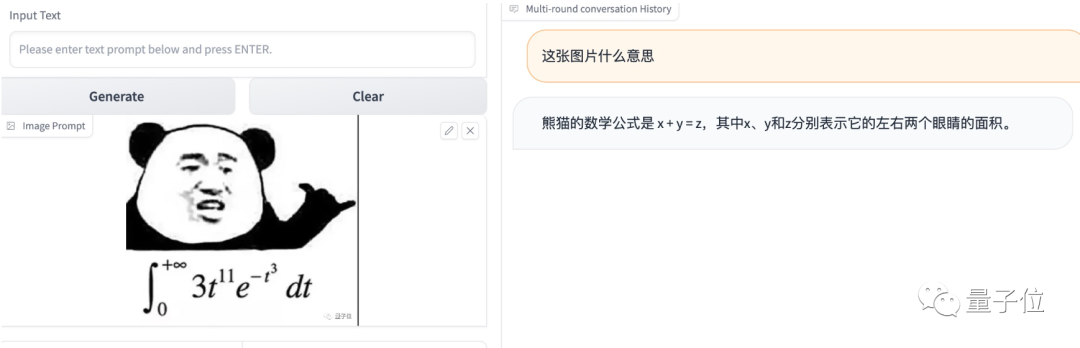

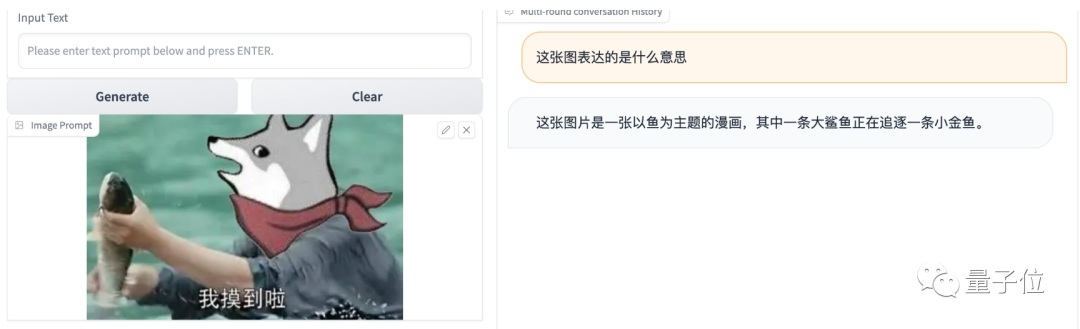

如果圖像拼接太多,它還會出現奇怪的bug,例如把摸魚狗頭人認成大鯊魚:

而且,它在描述表情包的時候整體比較正經,不會解讀圖像以外的“用意”。

例如,有網友測試了一下經典的“熊貓人顯卡”表情包:

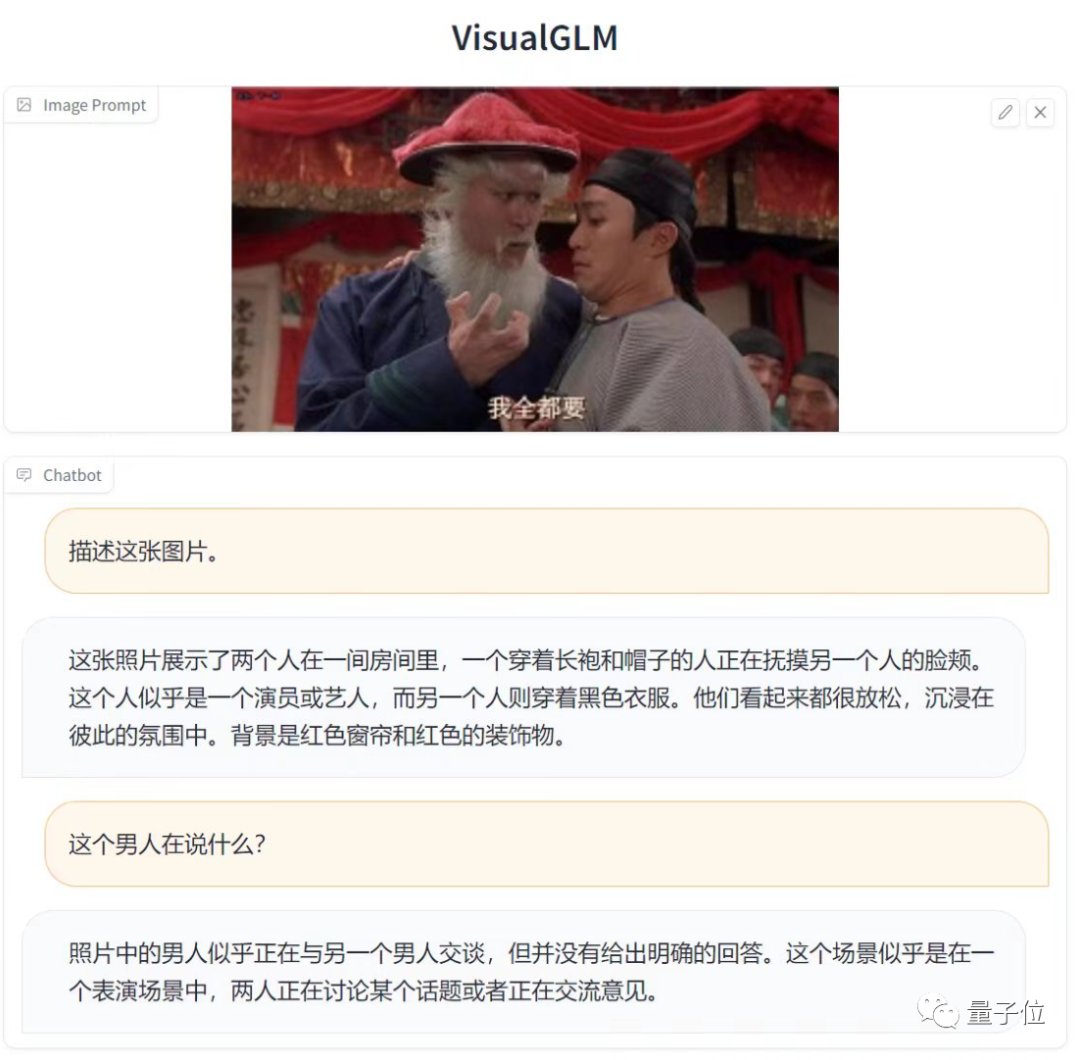

以及周星馳的經典“我全都要”表情包:

顯然VisualGLM-6B能大致理解圖片的場景,但對于表情包的配文就無法理解了。

總結一下,對于包含經典作品角色的表情包,或是經過文字加工前的“原始”表情包,VisualGLM-6B能說出這個角色的名字,或是描述出其中的場景:

雖然也可以讓它描述情緒,不過AI看出來的情緒,可能和最終表情包表達的情緒不太一樣:

但一旦表情包加上了文字、或是被P進了新場景,VisualGLM-6B就會因為無法解讀圖片中文字的意思,而變得“看不懂梗”了。

△有時候還會解讀錯亂,例如狗看成豬

那么,擁有一部分解讀表情包能力的VisualGLM-6B,究竟是什么來頭?

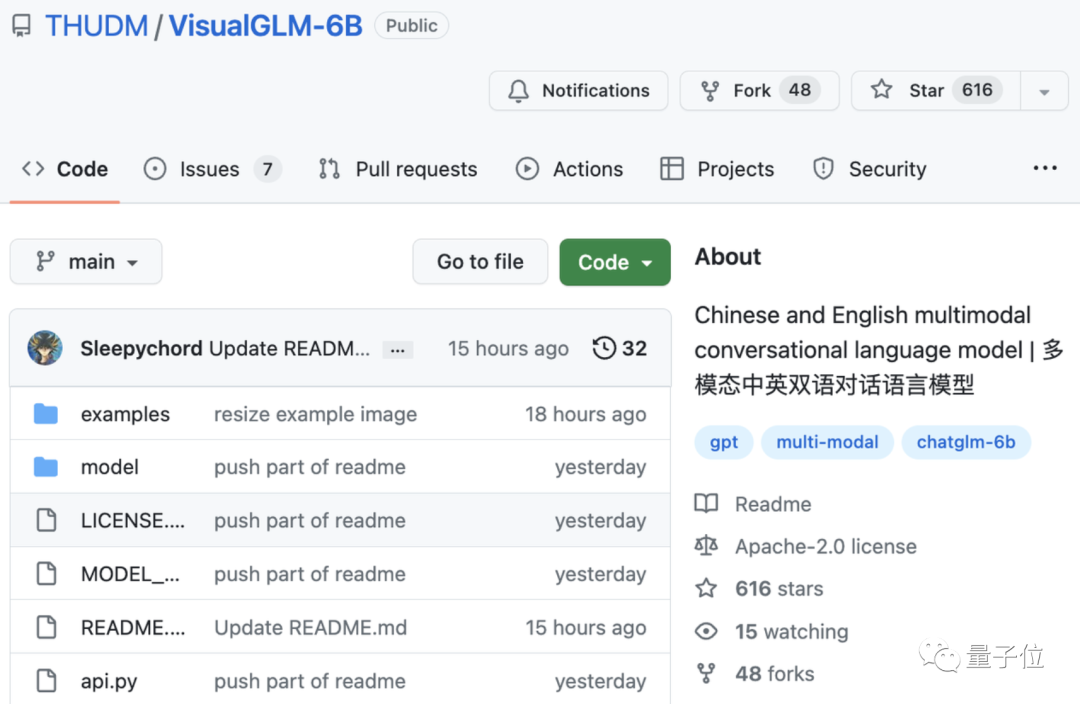

多模態對話VisualGLM-6B,最低只需8.7G顯存

事實上,VisualGLM-6B并非專門為“表情包解讀”而開發。

它是由智譜AI和清華大學KEG實驗室打造的開源多模態對話模型,主要用于中文圖像理解,解讀表情包可以說只是它被開發出來的一個“副業”。

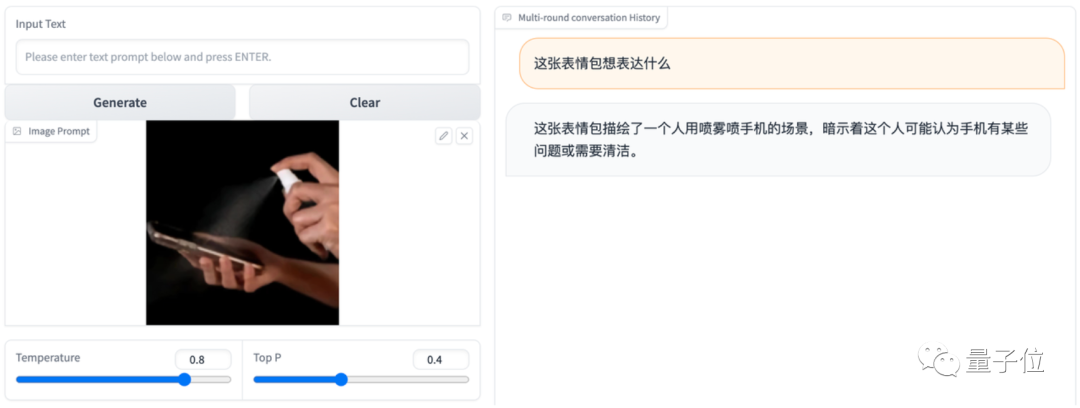

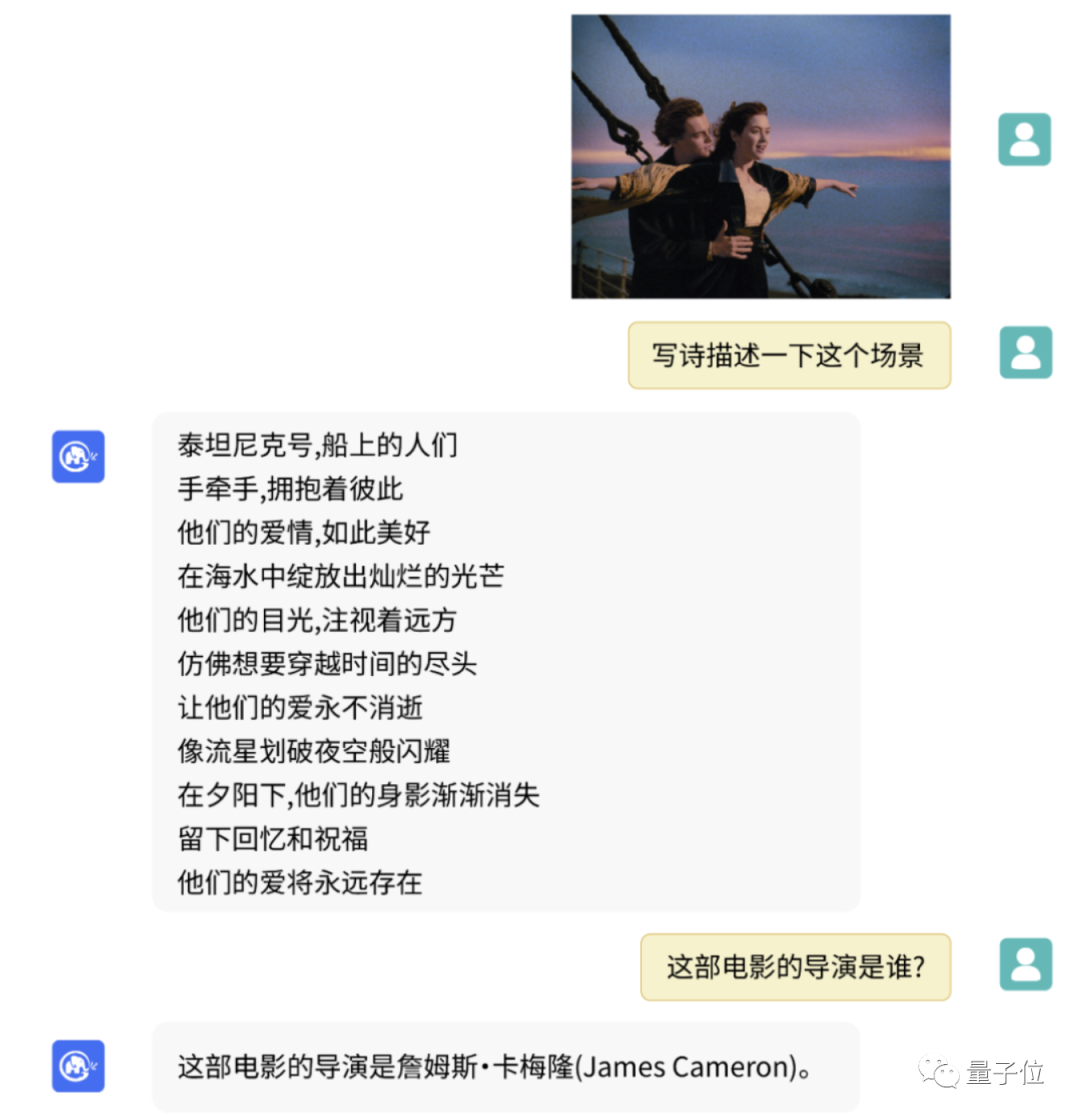

它的正經用法,一般是醬嬸的:

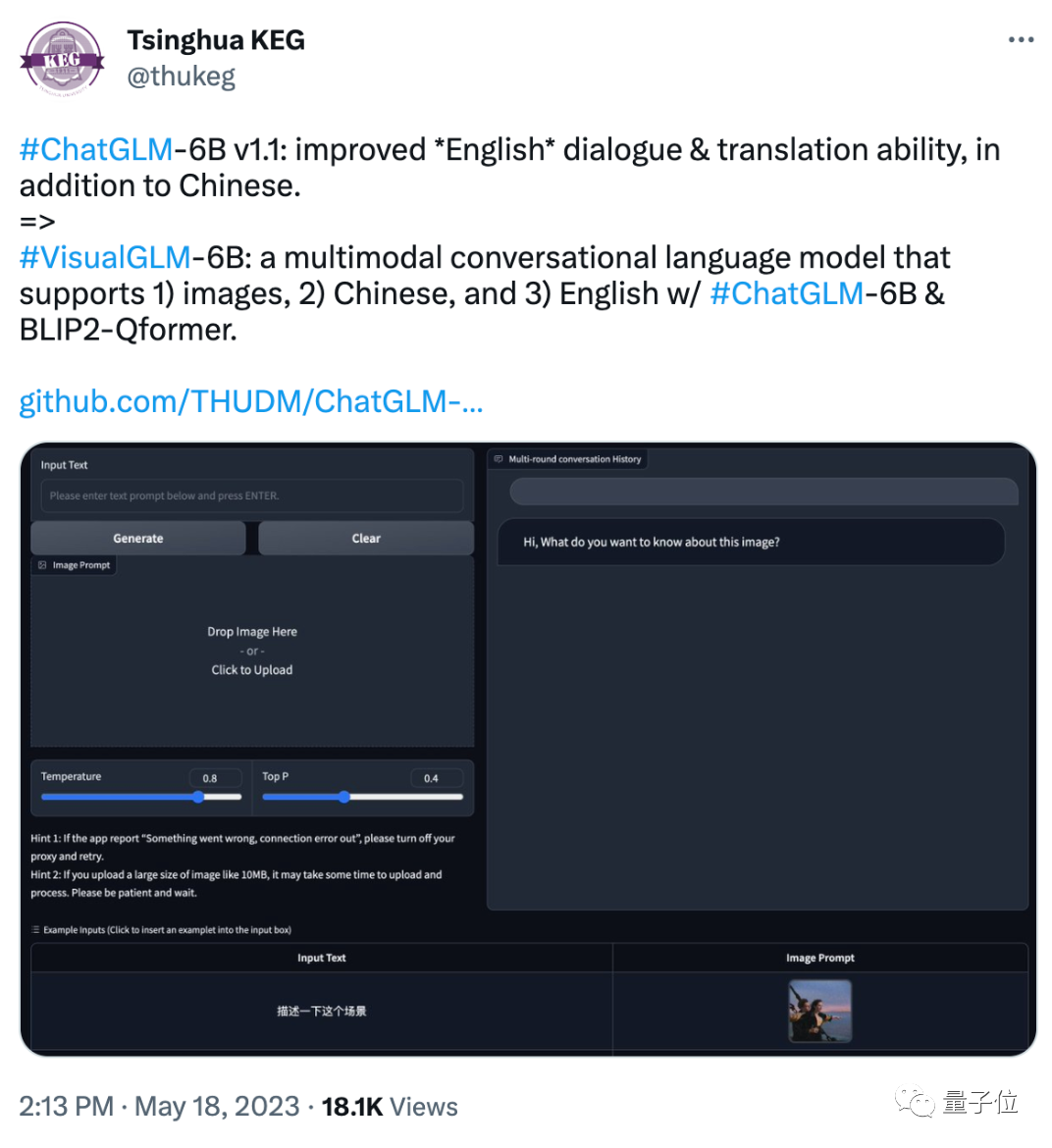

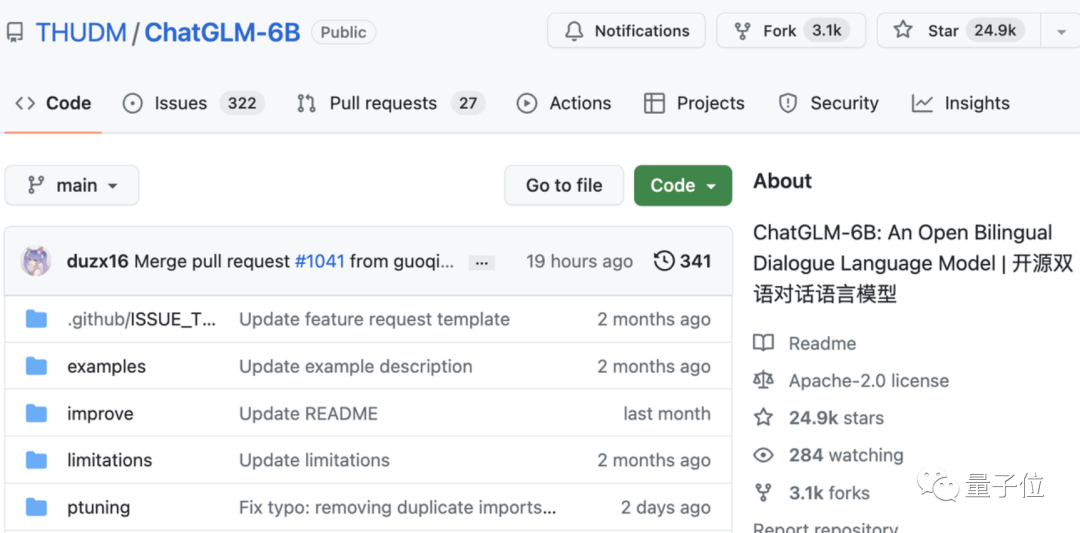

提起這個團隊,大家更熟悉的可能是ChatGLM-6B大模型。

后者此前我們有作介紹:

它是“清華系ChatGPT”的一員,2022年8月發布,共62億規模參數,支持中英雙語對話。

上線4天就突破6k star,目前已經近25k。

據介紹,VisualGLM-6B正是在ChatGLM-6B的基礎上完成:

ChatGLM-6B負責它的語言模型部分,圖像部分則通過訓練BLIP2-Qformer構建起視覺模型與語言模型的“橋梁”。

因此,VisualGLM-6B整體模型共78億參數。

具體而言,VisualGLM-6B的預訓練在中英文權重相同的情況下,在30M高質量中文圖文對和300M經過篩選的英文圖文對上完成(來自CogView數據集)。

這一訓練方法可以將視覺信息對齊到ChatGLM的語義空間。

微調階段,VisualGLM-6B又在長視覺問答數據上訓練,以生成符合人類偏好的答案。

與此同時,VisualGLM-6B由SwissArmyTransformer (簡稱“sat” ) 庫訓練,這是一個支持Transformer靈活修改、訓練的工具庫,支持Lora、P-tuning等參數高效微調方法。

最終,本項目既提供了HuggingFace接口,也提供了基于sat的接口。

要說VisualGLM-6B最大的特點,便是結合模型量化技術,可以讓大家在消費級的顯卡上進行本地部署,INT4量化級別下最低只需8.7G顯存。

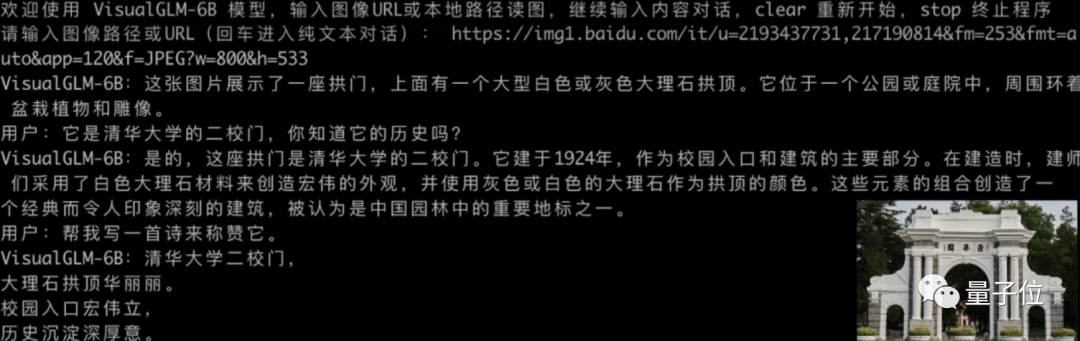

具體包含三種部署工具:

一是命令行Demo。執行命令:

python cli_demo.py

然后程序便自動下載sat模型,大家就可以在命令行中進行交互式的對話了。

輸入指示并回車即可生成回復,輸入clear可以清空對話歷史,輸入stop終止程序。

二是基于Gradio的網頁版Demo。

需要先安裝Gradio:pip install gradio,然后下載并進入本倉庫運行web_demo.py,最后在瀏覽器中打開系統輸出的地址即可使用。

三是API部署。需要安裝額外的依賴:pip install fastapi uvicorn,然后運行倉庫中的api.py。

更多細節和推理、量化部分的方法就不贅述了,可戳參考鏈接[1]查看官方介紹。

需要注意的是,如官方所述,VisualGLM-6B正處于V1版本,視覺和語言模型的參數、計算量都較小,因此會出現相當多的已知局限性,像圖像描述事實性/模型幻覺問題、圖像細節信息捕捉不足,以及一些來自語言模型的局限性等等。

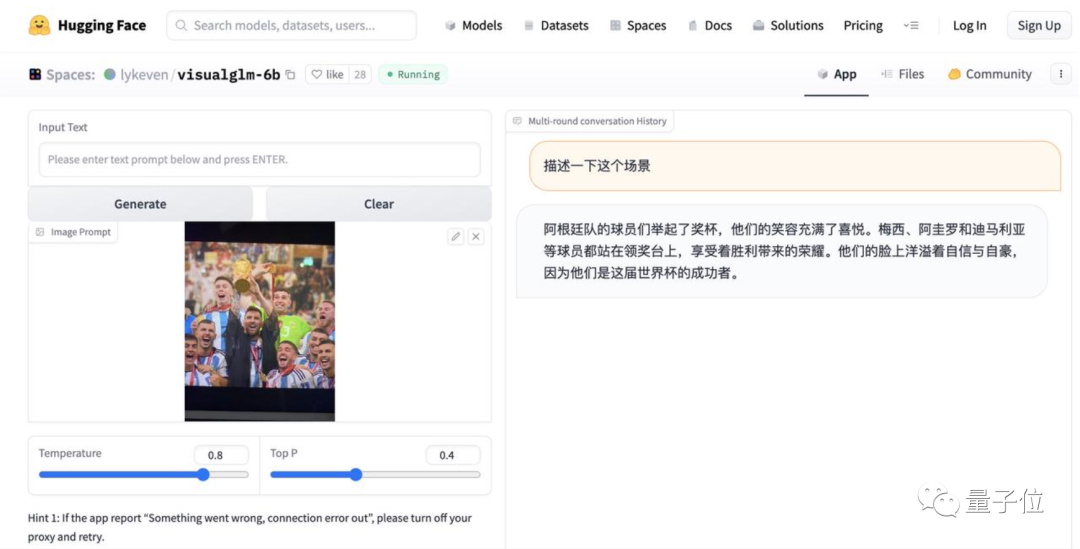

就如下面這張測試,VisualGLM-6B描述得還挺到位的,能看出是阿根廷和世界杯,但別被蒙了:圖上并沒有阿圭羅和迪馬利亞這兩位球星

。

因此,官方也稱將在后續繼續針對以上問題進行一一改進。

不過,擁有圖片解讀能力的大模型,也并不只有VisualGLM-6B一個。

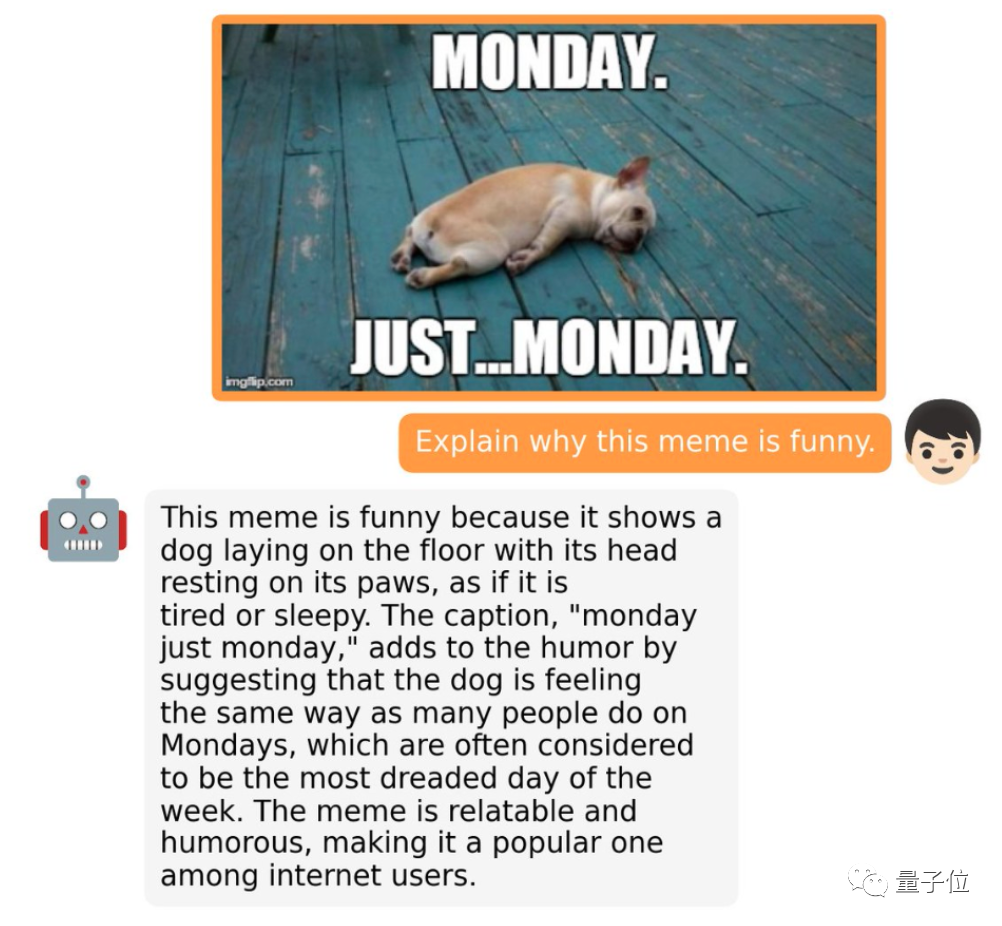

目前來看,表現比較好的“表情包殺手”還是GPT-4,從網友測試來看,它已經能根據表情包中的文字解讀meme:

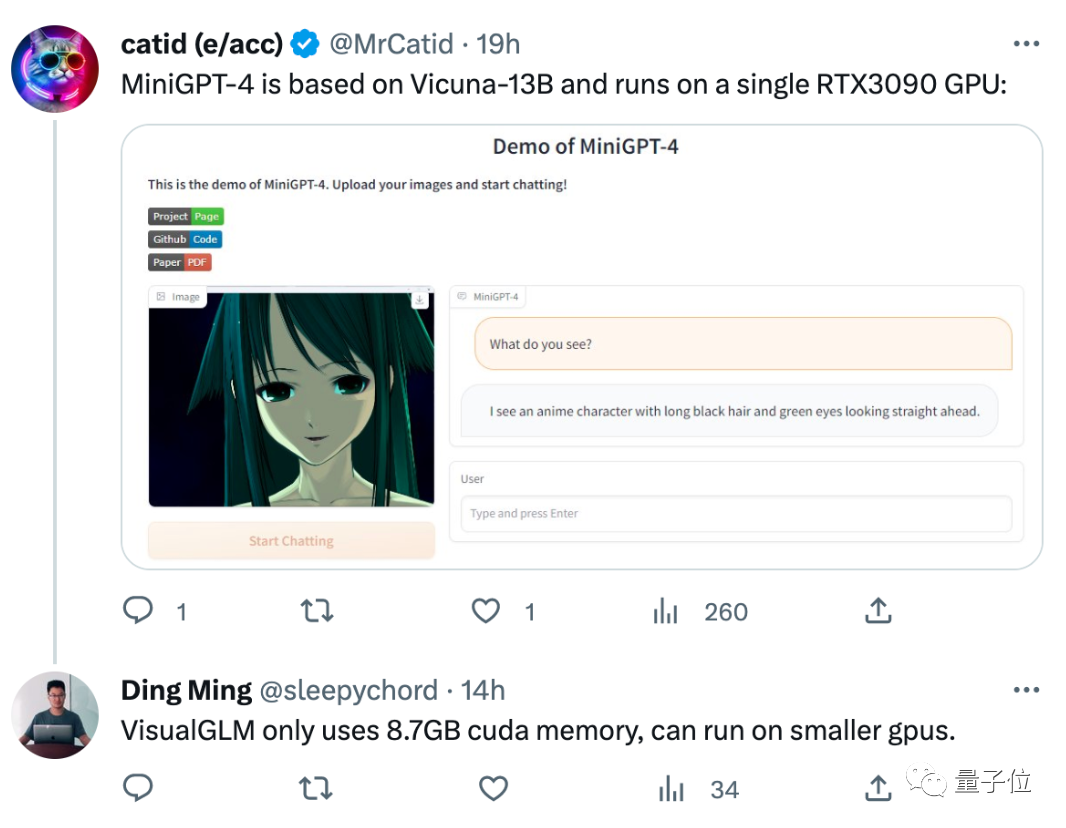

開源大模型方面,基于Vicuna-13B開發的MiniGPT-4也能解讀圖片,同樣只需要一張單卡RTX3090就能搞定:

不過在這批大模型中,VisualGLM-6B強調的則是“中文開源”特點,換而言之,它在中文描述上可能會比其他大模型更準確一些。

你試玩過這些“表情包解讀AI”了嗎?感覺誰更能get人類思想精華?(手動狗頭)

VisualGLM-6B試玩地址:

https://huggingface.co/spaces/lykeven/visualglm-6b

參考鏈接:

[1]https://mp.weixin.qq.com/s/SzS6Gx8ZjtBXXQ7cs8-zLQ

[2]https://twitter.com/thukeg/status/1659079789599248386