將入學考試題搬進中文大模型數據集,20477道題目,還帶4個候選答案

隨著中文大規模語言模型在自然語言理解與自然語言生成方面展現出強大的性能,現有針對特定自然語言處理任務的中文評測基準數據集已經不足以對中文大模型進行有效地評估。傳統的中文評測基準主要關注模型對于簡單常識(如雨天出門需要帶傘)和表層語義(如籃球比賽的報道是體育類還是科技類新聞)的理解能力,而忽略了人類復雜知識的挖掘和利用。目前,針對中文大模型復雜知識評測的數據集十分匱乏,特別是涉及我國教育體系下不同層次和不同領域的專業知識。

為了彌補這一差距,天津大學自然語言處理實驗室與華為諾亞方舟實驗室聯合發布了 M3KE(A Massive Multi-Level Multi-Subject Knowledge Evaluation Benchmark for Chinese Large Language Models)基準數據集,以零樣本、少樣本形式測試中文大模型對于多級多學科知識的掌握能力。

- 論文鏈接:https://arxiv.org/abs/2305.10263

- 數據鏈接:https://github.com/tjunlp-lab/M3KE

M3KE 數據集

數據集介紹

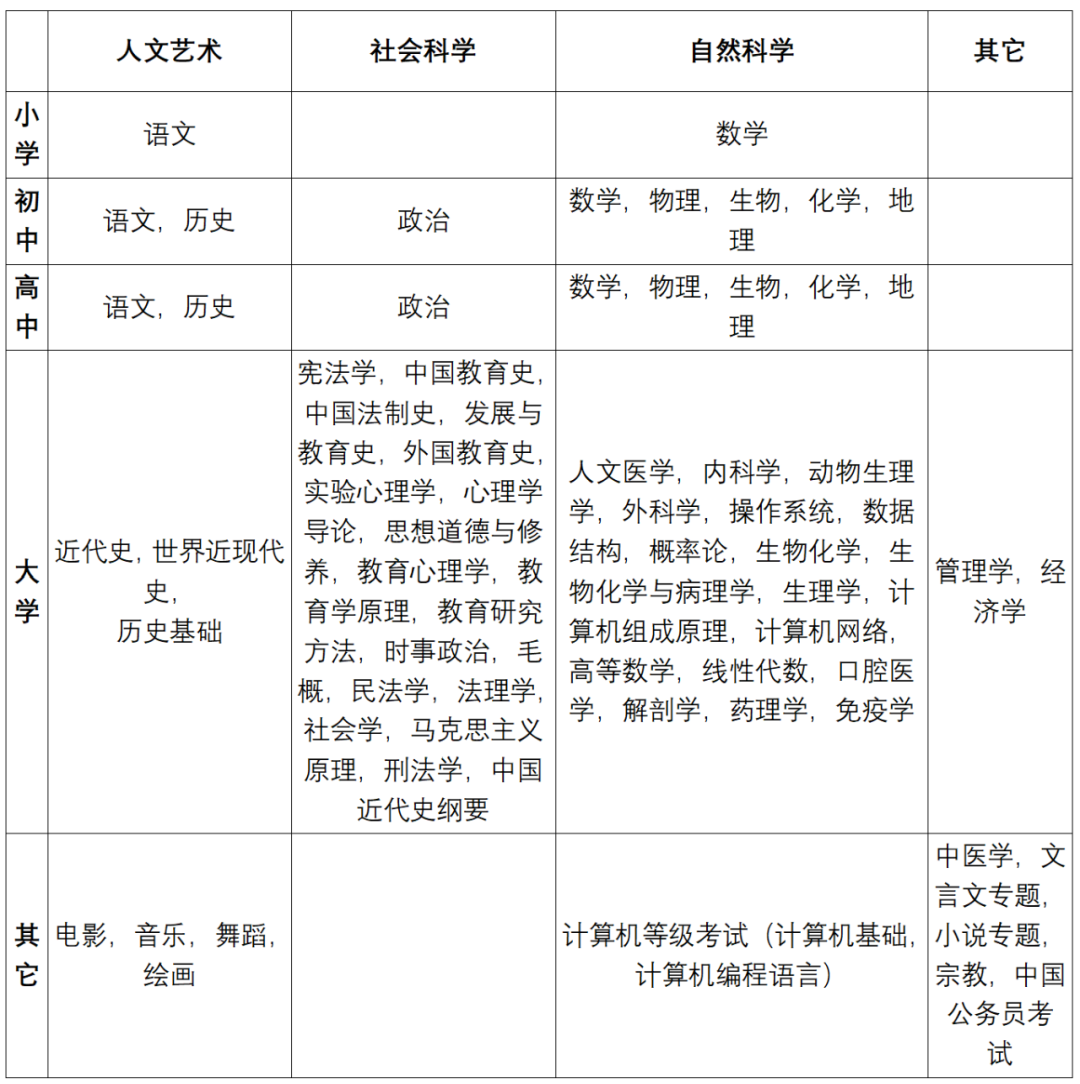

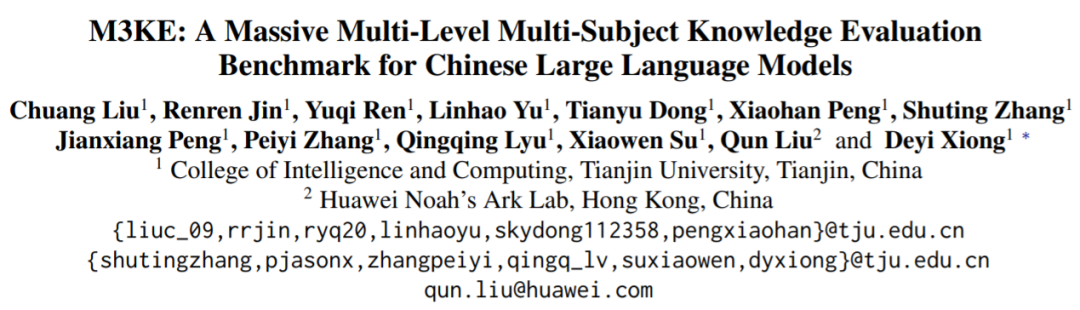

M3KE 收集了 20,477 個真人標準化考試題目(包含 4 個候選答案),覆蓋 71 個任務,包括小學、初中、高中、大學、研究生入學考試題目,涉及人文、歷史、政治、法律、教育、心理學、科學、工程技術、藝術等學科,分布如 Fig 1 所示。

研究人員基于兩個標準構建 M3KE 數據集:

1,契合中國教育體系,覆蓋多教育階段

研究人員模仿中國學生的教育經歷,即小學、初中、高中、大學等主要教育階段,旨在評估中文大模型在不同教育階段下的表現。由于每個教育階段需要掌握的知識點不同(例如,在語文學科中,小學和初中的知識或考點存在明顯的差異),因此,M3KE 在不同教育階段會包含相同的學科。為了提高數據集中學科知識點的覆蓋范圍,研究人員選擇了中國升學考試中的統考試題,包括小升初、中考、高考,研究生入學考試和中國公務員考試等真題題目。

2,覆蓋多學科領域

為提高數據集的學科覆蓋率,研究人員基于人文藝術、社會科學和自然科學三大類進行構建,包括:文學、理學,歷史、政治、法學、教育學、心理學、科學、工程技術、藝術等學科。為進一步拓展數據集的豐富度,研究人員補充了中醫、宗教以及計算機等級考試等任務。

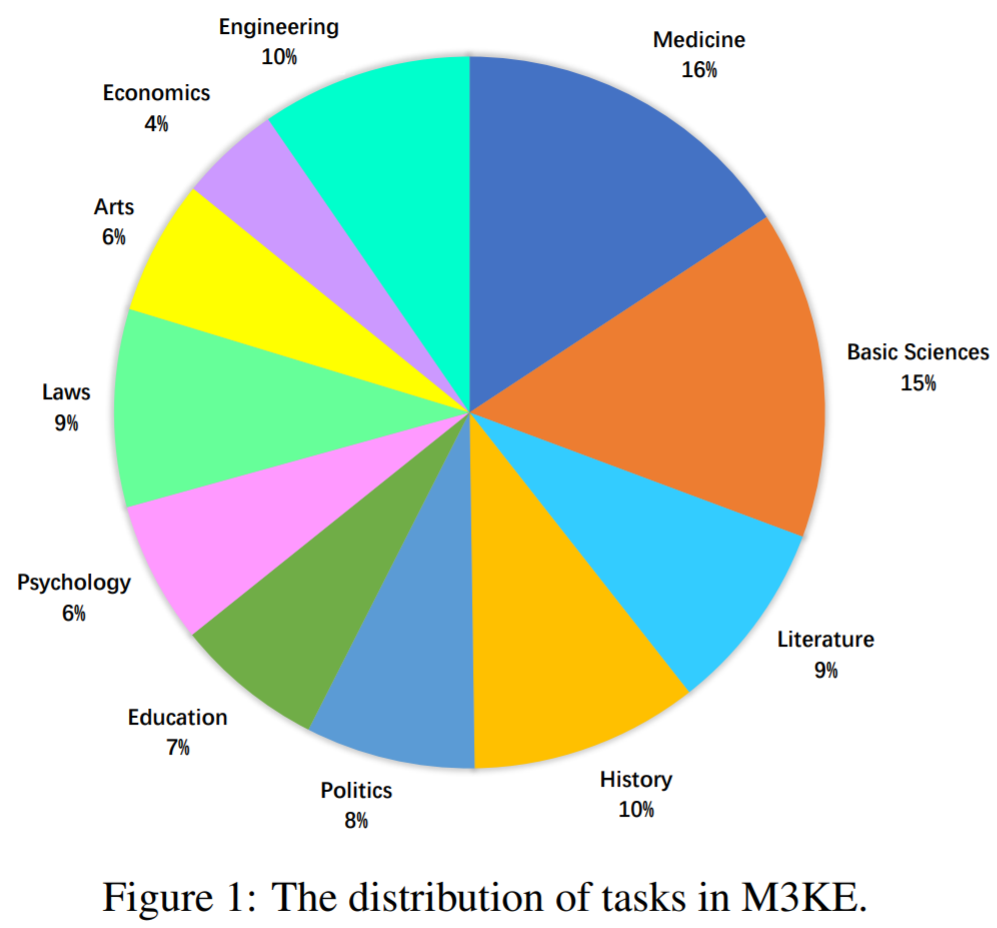

數據集統計

Table 3 顯示了 M3KE 的整體統計數據。上述四個學科類別中的任務數量分別為 12、21、31 和 7,而四個學科類別中的問題數量分別為 3,612、6,222、8,162 和 2,126。任務中包含的問題最大數量為 425,最小數量為 100。社會科學和自然科學的問題通常比藝術與人文學科和其他科目的問題更長,而它們的答案選項較短。

多學科視角下的 M3KE 介紹及示例

人文藝術

人文與藝術學科包括語文、藝術和歷史等多個領域的學科。這些學科注重對文學和文化文物的分析和解釋等,以小學語文為例,考試題目旨在評估 7 至 13 歲學生的語言運用和文學欣賞能力,如使用同義詞和反義詞的能力。歷史學科則涵蓋從古代到現代的中國和世界歷史。除人文學科外,M3KE 還包括藝術科目,如舞蹈、美術、音樂、電影等,藝術是人類文化的重要組成部分,評測中文大模型在藝術領域的表現同樣重要。

美術任務示例:

下面關于拉斯科洞穴壁畫說法錯誤的是?

A. 這個壁畫是在法國發現的

B. 發現的動物形象有 100 多個

C. 發現的時間為 1940 年

D. 壁畫顏色以黑色為主

世界近現代史任務示例:

從尼德蘭革命到法國大革命歷時兩個多世紀,而此后僅半個世紀資本主義就初步形成了一個世界體系,這主要是因為?

A. 法國大革命的影響得到廣泛傳播

B. 維也納體系激化了各國社會矛盾

C. 工業革命使資本主義力量迅速增強

D. 殖民統治遍及世界各大洲

社會科學

社會科學重在人文學科的應用,如法律、政治、教育和心理等學科。政治課程貫穿初中、高中、大學、研究生多個教育階段,其他學科則主要分布在大學階段的課程中。社會科學還包括經濟和管理學任務,這些任務的試題選自中國研究生入學考試中的經濟學聯考和管理學聯考,知識涉及微觀經濟學、宏觀經濟學、管理學和邏輯學等。

刑法學任務示例:

甲欲殺乙,將毒藥投入乙的飯食中。乙服食后,甲后悔,趕緊說明情況,并將乙送往醫院。醫院在過程中檢查發現,甲所投放的 "毒藥" 根本沒有毒性,乙安然無恙。甲的行為屬于?

A. 不構成犯罪

B. 犯罪未遂

C. 犯罪中止

D. 犯罪既遂

教育學原理任務示例:

教育研究中最基本、最常用的研究方法是?

A. 教育觀察研究

B. 教育調查研究

C. 教育測量研究

D. 教育實驗研究

自然科學

自然科學包括工程學、科學、醫學和數學、物理學、化學、生物學等基礎學科。這些學科通常需要復雜的計算、分析和邏輯推理能力。在我國教育體系中,同一學科在不同階段會涉及不同類型的知識。例如,小學數學主要學習基本的算術運算,而高中數學則涵蓋更高級的數學概念,如數列、導數、幾何等。

動物生理學任務示例:

使用普魯卡因麻醉神經纖維,影響了神經纖維傳導興奮的哪一項特征?

A. 生理完整性

B. 絕緣性

C. 雙向傳導性

D. 相對不疲勞性

操作系統任務示例:

目錄形式對文件的檢索效率影響很大,下列最高級的目錄形式是?

A. 單級目錄

B. 兩級目錄

C. 三級目錄

D. 樹形目錄

其它

其他類型的任務包括宗教、中國公務員考試,計算機等級考試等。這些任務需要的知識不局限于上述單一層次或學科的知識。如中國公務員考試涉及常識、人文、邏輯等知識,因此研究人員將這些任務視為對中文大模型綜合知識的評估。

中國公務員考試任務示例:

以前有幾項研究表明,食用巧克力會增加食用者患心臟病的可能性。而一項最新的、更為可靠的研究得出的結論是:食用巧克力與心臟病發病率無關。估計這項研究成果公布以后,巧克力的消費量將會大大增加。上述推論基于以下哪項假設?

A. 盡管有些人知道食用巧克力會增加患心臟病的可能性,卻照樣大吃特吃

B. 人們從來也不相信進食巧克力會更容易患心臟病的說法

C. 現在許多人吃巧克力是因為他們沒有聽過巧克力會導致心臟病的說法

D. 現在許多人不吃巧克力完全是因為他們相信巧克力會誘發心臟病

中醫學任務示例:

人參有大補元氣、益氣固脫的作用,而用于慢性虛弱性疾病常以何藥作代用品?

丹參

黨參

黃芪

太子參

多教育階段視角下的 M3KE 介紹和示例

研究人員按照中國教育體系對數據集進行了分階段,包括小學、初中、高中、大學及研究生入學考試。同樣,研究人員還選擇一些教育體系外的考試科目,如計算機等級考試和中國公務員考試等。

小學

小學語文任務示例:

下列詞語書寫完全正確的一項是?

A. 天籟之音 行云流水 筆走龍蛇 翻箱倒柜

B. 高山流水 輕歌曼舞 畫龍點睛 別出心栽

C. 余音繞梁 巧奪天功 妙筆生花 焦躁不安

D. 黃鐘大呂 惟妙惟肖 栩栩如生 精兵減政

小學數學任務示例:

一件商品,先提價 20%,以后又降價 20%,現在的價格與原來相比?

A. 提高了

B. 降低了

C. 不變

D. 不知道

初中

初中語文任務示例:

下列說法正確的一項是?

A. 《最苦與最樂》選自《梁啟超文選》,作者梁啟超是明代思想家、學者

B. 《鄒忌諷齊王納諫》選自《戰國策》,《戰國策》是戰國時游說之士的策謀和言論的匯編,由東漢的劉向編訂為三十三篇

C. 詞又稱 “長短句”,句式長短不一。興盛于宋代,蘇軾和辛棄疾是豪放派的代表人物,而李清照是婉約派的代表人物

D.《岳陽樓記》實際上是一篇借物言志的文章,寄寓了作者與民同樂的思想

初中政治任務示例:

班級要以 “崇尚法治精神” 為主題制作黑板報,小蘭負責 “踐行平等” 版塊內容的編寫。以下她搜集的素材適合入選的是?

A. 公交車上設有 “老弱病戲孕” 愛心專座

B. 中學生到革命傳統教育基地參加研學活動

C. 解放軍戰士不畏嚴寒酷暑,守衛祖國邊疆

D. 同學們利用節假日到街頭清除小廣告

高中

高中語文任務示例:

沈括在《夢溪筆談》中說道:“天地之變,寒暑風雨,水旱螟蝗,率皆有法。” 這句話的哲學寓意是?

A. 規律是客觀事物變化的根本原因

B. 規律具有客觀性、普遍性

C. 要學會用聯系的觀點看問題

D. 要學會用發展的觀點看問題

高中生物任務示例:

環境容納量取決于一個種群所處的環境條件。下列敘述正確的是?

甲乙兩地的灰喜鵲種群的環境容納量一定是相同的

生活在某草原的東亞飛蝗不同年份的環境容納量可能是相同的

當種群數量接近環境容納量時,死亡率會升高,出生率不變

生活在微山湖中的鯽魚和黑魚環境容納量是相同的

大學

大學口腔醫學任務示例:

排在我國口腔癌之首的是?

A. 牙槽黏膜癌

B. 頰黏膜癌

C. 唇癌

D. 舌癌

大學經濟學綜合任務示例:

下列項目哪一項應計入 GDP?

A. 政府轉移支付

B. 購買一輛用過的汽車

C. 企業支付的貸款和債券利息

D. 購買彩票贏得的 1 萬元

其它

計算機等級考試之計算機基礎任務示例:

因某工作表數據非常多,在滾動瀏覽時第一行的標題無法始終看到,應如何操作才能始終看到標題行,最快捷的方法是?

A. 設置 “打印標題”

B. 凍結窗格

C. 凍結首行

D. 凍結首列

宗教任務示例:

宗教能夠與社會主義社會相適應的政治基礎是?

A. 人民民主專政國家政權的建立

B. 廣大教徒是擁護社會主義制度的,同全國人民在根本利益上是一致的

C. 中國共產黨領導和執政地位的確立

D. 獨立自主,自辦教會

實驗

評測模型

- GLM-335M/10B/130B,由清華大學開發的預訓練大語言模型,支持中、英文雙語。研究人員選擇 GLM 中文版的三個模型,參數規模分別為 335M, 10B 和 130B。

- BLOOM-7.1B,Hugging Face 推出的多語言大模型,由數百名研究人員合作開發。

- ChatGLM-6B,由清華大學開發的語言模型,使用指令數據微調,并通過基于人類反饋的強化學習進一步訓練。

- MOSS-16B-SFT, 由復旦大學開發的語言模型,實驗中使用經過指令微調版的 MOSS-moon-003-SFT 版本。

- BELLE-7B-0.2M,基于 BLOOMZ-7.1B-mt 開發的經過 20 萬條指令微調的語言模型。

- BELLE-7B-2M,基于 BLOOMZ-7.1B-mt 開發的經過 200 萬條指令微調的語言模型。

- GPT-3.5-turbo,由 OpenAI 開發的語言模型。采用人工構建的高質量指令數據,進行人類反饋強化學習訓練。

Zero-shot/Few-shot 評估

在零樣本設置條件下,模型要求直接回答問題;在少樣本設置條件下,會預先給定模型同任務的若干示例,引導模型進行情景學習(In-Context Learning)。在 M3KE 中,所有題目均使用準確率計算得分。

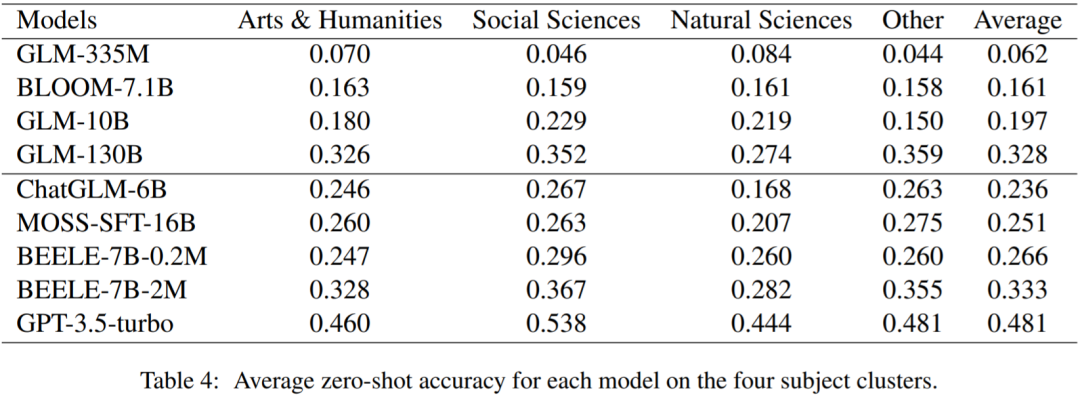

不同學科類別下的評測結果

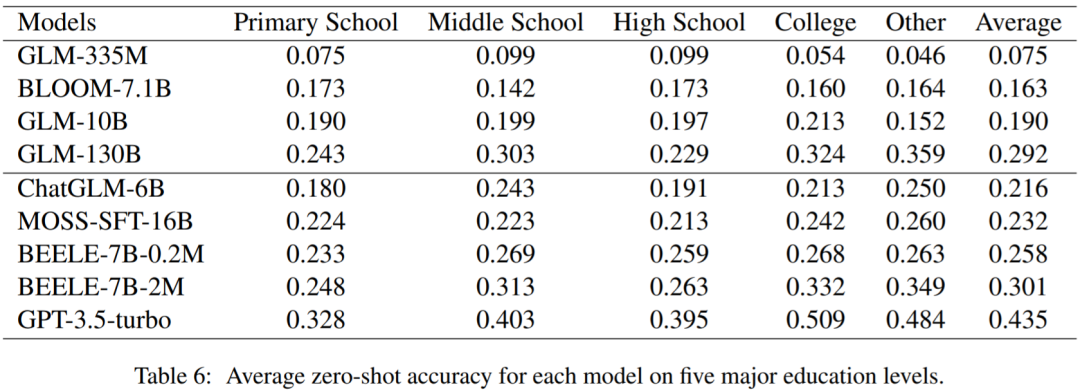

不同教育階段下的評測結果

實驗結果分析

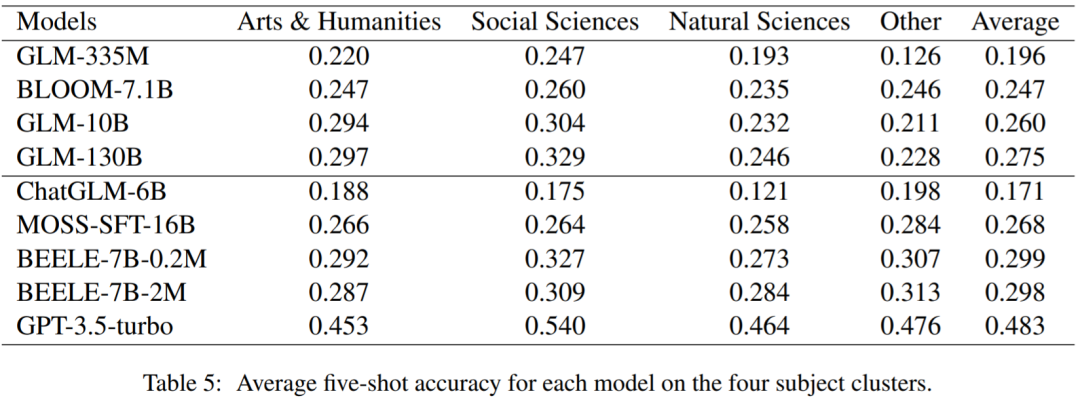

1,在零樣本評估中(Table 4&6),所有參數小于 10B 的預訓練語言模型(未經過微調)準確率都低于隨機結果(25%),少樣本的設置(Table 5&7)有助于模型性能的提升。但是,GLM130B 在零樣本評估的結果好于少樣本評估結果,原因可能是 GLM130B 在預訓練階段已經使用了部分指令數據,使其已經具備較好的零樣本學習能力。

2,大部分經過微調后的中文大模型僅達到隨機結果(25%)水平,即使在小學階段的測試中(Table 6&7)。這說明較低教育階段中的知識仍然是當前中文大模型的短板之一。

3,在零樣本評估中,BELLE-7B-2M 取得了中文大模型中最好的成績,但仍然與 GPT-3.5-turbo 有 14.8% 的差距。此外,有監督微調指令的數量也是一個重要的因素,經過兩百萬指令微調的 BELLE-7B-2M 好于經過二十萬指令微調的 BELLE-7B-0.2M(Table 4)。

4,少樣本的設置在大多數情況下并沒有帶來性能的改善(Table 5&7 vs Table 4&6),尤其是經過指令微調或基于人類反饋的強化學習訓練后的語言模型。這表明對預訓練語言模型進行指令微調可以顯著提升語言模型的零樣本學習能力,不需要額外的示例就能理解指令或問題的意圖。

結論

研究人員提出了一個新的基準 M3KE,用于評估中文大模型在多個學科和不同教育階段下中文大模型知識掌握能力。M3KE 包含 71 個任務和 20,447 個問題。研究人員發現,所有參與評估的開源中文大模型都明顯落后于 GPT-3.5。研究人員希望 M3KE 有助于發現中文大模型的知識漏洞,促進中文大模型進一步的發展。

M3KE 中所有的任務