蘇媽戰老黃!官宣AMD大模型專用卡,對標英偉達H100,可跑更大模型

蘇媽發布最新AMD加速卡,直接宣戰英偉達!

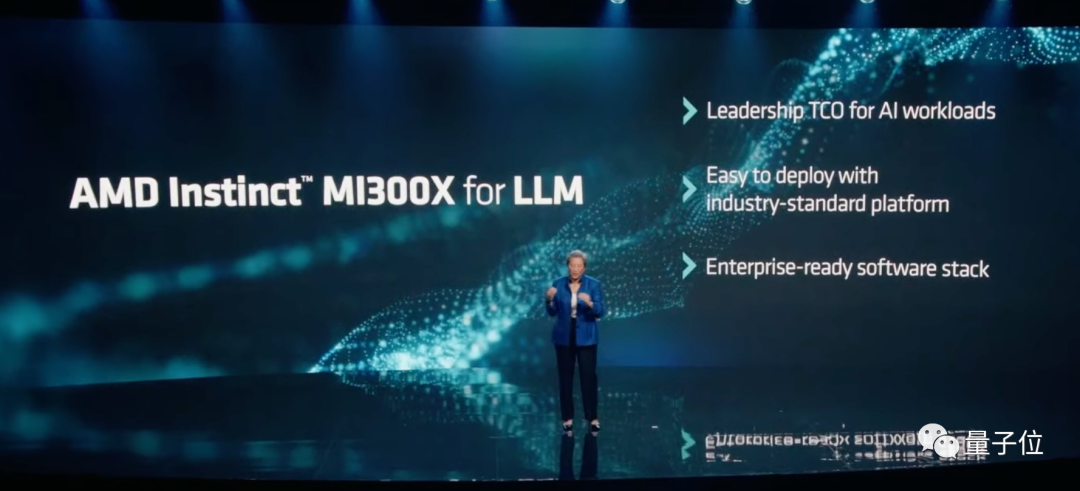

沒錯,就在AMD推出最新加速卡Instinct MI300X的現場,PPT上專門打出一行字——

大語言模型專用。

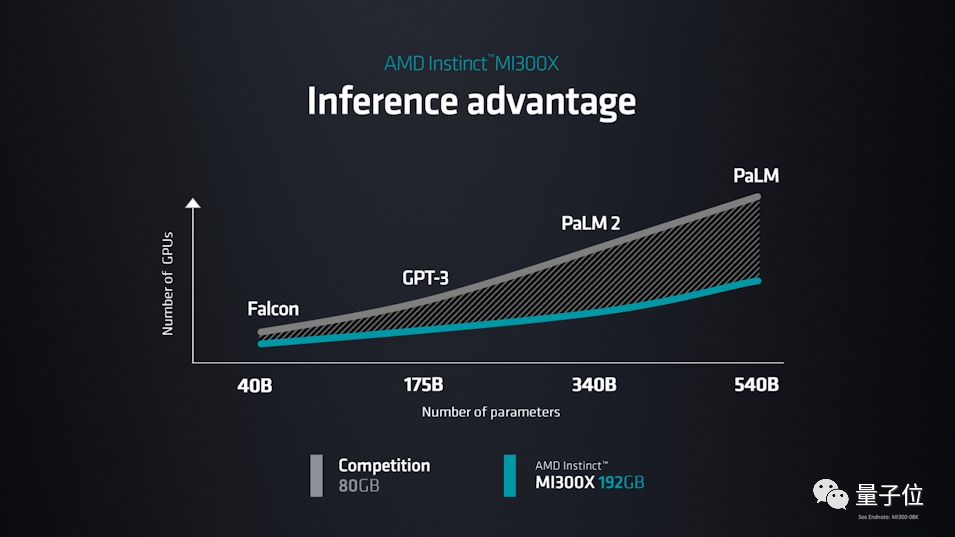

AMD表示,MI300X的高帶寬內存(HBM)密度,最高可達英偉達H100的2.4倍,高帶寬內存帶寬最高可達H100的1.6倍,顯然MI300X能運行比H100更大的AI模型。

MI300X所在的MI300系列,是AMD為AI和高性能計算(HPC)打造的一系列最新APU加速卡。

其中,MI300A是“基礎款”,MI300X則是硬件性能更高的“大模型優化款”。

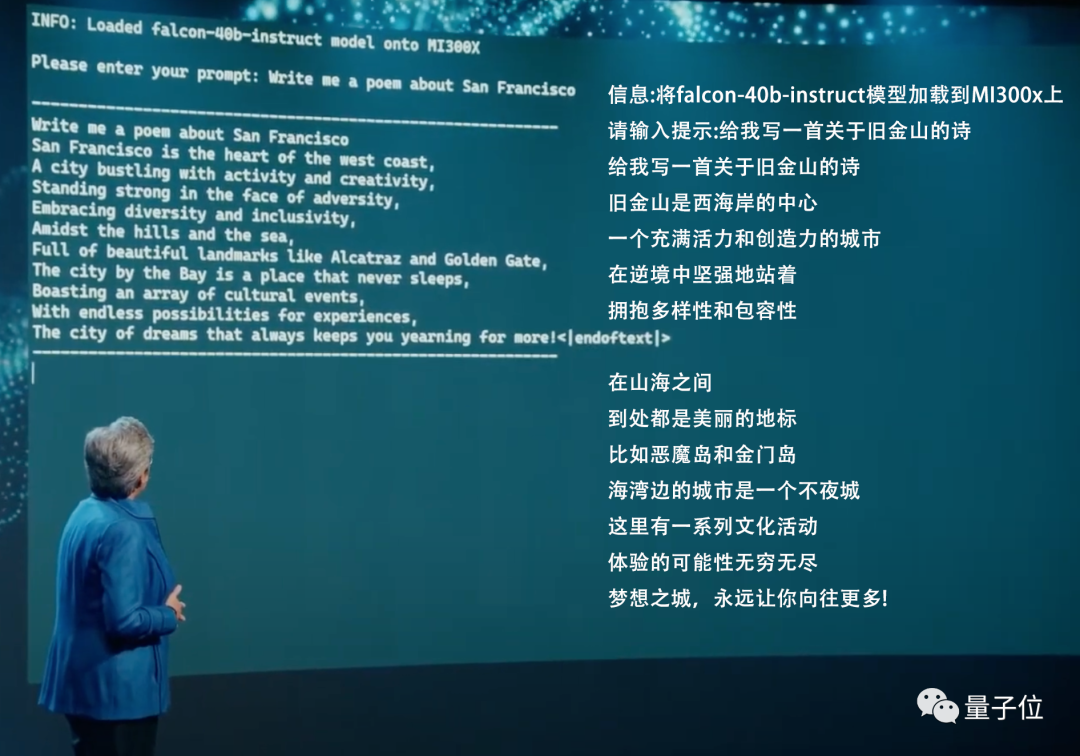

蘇媽還現場演繹MI300X的計算速度,利用抱抱臉的400億參數大模型快速寫了首小詩:

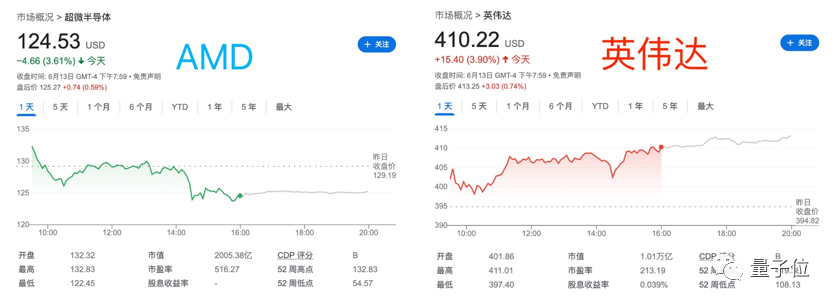

遺憾的是,市場對AMD的新卡好像不太買賬。

就在這次AMD發布會期間,市場股價一路下跌,開完后甚至跌了3.61%……相比之下,英偉達股價還上漲了一波。

不過仍有網友表示驚喜:

盡管股價波動,這可能是第一次有這么大的模型(400億參數)在單卡GPU上運行。

所以,AMD最新MI300系列的參數細節如何?

“LLM專用加速卡”

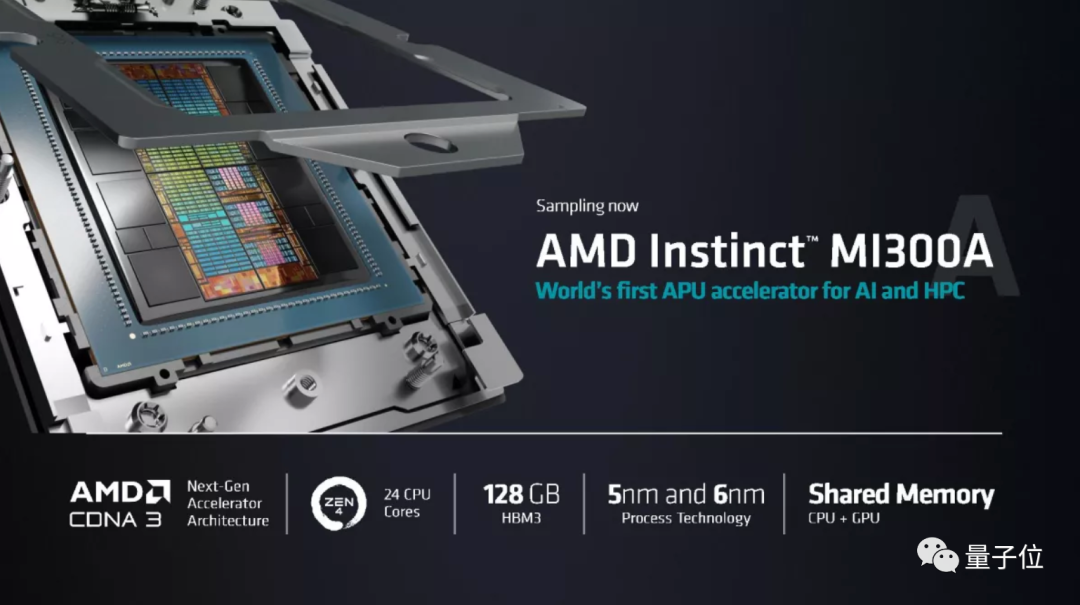

先來看看Instinct MI300A的情況。

據蘇媽介紹,MI300A應該是首個針對AI和高性能計算(HPC)推出的APU。

它一共有13個小芯片,包含9個5nm制程GPU+CPU,以及4個6nm制程的小芯片(base dies),包含1460億個晶體管,其中有24個Zen 4 CPU核心,1個CDNA 3圖形引擎,128GB的HBM3內存。

相比MI250,MI300的性能提升了8倍,效率提升了5倍。

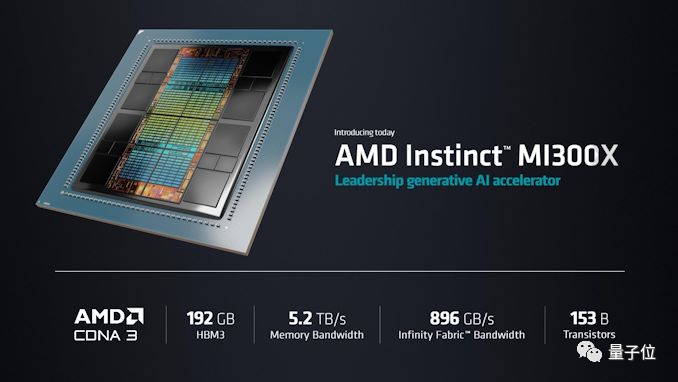

再來看看Instinct MI300X。

這是針對大語言模型(LLM)專用的卡,包含12個小芯片,1530億個晶體管,192GB的HBM3內存,內存帶寬達到5.2TB/s,Infinity Fabric帶寬達到896GB/s。

蘇媽還現場展示了MI300X運行包括GPT-3、PaLM2等大模型的優勢:

在發布MI300X的現場,蘇媽還現場運行了Hugging Face 的falcon-40b-instruct模型,寫了首關于舊金山(這次AMD發布會地址)的小詩。

除此之外,AMD這次發布會還發布了第四代霄龍(EPYC)處理器,包括亞馬遜、微軟和Meta都已經在著手準備用上新品了。

預計今年Q4推出

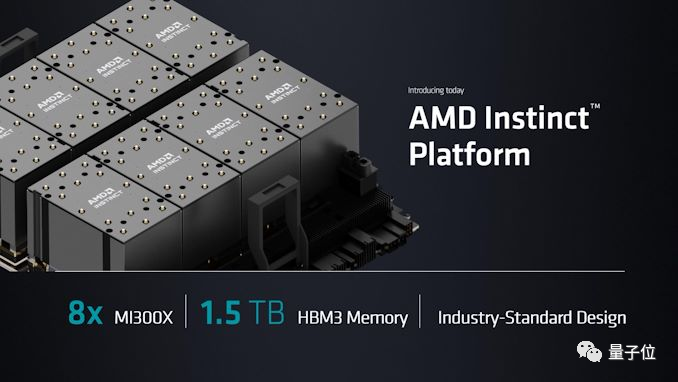

除了最新推出的霄龍處理器、MI300A和MI300X以外,AMD還在發布會上宣布了一個AMD Instinct計算平臺。

這個平臺集成了8個MI300X,可提供1.5TB的HBM3內存。

那么,這些新卡和新平臺,預計什么時候能出貨?

目前來看,MI300A已經出樣,估計不久就能買上;大模型專用卡MI300X、以及集成8個MI300X的AMD Instinct計算平臺,預計今年第三季度出樣,第四季度就能推出。

但這幾年來,相比英偉達一直在AI上面有大動作,AMD的行動卻好像有點遲緩。

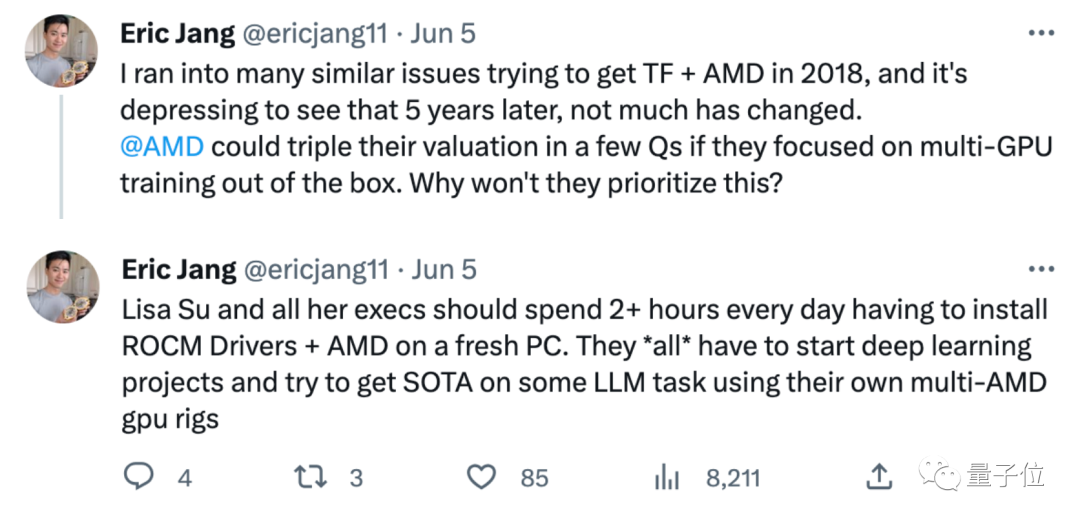

就在這次發布會前幾天,DeepBrain AI的CEO Eric Jang發推表示,感覺AMD這幾年讓他很失望,5年來沒什么變化:

蘇媽和她的所有高管,至少該開始嘗試用AMD卡跑一些大模型,看看能不能達到SOTA。

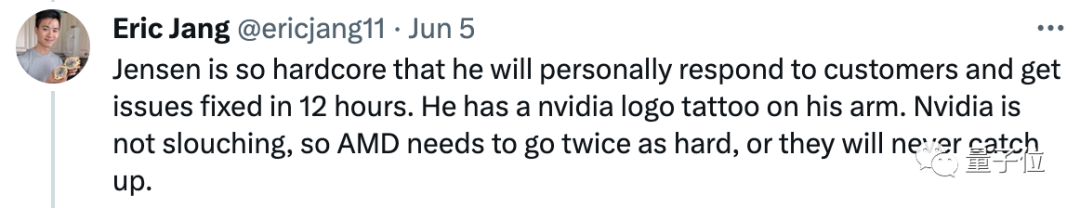

Eric Jang指出,AMD和英偉達已經存在一定差距。

如果AMD不努力跟上,差距只會越拉越大:

老黃(Jensen)很硬核,他不僅會親自回應客戶并在12小時內解決問題,手臂上還紋著英偉達的LOGO。

相比之下,AMD至少需要加倍努力,否則它將永遠追不上英偉達。

好消息是,AMD至少開始行動了。這次發布會結束,就有網友表示:

至少,現在終于能看到AMD和NVIDIA正面打擂臺了。

你看好AMD的新卡嗎?

參考鏈接:

[1]https://www.anandtech.com/show/18915/amd-expands-mi300-family-with-mi300x-gpu-only-192gb-memory

[2]https://www.tomshardware.com/news/amd-expands-mi300-with-gpu-only-model-eight-gpu-platform-with-15tb-of-hbm3

[3]https://twitter.com/ericjang11/status/1665618676354109440