老黃給H100“打雞血”:英偉達(dá)推出大模型加速包,Llama2推理速度翻倍

本文經(jīng)AI新媒體量子位(公眾號(hào)ID:QbitAI)授權(quán)轉(zhuǎn)載,轉(zhuǎn)載請(qǐng)聯(lián)系出處。

大模型的推理速度,僅僅一個(gè)月就提高了一倍!

英偉達(dá)近日官宣給H100推出了“雞血包”——專(zhuān)用于LLM推理的加速程序。

或許這下可以不用空等明年才能交付的GH200了 。

。

GPU的運(yùn)算能力一直影響著大模型的表現(xiàn),無(wú)論是硬件提供者還是使用者都希望能算得更快些。

而作為大模型背后硬件的最大供應(yīng)商,英偉達(dá)一直在研究怎么給大模型硬件加速。

通過(guò)與多家AI公司合作,英偉達(dá)終于推出了大模型推理優(yōu)化程序TensorRT-LLM(暫且簡(jiǎn)稱(chēng)TensorRT)。

TensorRT不僅能讓大模型的推理速度翻番,使用起來(lái)也十分方便。

無(wú)需深入了解C++和CUDA,也能快速定制優(yōu)化策略,在H100上更快地跑大模型。

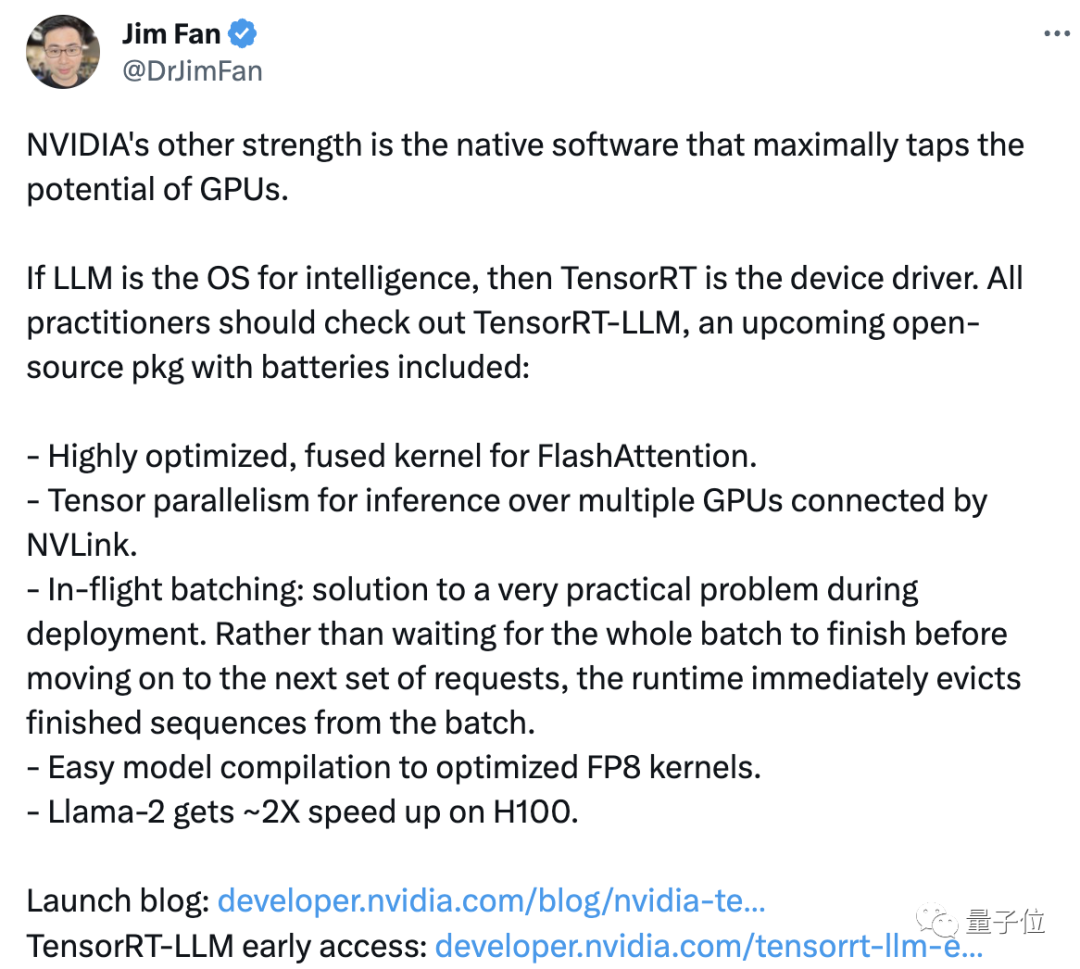

英偉達(dá)科學(xué)家范麟熙(Jim Fan)轉(zhuǎn)發(fā)并評(píng)論稱(chēng),英偉達(dá)的“另一項(xiàng)優(yōu)勢(shì)”就是可以最大化利用GPU性能的配套軟件。

英偉達(dá)通過(guò)軟件給產(chǎn)品打雞血,仿佛在實(shí)踐老黃的那句“買(mǎi)的越多省的越多”,但這也并不妨礙有人嫌貴:

除了價(jià)格,也有網(wǎng)友對(duì)其運(yùn)行效果提出了質(zhì)疑:

我們總是看到(宣傳中的)多少倍的性能提升,但自己運(yùn)行Llama 2的時(shí)候每秒還是只能處理幾十個(gè)token。

到底是不是真的有效可能還需要繼續(xù)檢驗(yàn),我們先來(lái)具體了解一下TensorRT。

大模型推理速度翻倍

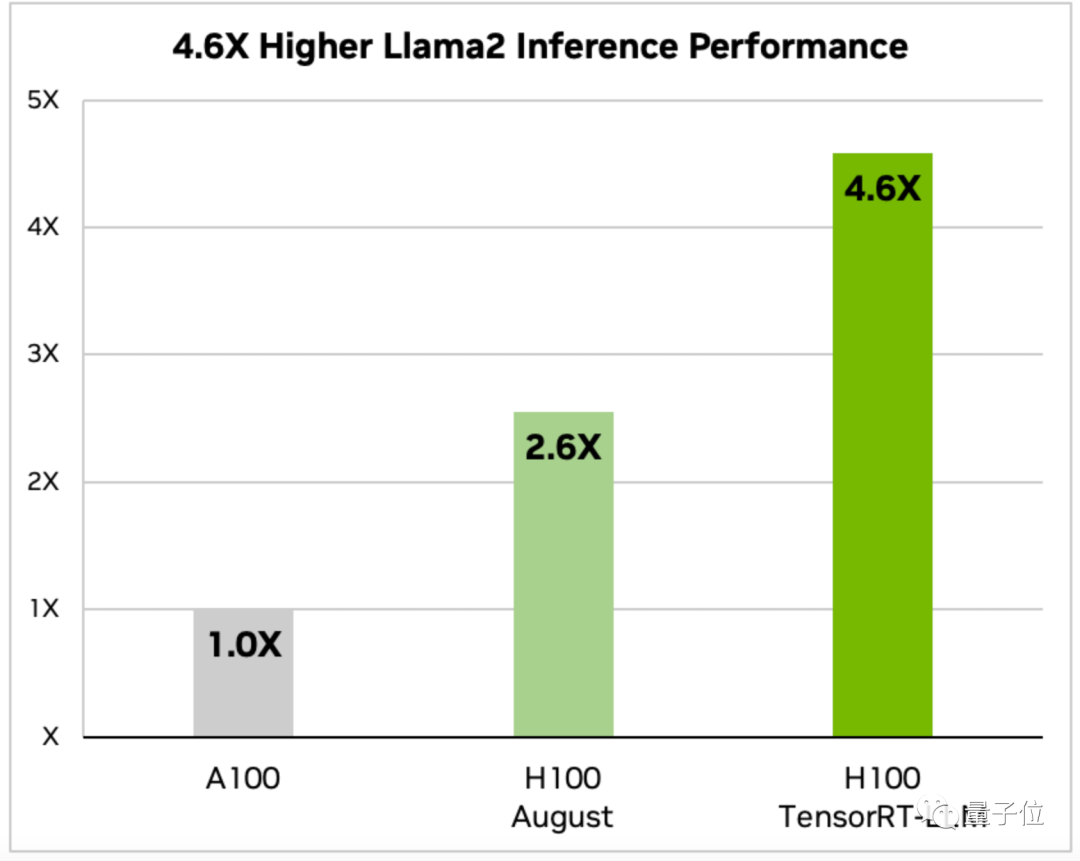

TensorRT-LLM優(yōu)化之后的H100,跑大模型到底有多快呢?

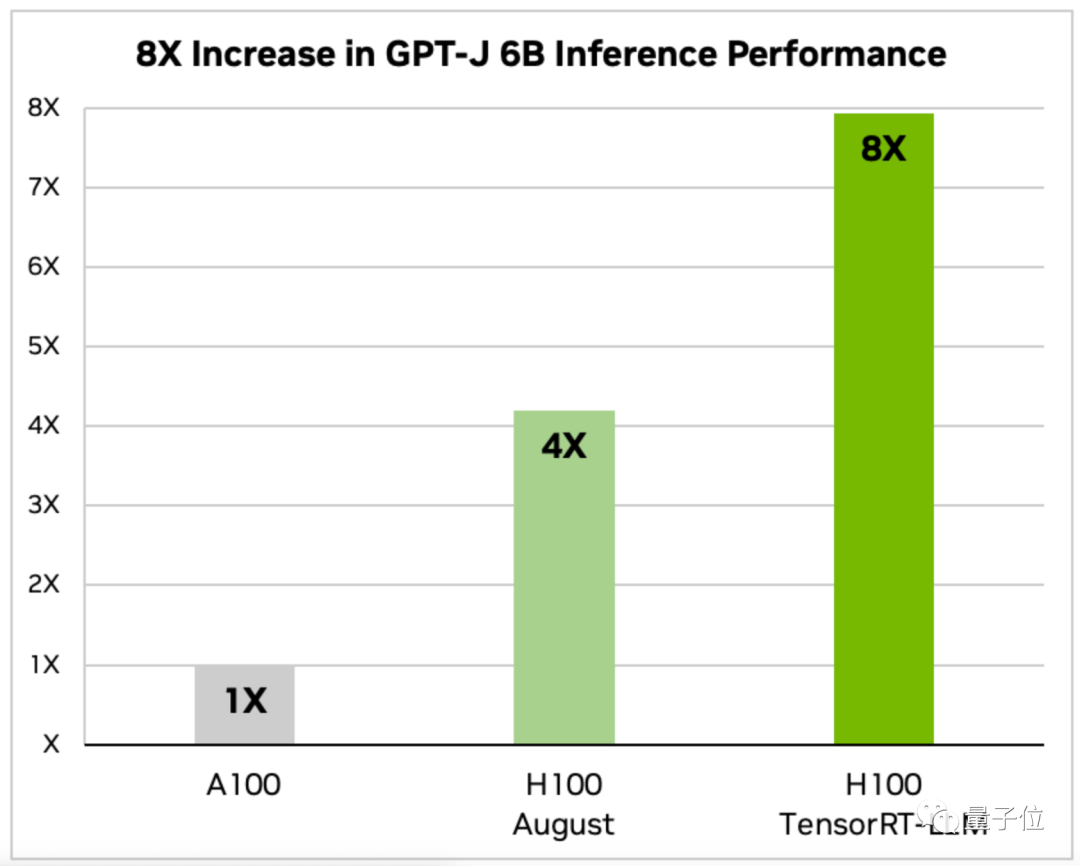

英偉達(dá)的通告中給出了Llama 2和GPT-J-6B兩種模型的數(shù)據(jù)。

在優(yōu)化后的H100上,跑Llama 2的推理速度則是A100的4.6倍、八月份未優(yōu)化版H100的1.77倍。

而GPT-J-6B的推理速度是A100上的8倍、八月未優(yōu)化版的2倍。

TensorRT還提供了開(kāi)源的模塊化Python API,根據(jù)不同LLM的需求,可以快速定制優(yōu)化方案。

這個(gè)API將深度學(xué)習(xí)編譯器、內(nèi)核優(yōu)化、預(yù)/后處理和多節(jié)點(diǎn)通信功能集成到了一起。

其中針對(duì)GPT(2/3)、Llama等常見(jiàn)模型,還有已經(jīng)定制好的版本,可以“開(kāi)箱即用”。

通過(guò)TensorRT中最新的開(kāi)源AI內(nèi)核,開(kāi)發(fā)者還可以對(duì)模型自身進(jìn)行優(yōu)化,其中就包括了讓Transformer大大提速的注意力算法FlashAttention。

那么TensorRT又是如何對(duì)LLM推理速度進(jìn)行優(yōu)化的呢?

首先要得益于TensorRT對(duì)多節(jié)點(diǎn)協(xié)同工作方式進(jìn)行了優(yōu)化。

像Llama這樣龐大的模型,在單卡上是跑不起來(lái)的,需要多塊GPU一起跑才能帶動(dòng)。

過(guò)去,這一工作需要人們手工把模型拆開(kāi)來(lái)實(shí)現(xiàn)。

而有了TensorRT,系統(tǒng)可以自動(dòng)化地對(duì)模型進(jìn)行拆分,并通過(guò)NVLink在多GPU間高效運(yùn)行。

其次,TensorRT還利用了一種名為動(dòng)態(tài)批處理的優(yōu)化調(diào)度技術(shù)。

LLM在推理過(guò)程中,實(shí)際上是在多次執(zhí)行模型迭代。

動(dòng)態(tài)批處理技術(shù)會(huì)將已完成的序列立即踢出,而不是等待整批任務(wù)完成后再處理下一組請(qǐng)求。

實(shí)際測(cè)試中,動(dòng)態(tài)批處理將LLM的GPU請(qǐng)求吞吐量減少了一半,大大降低了運(yùn)行成本。

另一個(gè)關(guān)鍵點(diǎn)則是將16位精度浮點(diǎn)數(shù)轉(zhuǎn)換為8位精度,從而降低內(nèi)存消耗。

FP8與訓(xùn)練階段的FP16相比消耗的資源更低,同時(shí)精確度又高于INT-8,在提高性能的同時(shí)不影響模型的準(zhǔn)確性。

通過(guò)Hopper Transformer引擎,F(xiàn)P16到FP8的轉(zhuǎn)化編譯由系統(tǒng)自動(dòng)完成,無(wú)需人工對(duì)模型中的任何代碼進(jìn)行修改。

目前,TensorRT-LLM的早鳥(niǎo)版已經(jīng)可以下載,正式版將于幾周內(nèi)推出并集成到NeMo框架中。

One More Thing

每當(dāng)大事件出現(xiàn),總少不了“列文虎克”的身影。

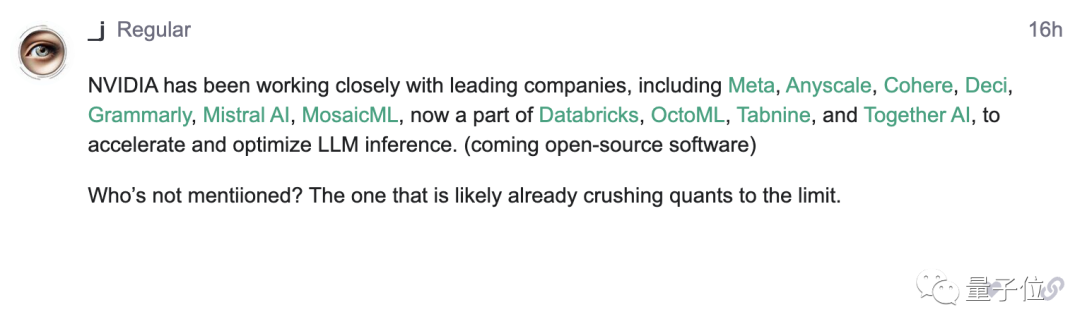

英偉達(dá)的公告中提到了“在與Meta等AI頭部公司合作”,但沒(méi)有提及OpenAI。

從這則通告中,就有網(wǎng)友發(fā)現(xiàn)了這個(gè)華點(diǎn),并發(fā)到了OpenAI論壇上:

讓我康康是誰(shuí)沒(méi)被老黃cue到(手動(dòng)狗頭)

你還期待老黃帶給我們什么樣的“驚喜”呢?