給圖片悄悄加上像素級水印:防止AI「抄襲」藝術(shù)作品的方法找到了

自開源 AI 圖像生成模型 Stable Diffusion 發(fā)布以來,數(shù)字藝術(shù)創(chuàng)作進(jìn)入了一個全新的階段。Textual Inversion,Dreambooth 和 LoRA 等多種以 Stable Diffusion 為基礎(chǔ)的模型微調(diào)技術(shù)催生了大量能夠創(chuàng)作特定風(fēng)格繪畫作品的藝術(shù)「私爐」。這些「私爐」能夠從多則幾十張少則幾張的繪畫作品中訓(xùn)練學(xué)習(xí)其藝術(shù)風(fēng)格或內(nèi)容,并模仿這些風(fēng)格、內(nèi)容創(chuàng)作新的作品。這些技術(shù)使得每個人都能以較低的成本創(chuàng)造自定義的繪畫作品。

然而,這些微調(diào)技術(shù)卻飽受繪畫創(chuàng)作者們的非議和批評。在創(chuàng)作者們看來,「私爐」產(chǎn)出的繪畫作品更像是在人類繪畫作品的基礎(chǔ)上進(jìn)行移花接木,是一種「高明的抄襲」。更有人利用此類技術(shù)專門模仿特定畫手的風(fēng)格生產(chǎn)畫作,并以此在網(wǎng)絡(luò)上對畫手本人進(jìn)行攻擊。一些創(chuàng)作者選擇從互聯(lián)網(wǎng)上撤下自己的畫作,通過物理隔絕的方式避免畫作被用于訓(xùn)練 AI。

最近的一項工作提出了一個避免繪畫作品被用于 AI 模型微調(diào)訓(xùn)練的算法框架「AdvDM」。通過在畫作中添加像素級的微小水印,該框架能夠有效誤導(dǎo)當(dāng)前的模型微調(diào)技術(shù),讓模型無法從畫作中正確地學(xué)習(xí)其藝術(shù)風(fēng)格和內(nèi)容并進(jìn)行模仿創(chuàng)作。在相關(guān)法律法規(guī)尚不完善的當(dāng)下,這一技術(shù)能夠成為藝術(shù)創(chuàng)作者保護(hù)自身權(quán)益、對抗 AI 濫用行為的工具。

- 論文地址:https://arxiv.org/abs/2302.04578

- 項目主頁:https://mist-project.github.io/

- 開源地址:https://github.com/mist-project/mist

在擴(kuò)散模型中定義對抗樣本

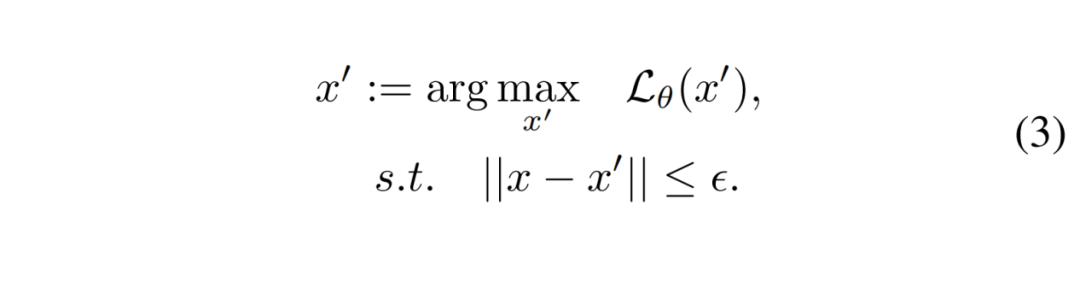

在傳統(tǒng)圖像分類任務(wù)中,對抗樣本是一類被廣泛研究的圖像。它們和真實(shí)圖像的最大差距僅有幾個像素值,這一差距常常無法被人眼所識別。但圖像分類的 AI 模型卻會將其錯誤地分類。這類樣本的定義由下面的公式給出:

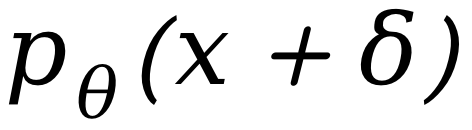

直白地說,對抗樣本是經(jīng)過一點(diǎn)微小擾動的真實(shí)圖像。這個擾動的方向由最大化模型分類損失函數(shù)的方向確定。也就是說,將真實(shí)圖像向模型分類正確的反方向推動一點(diǎn)點(diǎn)。在具體操作時,推動的最大像素值的上限受到嚴(yán)格限制。這保證了人眼難以識別這種擾動。例如:下圖中綠色方框內(nèi)的貓和紅色方框內(nèi)的貓在人類視覺下幾乎完全一樣。然而,實(shí)驗證明,即使是一點(diǎn)極其微小的像素擾動也足以讓分類模型判斷錯誤:下圖中紅色方框內(nèi)的貓在分類模型看來是一只狗。

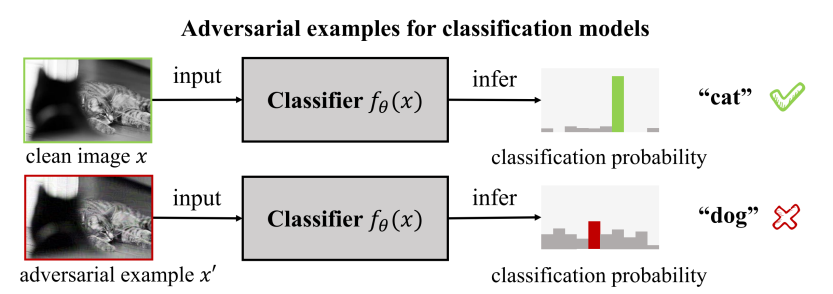

不難發(fā)現(xiàn),讓畫作不被擴(kuò)散模型通過微調(diào)正確學(xué)習(xí)的想法和對抗樣本的概念有許多相似之處:它們同樣要求模型在特定圖像上無法完成給定任務(wù),它們也同樣不希望顯著改變圖像在人類視覺下的內(nèi)容。受到對抗樣本的啟發(fā),作者在擴(kuò)散模型乃至生成模型的語境中給出對抗樣本的定義:

公式中的來自于生成模型的建模。和圖像分類任務(wù)不同,圖像生成任務(wù)是一個從一批訓(xùn)練數(shù)據(jù)集中學(xué)習(xí)怎么生成類似圖像的過程。其中不存在(圖像,類別)這樣的輸入 - 輸出對。因此,無法直接通過給定輸入糾正輸出的方式來對模型進(jìn)行訓(xùn)練。作為替代,生成任務(wù)通過模型參數(shù) θ 定義了特定圖像樣本 x 在模型看來屬于真實(shí)圖像的概率。對于訓(xùn)練數(shù)據(jù)集中的圖像,作者自然希望其 越大越好,最好無限接近于 1。因此,在訓(xùn)練數(shù)據(jù)集的圖像 x 上最大化

越大越好,最好無限接近于 1。因此,在訓(xùn)練數(shù)據(jù)集的圖像 x 上最大化 就成了訓(xùn)練生成模型最常用的優(yōu)化目標(biāo)。

就成了訓(xùn)練生成模型最常用的優(yōu)化目標(biāo)。

而站在對抗樣本的視角,一個自然的想法是:對于一個訓(xùn)練好的生成模型,如果圖像 的

的 非常小,那么說明模型不認(rèn)為

非常小,那么說明模型不認(rèn)為

是一張真實(shí)圖像。因此,模型無法從自己已有的知識庫中找到能夠有效匹配圖像的內(nèi)容的相關(guān)信息,進(jìn)而無法有效描述這張圖像上的內(nèi)容。模型不認(rèn)識

是一張真實(shí)圖像。因此,模型無法從自己已有的知識庫中找到能夠有效匹配圖像的內(nèi)容的相關(guān)信息,進(jìn)而無法有效描述這張圖像上的內(nèi)容。模型不認(rèn)識 上的內(nèi)容,自然也就無法正確復(fù)刻其藝術(shù)風(fēng)格。這與保護(hù)藝術(shù)作品的研究動機(jī)相合。在現(xiàn)實(shí)應(yīng)用中,藝術(shù)創(chuàng)作者們需要的是能夠基于真實(shí)圖像 x 生成在像素距離上非常接近、人眼無法識別其區(qū)別的對抗樣本。因此,尋找生成模型對抗樣本的過程可以被建模為:通過給真實(shí)圖像 x 上添加一層微小的像素擾動

上的內(nèi)容,自然也就無法正確復(fù)刻其藝術(shù)風(fēng)格。這與保護(hù)藝術(shù)作品的研究動機(jī)相合。在現(xiàn)實(shí)應(yīng)用中,藝術(shù)創(chuàng)作者們需要的是能夠基于真實(shí)圖像 x 生成在像素距離上非常接近、人眼無法識別其區(qū)別的對抗樣本。因此,尋找生成模型對抗樣本的過程可以被建模為:通過給真實(shí)圖像 x 上添加一層微小的像素擾動 ,最小化生成模型的

,最小化生成模型的 。最后得到的對抗樣本即為最優(yōu)噪聲

。最后得到的對抗樣本即為最優(yōu)噪聲 和原圖 x 的加和。

和原圖 x 的加和。

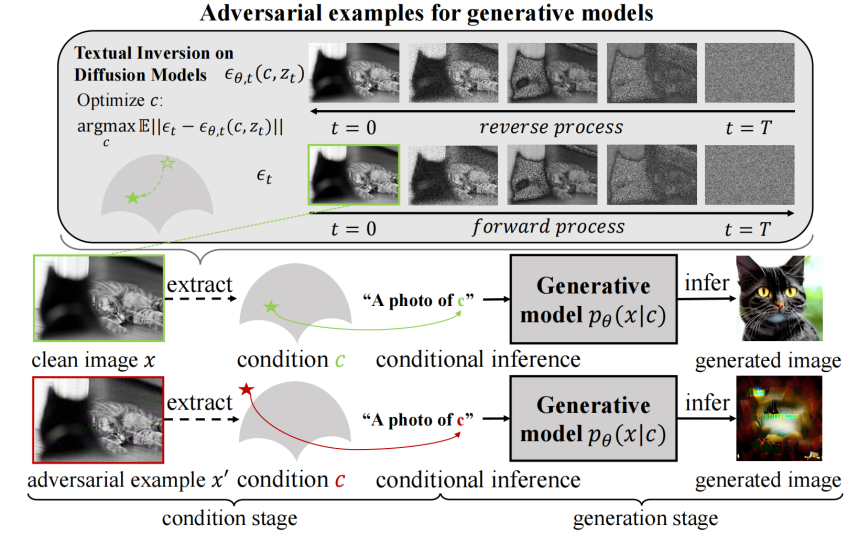

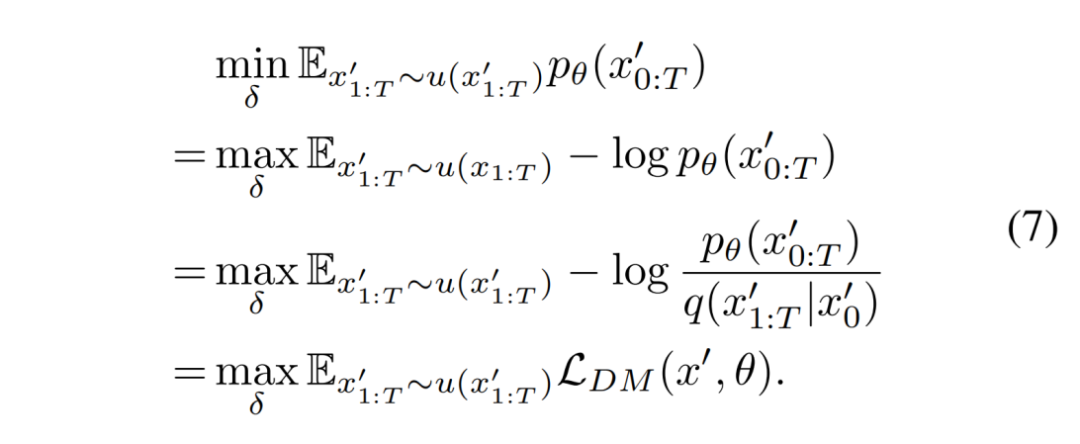

計算擴(kuò)散模型的對抗樣本

然而,優(yōu)化擴(kuò)散模型的對抗樣本并不是一個簡單的任務(wù)。在生成模型的優(yōu)化中,并不能直接通過計算得出。在最大化的過程中,常用的一個方案是最大化的一個理論下界,即證據(jù)下界(ELBO)。類似地,在對抗樣本的優(yōu)化過程中,也可以通過最小化的一個上界來替代最小化的過程。具體來說,在擴(kuò)散模型中,可展開為擴(kuò)散模型中的隱變量的積分:

由此,可以通過蒙特卡洛方法,對隱變量 進(jìn)行采樣,并在采樣基礎(chǔ)上優(yōu)化上式的被積函數(shù)

進(jìn)行采樣,并在采樣基礎(chǔ)上優(yōu)化上式的被積函數(shù) ,從而達(dá)到優(yōu)化

,從而達(dá)到優(yōu)化 的目的。優(yōu)化目標(biāo)可改寫成下式:

的目的。優(yōu)化目標(biāo)可改寫成下式:

擴(kuò)散模型擁有一個非常優(yōu)秀的性質(zhì):后驗分布 是一個高斯分布。該分布的參數(shù)固定且與

是一個高斯分布。該分布的參數(shù)固定且與 完全獨(dú)立。因此,這個分布的在對抗樣本的優(yōu)化過程中是不變的。在優(yōu)化過程中,可以利用

完全獨(dú)立。因此,這個分布的在對抗樣本的優(yōu)化過程中是不變的。在優(yōu)化過程中,可以利用 將原優(yōu)化目標(biāo)改寫成更易計算的形式:

將原優(yōu)化目標(biāo)改寫成更易計算的形式:

可以看到:公式(7)最后得到的目標(biāo)函數(shù)形式非常類似于擴(kuò)散模型訓(xùn)練時的損失函數(shù)。最大的區(qū)別在于優(yōu)化變量的變化。在訓(xùn)練時,優(yōu)化變量是模型參數(shù) θ ;而在產(chǎn)生對抗樣本時,優(yōu)化變量是對抗樣本上添加的擾動 。這個目標(biāo)函數(shù)顯然是可以直接計算的。

。這個目標(biāo)函數(shù)顯然是可以直接計算的。

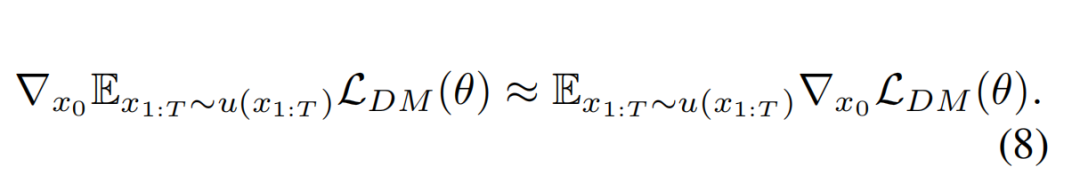

得到了優(yōu)化對抗樣本的目標(biāo)函數(shù)之后,接下來考慮如何優(yōu)化這個目標(biāo)函數(shù)。而優(yōu)化過程最大的難點(diǎn)是如何計算目標(biāo)函數(shù)的梯度。很容易發(fā)現(xiàn),現(xiàn)在的目標(biāo)函數(shù)被寫成了期望的形式。在計算期望的梯度時進(jìn)行了一次近似:用梯度的期望近似期望的梯度,通過多次采樣隱變量并計算對應(yīng)采樣下的 的梯度來估計

的梯度來估計 期望的梯度。

期望的梯度。

由于 同時,在考慮對擾動 由總共 T 項的單層噪聲估計差異函數(shù)聯(lián)合組成,作者在計算時參考擴(kuò)散模型論文中給出的計算方法,在1~T的范圍內(nèi)均勻采樣得 t,將多次采樣的第 t 項函數(shù)的平均值作為

由總共 T 項的單層噪聲估計差異函數(shù)聯(lián)合組成,作者在計算時參考擴(kuò)散模型論文中給出的計算方法,在1~T的范圍內(nèi)均勻采樣得 t,將多次采樣的第 t 項函數(shù)的平均值作為 的估計值。

的估計值。 的大小進(jìn)行約束時,參考了現(xiàn)有的對抗攻擊方法的范式,即利用符號函數(shù)來約束梯度的大小。令

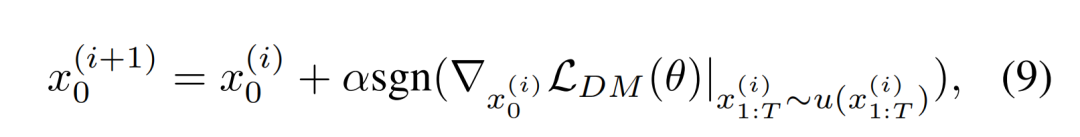

的大小進(jìn)行約束時,參考了現(xiàn)有的對抗攻擊方法的范式,即利用符號函數(shù)來約束梯度的大小。令 表示第步的對抗性樣本。第(i+1)步的對抗性樣本可以通過沿著公式(8)中梯度的方向更新單步步長

表示第步的對抗性樣本。第(i+1)步的對抗性樣本可以通過沿著公式(8)中梯度的方向更新單步步長 所得:

所得: 所得:

所得:

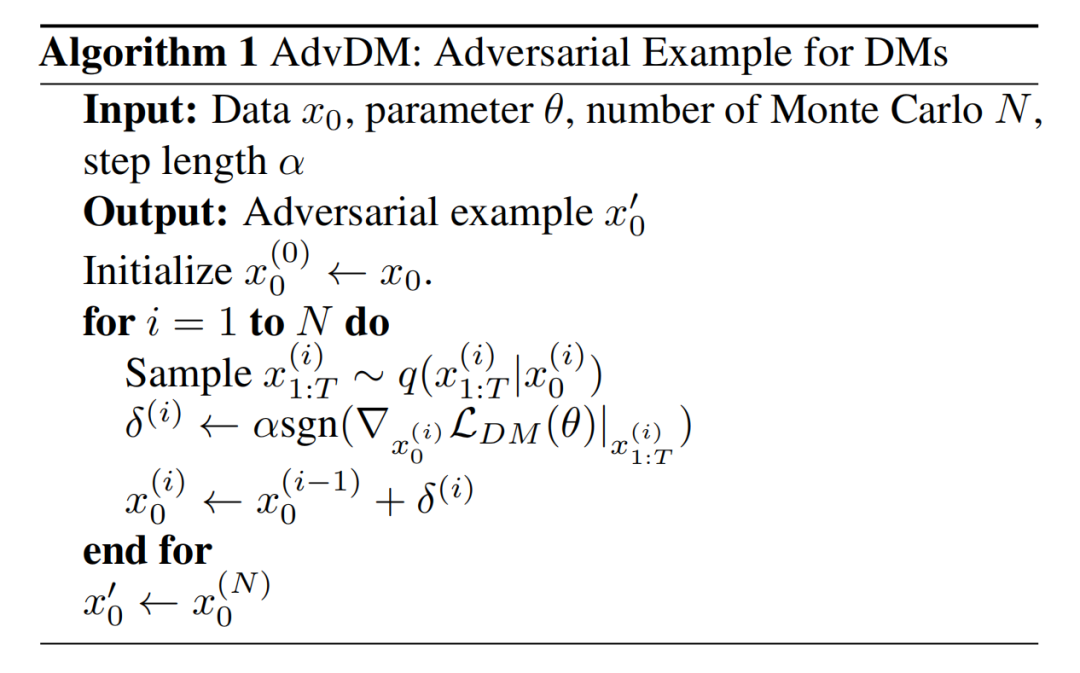

直觀地說,AdvDM 算法采樣不同的隱變量,并針對每個采樣進(jìn)行一次梯度上升。完整的算法如下:

實(shí)驗結(jié)果

作者在圖像內(nèi)容學(xué)習(xí)和圖像風(fēng)格遷移兩個場景下測試了 AdvDM 算法框架的效果。

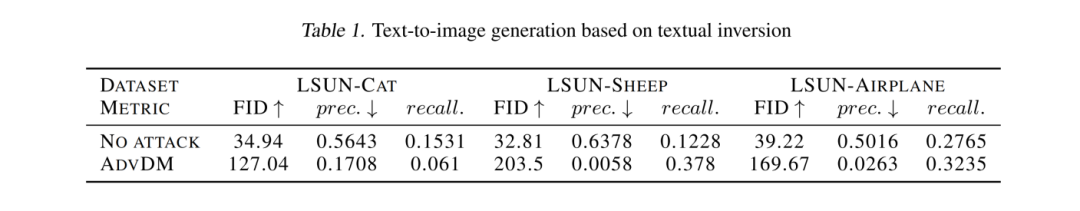

針對圖像內(nèi)容學(xué)習(xí)的保護(hù)

利用微調(diào)技術(shù),擴(kuò)散模型能夠?qū)⒁唤M圖像中的相同物體抽取為一個概念 S*,并基于概念生成新圖片。例如:通過學(xué)習(xí)一組同一只貓在森林中漫步的圖片,模型能夠生成這只貓在沙灘曬太陽的圖片。在本實(shí)驗中,作者把含有同一類物體的原圖作為對照組,把原圖經(jīng) AdvDM 處理后得到的對抗樣本作為實(shí)驗組,分別在兩組圖片上進(jìn)行擴(kuò)散模型微調(diào)訓(xùn)練,并利用微調(diào)中抽取的概念生成新圖片。此時,比較生成圖片和微調(diào)所用的訓(xùn)練圖片的差異能夠反映基于對照組和實(shí)驗組圖片進(jìn)行模型微調(diào)的效果差別。若基于實(shí)驗組生成圖片與原圖的差距遠(yuǎn)大于對照組中的差距,則可說明 AdvDM 算法成功阻止了模型通過微調(diào)抽取數(shù)據(jù)集中的內(nèi)容。

具體實(shí)驗中,作者使用了 LSUN-cat、LSUN-sheep 和 LSUN-airplane 三個單類別圖像數(shù)據(jù)集。作者從每個數(shù)據(jù)集中隨機(jī)抽取 1,000 張圖片選作微調(diào)訓(xùn)練數(shù)據(jù)集。根據(jù) Textual Inversion 微調(diào)方法的官方推薦,以每 5 張測試圖片為一組抽取一個概念 S*,并用抽取的概念生成總計 10,000 張圖像。作者使用 Fréchet Inception Distance(FID)和 Precision(prec.)對生成圖像與原始圖像的相似度進(jìn)行了評估。實(shí)驗結(jié)果顯示在下表中。可以觀察到,AdvDM 生成的對抗樣本顯著增加了生成的圖像的 FID 值并降低了 Precision 值。這表明 AdvDM 能夠有效地保護(hù)圖像的內(nèi)容,避免其內(nèi)容概念被擴(kuò)散模型抽取,并用于后續(xù)的生成。

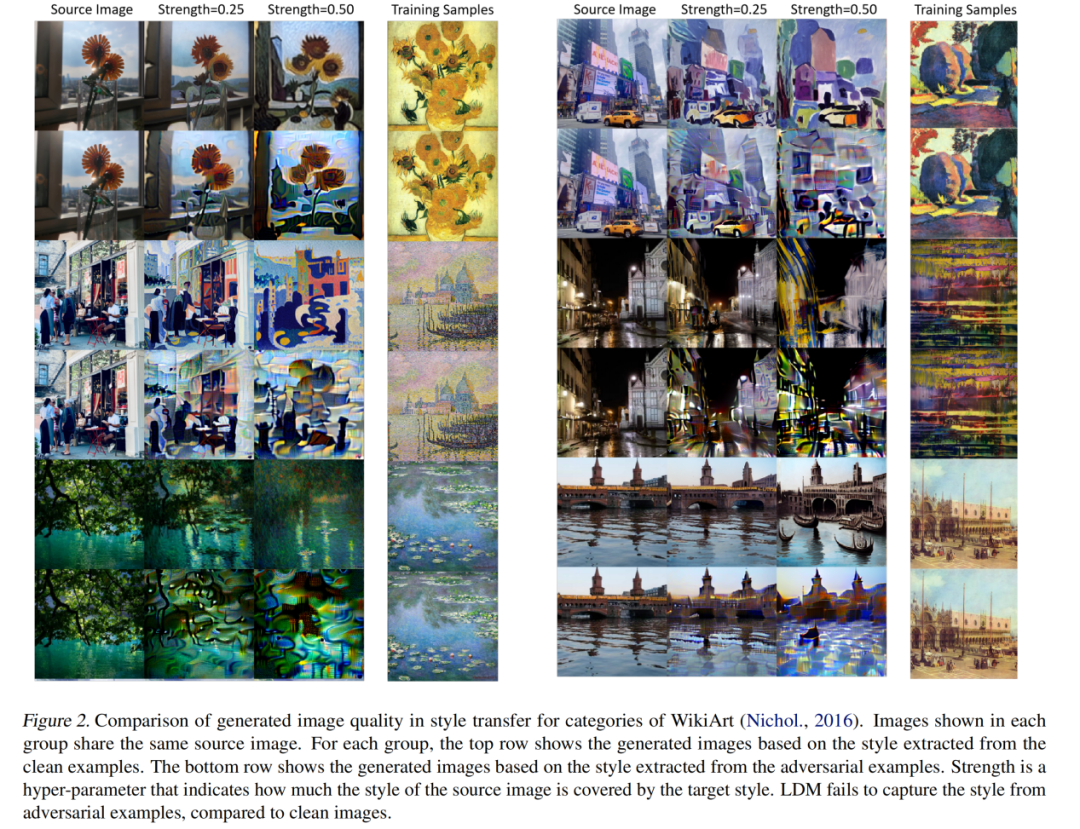

針對風(fēng)格遷移的保護(hù)

另外一個受到廣泛關(guān)注的重要微調(diào)場景是擴(kuò)散模型支持的的藝術(shù)風(fēng)格遷移。該場景通過在少量屬于相同或相似藝術(shù)風(fēng)格的畫作圖片上微調(diào)擴(kuò)散模型,能夠從圖片數(shù)據(jù)中歸納出其共同風(fēng)格的概念 S*,并基于這一概念生成具有類似風(fēng)格的新圖片。

針對該場景,作者在 WikiArt 數(shù)據(jù)集中選擇 10 位個人風(fēng)格鮮明的藝術(shù)家的畫作。作者使用 AdvDM 處理這些畫作,并在處理前、后的畫作上分別微調(diào)擴(kuò)散模型。在微調(diào)結(jié)束后,作者再通過模型學(xué)習(xí)的風(fēng)格概念生成新的畫作。生成對比結(jié)果如下圖所示。可以觀察到 AdvDM 處理后生成的圖片普遍圖像質(zhì)量較低,具有混亂的紋理,喪失了作為藝術(shù)作品的可用性。這表明 AdvDM 可有效對抗基于擴(kuò)散模型的藝術(shù)風(fēng)格遷移。

近期,作者已將該工作擴(kuò)展為開源應(yīng)用 Mist。Mist 針對更多的微調(diào)技術(shù)和更為復(fù)雜的場景均具有較好的效果,并對去噪有一定魯棒性。相關(guān)工作已更新在 GitHub 倉庫中。