歐洲推進人工智能監管

上周,歐洲立法者以壓倒性多數投票支持具有里程碑意義的人工智能法規《歐盟人工智能法案》(EU AI Act)。雖然該法案還沒有法律效力,但一邊倒的投票表明它很快就會在歐盟生效。在其他國家,公司仍然可以自由使用人工智能。例如,到目前為止,美國對人工智能代表的是風險還是機遇缺乏共識。

歐洲議會499名議員投了贊成票,28人反對,93人棄權,以較大優勢通過了《人工智能法案》草案。在議會成員、歐盟委員會和歐盟理事會進行談判后,今年晚些時候可能會進行最終投票。

2021年4月首次提出的《歐盟人工智能法案》將限制公司在其產品中使用人工智能的方式;要求人工智能以安全、合法、合乎道德和透明的方式實施;強制公司獲得某些人工智能用例的事先批準;并要求公司監控其人工智能產品。

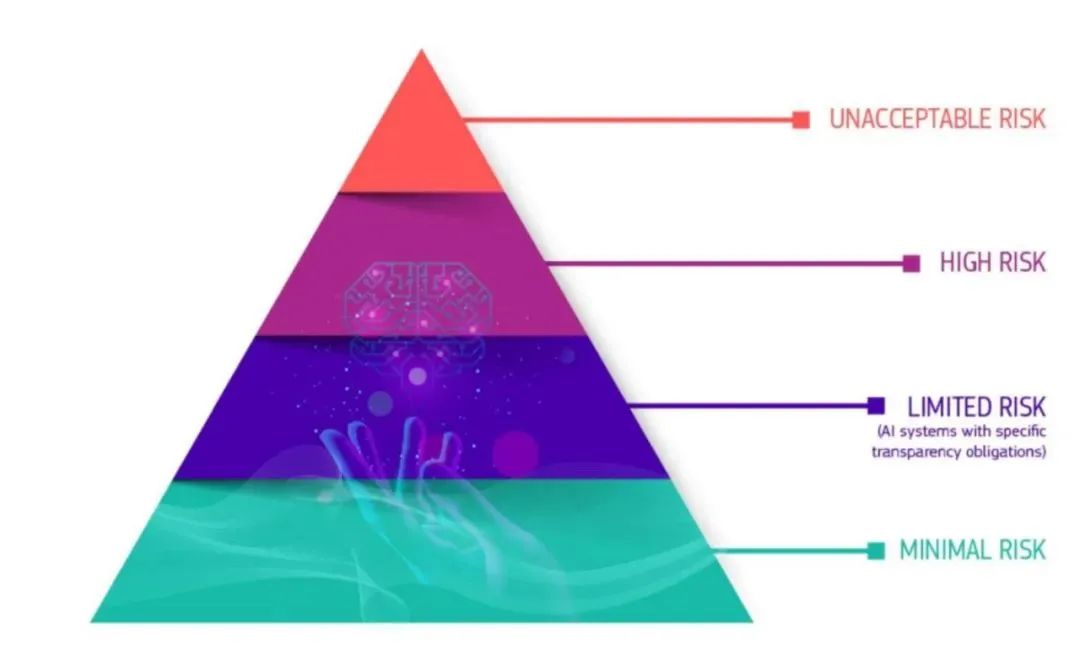

人工智能法將根據不同的人工智能使用帶來的風險對其進行排名并將其分為四類,并要求公司在人工智能給客戶使用之前達到相應安全標準。

第一類風險最小的人工智能,如垃圾郵件過濾器或視頻游戲,可以繼續像以往一樣使用,并且不受透明度要求的約束。

第二類人工智能被稱為“風險有限”,這一類別包括OpenAI的ChatGPT或谷歌的Bard等聊天機器人。根據擬議的法律,為了遵守《歐盟人工智能法案》,必須告知用戶他們正在與聊天機器人互動。

第三類是組織需要對所謂的高風險人工智能系統進行影響評估和審計,其中包括自動駕駛汽車,以及教育、移民和就業方面的決策支持系統。歐洲中央政府將在一個中央數據庫中跟蹤高風險的人工智能使用案例。

第四類被認為具有“不可接受”風險的人工智能,在歐盟永遠不會被允許,即使有審計和監管。這種被禁止的人工智能的包括實時生物特征監測和社會評分系統。不遵守規定可能會被處以相當于公司收入6%或7%的罰款。

法案投票結果表明大多數人支持人工智能已經失控,需要加以控制的觀點。一些著名的人工智能開發者最近呼吁禁止或暫停人工智能研究,包括Geoffrey Hinton和Yoshua Bengio,他們為普及現代神經網絡做出了巨大貢獻。如今他們簽署了人工智能安全中心的一份聲明,呼吁將人工智能視為全球風險。

Hinton今年初辭去了谷歌的工作,以便能夠更自由地談論人工智能的威脅,他將人工智能比作核武器。在5月3日Hinton對美國有線電視新聞網說:“我只是一個突然意識到這些東西比我們更聰明的科學家。”“…我們應該認真考慮如何阻止這些事情控制我們。”

然而,并不是所有的人工智能研究人員或計算機科學家都認同這一觀點。Yann LeCun是Facebook母公司meta的人工智能研究負責人,他與Hinton和Bengio一起因在神經網絡方面的集體工作而獲得2018年圖靈獎,他一直直言不諱地認為,現在不是監管人工智能的合適時機。

LeCun近期在推特上表示,他認為“過早的監管會扼殺創新”,特別是在提到新的歐盟人工智能法案時。

LeCunn上周在法國巴黎舉行的VivaTech會議上表示:“從總體上講,人工智能本質上是好的,因為人工智能的作用是讓人們變得更聰明。”“你可以把人工智能視為人類智慧的放大器。當人們更聰明時,事情就會發生。人們的生產力更高,更快樂。”

Meta的人工智能主管Yann LeCun在VivaTech上表示:“你可以把人工智能視為人類智能的放大器。”

LeCunn繼續說道:“現在毫無疑問,壞人可以利用它來做壞事。”“然后是一個問題,好人是否比壞人多。”

商業轉型專家Kamales Lardi表示,正如歐盟的《通用數據保護條例》(GDPR)構成了其他國家和美國各州(如加利福尼亞州)許多數據隱私法的基礎一樣,擬議的《歐盟人工智能法案》將為世界各地的人工智能監管開辟道路。

她說:“歐盟的法案可能會成為一項全球標準,對人工智能如何影響我們的生活以及如何在全球范圍內對其進行監管產生影響。”“然而,該法案也有局限性……監管應側重于在創新和技術錯誤應用之間取得智能平衡。該法案也不靈活,沒有考慮到人工智能發展的指數級速度,一兩年后人工智能的發展速度可能與今天大不相同。”

總部位于倫敦的人工智能公司Encord的聯合創始人兼總裁Ulrik Stig Hansen表示,現在不是監管人工智能的合適時機。“我們聽說過太大而無法監管,但太早怎么辦?”“按照歐盟的傳統方式,他們正在尋求監管一項新技術,而這項技術很少有企業或消費者采用,也很少有人在這一點上進行開發。”他說,由于我們還沒有牢牢把握人工智能系統固有的風險,現在制定監管人工智能的法律還為時過早。

“一個更明智的方法可能是相關行業機構像監管其他技術一樣監管人工智能。”“人工智能作為一種醫療設備,是一個很好的例子,它需要獲得美國食品藥品監督管理局(FDA)的批準或CE標志。這與我們在英國看到的情況一致,英國采取了更務實的支持創新的方法,并將責任交給了人工智能應用領域的現有監管機構。”

雖然美國目前還沒有制定人工智能法規,但正在采取措施,指導各組織合乎道德地使用人工智能。今年1月,美國國家標準與技術研究所(NIST)發布了《人工智能風險管理框架》(RMF),該框架指導各組織完成人工智能系統的規劃、衡量、管理和治理過程。RMF有幾件事要做,包括有可能成為多方認可的法律標準。更重要的是,它保留了適應快速變化的人工智能技術的靈活性,這是《歐盟人工智能法案》所缺乏的。