中科院、阿里出品FF3D,創建自定義風格化3D人像只需三分鐘

3D 人像合成一直是備受關注的 AIGC 領域。隨著 NeRF 和 3D-aware GAN 的日益進步,合成高質量的 3D 人像已經不能夠滿足大家的期待,能夠通過簡單的方式自定義 3D 人像的風格屬性成為了更高的目標,例如直接使用文本描述指導合成想要的 3D 人像風格。

但是 3D 人像的風格化存在一個普遍的問題,當一個高質量的 3D 人像合成模型訓練好后(例如訓練一個 EG3D 模型),后續往往很難對其進行較大的風格化改變。基于模型隱空間編輯的方法會受限于預訓練 3D 人像合成模型的數據分布;直接對 3D 人像不同視角進行風格化會破壞 3D 一致性;自己收集創建一個風格化的多視角人像數據集成本很高。以上這些問題使得大家難以簡單的創建風格化 3D 人像。

本文作者們提出一種簡單高效的風格化 3D 人像合成方法,能夠快速實現基于文本描述的自定義 3D 人像風格化。

圖片

圖片

- 論文地址:https://arxiv.org/pdf/2306.15419.pdf

- 項目網站:https://tianxiangma.github.io/FF3D/

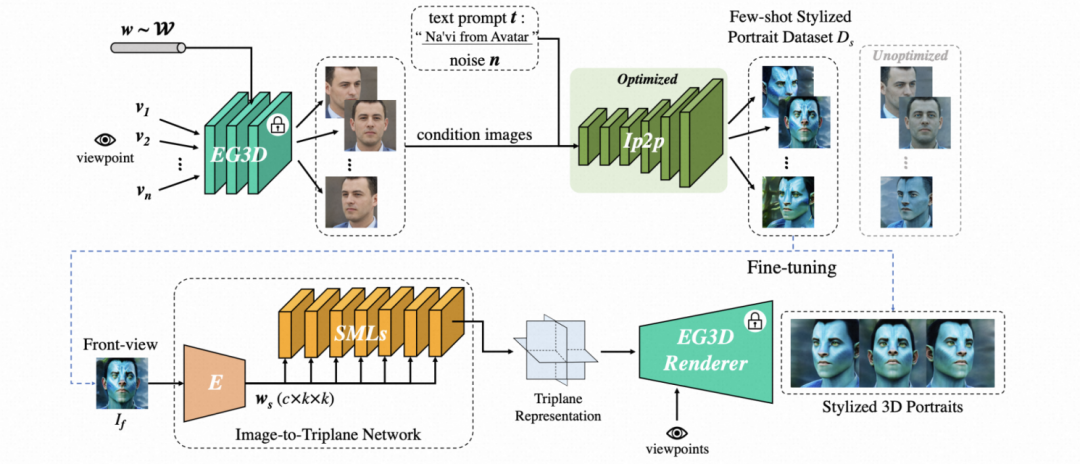

方法框架

該方法的核心步驟有兩個:1. 小樣本風格化人像數據集構建,2. Image-to-Triplane 模型微調。方法框架如下。

圖片

圖片

使用兩種先驗模型構建小樣本風格化人像數據集

人工收集多視角風格化人像數據是困難的,但是研究團隊可以利用已有的預訓練模型來間接構建這種數據。本文采用兩個預訓練先驗模型 EG3D 和 Instruct-pix2pix (IP2P) 來實現這一目標。

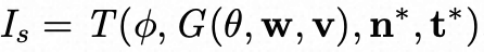

EG3D 是一個高質量的 3D-aware GAN 方法用來提供多視角 3D 一致的人像合成結果,計作: 。theta 是模型的參數,w 是從 W 隱空間隨機采樣的向量編碼,v 是人像的渲染方向。該研究隨機采樣一個 w,并從 - 30 度到 30 度的俯仰角和偏航角范圍內均勻采樣 i*i 個不同視角的人像。

。theta 是模型的參數,w 是從 W 隱空間隨機采樣的向量編碼,v 是人像的渲染方向。該研究隨機采樣一個 w,并從 - 30 度到 30 度的俯仰角和偏航角范圍內均勻采樣 i*i 個不同視角的人像。

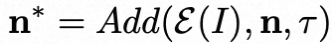

IP2P 是一個文本引導的圖像編輯大模型,該研究用其來對不同視角的人像進行風格化編輯,計作: 。phi 是模型參數,I 代表輸入的人像圖像,n 是隨機噪聲,c 是文本的條件輸入(后面使用 t 來表示)。借助 T ,研究團隊可以將上述 i*i 個不同視角的人像進行文本引導的風格化編輯。同時,在實驗中研究團隊發現 IP2P 在一些文本提示下對于同一個人像的不同視角的風格化編輯結果存在較大的差異。因此該研究對其推理過程進行一些改進,將原始的噪聲 n 替換為

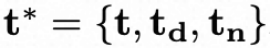

。phi 是模型參數,I 代表輸入的人像圖像,n 是隨機噪聲,c 是文本的條件輸入(后面使用 t 來表示)。借助 T ,研究團隊可以將上述 i*i 個不同視角的人像進行文本引導的風格化編輯。同時,在實驗中研究團隊發現 IP2P 在一些文本提示下對于同一個人像的不同視角的風格化編輯結果存在較大的差異。因此該研究對其推理過程進行一些改進,將原始的噪聲 n 替換為 。該式表示將噪聲 n 與輸入人像 I 的信息進行加權融合,使得不同視角的人像 I 的風格化編輯結果趨緊相同。此外該研究又引入輔助文本提示 td 和消極文本提示 tn 來增強 IP2P 的生成質量,即新的文本提示為

。該式表示將噪聲 n 與輸入人像 I 的信息進行加權融合,使得不同視角的人像 I 的風格化編輯結果趨緊相同。此外該研究又引入輔助文本提示 td 和消極文本提示 tn 來增強 IP2P 的生成質量,即新的文本提示為 。

。

基于上述過程,該研究提出風格化人像合成 pipeline 為:

圖片

圖片

。該過程為純模型推理不需要額外的訓練。對于 i*i 個不同視角的合成人像,研究團隊可以快速構建出一個小樣本風格化人像數據集 Ds。

Image-to-Triplane 模型微調

構建出 Ds 后,需要學習一個符合該數據集人像風格的的 3D 模型。針對這個問題,研究團隊提出一個 Image-to-Triplane (I2T) 網絡,它可以建立人像圖像到 Triplane 表征到映射。研究將預訓練的 EG3D 模型的 Triplane 合成網絡替換為本文提出的的 I2T 網絡,并復用剩余的渲染網絡。

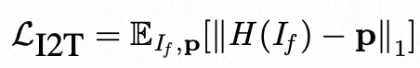

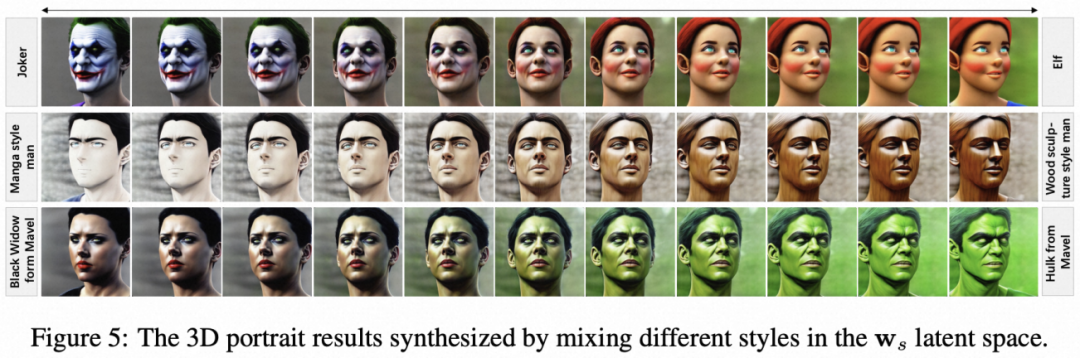

因為 Ds 數據集的不同視角風格化肖像是 3D 不一致的,所以首先需要對 I2T 網絡進行預訓練,來預先建立人像到 Triplane 表征的準確映射關系。研究團隊利用 EG3D 的合成數據來預訓練 I2T 網絡,訓練損失函數如下:

圖片

圖片

H 代表 I2T 網絡,If 為正視角人像圖像輸入(由 EG3D 采樣提供),p 是 Triplane 表征的真值(也由 EG3D 采樣提供)。

利用預訓練的 I2T 網絡,研究團隊就可以在構建好的 Ds 數據集上進行快速微調,讓 I2T 的隱空間擬合到 Ds 數據集風格分布。模型微調的損失函數包含重建損失和密度正則損失: 該模型微調是十分高效的,可以在 3 分鐘左右完成。至此,就能夠得到一個自定義風格(使用文本提示 t 指定)的 3D 人像模型。

該模型微調是十分高效的,可以在 3 分鐘左右完成。至此,就能夠得到一個自定義風格(使用文本提示 t 指定)的 3D 人像模型。

實驗

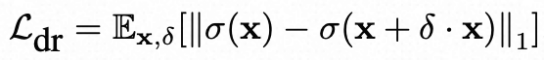

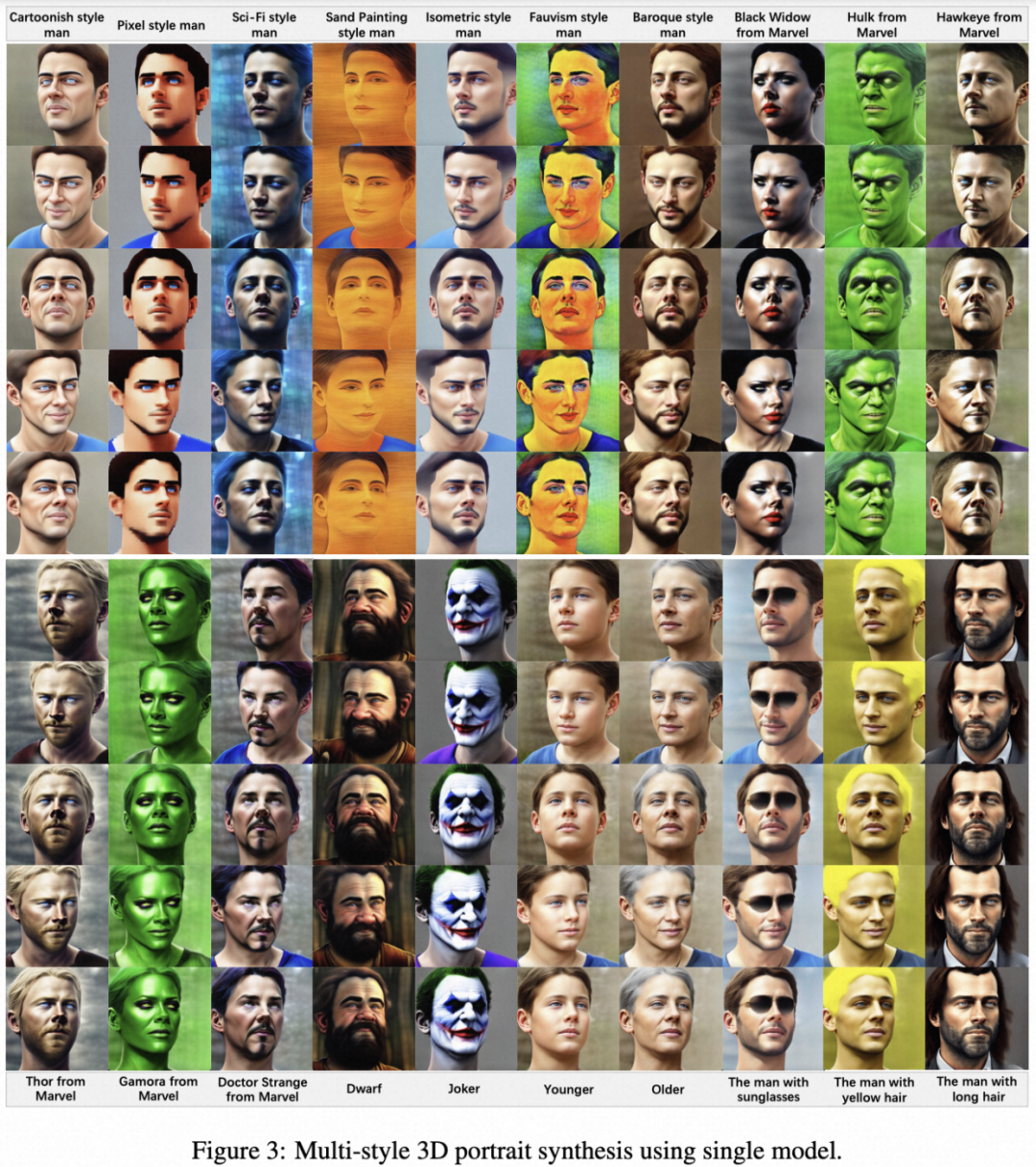

在本文的首頁所展示的就是一系列高質量的風格化 3D 人像合成結果。為了驗證本文方法的可擴展性,研究團隊構建了一個多風格多身份人像數據集。他們利用 ChatGPT 生成 100 種不同風格類型的問題提示,包含藝術風格、電影角色風格、游戲角色風格、以及基礎屬性編輯風格。對于每種風格使用本文的人像風格化 pipeline 合成 10*10 張不同視角的風格化人像,進而構建出包含 10,000 張圖像的多風格單身份人像數據集(MSSI)。此外,在 MSSI 的基礎上擴展每種風格的身份屬性,即隨機采樣不同的 w 向量,得到多風格多身份人像數據集(MSMI)。該方法在這兩個數據集上的微調模型的 3D 人像合成結果如下:

圖片

圖片

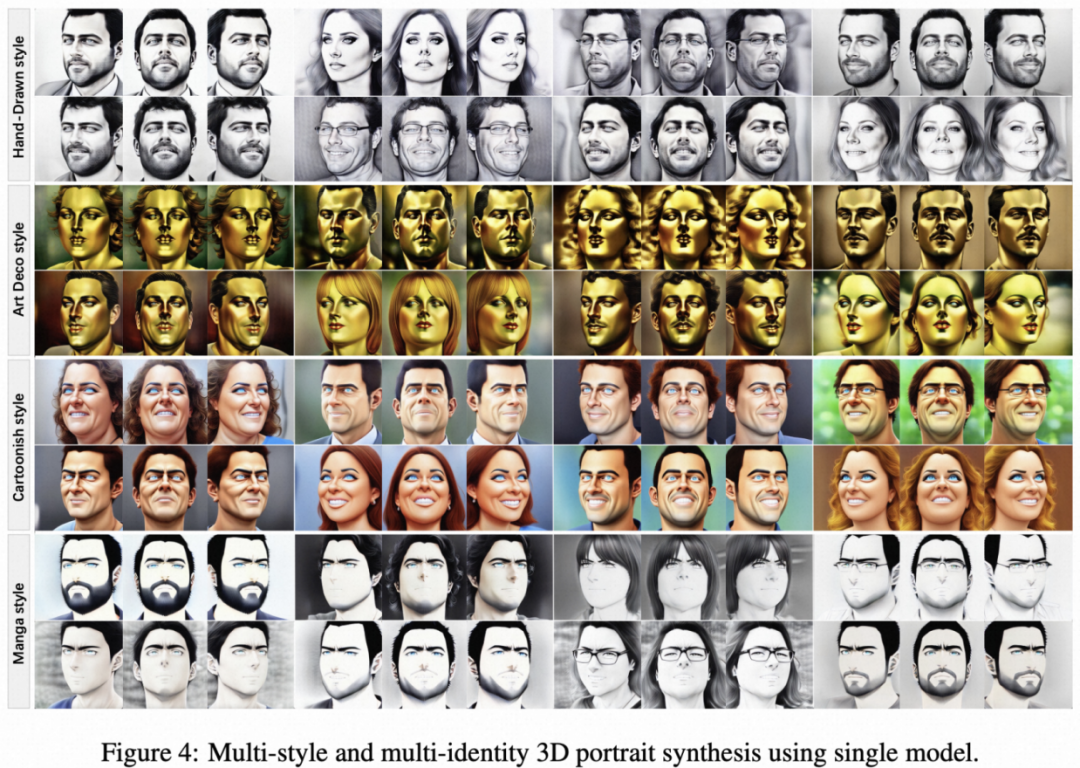

在 I2T 的 ws 隱空間進行插值即可實現 3D 人像的風格變化:

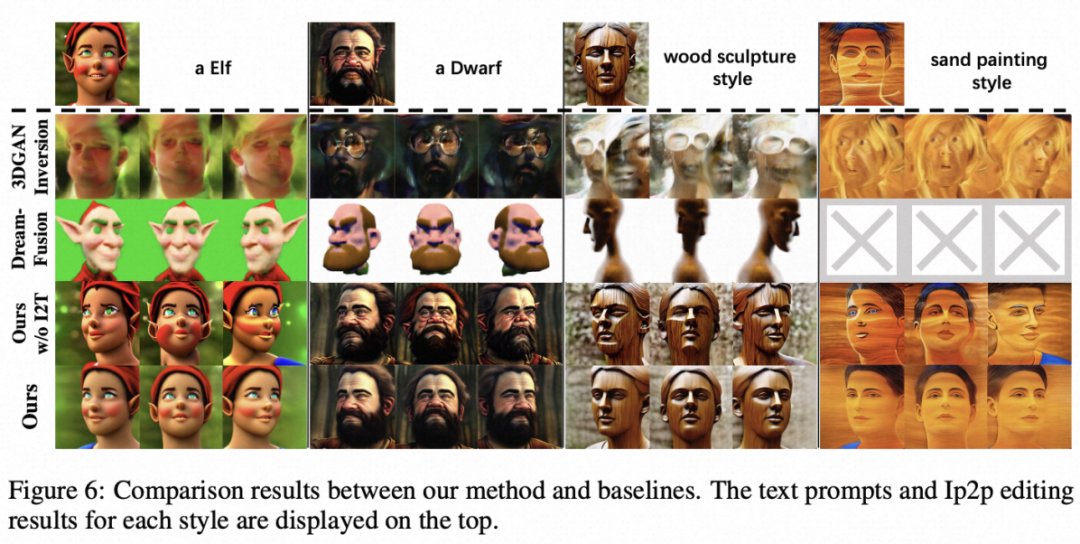

該方法與 baseline 方法的對比結果如下:

更多的方法細節和實驗結果請參考論文原文以及項目網站。