LLM評估綜述論文問世,分三方面全面總結(jié),還帶資料庫

大型語言模型(LLM)已經(jīng)得到了學(xué)術(shù)界和產(chǎn)業(yè)界的廣泛關(guān)注,而為了開發(fā)出好用的 LLM,適當?shù)脑u估方法必不可少。現(xiàn)在,一篇有關(guān) LLM 評估的綜述論文終于來了!其中分三方面對 LLM 評估的相關(guān)研究工作進行了全面的總結(jié),可幫助相關(guān)研究者索引和參考。

不僅如此,該論文作者還創(chuàng)建了一個開源資料庫,讓用戶可以方便地添加和共享相關(guān)的新研究:https://github.com/MLGroupJLU/LLM-eval-survey

對科學(xué)家來說,理解智能的本質(zhì)以及確定機器是否能具有智能是極具吸引力的課題。人們普遍認為,人類之所以有能力執(zhí)行推理、檢驗假設(shè)以及為未來做準備,就是因為我們具有真正的智能。人工智能研究者關(guān)注的是開發(fā)基于機器的智能。正確的度量方式有助于理解智能。舉個例子,為了測試人類的智能水平 / 智力,常常會用到 IQ 測試。

而在 AI 領(lǐng)域,AI 開發(fā)的一個長期目標是讓 AI 通過圖靈測試(Turing Test),這需要一個能被廣泛認可的測試集,通過辨別 AI 和人類對其的響應(yīng)來評估 AI 的智能水平。研究者普遍相信,如果計算機能成功通過圖靈測試,那么就可以認為它具有智能。因此,從更廣泛的視角看,AI 的編年史可描述為智能模型和算法的創(chuàng)造和評估的時間線。每當出現(xiàn)一個新的 AI 模型或算法,研究者都會使用有難度的特定任務(wù)來仔細評估其在真實世界場景中的能力。

舉個例子,曾在上世紀 50 年代被吹捧為通用人工智能(AGI)方法的感知器算法之后被證明名不符實,因為其難以求解 XOR(異或)問題。之后興起并得到應(yīng)用的支持向量機(SVM)和深度學(xué)習(xí)都是 AI 發(fā)展圖景中的重大里程碑,但它們也都各有短板。

過去的研究歷程向我們揭示了評估的重要性。評估是一種重要工具,能幫助我們識別當前系統(tǒng)的局限性并讓我們獲得設(shè)計更強模型的信息。

目前而言,學(xué)術(shù)界和產(chǎn)業(yè)界最感興趣的技術(shù)方法是大型語言模型(LLM)。已有的研究表明:LLM 表現(xiàn)優(yōu)異,已經(jīng)成為 AGI 的有力候選。相比于之前受限于特定任務(wù)的模型,LLM 有能力解決多種不同任務(wù)。由于 LLM 既能應(yīng)對一般性自然語言任務(wù),又能處理特定領(lǐng)域的任務(wù),因此越來越受有特定信息需求的人的歡迎,比如學(xué)生和病人。

評估對于 LLM 的成功來說至關(guān)重要,原因如下。

首先,評估 LLM 有助于我們更好地了解 LLM 的優(yōu)勢和劣勢。舉個例子,PromptBench 基準測試表明,當前的 LLM 對對抗性 prompt 很敏感,因此為了更好的性能,必需仔細設(shè)計 prompt。

第二,更好的評估可以為人類與 LLM 的交互提供更好的指引,這能為未來的交互設(shè)計和實現(xiàn)提供思路。

第三,LLM 由于廣泛適用于多種任務(wù),因此確保其安全性和可靠性就至關(guān)重要了,尤其是在金融和醫(yī)療等行業(yè)。

最后,隨著 LLM 能力增多,其也在越來越大,因此現(xiàn)有的評估方法可能不足以評估它們的能力和潛在風險。這就引出了這篇綜述論文的目標:讓 AI 社區(qū)認識到 LLM 評估的重要性并指引有關(guān) LLM 評估協(xié)議的未來新研究。

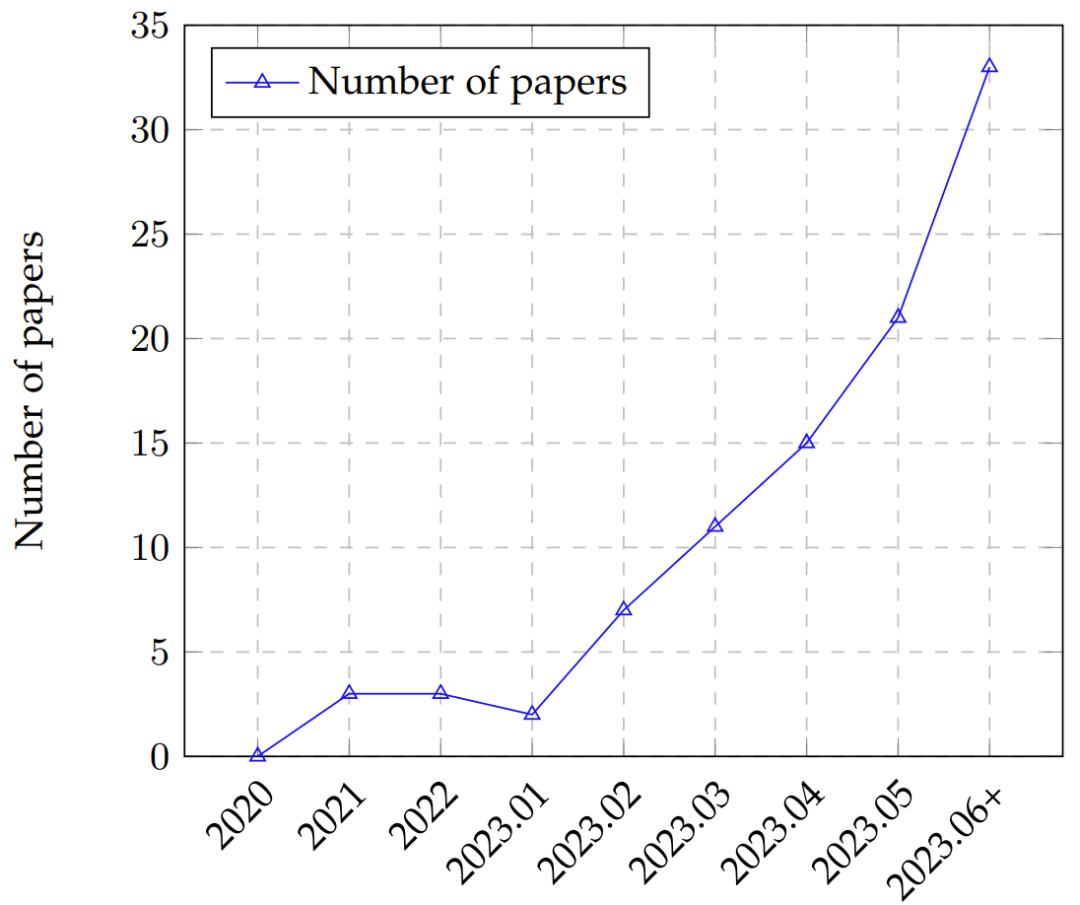

隨著 ChatGPT 和 GPT-4 的推出,已經(jīng)出現(xiàn)了一些旨在從不同方面評估 ChatGPT 和其它 LLM 的研究工作(圖 2),其中涵蓋很多因素,包括自然語言任務(wù)、推理、穩(wěn)健性、可信度、醫(yī)學(xué)應(yīng)用和道德考量。盡管如此,仍然缺乏一篇涵蓋整個評估圖景的全面綜述。此外,LLM 的持續(xù)演進還會引入需要評估的新方面,這會給現(xiàn)有評估帶來困難,并由此更加需要徹底的和多方面的評估技術(shù)。盡管有一些研究工作宣傳 GPT-4 可以被視為 AGI 的星星之火,但另一些人則反對這個說法,因為 GPT-4 的評估方法本質(zhì)上還是啟發(fā)式的。

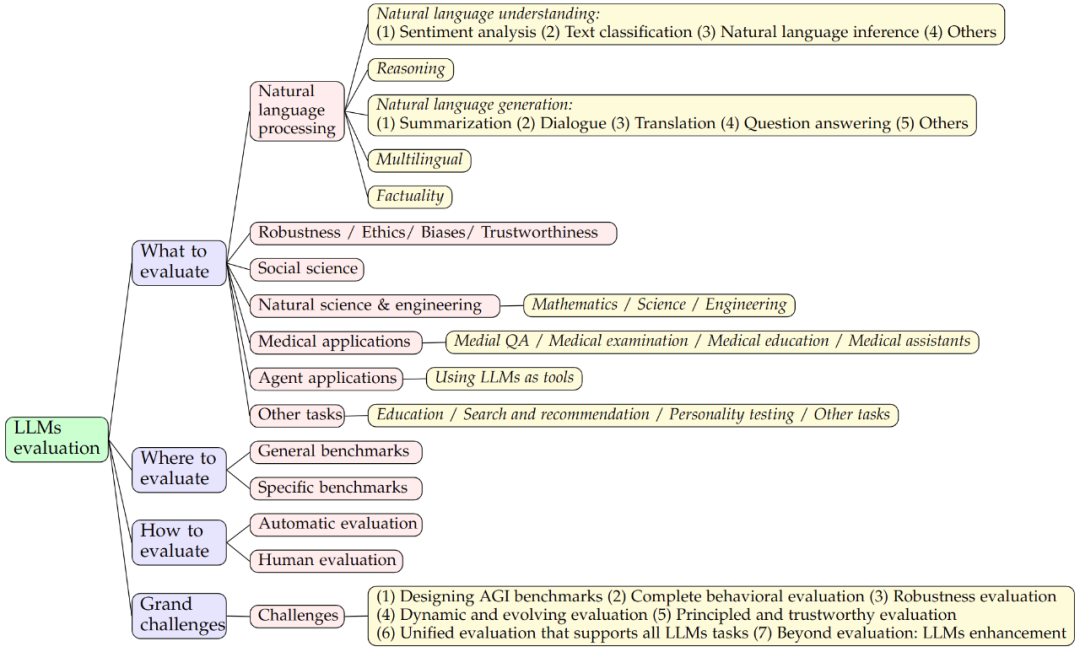

這篇來自吉林大學(xué)、微軟亞洲研究院和卡內(nèi)基?梅隆大學(xué)等機構(gòu)論文對大型語言模型評估進行了全面綜述。如圖 1 所示,作者從三個維度對現(xiàn)有研究工作進行了探索:1) 評估什么,2) 何處評估,3) 如何評估。

論文地址:https://arxiv.org/pdf/2307.03109.pdf

具體來說,「評估什么」涵蓋 LLM 現(xiàn)有的評估任務(wù),「何處評估」涉及對所用的數(shù)據(jù)集和基準的適當選擇,「如何評估」關(guān)注的是給定任務(wù)和數(shù)據(jù)集下的評估過程。這三個維度是 LLM 評估不可或缺的一部分。之后,作者還會討論 LLM 評估領(lǐng)域潛在的未來挑戰(zhàn)。

圖 2:LLM 評估論文隨時間的趨勢,從 2020 年到 2023 年 6 月(6 月數(shù)據(jù)包含 7 月的部分論文)

本文的主要貢獻包括:

- 本文從三方面全面地概述了 LLM 評估:評估什么、何處評估、如何評估。其中采用的分類方法是普適的并且涵蓋 LLM 評估的整個生命周期。

- 在「評估什么」方面,本文總結(jié)了多個領(lǐng)域的現(xiàn)有任務(wù),并得到了有關(guān) LLM 的成功和失敗案例的富有洞見的結(jié)論。

- 在「何處評估」方面,本文對評估指標、數(shù)據(jù)集和基準進行了總結(jié),可幫助讀者透徹地理解 LLM 評估的當前圖景。在「如何評估」方面,本文探索了當前協(xié)議并總結(jié)了新的評估方法。

- 本文還進一步討論了評估 LLM 方面的未來挑戰(zhàn)。為了促進構(gòu)建一個有關(guān) LLM 評估的合作社區(qū),作者還維護著一個 LLM 評估相關(guān)材料的資源庫并已開源:https://github.com/MLGroupJLU/LLM-eval-survey

背景

大型語言模型(LLM)

GPT-3、InstructGPT 和 GPT-4 等許多 LLM 背后的核心模塊是 Transformer 中的自注意力模塊,Transformer 則是語言建模任務(wù)的基本構(gòu)建模塊。Transformer 已經(jīng)為 NLP 領(lǐng)域帶來了變革,因為其能高效處理序列數(shù)據(jù)、支持并行化并能捕獲文本中的長程依賴關(guān)系。

LLM 的一大關(guān)鍵特性是上下文學(xué)習(xí),即模型可被訓(xùn)練基于給定的上下文或 prompt 生成文本。這讓 LLM 可以生成更為連貫且更長上下文相關(guān)的響應(yīng),從而讓它們更適用于交互式和會話應(yīng)用。

根據(jù)人類反饋的強化學(xué)習(xí)(RLHF)是 LLM 的另一重要方面。該技術(shù)是使用人類生成的響應(yīng)作為獎勵對模型進行微調(diào),從而讓模型可以學(xué)習(xí)自身的錯誤并隨時間提升性能。

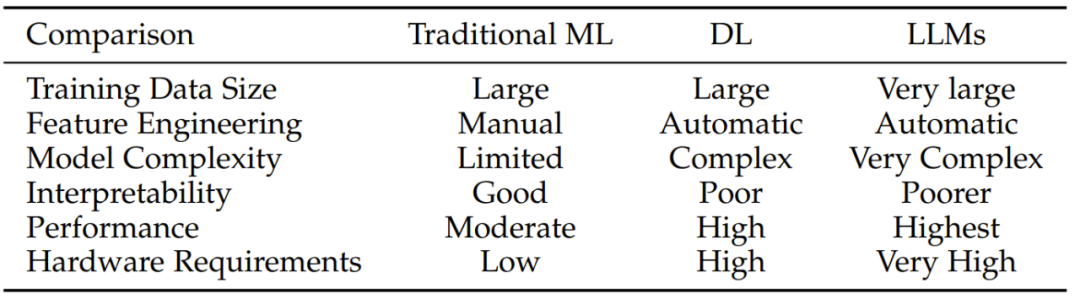

表 1:對比傳統(tǒng)機器學(xué)習(xí)、深度學(xué)習(xí)和 LLM

AI 模型評估

AI 模型評估是評估模型性能的重要步驟。目前已有一些標準模型評估協(xié)議,包括 K-fold 交叉驗證、Holdout 驗證、Leave One Out 交叉驗證(LOOCV)、Bootstrap 和 Reduced Set。

圖 3:AI 模型的評估過程

隨著 LLM 應(yīng)用增多,其可解釋性卻越來越差,因此現(xiàn)有的評估協(xié)議可能不足以徹底評估 LLM 的真實能力。

評估什么

開發(fā)語言模型(尤其是大型語言模型)的最初目標是提升 AI 在自然語言處理任務(wù)上的性能,其中包含理解任務(wù)和生成任務(wù)。正因為此,大多數(shù)評估研究關(guān)注的也主要是自然語言任務(wù)。

自然語言處理任務(wù)

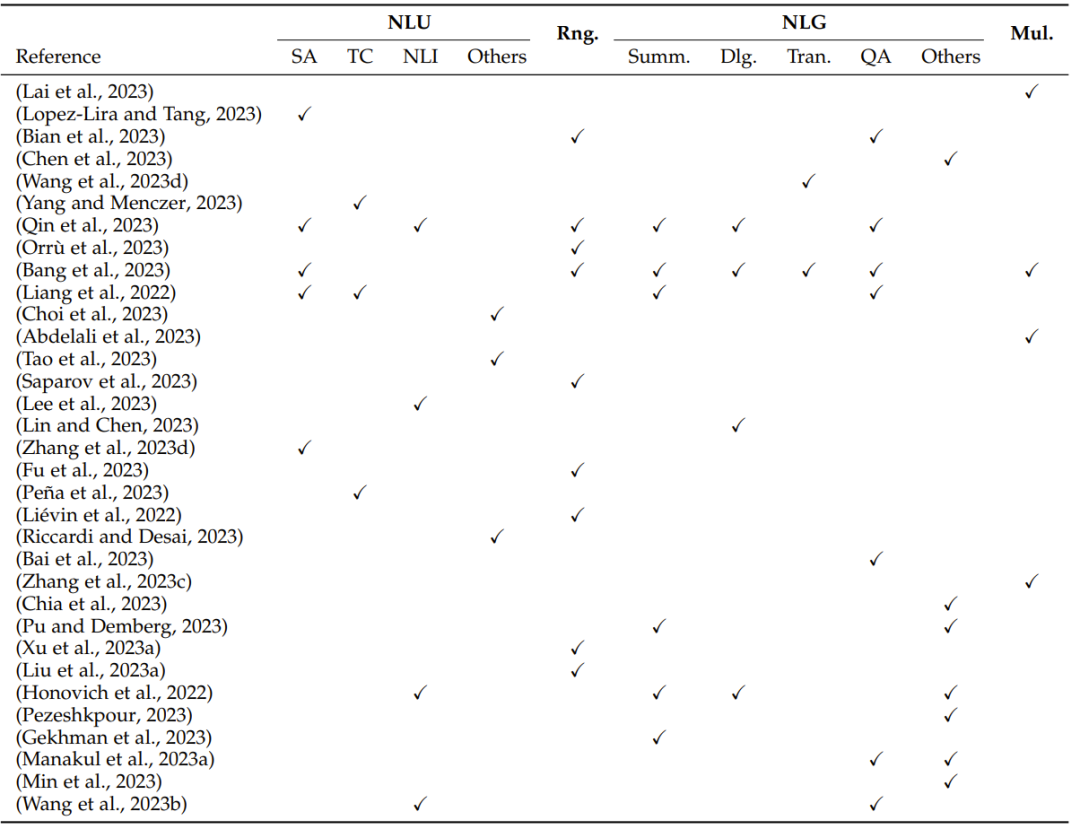

表 2:基于自然語言處理任務(wù)的評估概況:NLU(自然語言理解,包括 SA(情感分析)、TC(文本分類)、NLI(自然語言推理)和其它 NLU 任務(wù))、Rng.(推理)、NLG(自然語言生成,包括 Summ.(摘要)、Dlg.(對話)、Tran.(翻譯)、QA(問答)和其它 NLG 任務(wù))和 Mul.(多語言任務(wù))

穩(wěn)健性、道德、偏見和可信度

LLM 的評估涵蓋穩(wěn)健性、道德、偏見和可信度等關(guān)鍵方面。為了全面評估 LLM 的表現(xiàn),這些因素的重要性正在提升。

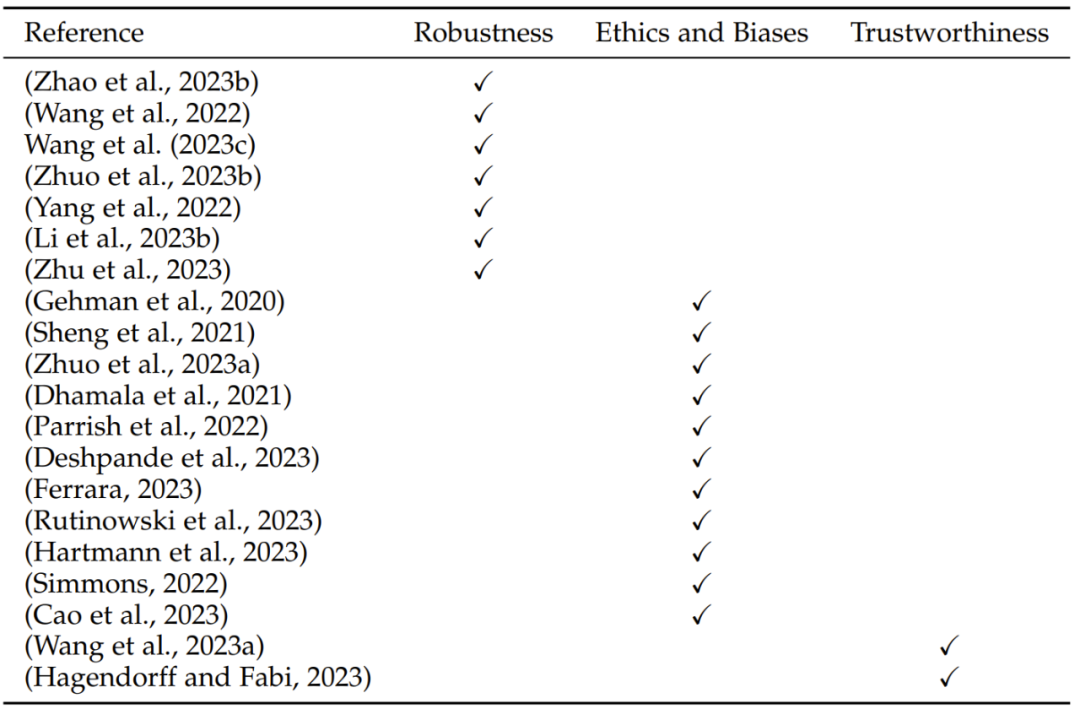

表 3:在穩(wěn)健性、道德、偏見和可信度方面的 LLM 評估研究概況

社會科學(xué)

社會科學(xué)研究的是人類社會和個人行為,包括經(jīng)濟學(xué)、社會學(xué)、政治學(xué)、法學(xué)等學(xué)科。評估 LLM 在社會科學(xué)領(lǐng)域的表現(xiàn)對于學(xué)術(shù)研究、政策制定和社會問題解決而言具有重要意義。這些評估有助于推進模型在社會科學(xué)領(lǐng)域的應(yīng)用并改善模型的質(zhì)量,提升對人類社會的理解以及推動社會進步。

自然科學(xué)和工程學(xué)

評估 LLM 在自然科學(xué)和工程學(xué)領(lǐng)域的表現(xiàn)有助于引導(dǎo)科學(xué)研究的應(yīng)用和發(fā)展、技術(shù)開發(fā)以及工程研究。

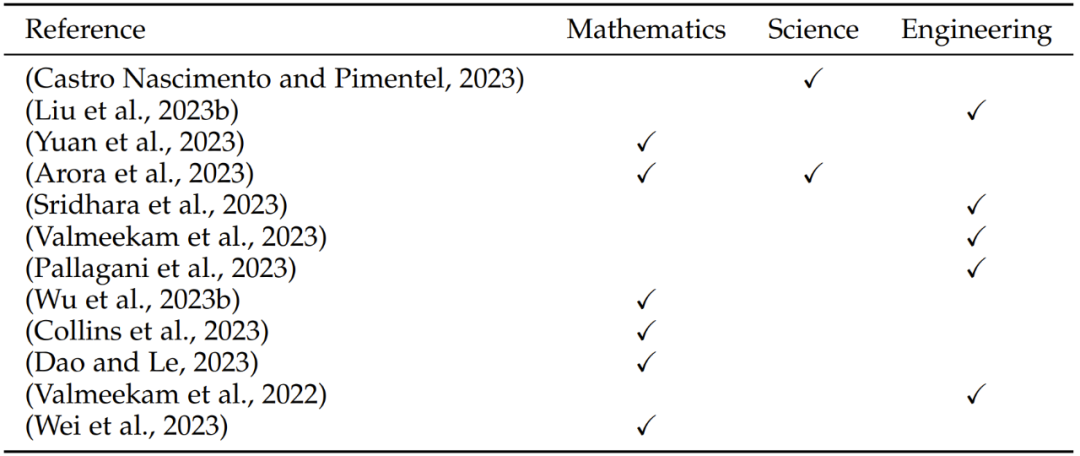

表 4:在自然科學(xué)和工程學(xué)任務(wù)方面的評估研究概況,其中涉及三個方面:數(shù)學(xué)、科學(xué)和工程學(xué)

醫(yī)學(xué)應(yīng)用

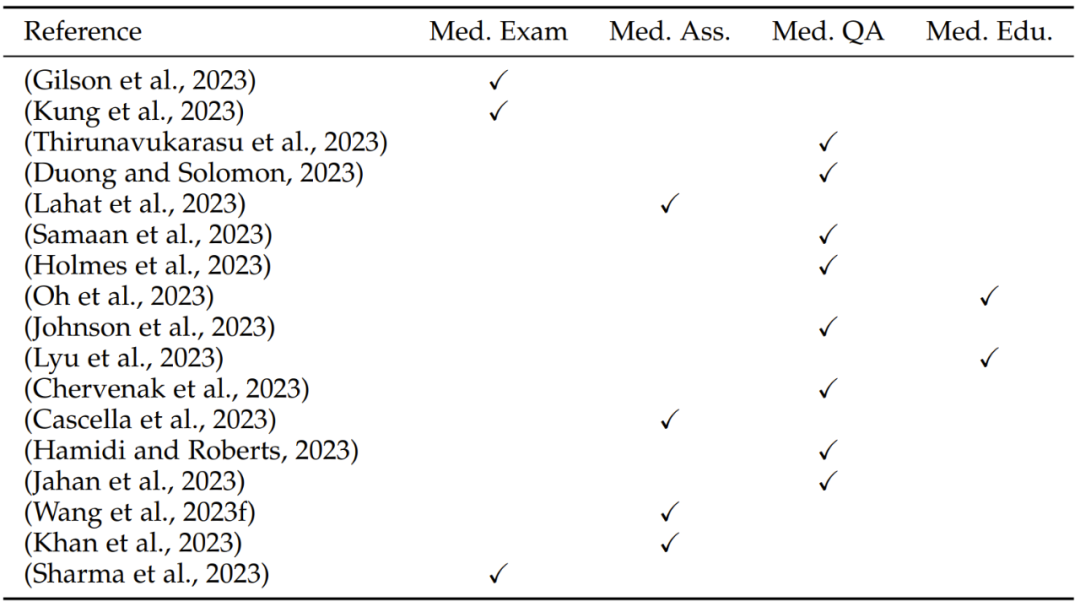

LLM 在醫(yī)學(xué)領(lǐng)域的應(yīng)用最近引起了極大的關(guān)注。這里從四個方面介紹 LLM 在醫(yī)學(xué)領(lǐng)域的應(yīng)用:醫(yī)學(xué)問答、醫(yī)學(xué)檢查、醫(yī)學(xué)評估和醫(yī)學(xué)教育。

表 5:LLM 的醫(yī)學(xué)應(yīng)用方面的評估研究概況,其中涉及四個方面:Med. Exam.(醫(yī)學(xué)檢查)、Med. Ass.(醫(yī)學(xué)評估)、Med. QA(醫(yī)學(xué)問答)和 Med. Edu.(醫(yī)學(xué)教育)

智能體應(yīng)用

LLM 不僅專注于一般語言任務(wù),而是可以用作一種強大工具,應(yīng)對不同領(lǐng)域的任務(wù)。通過為 LLM 配備外部工具,可以極大擴展模型能力。

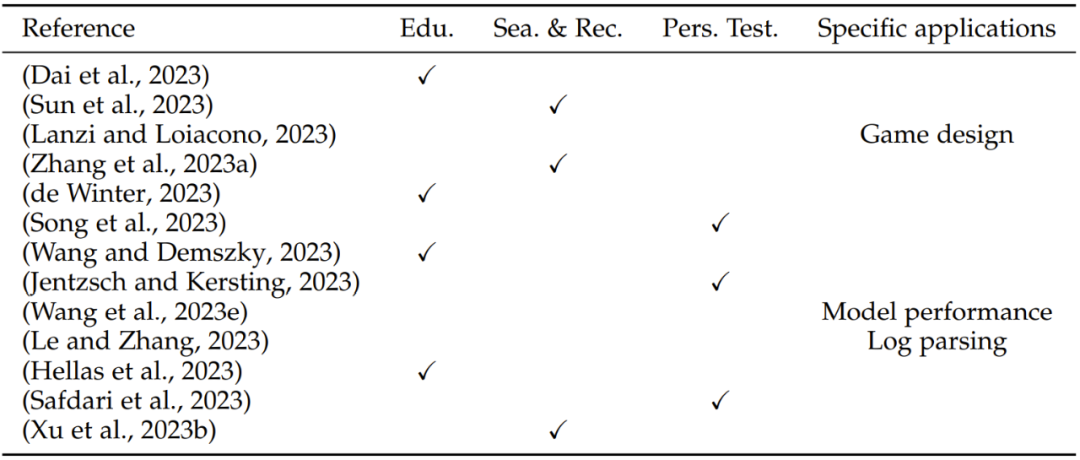

其它應(yīng)用

除了上述分類,LLM 還能用于其它一些不同領(lǐng)域,包括教育、搜索和推薦、性格測試以及特定領(lǐng)域的應(yīng)用。

表 6:LLM 的其它應(yīng)用方面的評估研究概況,其中涉及四個方面:Edu.(教育)、Sea. & Rec. (搜索和推薦)、Pers. Test.(性格測試)和 Specific applications(特定領(lǐng)域的應(yīng)用)

何處評估:數(shù)據(jù)集和基準

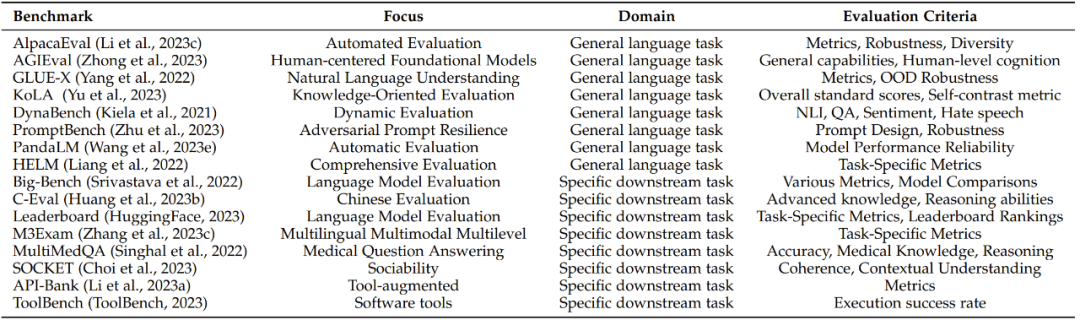

LLM 評估數(shù)據(jù)集的作用是測試和比較不同語言模型在各種任務(wù)上的性能。GLUE 和 SuperGLUE 等數(shù)據(jù)集的目標是模擬真實世界的語言處理場景,其中涵蓋多種不同任務(wù),如文本分類、機器翻譯、閱讀理解和對話生成。這里不關(guān)注用于語言模型的任何單個評估數(shù)據(jù)集,關(guān)注的則是用于評估 LLM 的基準。

由于 LLM 在不斷演進,因此基準也會變化,這里列出了 13 個常用的基準。每個基準側(cè)重于不同的方面和評估指標,都為各自領(lǐng)域提供了寶貴的貢獻。為了更好地進行總結(jié),這里將基準分為兩類:通用語言任務(wù)基準和特定下游任務(wù)基準。

表 7:LLM 評估基準概況

如何評估

常用的評估方法分為兩大類:自動評估和人類評估。顧名思義,這里就不多介紹了。

總結(jié)

任務(wù):LLM 的成功和失敗案例

現(xiàn)在總結(jié)一下 LLM 在不同任務(wù)中的成功和失敗案例。注意,以下結(jié)論都是基于現(xiàn)有評估工作得出的,結(jié)果可能取決于具體的數(shù)據(jù)集。

LLM 擅長做什么?

- LLM 熟練掌握了文本生成,能生成流暢和精確的語言表達。

- LLM 能出色地應(yīng)對涉及語言理解的任務(wù),比如情感分析和文本分類。

- LLM 展現(xiàn)出了穩(wěn)健的上下文理解能力,讓它們能生成與給定輸入相符的連貫響應(yīng)。

- LLM 在多種自然語言處理任務(wù)上的表現(xiàn)都值得稱贊,包括機器翻譯、文本生成和問答。

LLM 不擅長做什么?

- LLM 可能會在生成過程中展現(xiàn)出偏見和不準確的問題,從而得到帶偏見的輸出。

- LLM 在理解復(fù)雜邏輯和推理任務(wù)方面的能力有限,經(jīng)常在復(fù)雜的上下文中發(fā)生混淆或犯錯。

- LLM 處理大范圍數(shù)據(jù)集和長時記憶的能力有限,這可能使其難以應(yīng)對很長的文本和涉及長期依賴的任務(wù)。

- LLM 整合實時和動態(tài)信息的能力有限,這讓它們不太適合用于需要最新知識或快速適應(yīng)變化環(huán)境的任務(wù)。

- LLM 對 prompt 很敏感,尤其是對抗性 prompt,這會激勵研究者開發(fā)新的評估方法和算法,以提升 LLM 的穩(wěn)健性。

- 在文本摘要領(lǐng)域,人們觀察到大型模型可能在特定評估指標上表現(xiàn)不佳,原因可能在于這些特定指標的固有局限性和不足之處。

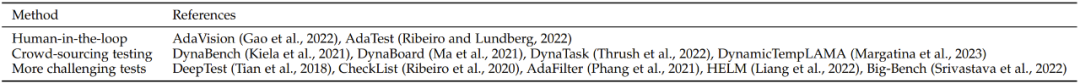

基準和評估協(xié)議

隨著 LLM 的快速發(fā)展和廣泛使用,在實際應(yīng)用和研究中評估它們的重要性變得至關(guān)重要。這個評估過程不僅應(yīng)該包括任務(wù)層面的評估,還應(yīng)該包括它們在社會方面的潛在風險。表 8 總結(jié)了現(xiàn)有的基準和評估協(xié)議。

表 8:新型 LLM 評估協(xié)議概況

巨大挑戰(zhàn)

最后來看看 LLM 評估研究方面面臨的挑戰(zhàn)。作者認為,為了推動 LLM 和其它 AI 模型的成功發(fā)展,應(yīng)當將評估當作一門關(guān)鍵性學(xué)科來對待。現(xiàn)有的協(xié)議不足以透徹地評估 LLM,還有許多挑戰(zhàn)有待攻克,下面將簡單羅列出這些挑戰(zhàn),但它們也是 LLM 評估方面的未來研究的新機會。

- 設(shè)計 AGI 評估基準

- 對完整行為進行評估

- 穩(wěn)健性評估

- 動態(tài)和演化評估

- 有原則且值得信任的評估

- 支持所有 LLM 任務(wù)的統(tǒng)一評估

- 超越評估:LLM 強化