數倉 Hive HA 介紹與實戰操作

一、概述

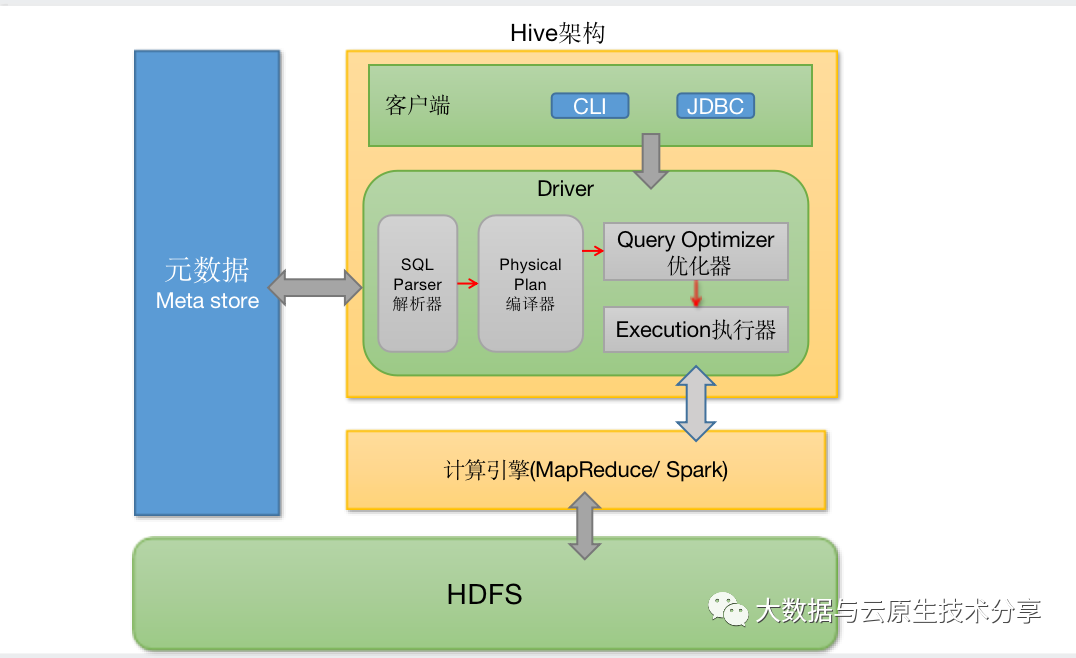

在數據倉庫中,Hive HA(High Availability) 是指為 Apache Hive 這個數據倉庫查詢和分析工具提供高可用性的架構和解決方案。Hive是建立在Hadoop生態系統之上的一種數據倉庫解決方案,用于處理大規模數據的查詢和分析。為了確保Hive服務的連續性和可用性,特別是在出現硬件故障、軟件問題或其他中斷情況時,實施Hive的高可用性解決方案非常重要。

Hive HA通常涉及以下幾個方面:

- 元數據存儲的高可用性 : 元數據存儲在Hive Metastore中,其中包括表的結構、分區信息、表的位置等。為了確保元數據的高可用性,可以使用數據庫復制、備份和恢復策略。常見的數據庫選擇包括MySQL、PostgreSQL等。

- 查詢引擎的高可用性: Hive的查詢引擎可以采用多種方式實現高可用性,例如使用Hadoop的YARN資源管理器來管理查詢作業,或者通過部署多個Hive Server來實現負載均衡和故障轉移。

- 數據存儲的冗余備份: 在Hadoop HDFS中存儲的數據可以通過數據冗余備份來確保數據的可靠性和高可用性。HDFS通常使用副本機制來保存多個數據副本,以防止單個節點故障導致數據丟失。

- 自動故障切換: Hive HA解決方案應該能夠自動檢測到故障,并在需要時進行故障切換。這意味著當一個節點或服務出現問題時,系統能夠迅速將請求路由到可用的節點或服務上,從而減少中斷時間。

- 監控和告警系統: 為了實現高可用性,監控和告警系統對于及時發現和處理故障非常重要。這些系統可以監視Hive服務的運行狀態,及時發出警報并采取必要的措施來應對潛在的問題。

總的來說,Hive HA旨在通過冗余、備份、自動故障切換和監控系統等方式,確保在各種情況下都能夠保持Hive服務的正常運行,從而提供持續的數據查詢和分析能力。具體的實施方式可能因組織的需求和技術棧而異。

圖片

圖片

二、Hive MetaStore HA 介紹與配置

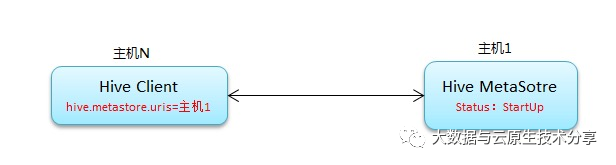

Hive MetaStore HA(High Availability)是為了保證Hive元數據存儲的高可用性而采取的一系列措施和配置。Hive元數據存儲在MetaStore中,包括表的定義、分區、表的屬性等信息。確保Hive MetaStore的高可用性是保障整個Hive系統可靠性和穩定性的重要一步。

常規連接原理:

圖片

圖片

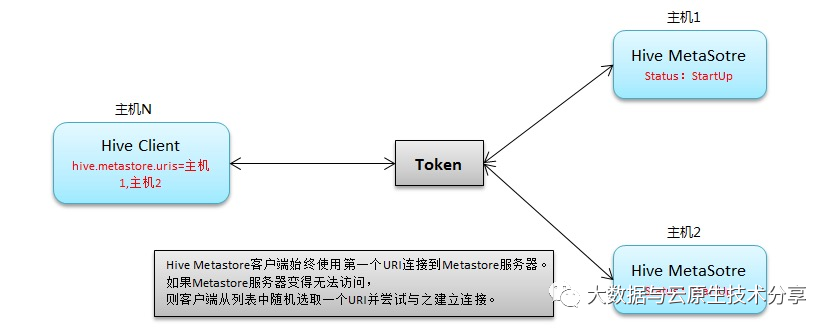

高可用原理:

圖片

圖片

以下是一個示例,將 ZooKeeper 地址配置到 hive.metastore.uris 中:

<configuration>

<property>

<name>hive.server2.thrift.bind.host</name>

<value>metastore1_host</value>

</property>

<!-- 啟用 ZooKeeper 用于 HA -->

<property>

<name>hive.metastore.uris</name>

<value>

thrift://metastore1_host:9083,

thrift://metastore2_host:9083

</value>

</property>

<!-- 其他配置項 -->

</configuration>在這個示例中,你需要將 metastore1_host、metastore2_host、metastore3_host 替換為你的 Hive MetaStore 實例的主機地址。使用逗號分隔來指定多個地址。這樣,當連接到一個實例時出現問題,Hive 將嘗試連接到下一個地址,以實現故障切換和冗余。

三、Hive HiveServer2 HA 介紹與配置

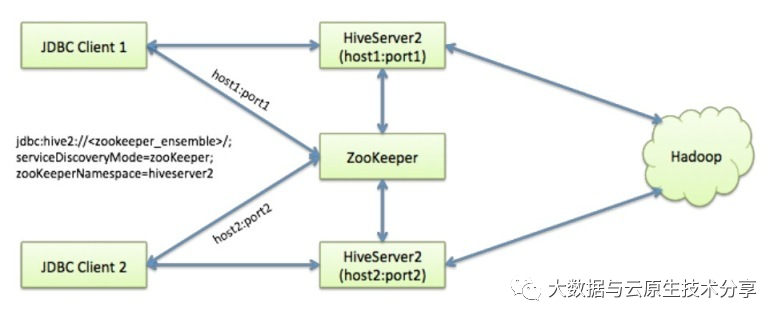

HiveServer2 HA(High Availability)是為了確保Apache Hive的查詢服務HiveServer2的高可用性而采取的一系列措施和配置。HiveServer2是Hive的一個查詢引擎,允許用戶通過多種方式(如JDBC、ODBC等)提交和執行Hive查詢。通過配置HiveServer2的高可用性,可以確保在出現硬件故障、軟件問題或其他中斷情況時仍然能夠提供持續的查詢服務。

圖片

圖片

以下是一個示例HiveServer2的高可用性配置,使用Apache ZooKeeper來實現故障切換。請注意,這只是一個簡化的示例,實際配置可能會因環境和需求而有所不同。

- 安裝和配置ZooKeeper:確保你已經安裝和配置了一個ZooKeeper集群。你需要知道ZooKeeper服務器的主機名或IP地址以及端口號。

- 編輯Hive Site配置:打開Hive的配置文件 hive-site.xml,添加以下屬性來配置HiveServer2的高可用性和與ZooKeeper的集成:

<configuration>

<!-- 啟用ZooKeeper用于HA -->

<property>

<name>hive.server2.zookeeper.namespace</name>

<value>hiveserver2</value>

</property>

<property>

<name>hive.zookeeper.client.port</name>

<value>2181</value>

</property>

<property>

<name>hive.zookeeper.quorum</name>

<value>zk1_host:2181,zk2_host:2181,zk3_host:2181</value>

</property>

<property>

<name>hive.server2.support.dynamic.service.discovery</name>

<value>true</value>

</property>

<!-- 其他配置項 -->

</configuration>將zk1_host、zk2_host、zk3_host替換為你的ZooKeeper主機地址和端口號。

四、環境部署

這里為了快速部署環境,就使用k8s 環境部署Hadoop了。關于 hadoop on k8s 教程,可以參考我這篇文章:Hadoop HA on k8s 編排部署進階篇

hive-site.xml 完整配置如下:

<?xml versinotallow="1.0"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<!-- 配置hdfs存儲目錄 -->

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive_remote/warehouse</value>

</property>

<property>

<name>hive.metastore.local</name>

<value>false</value>

</property>

<!-- 所連接的 MySQL 數據庫的地址,hive_local是數據庫,程序會自動創建,自定義就行 -->

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://192.168.182.110:13306/hive_metastore?createDatabaseIfNotExist=true&useSSL=false&serverTimeznotallow=Asia/Shanghai</value>

</property>

<!-- MySQL 驅動 -->

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<!--<value>com.mysql.cj.jdbc.Driver</value>-->

<value>com.mysql.jdbc.Driver</value>

</property>

<!-- mysql連接用戶 -->

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<!-- mysql連接密碼 -->

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>123456</value>

</property>

<!--元數據是否校驗-->

<property>

<name>hive.metastore.schema.verification</name>

<value>false</value>

</property>

<property>

<name>system:user.name</name>

<value>root</value>

<description>user name</description>

</property>

<property>

<name>hive.metastore.uris</name>

<value>thrift://{{ include "hadoop.fullname" . }}-hive-metastore-0.{{ include "hadoop.fullname" . }}-hive-metastore:{{ .Values.service.hive.metastore.port }},{{ include "hadoop.fullname" . }}-hive-metastore-1.{{ include "hadoop.fullname" . }}-hive-metastore:{{ .Values.service.hive.metastore.port }}</value>

</property>

<!-- host -->

<property>

<name>hive.server2.thrift.bind.host</name>

<value>0.0.0.0</value>

<description>Bind host on which to run the HiveServer2 Thrift service.</description>

</property>

<!-- hs2端口 默認是10000-->

<property>

<name>hive.server2.thrift.port</name>

<value>{{ .Values.service.hive.hiveserver2.port }}</value>

</property>

<!-- 啟用ZooKeeper用于HA -->

<!--設置hiveserver2的命名空間-->

<property>

<name>hive.server2.zookeeper.namespace</name>

<value>hiveserver2</value>

</property>

<!--指定zk的端口,這個其實是否可以去掉,因為hive.server2.zookeeper.quorum 配置里有配置端口的-->

<property>

<name>hive.zookeeper.client.port</name>

<value>2181</value>

</property>

<!--設置zk集群的客戶端地址-->

<property>

<name>hive.zookeeper.quorum</name>

<value>{{ include "hadoop.fullname" . }}-zookeeper-0.{{ include "hadoop.fullname" . }}-zookeeper.{{ .Release.Namespace }}.svc.cluster.local:2181,{{ include "hadoop.fullname" . }}-zookeeper-1.{{ include "hadoop.fullname" . }}-zookeeper.{{ .Release.Namespace }}.svc.cluster.local:2181,{{ include "hadoop.fullname" . }}-zookeeper-2.{{ include "hadoop.fullname" . }}-zookeeper.{{ .Release.Namespace }}.svc.cluster.local:2181</value>

</property>

<!-- 用于啟用或禁用 HiveServer2 動態服務發現功能。-->

<property>

<name>hive.server2.support.dynamic.service.discovery</name>

<value>true</value>

</property>

</configuration>【溫馨提示】如果不是使用 hadoop on k8s 方式部署,記得修改 javax.jdo.option.ConnectionURL、hive.metastore.uris、hive.server2.zookeeper.quorum 這幾個配置的值。

開始部署

cd hadoop-ha-on-kubernetes

#mkdir -p /opt/bigdata/servers/hadoop/{nn,jn,dn,zk}/data/data{1..3}

#chmod 777 -R /opt/bigdata/servers/hadoop/

# 安裝

helm install hadoop-ha ./ -n hadoop-ha --create-namespace

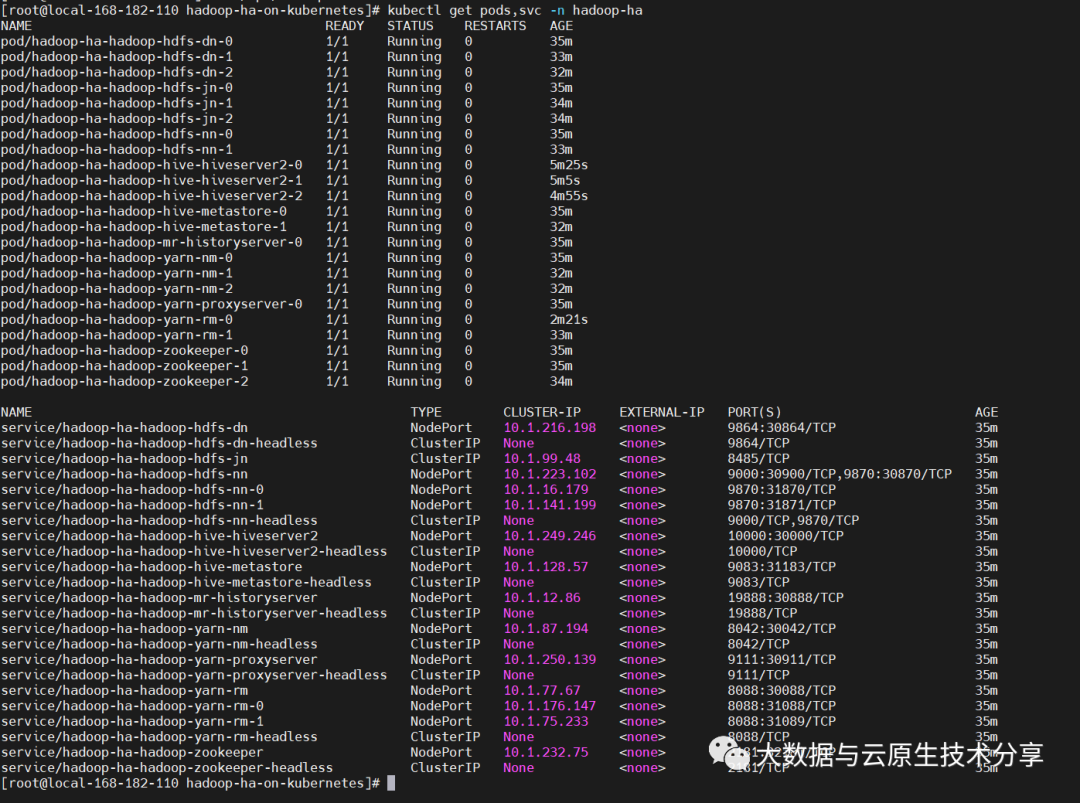

# 查看

kubectl get pods,svc -n hadoop-ha -owide

# 更新

# helm upgrade hadoop-ha ./ -n hadoop-ha

# 卸載

# helm uninstall hadoop-ha -n hadoop-ha

#rm -fr /opt/bigdata/servers/hadoop/* 圖片

圖片

五、測試驗證

1)hive metastore 測試驗證

hive_pod_name=`kubectl get pods -n hadoop-ha|grep 'hiveserver2'|head -1 |awk '{print $1}'`

# 登錄pod

kubectl exec -it $hive_pod_name -n hadoop-ha -- bash

# 啟動命令,

hive

create database test2023;

create table test2023.person_local_1(id int,name string,age int) row format delimited fields terminated by ',';

# 查看表結構

show create table test2023.person_local_1;

drop table test2023.person_local_1;

drop database test2023;

# 指定具體metastore,不指定就是查詢可用的metastore服務

# 交互式

SET hive.metastore.uris=thrift://hadoop-ha-hadoop-hive-metastore-0.hadoop-ha-hadoop-hive-metastore:9083;

# 非交互式

hive --hiveconf hive.metastore.uris=thrift://hadoop-ha-hadoop-hive-metastore-0.hadoop-ha-hadoop-hive-metastore:9083 -e "show databases;"2)hive hiveserver2 測試驗證

hive_pod_name=`kubectl get pods -n hadoop-ha|grep 'hiveserver2'|head -1 |awk '{print $1}'`

# 登錄pod

kubectl exec -it $hive_pod_name -n hadoop-ha -- bash

# 非交互式,這里我使用svc訪問,當然你也可以展開,寫具體的pod或IP

beeline -u "jdbc:hive2://hadoop-ha-hadoop-zookeeper.hadoop-ha:2181/;serviceDiscoveryMode=zookeeper;zookeeperNamespace=hiveserver2/default" -n hadoop -e "select version();"

# 交互式操作

beeline -u "jdbc:hive2://hadoop-ha-hadoop-zookeeper.hadoop-ha:2181/;serviceDiscoveryMode=zookeeper;zookeeperNamespace=hiveserver2/default" -n hadoop

--- 1、創建表

create table person_local_1(id int,name string,age int) row format delimited fields terminated by ',';

create table person_hdfs_1(id int,name string,age int) row format delimited fields terminated by ',';

show tables;

--- 2、 從local加載數據,這里的local是指hs2服務所在機器的本地linux文件系統

load data local inpath '/opt/bigdata/hadoop/data/hive-data' into table person_local_1;

--- 3、查詢

select * from person_local_1;

--- 4、從hdfs中加載數據,這里是移動,會把hdfs上的文件mv到對應的hive的目錄下

load data inpath '/person_hdfs.txt' into table person_hdfs_1;

--- 5、查詢

select * from person_hdfs_1;