擊敗整個羊駝家族,Meta AI自對齊新方法只需極少人工標注數據

本文經AI新媒體量子位(公眾號ID:QbitAI)授權轉載,轉載請聯系出處。

人工標注數據告急?

Mata新方法僅用少量種子數據,就構建了一個高質量的指令遵循( instruction following)語言模型。

換言之,大語言模型需要大量人工標注的指令數據進行微調,而現在模型可自動從網絡語料庫未標記的文本中推理出指令。

然后用自己生成的指令數據進行訓練,堪比自產自銷。

并且用這種方法訓練出的模型在Alpaca基準測試上,超越開源羊駝及其一系列衍生模型。

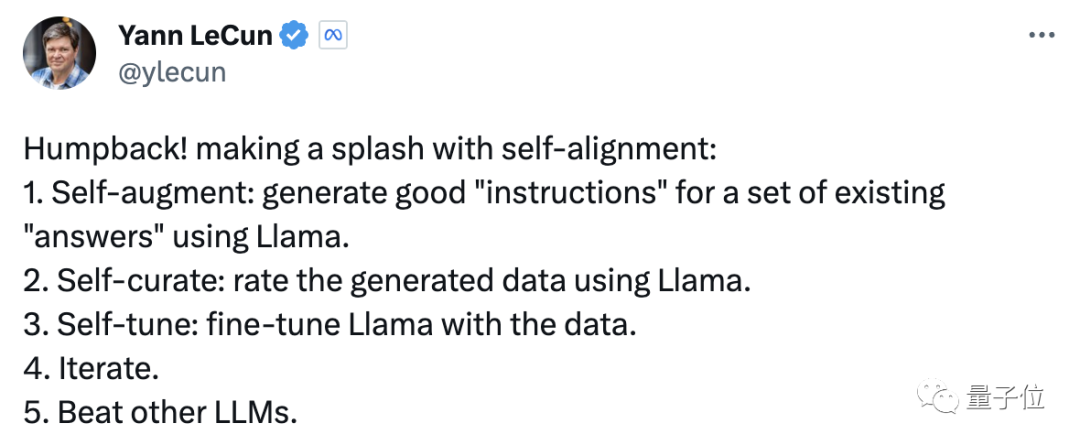

LeCun發推認為該研究在模型自對齊方面具有轟動性:

用網友的一句話總結:

羊駝開始自我訓練了。

兩句話總結是這樣嬸兒的:

原本需要指令>響應數據集(需要人工標注),現在只需要簡單訓練一個“反向模型”做響應>指令。任何文本可隨意轉換為指令數據集。

還有網友發出靈魂拷問:

是只有我一個人,覺得這看起來像是通往超級智能的道路?如果你不需要額外的高質量外部數據,就能獲得越來越智能的LLM,那么這就是一個自我改進的封閉系統。

也許只需要一種強化學習系統來提供信號,然后LLM自身的迭代就可以完成其余的工作。

羊駝:我自己搞數據訓練了一頭鯨

這種可擴展的新方法叫做指令回譯,Mata為用這種方法訓練出的模型起了個名字——Humpback(座頭鯨,又稱駝背鯨)。

(研究人員表示,之所以起這么個名字,是因為它和駱駝背的關系,而且鯨魚體型更大,對應模型規模更大)

訓練一個Humpback的步驟簡單來說就是,從少量標注數據開始,使用語言模型生成未標注文本所對應的指令,形成候選訓練數據。再用模型評估數據質量,選擇高質量數據進行再訓練。然后重復該過程,進一步改進模型。

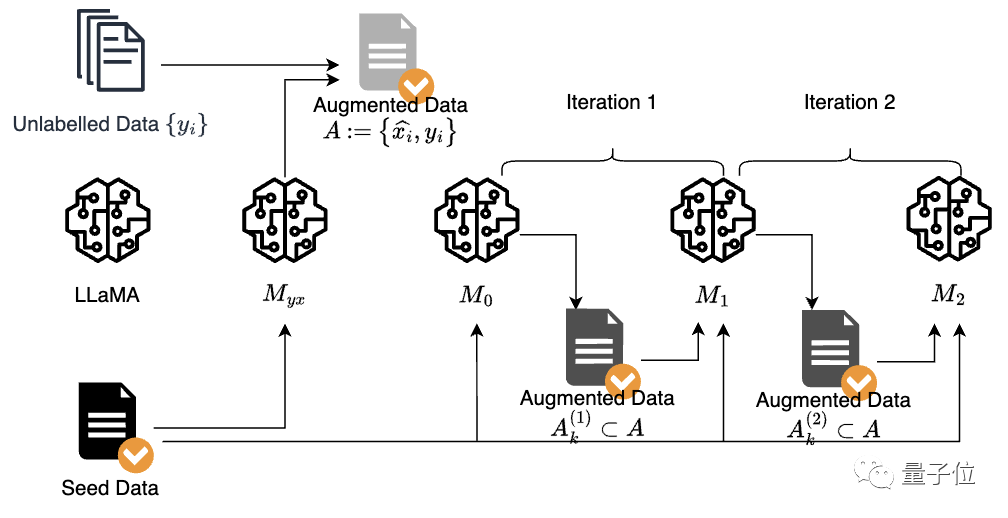

如上圖所示,需要準備的“材料”有:

- 一個基礎模型——LLaMa

- 一個由Open Assistant數據集中的3200個示例構成的種子數據(Seed Data),每個示例包括一個指令和對應的輸出。

- 從ClueWeb語料中抽取了502K段已去重、過濾、刪除了潛在低質量段落的未標注文本(Unlabeled Data)。

標注示例和語料來源都有了,下一步就是自增強(Self-augment)階段。

研究人員用種子數據對基礎模型LLaMa進行了微調,獲得指令預測模型。然后用這個指令預測模型,為未標注文本推理出一個候選指令。之后組合候選指令與文本(指令-輸出對),作為候選增強訓練數據,也就是上圖中的Augmented Data A。

但還不能用A的數據直接訓練,因為未標注文本本身質量參差不齊,生成的候選指令也存在噪聲。

所以需要關鍵的自管理(Self-curate)步驟,使用模型預測數據質量,選擇高質量樣本進行訓練。

具體來說,研究人員使用僅在種子數據上微調的指令模型對候選數據打分。滿分五分,分數較高的才會被挑選出來作為下一輪的候選數據。

為了提高模型指令預測質量,研究人員用候選數據迭代訓練了模型,在迭代訓練中,數據質量也會越來越好。

此外,在組合種子數據和增強數據微調模型時,他們還使用不同的系統提示標記區分了這兩個數據源:

- 種子數據使用提示“Answer in the style of an AI Assistant.”

- 篩選數據使用提示“Answer with knowledge from web search.”

進行兩輪迭代后,最終模型就新鮮出爐啦。

合并兩種訓練數據:1+1>2

下面再來看看研究人員的分析結果:

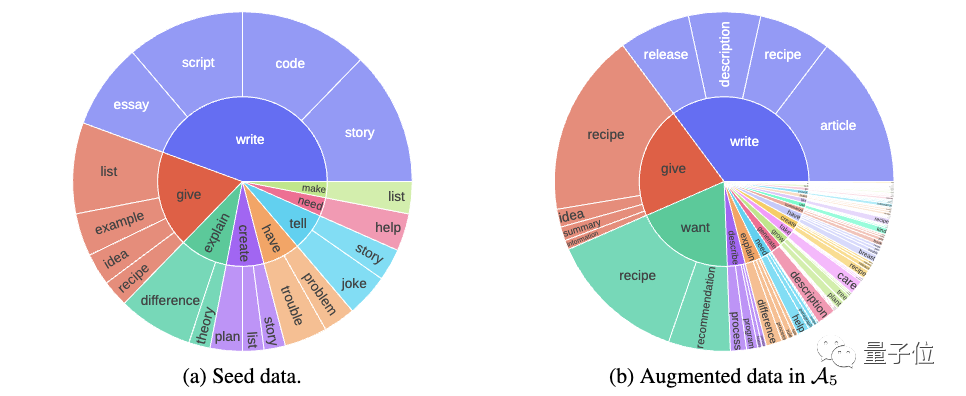

△種子數據和增強數據的指令多樣性。內圈是常見的根動詞,外圈是與其對應的常見名詞。

上圖是用8%種子數據和13%的增強數據統計的指令多樣性。

可以很直觀地看到,在長尾部分增強數據多樣性更強,且增強數據與現有的人工標注種子數據相輔相成,補充了種子數據中未出現的類型。

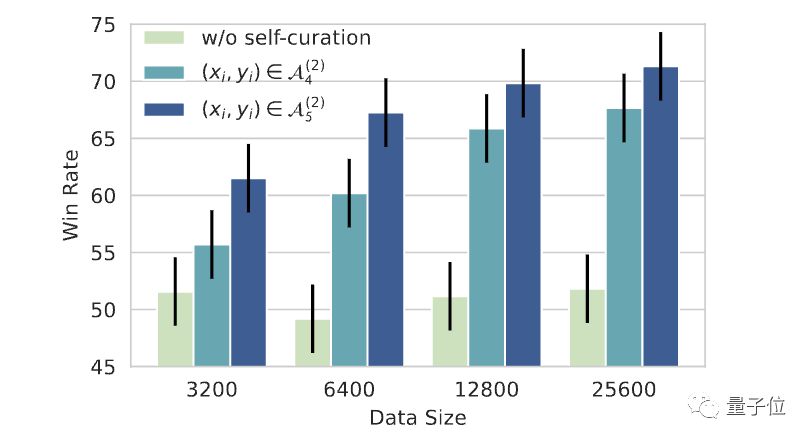

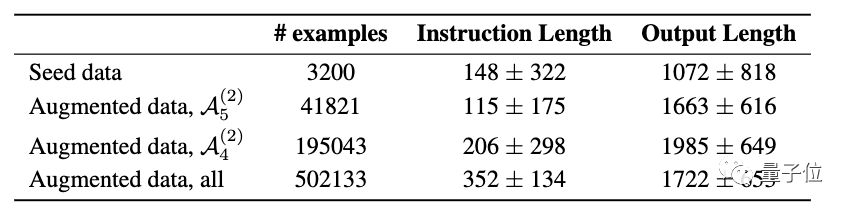

其次,研究人員比較了三個增強數據集:Augmented data,all(無自管理)、 、數據更少但質量更高的

、數據更少但質量更高的

實驗觀察到,盡管數據集變小,但伴隨著訓練數據質量的提升模型性能也有了很好的提升。

△使用自篩選評估不同數據大小和質量的自增強數據。y軸表示在使用給定數據大小和質量微調LLaMa 7B時與text-davinci-003的勝率。

(text-davinci-003,一種基于GPT-3的指令遵循模型,使用強化學習在人類編寫的指令數據、輸出、模型響應和人類偏好上進行了微調)

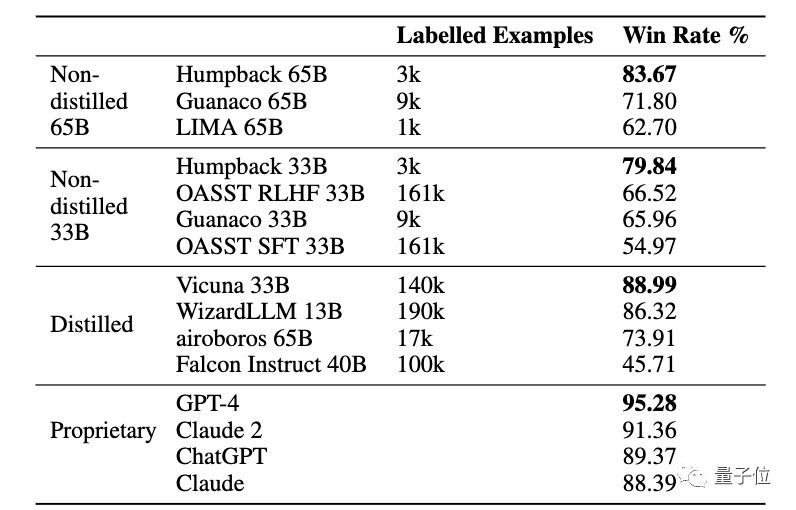

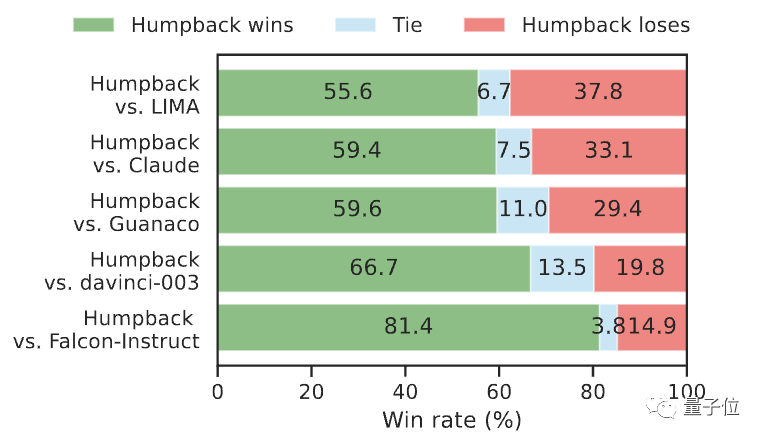

最后來看一下Alpaca排行榜上的結果。Humpback在不依賴蒸餾數據的情況下,表現明顯優于其它方法,并且縮小了與專有模型之間的差距。

非蒸餾(Non-distilled),指不依賴于任何外部模型作為任何形式監督的訓練模型;蒸餾(Distilled),指在訓練過程中引入更強大的外部模型,例如使用從外部模型蒸餾的數據;專有(Proprietary),指使用專有數據和技術進行訓練的模型。

△相對于text-davinci-003的勝率

在與開源模型LIMA 65B、Guanaco 65B、Falcon-Instruct 40B和專有模型davinci-003、Claude的比較中,Humpback的表現也都更符合人類偏好。

此外,研究人員還指出了該方法的局限性:

由于用于訓練的文本數據來自網絡語料庫,微調后的模型可能會放大網絡數據的偏差。雖然和基礎模型相比,微調后的模型提高了檢測偏差的準確性。然而,這并不意味著會完全解決這個問題。

傳送門:https://arxiv.org/abs/2308.06259(論文鏈接)