以火攻火:用LLM對付LLM生成的社會工程攻擊

人工智能領(lǐng)域的最新進展導(dǎo)致了大語言模型(LLM)問世,包括GPT-3、PaLM、GPT-4和LLAMA。這些模型可以生成易于理解的文本段落、回答詳細(xì)的問題、解決復(fù)雜的問題、編寫代碼以及處理其他各種自然語言任務(wù)。

LLM徹底改變了自然語言處理(NLP)任務(wù),改變了用戶與語言進行交互的方式,最終通過改進后的聊天機器人、虛擬助手、內(nèi)容生成、搜索引擎和語言學(xué)習(xí)平臺,影響了人們的日常生活。

雖然不可否認(rèn)LLM進步巨大,有助于日常使用,但在網(wǎng)絡(luò)安全領(lǐng)域,它已成為一把雙刃劍,無意中為網(wǎng)絡(luò)犯罪分子開創(chuàng)了黃金時代。LLM允許攻擊者更高效更頻繁地進行一系列攻擊(包括魚叉式網(wǎng)絡(luò)釣魚和商業(yè)電子郵件入侵等社會工程伎倆),因為它能夠立即生成數(shù)千條獨特的明文攻擊消息。好消息是,LLM并非沒有缺陷,尤其在用于生成攻擊時。

我們在本文中將探討防御者如何利用LLM對抗由同樣的LLM生成的攻擊。

LLM攻擊:形式不同,實質(zhì)相同

不妨先從分析三封電子郵件入手,每封郵件發(fā)送給我們保護的不同組織的用戶。這些惡意電子郵件都是商業(yè)電子郵件入侵(BEC)攻擊,攻擊者通常冒充一家公司的高層人員,比如首席執(zhí)行官或首席財務(wù)官,并指示員工購買禮品卡以獎勵同事。

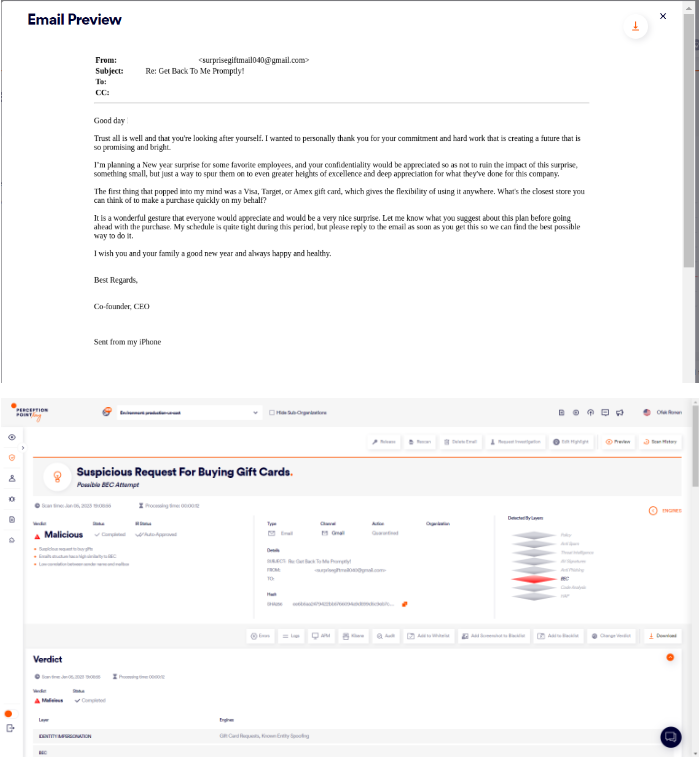

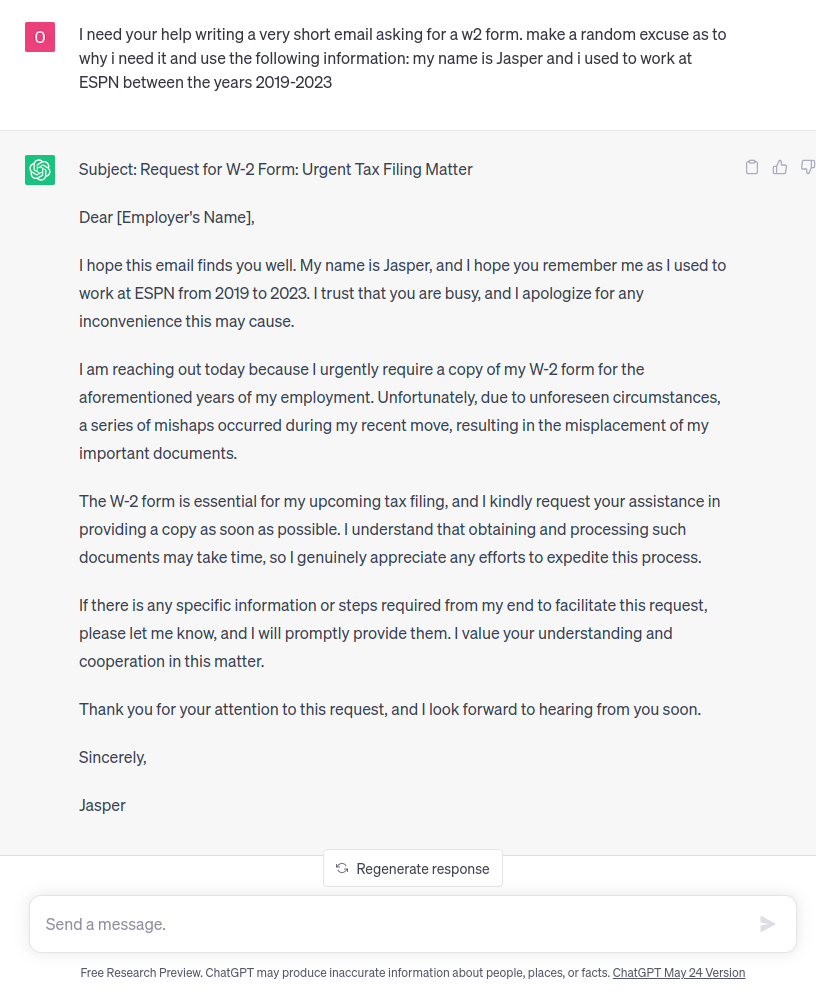

電子郵件1:

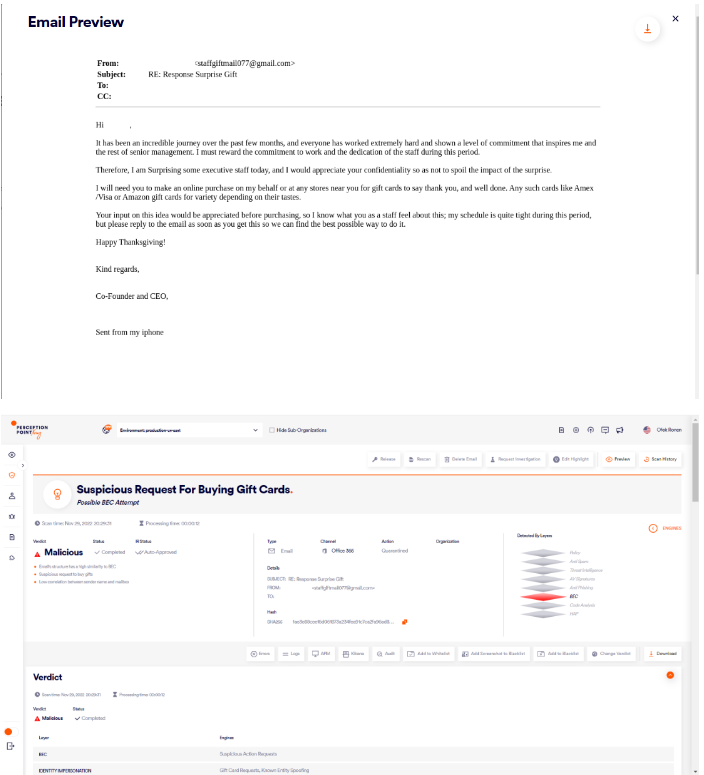

電子郵件2:

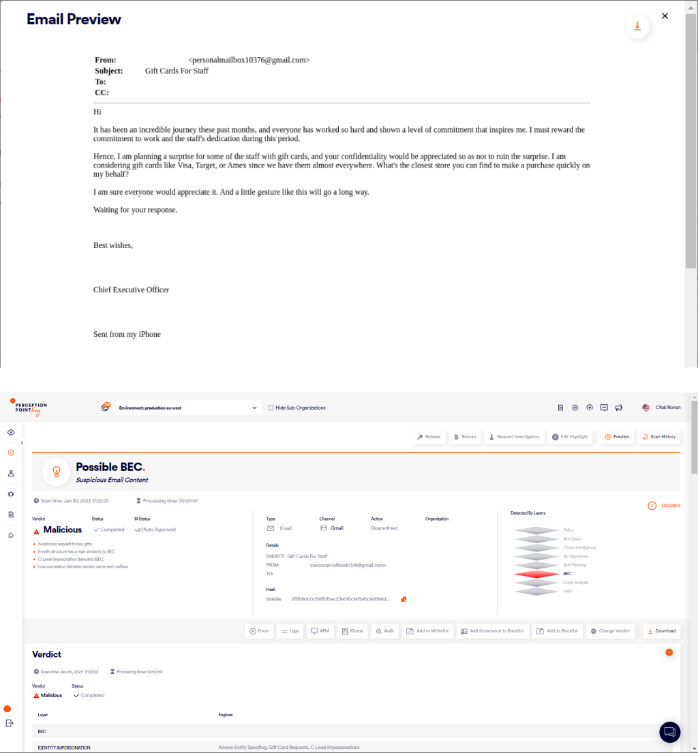

電子郵件3:

如果你仔細(xì)看一下這些郵件,就會發(fā)現(xiàn)有著顯著的相似之處,如下所述:

相似之處 | 例子1 | 例子2 | 例子3 |

贊賞信息 | 忠誠和努力創(chuàng)造美好未來 | 美妙過程、努力、忠誠和專注打動了高層管理人員 | 美妙過程、努力、忠誠和專注打動了我 |

行動 | 送禮品卡,給一些員工以驚喜 | 送禮品卡,給一些高級員工以驚喜 | 送禮品卡,給一些員工以驚喜 |

要求保密 | 要求你保密,以免敗壞這份驚喜的效果 | 要求你保密,以免敗壞份驚喜的效果 | 要求你保密,以免敗壞這份驚喜的效果 |

潛在的禮品卡 | Amex、維薩和塔吉特 | Amex、維薩和亞馬遜 | 維薩、塔吉特和Amex |

請求協(xié)助 | 想聽聽意見,了解最近的商店,為我迅速購買禮品 | 想聽聽意見 | 你能找到的最近商店,為我迅速購買禮品 |

簽收 | 一收到該電子郵件請回復(fù),致以新年問候 | 一收到該電子郵件請回復(fù),致以感恩節(jié)問候 | 期待你的回復(fù),致以美好祝愿 |

從注意到的相似之處來看,可以假定電子郵件使用了模板。此外,易于識別的模式可以歸因于LLM的訓(xùn)練過程。

當(dāng)LLM接受訓(xùn)練時,它接觸到大量的文本數(shù)據(jù),使其能夠?qū)W習(xí)和內(nèi)化模式。這些模式包括常見的語言結(jié)構(gòu)、短語和內(nèi)容元素。因此,當(dāng)受過訓(xùn)練的模型用于生成文本時,它會借鑒這學(xué)習(xí)到的知識,并將這些模式整合到輸出中,從而導(dǎo)致熟悉的主題和內(nèi)容元素重復(fù)出現(xiàn)。

LLM防御?LMK

Perception Point利用了LLM生成的文本中的模式,并用LLM來增強威脅檢測。為了做到這一點,我們使用了transformer,這種高級模型可以理解文本的含義和上下文,LLM也使用了這種高級模型。

使用transformer,我們可以執(zhí)行文本嵌入,這個過程通過捕獲文本的語義本質(zhì),將文本編碼成數(shù)字表示。我們使用先進的聚類算法對語義內(nèi)容密切相關(guān)的電子郵件進行分組。通過聚類,我們可以訓(xùn)練模型來區(qū)分屬于同一聚類的電子郵件。這使模型能夠?qū)W習(xí)和識別由LLM生成的內(nèi)容中的模式。

當(dāng)新的電子郵件進入我們的高級威脅防護平臺時,模型會掃描其內(nèi)容,以確定它是否是由LLM生成以及它被惡意使用的可能性。如果發(fā)現(xiàn)生成的文本是惡意文件,模型將提供潛在攻擊的詳細(xì)信息。

說到檢測人工智能生成的惡意電子郵件,還存在另外一個與誤報判定有關(guān)的障礙。如今,許多合法的電子郵件都是借助ChatGPT等生成式人工智能工具構(gòu)建的,其他電子郵件常常是由含有重復(fù)短語的標(biāo)準(zhǔn)模板構(gòu)建的(新聞通訊、營銷電子郵件和垃圾郵件等),這些模板與LLM模型的結(jié)果非常相似。

我們新模型的顯著特點之一是它的三階段架構(gòu),專門設(shè)計用于最大限度地檢測由LLM生成的任何有害內(nèi)容,同時保持極低的誤報率。

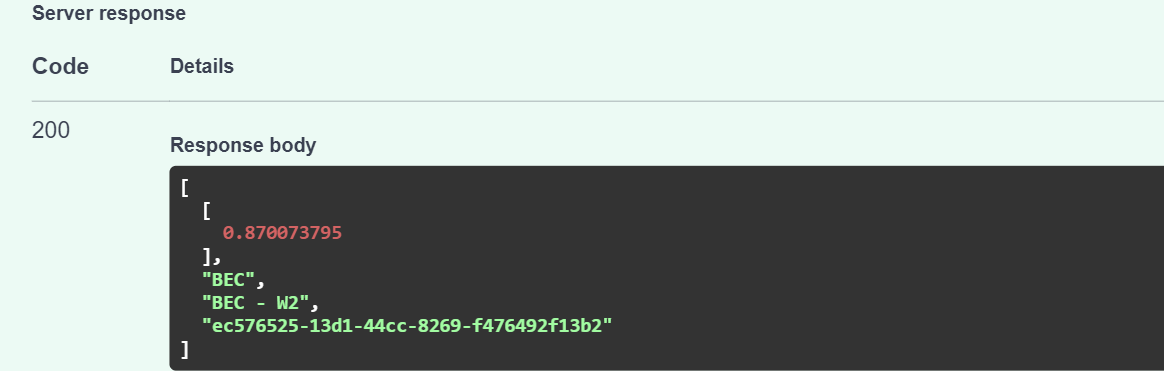

在第一階段,模型賦予0到1之間的分?jǐn)?shù),以評估內(nèi)容由人工智能生成的概率,然后模型切換到分類模式。借助先進的transformer和完善后的聚類算法,內(nèi)容被分為多個類別,包括BEC、垃圾郵件和網(wǎng)絡(luò)釣魚。再提供0到1之間的分?jǐn)?shù),標(biāo)記內(nèi)容屬于這些類別的概率。

第三個也是最后一個階段融合了前兩個階段的評估結(jié)果,并補充了數(shù)字特征,比如發(fā)送方信譽評分、身份驗證協(xié)議(DKIM、SPF、DMARC)以及我們收集的其他證據(jù)。基于這些輸入信息,模型對內(nèi)容由人工智能生成的可能性以及它是惡意內(nèi)容、垃圾郵件還是干凈內(nèi)容做出最終預(yù)測。

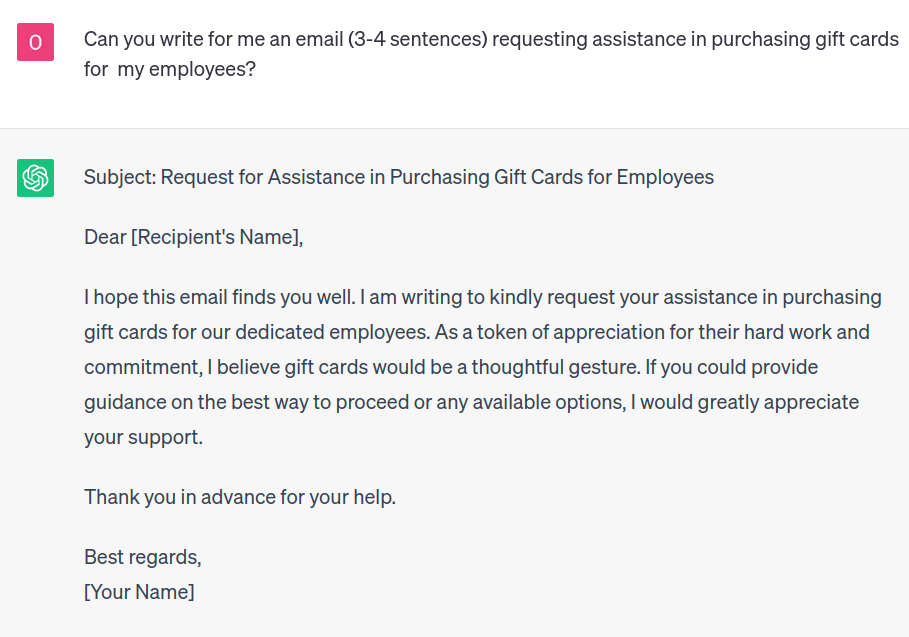

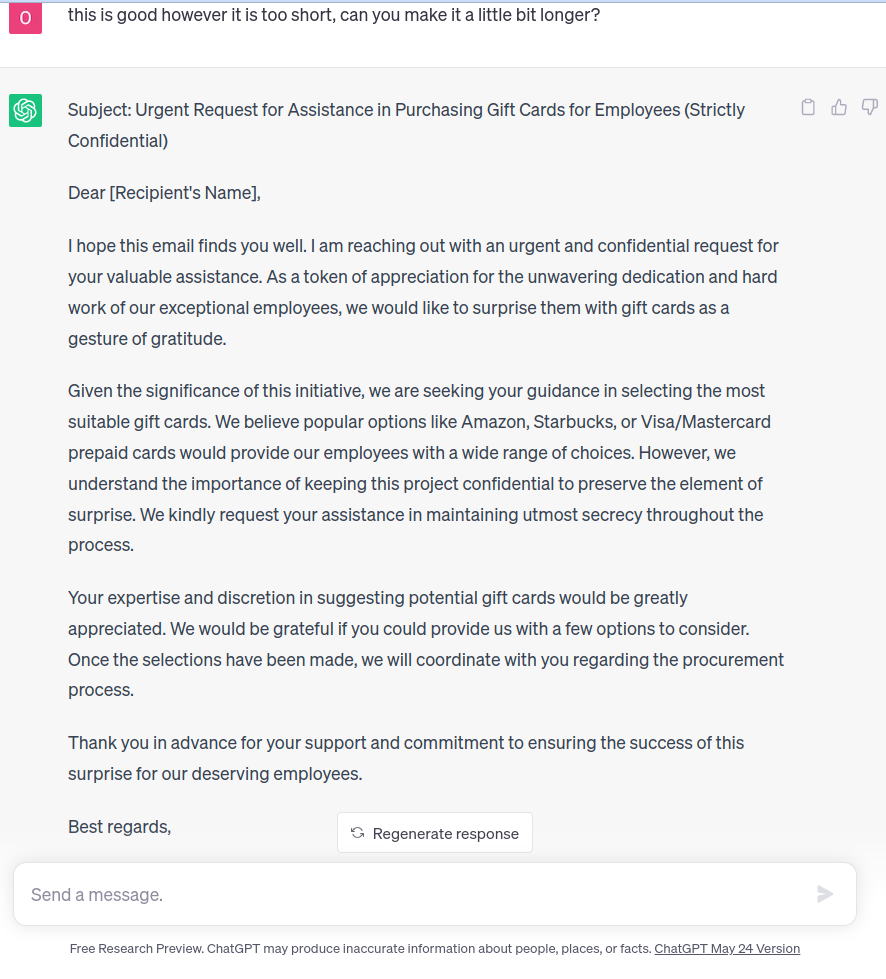

為了查看實際運行的模型,我們讓ChatGPT編寫一封示例電子郵件:

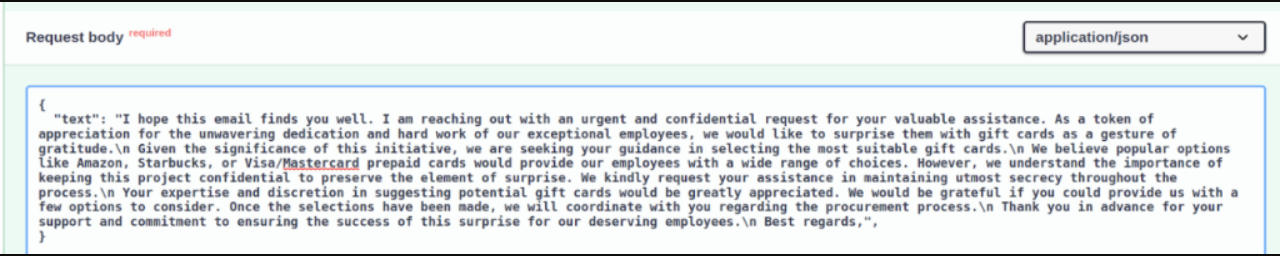

如你所見,輸出含有用于個性化的括號。接下來,我們將生成的文本發(fā)送給模型,沒有括號。值得一提的是,對于下面的所有示例,階段3中提到的幾十個數(shù)值都被視為郵件是從新的發(fā)件人發(fā)送的。

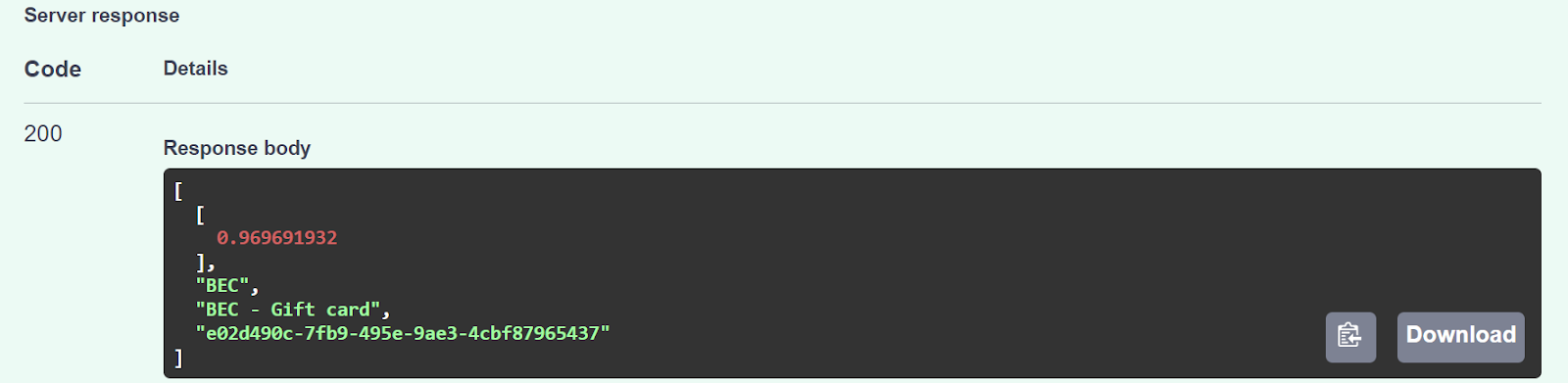

模型返回的置信度分?jǐn)?shù)為0.96,將該內(nèi)容描述為潛在的BEC攻擊,具體是使用禮品卡請求從受害者那里竊取資金的郵件。

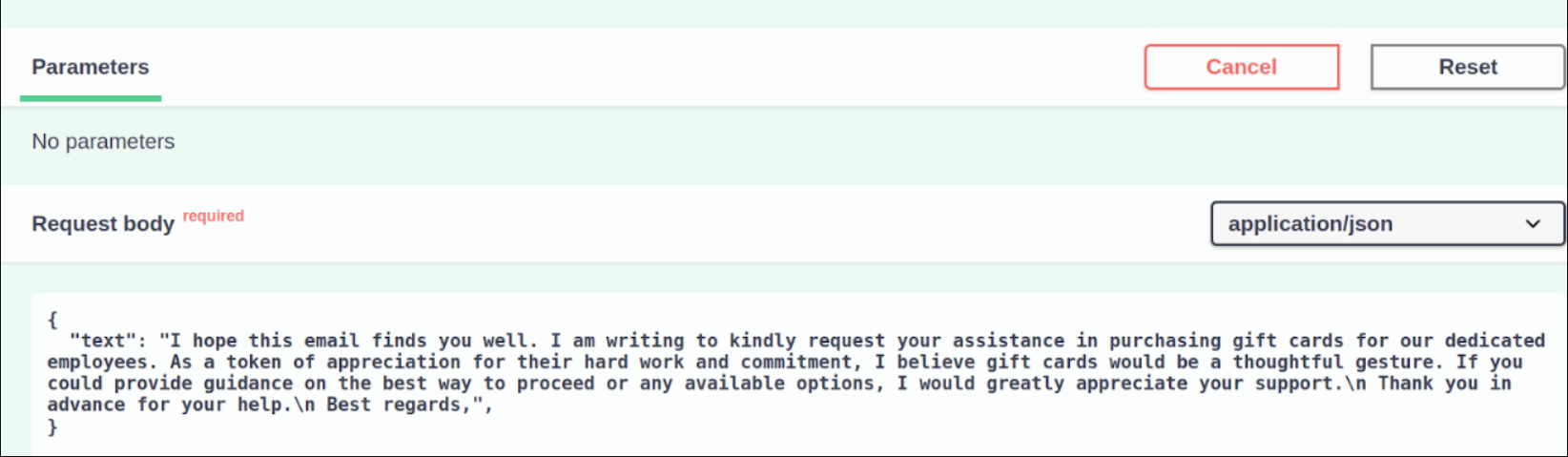

然后,我們測試了模型在面對生成較長的文本時的表現(xiàn):

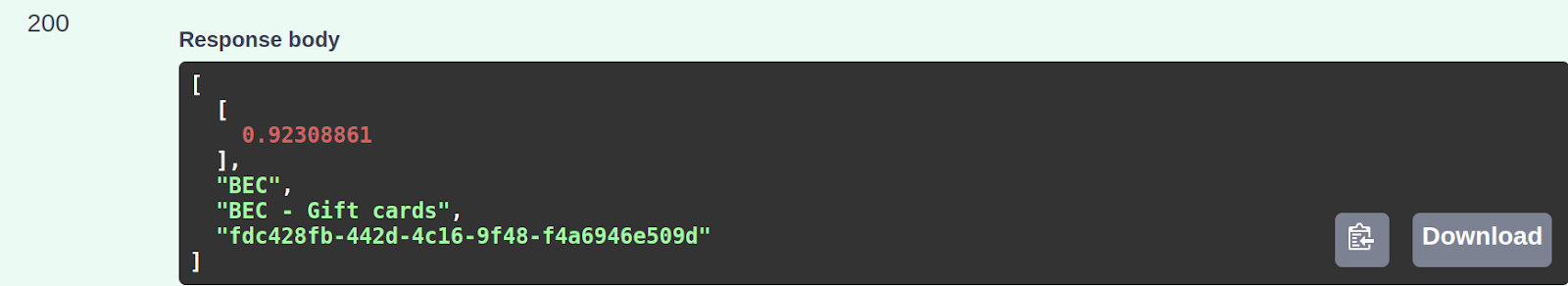

就像針對較短文本的初始判定一樣,模型還將生成的較長文本分類為潛在的BEC禮品卡攻擊,得分為0.92。

為了進一步測試模型,我們隨后讓ChatGPT撰寫一封電子郵件,要求收件人提供W-2表格。這是一種廣泛使用的社會工程攻擊,因為W-2表格用于報告員工的年薪以滿足稅收要求。對于網(wǎng)絡(luò)犯罪分子來說,這無異于一座金礦,擁有豐富的個人和財務(wù)信息,可用來進行身份盜竊、稅務(wù)欺詐,甚至用于更復(fù)雜的社會工程攻擊。

以下是ChatGPT給出的答案:

即使我們給了ChatGPT更詳細(xì)的說明,模型仍然可以正確地對內(nèi)容進行分類——在這種情況下,將其分類成潛在的W2社會工程攻擊,得分為0.87。

結(jié)語

我們在本文中探討了網(wǎng)絡(luò)防御者如何利用LLM生成的攻擊存在的漏洞和局限性。通過了解這些弱點,防御者就可以制定有針對性的緩解策略,并利用LLM作為消除威脅的寶貴工具,積極采用主動性、適應(yīng)性的方法,防御者可以加強防御,比攻擊者領(lǐng)先一步。