紐大具身智能新進展:靠視覺反饋學會開罐頭,任務成功率提高135%,LeCun點贊

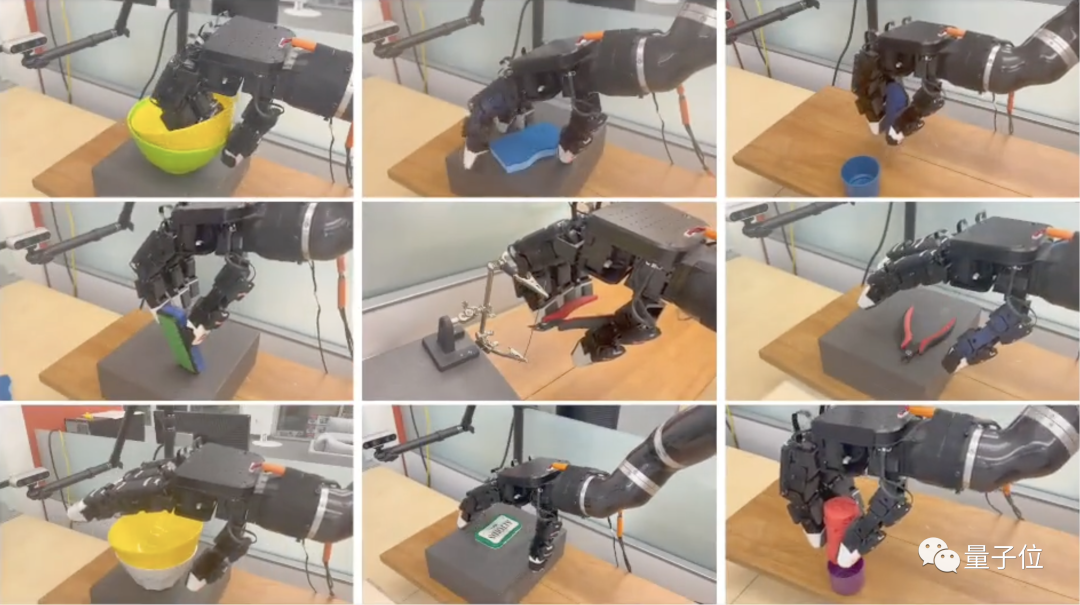

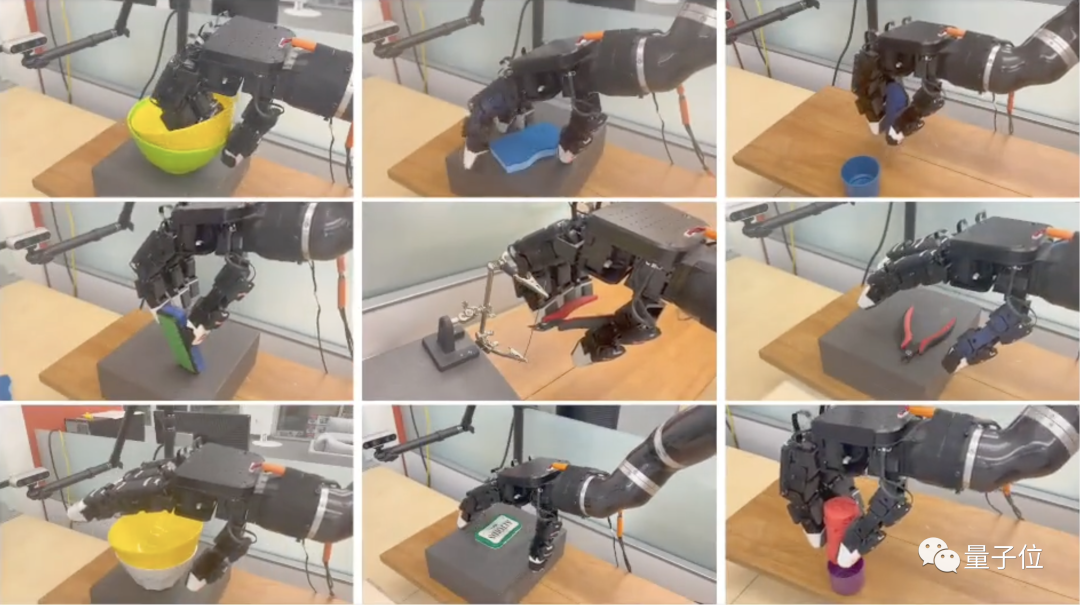

注意看,這個機器人用手中的鉗子輕松剪斷了一根金屬絲。

蓋上的鐵盒子,也三下五除二就打開了。

除此之外,物體抓取等任務更是能輕松完成。

這個機器人的背后,是紐約大學聯合Meta AI實驗室推出的最新具身智能成果。

研究人員提出了一種名為TAVI的新訓練方法,將視覺與觸覺相結合,把機器人執行任務的效果提高一倍以上。

目前,研究團隊的論文已經公開發表,相關代碼也已經開源。

看到這個機器人的表現,Meta首席科學家LeCun也不禁感嘆這是一項驚人的進展。

那么用這種方法訓練出的機器人,還能做些什么呢?

取物置物易如反掌

它可以把摞在一起的兩只碗分開,然后拿取上面的一個。

仔細觀察可以發現,在分開的過程當中,機器人的手部做出了攆的動作,讓黃色的碗沿著綠色碗的內壁滑動。

這個機器人不僅能“分”,還能“合”。

將紅色的物塊拿起之后,機器人將它精準地放入了紫色的蓋子當中。

或者,給橡皮翻個身。

只見它將一大塊橡皮拿起,然后利用下面的盒子調整角度。

雖然不知道為什么不多用幾根手指,但畢竟也是學會了借助工具。

總之,用TAVI方式訓練出的具身智能機器人,動作已經和人類有了幾分相似。

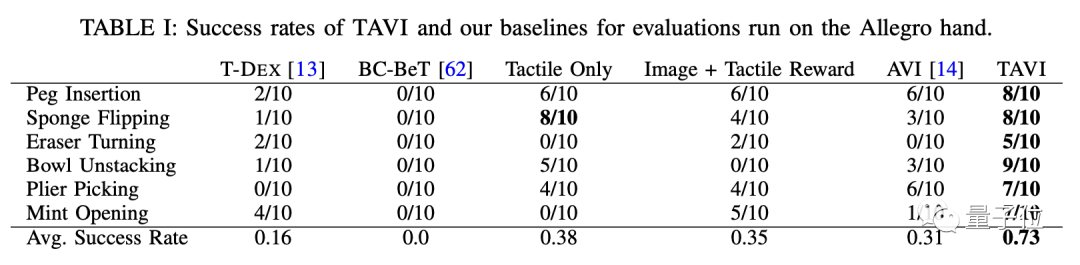

數據上,TAVI方式在6項典型任務中明顯優于只用觸覺或視覺反饋的方法。

和不使用觸覺信息的AVI方式相比,TAVI的平均成功率提高了135%,和圖像+觸覺獎勵模型的方式相比也翻了倍。

而同樣采用視覺觸覺混合模式的T-DEX訓練方式,成功率還不到TAVI的四分之一。

TAVI訓練的機器人還有很強的泛化能力——對于未曾見過的物體,機器人也可以完成任務。

在“拿碗”和“裝盒”兩項任務中,機器人面對未知物體的成功率均超過了半數。

此外,TAVI方法訓練出的機器人不僅能出色完成各項任務,還能按順序依次執行多項子任務。

魯棒性方面,研究團隊通過調整相機角度進行了測試,結果機器人依舊保持了高成功率。

那么,TAVI方法是如何實現這樣的效果的呢?

用視覺信息評價機器人表現

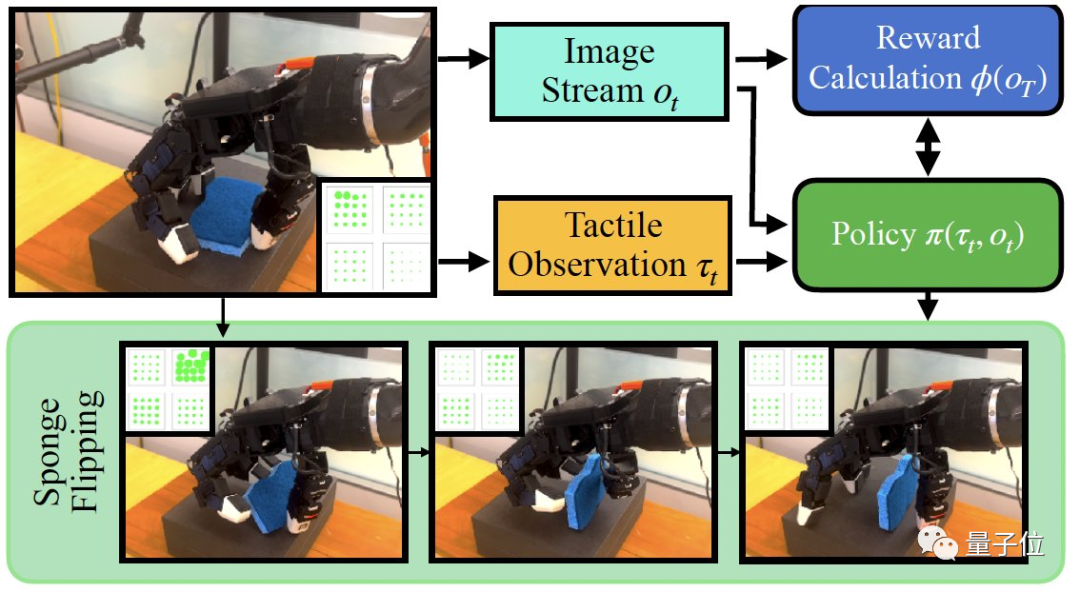

TAVI的核心是使用視覺上的反饋來訓練機器人,工作主要分為三個步驟。

首先是從視覺和觸覺兩個維度收集人類給出的演示信息。

收集到的視覺信息會被用于建立獎勵函數,以供后續學習過程中使用。

這一過程中,系統通過對比學習的方式來獲取對完成任務有用的視覺特征,對機器人動作完成度進行評價。

然后結合觸覺信息和視覺反饋,通過強化學習方式進行訓練,讓機器人反復嘗試,直到獲得較高的完成度評分。

而TAVI的學習是一個循序漸進的過程,隨著學習步驟的增加,獎勵函數越來越完善,機器人的動作也越來越精準。

而為了提高TAVI的靈活性,研究團隊還引入了一種殘差策略。

遇到與基礎策略出現差別時,只需要對有差別的部分進行學習,而不必從頭開始。

消融實驗結果表明,如果沒有殘差策略,而是每次都從頭學起,機器人完成任務的成功率將有所降低。

如果對具身智能有興趣,可以閱讀研究團隊的論文了解更多詳情。

論文地址:https://arxiv.org/abs/2309.12300GitHub。

項目頁:https://github.com/irmakguzey/see-to-touch。