ELK Stack生產實踐——pod日志采集(Elastic Agent方案)

pod日志采集方案

方案選型

- DaemonSet+Elastic Agent方案:使用DaemonSet控制器在每個kubernetes集群節點上運行elastic agent服務,業務容器日志目錄統一掛載到節點指定目錄下。在fleet中配置集成Custom Logs集成策略,指定日志采集目錄和ingest pipeline,實現自定義路徑下的日志收集和清理操作。

- DaemonSet+filebeat+logstash方案:通過DaemonSet方式在每個kubernetes集群節點上運行filebeat服務。以容器運行時containerd為例,配置filebeat輸入路徑為/var/log/containers/<kubernetes.container.id>.log,輸出路徑為logstash。并在logstash中配置規則提取container名稱變量,然后在logstash輸出中引用container名稱變量,以此來實現寫入到es的不同index中。

- sidecar+fluentd方案:每個業務容器中通過sidecar方式運行一個fluentd日志采集處理容器,Fluentd是一個開源的數據收集器,專為處理數據流設計,使用JSON作為數據格式。它采用了插件式的架構,具有高可擴展性高可用性,同時還實現了高可靠的信息轉發。由于logstash處理性能較弱且占用資源較高,可以通過fluentd一個組件替代filebeat+logstash的功能,從而簡化日志采集流程與配置。

- sidecar+filebeat+kafka+logstash方案:每個業務容器中通過sidecar方式運行一個filebeat日志采集容器,用于采集業務容器產生的日志并輸出到kafka中。借助Kafka的Consumer Group技術可部署多個logstash副本,提升數據處理能力和高可用性。需要注意的是每個consumer最多只能使用一個partition,當一個Group內consumer的數量大于partition的數量時,只有等于partition個數的consumer能同時消費,其他的consumer處于等待狀態。因此想要增加logstash的消費性能,可以適當的增加topic的partition數量,但kafka中partition數量過多也會導致kafka集群故障恢復時間過長。

適用場景

在小規模日志場景下,首選DaemonSet+Elastic Agent方案采集pod日志,我們只需要調整集成策略的采集日志路徑和ingest pipeline管道處理規則即可,集群性能瓶頸取決于ingest節點性能。

在大規模日志場景下,推薦使用sidecar+fluentd方案,由fluentd實現日志的采集與過濾處理后直接寫入ES集群,集群性能瓶頸取決于es集群hot節點性能。

在超大規模且業務存在瞬間高峰的日志場景下,推薦使用sidecar+filebeat+kafka+logstash方案。可將日志內容暫存到kafka消息隊列中,由logstash集群逐個消費并寫入ES,防止瞬間高峰導致直接寫入ES失敗,集群性能瓶頸取決于logstash節點性能。

注意事項

應用日志應配置日志輪換以防止日志文件無限增長并占用過多的磁盤空間。通過設置日志輪換參數,可以控制日志文件的大小、保留的日志文件數量以及輪換的頻率。這種做法可以高效管理日志,避免磁盤空間問題。

部署模擬日志程序

項目地址

代碼倉庫地址:https://gitee.com/cuiliang0302/log_demo

日志格式

模擬常見的后端服務日志,格式如下

2023-07-23 09:35:18.987 | INFO | __main__:debug_log:49 - {'access_status': 200, 'request_method': 'GET', 'request_uri': '/account/', 'request_length': 67, 'remote_address': '186.196.110.240', 'server_name': 'cu-36.cn', 'time_start': '2023-07-23T09:35:18.879+08:00', 'time_finish': '2023-07-23T09:35:19.638+08:00', 'http_user_agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.2999.0 Safari/537.36'}

2023-07-23 09:35:19.728 | WARNING | __main__:debug_log:47 - {'access_status': 403, 'request_method': 'PUT', 'request_uri': '/public/', 'request_length': 72, 'remote_address': '158.113.125.213', 'server_name': 'cu-35.cn', 'time_start': '2023-07-23T09:35:18.948+08:00', 'time_finish': '2023-07-23T09:35:20.343+08:00', 'http_user_agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10_12_3) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/58.0.2999.0 Safari/537.36'}

2023-07-23 09:35:19.793 | INFO | __main__:debug_log:49 - {'access_status': 200, 'request_method': 'GET', 'request_uri': '/public/', 'request_length': 46, 'remote_address': '153.83.121.71', 'server_name': 'cm-17.cn', 'time_start': '2023-07-23T09:35:19.318+08:00', 'time_finish': '2023-07-23T09:35:20.563+08:00', 'http_user_agent': 'Mozilla/5.0 (Macintosh; Intel Mac OS X 10.9; rv:57.0) Gecko/20100101 Firefox/57.0'}

2023-07-23 09:35:20.614 | ERROR | __main__:debug_log:45 - {'access_status': 502, 'request_method': 'GET', 'request_uri': '/public/', 'request_length': 62, 'remote_address': '130.190.246.56', 'server_name': 'cu-34.cn', 'time_start': '2023-07-23T09:35:20.061+08:00', 'time_finish': '2023-07-23T09:35:21.541+08:00', 'http_user_agent': 'Mozilla/4.0 (compatible; MSIE 7.0; Windows NT 5.1; Trident/4.0; Hot Lingo 2.0)'}打包并上傳鏡像

[root@es-master ~]# cd /opt/

[root@es-master opt]# git clone https://gitee.com/cuiliang0302/log_demo.git

[root@es-master opt]# cd log_demo/

[root@es-master log_demo]# ls

Dockerfile log.py main.py readme.md requirements.txt

[root@es-master log_demo]# docker build -t harbor.local.com/app/log_demo:1.0 .

[root@es-master log_demo]# docker push harbor.local.com/app/log_demo:1.0部署服務

在本案例中,我們將容器日志目錄通過hostPath方式掛載到宿主機的/var/log/logDemo路徑下。

[root@tiaoban fleet]# cat log-demo.yaml

apiVersion: apps/v1

kind: Deployment

metadata:

name: log-demo

spec:

replicas: 2

selector:

matchLabels:

app: log-demo

template:

metadata:

labels:

app: log-demo

spec:

containers:

- name: log-demo

image: harbor.local.com/app/log_demo:1.0

resources:

requests:

memory: "32Mi"

cpu: "100m"

limits:

memory: "128Mi"

cpu: "500m"

volumeMounts:

- mountPath: /opt/logDemo/log

name: logs

volumes:

- name: logs

hostPath:

path: /var/log/logDemo

type: DirectoryOrCreate

[root@tiaoban fleet]# kubectl apply -f log-demo.yaml

deployment.apps/log-demo created

[root@tiaoban fleet]# kubectl get pod -o wide

NAME READY STATUS RESTARTS AGE IP NODE NOMINATED NODE READINESS GATES

log-demo-76c57cf9dc-9znrd 1/1 Running 0 2m45s 10.244.3.124 work3 <none> <none>

log-demo-76c57cf9dc-lkvrq 1/1 Running 0 2m45s 10.244.4.158 work2 <none> <none>配置代理采集日志

創建集成策略

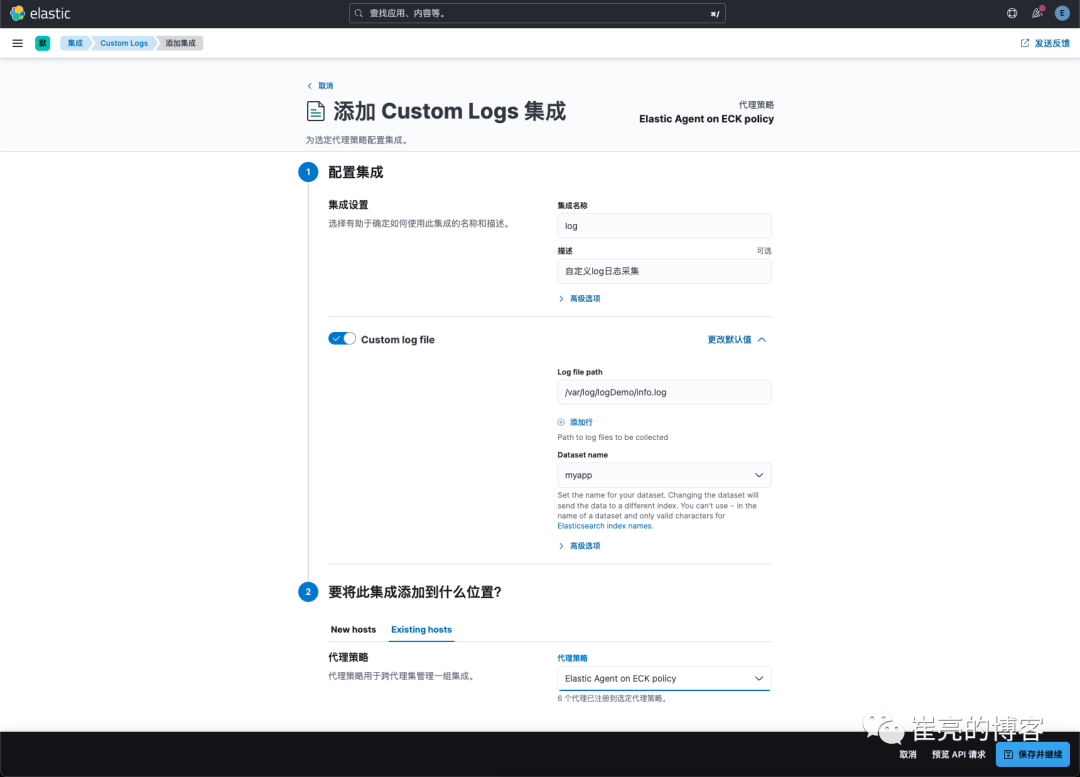

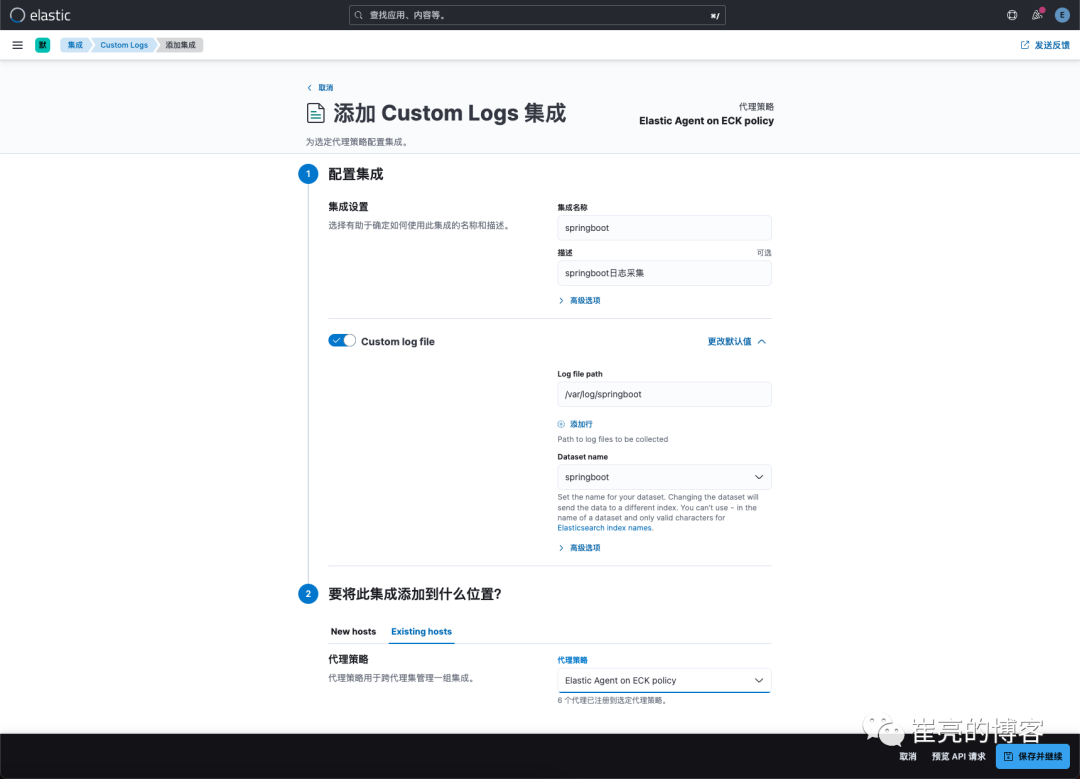

日志路徑填寫掛載到Elastic agent的日志路徑,即/var/log/logDemo/info.log,代理策略選擇現有的Elastic Agent on ECK policy。

圖片

圖片

自定義ingest處理

在先前的自定義日志采集(fleet方式)中已有詳細講解,具體內容可參考文檔https://www.cuiliangblog.cn/detail/article/62,此處不再贅述。

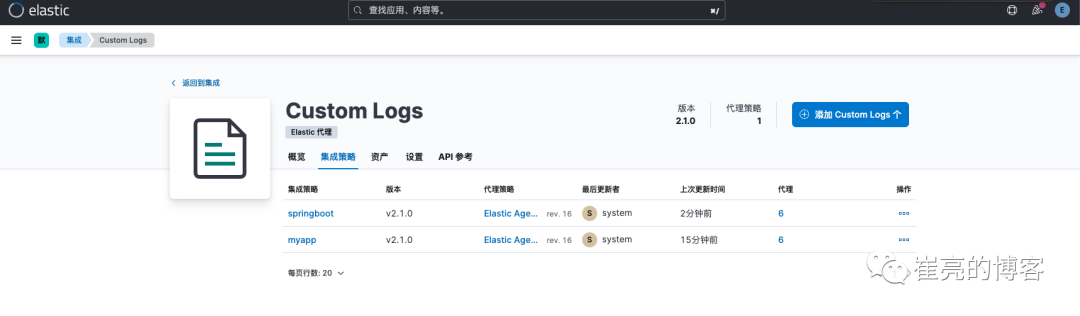

多應用采集思路

通常情況下我們需要采集多個自定義應用的日志內容,我們只需要保證應用日志目錄均掛載至宿主機/var/log目錄下,然后配置fleet代理策略,指定對應的日志路徑和名稱以及ingest pipeline即可。

圖片

圖片

如下所示,我們需要采集myapp和springboot兩個應用的日志,只需要添加多條Custom logs集成策略即可。

圖片

圖片