用童話訓練AI模型,微軟找到了探索生成模型參數的新切入點

即便大語言模型的參數規模日漸增長,其模型中的參數到底是如何發揮作用的還是讓人難以琢磨,直接對大模型進行分析又費錢費力。針對這種情況,微軟的兩位研究員想到了一個絕佳的切入點,用生成簡練但是又涵蓋各種常見邏輯和語法的童話故事來作為模型的生成任務,這樣做能在減少模型的學習負擔的同時,保留模型對邏輯和語法的學習能力,進而用小模型來分析參數發揮的作用。這種方法可能會開創一條新的研究道路。

人們都知道,學英語不是一件容易的事。但假如「學生」是一臺計算機,就可以這樣高效地學英語:只需將互聯網上堆積如山的文本,輸入一個名為神經網絡的巨大數學模型即可。

這就是像 OpenAI 的 ChatGPT 這樣的生成式大模型背后的工作原理,在過去的一年里,它能夠面向廣泛的主題連貫地交談(即便會存在「幻覺」),效果讓所有人都感到驚訝。

但這種方法也有缺點:首先,將龐大的文本檔案轉化為語言模型所需的訓練語料,成本高昂且耗時。另一方面,即使是訓練大語言模型的人也很難理解它們的內部工作原理,這反過來又使得人們很難避免設計上的失敗。

面對這些困難,一些研究人員選擇在較小的數據集上訓練較小的模型,然后研究模型行為。布朗大學語言模型研究員 Ellie Pavlick 說:「這就像果蠅基因組測序與人類基因組測序的關系一樣。」

現在,在近期發布的一篇論文中,微軟的兩名研究人員介紹了一種訓練微小語言模型的新方法:用童話故事訓練模型。

論文鏈接:https://arxiv.org/pdf/2305.07759.pdf

為 ChatGPT 接口提供動力的大型語言模型 GPT-3.5 有近 2000 億個參數,它是在由數千億個單詞組成的數據集上訓練的(OpenAI 尚未發布 GPT-4 的相應數據)。訓練這樣的大型模型通常需要至少 1000 個稱為 GPU 的專用處理器,并行運行數周。只有少數公司能夠籌集到如此的資源,更不用說訓練和比較不同的模型了。

這兩位研究人員的研究表明,比當今最先進的系統小數千倍的語言模型在接受這種基于童話故事的訓練后,能迅速學會講述連貫且符合語法的故事。他們的研究成果指明了新的研究方向,可能有助于訓練更大的模型并理解它們的行為。

艾倫人工智能研究所(Allen Institute for Artificial Intelligence)的語言模型研究員 Chandra Bhagavatula 說:「我發現這篇論文信息量很大,這個概念本身就超級有趣」。

從童話故事說起

作為語言模型核心的神經網絡是一種數學結構,其靈感來源于人腦。每個神經網絡都包含許多按層排列的人工神經元,相鄰層的神經元之間存在連接。神經網絡的行為受這些連接點(稱為參數)的控制。在語言模型中,根據初始提示詞(prompt)和已經生成的單詞,參數控制著模型下一步可能吐出的單詞。

只有在訓練中,當模型反復將自己的輸出與訓練數據集中的文本進行比較,并調整參數以提高相似度時,模型才會真正 「活 」起來。一個未經訓練、參數隨機的網絡很容易通過幾行代碼組裝起來,但它只會產生胡言亂語。經過訓練后,它通常可以「似是而非」地繼續處理陌生文本。較大的模型通常會進行進一步的微調,使其學會回答問題和遵循指令,但訓練的主要內容是掌握單詞預測。

單詞預測的成功需要語言模型掌握多種不同的技能。例如,根據英語語法規則,「going」一詞之后的下一個詞很可能是 「to」,而與文章主題無關。此外,完成 「the capital of France is」(法國的首都是__)需要系統掌握事實知識,而完成包含 「not」一詞的段落則需要系統掌握基本的邏輯。

「原始語言非常復雜,」DeepMind 的機器學習研究員 Timothy Nguyen 說。「為了讓有趣的語言能力出現,人們采用了數據越多越好的方法。」

Ronen Eldan 是一位數學家,2022 年加入微軟研究院研究生成語言模型。要想做到這一點,最直觀的方法是使用小數據集,而這又意味著必須訓練專攻特定任務的模型,這樣它們就不會過于分散。起初,他想訓練模型解決某一類數學問題,但一天下午,在與 5 歲的女兒相處時,他意識到童話故事非常適合。

他說:「在我給她讀了一個故事后,我就想到了這個點子。」

Ronen Eldan。

Ronen Eldan。

為了生成連貫的童話故事,語言模型需要學習世界性的事實,跟蹤人物和事件,并遵守語法規則——這些都是大型模型所面臨的挑戰的簡單版本。但是,在海量數據集上訓練的大型模型在學習真正重要的規則的同時,也學習了無數無關緊要的細節。Eldan 希望,兒童故事的簡潔性和有限的詞匯量能讓小型模型的學習變得更容易管理——使它們更容易訓練,也更容易理解。

不過,在語言模型的世界里,「小」是相對的:比用于訓練 GPT-3.5 的數據集小一千倍的數據集仍然需要包含數百萬個故事。

Nguyen 說:「我不知道你想花多少錢,但我猜你不會雇專業人士來寫(幾百萬個)短篇故事。」

要滿足如此貪婪的讀者,需要一位非常多產的作家,但 Eldan 心里有幾個候選:有誰能比大語言模型更適合為小語言模型寫作呢?

Toy Stories

Eldan 立即著手創建一個由大語言模型生成的合成童話故事庫。但他很快發現,即使是最先進的模型,也不是「天生」就很有創造力。他意識到,如果你只是告訴 GPT-4 編寫適合 4 歲兒童的故事,「大約五分之一的故事都會是關于去公園的孩子害怕滑梯的」。在互聯網看來,這顯然就是最典型的學齡前故事。

解決的辦法是在 prompt 中加入一點隨機性。首先,Eldan 使用 GPT-4 生成了一份包含 1500 個 4 歲兒童可能知道的名詞、動詞和形容詞的列表,這個列表非常簡短,他可以很容易地自行檢查。然后,他編寫了一個簡單的計算機程序,反復提示 GPT-3.5 或 GPT-4 生成一個適合該年齡段的故事,其中包括從列表中隨機抽取的三個單詞,還包括一個的隨機選擇的細節類型,如大團圓結局或情節轉折。令人欣慰的是,生成的故事并不會充滿恐怖情節。

Eldan 現在有了一套按需提供訓練數據的程序,但他不知道訓練一個功能模型需要多少故事,也不知道這個模型需要多大。這時,他與微軟和卡內基梅隆大學的機器學習研究員李遠志合作,利用小型模型可以快速訓練的優勢,嘗試了不同的可能性。

李遠哲與 Eldan 合作,比較了在合成兒童故事上訓練的不同模型。他們發現,小得出奇的模型也能學會講連貫的故事。

第一步是決定如何評估他們的模型。就像在課堂上一樣,在語言模型研究中,評分也是一個充滿爭議的話題。沒有一個完美的評分標準能囊括研究人員想知道的一切,在某些任務中表現出色的模型在另一些任務中往往會大敗而歸。隨著時間的推移,研究人員根據答案明確的問題制定了各種標準基準,如果要評估特定技能,這是一種很好的方法。

但 Eldan 和李對一些更模糊的問題很感興趣:如果盡可能簡化語言,語言模型到底需要多大?Eldan 說:「為了直接測試模型是否會說英語,我認為唯一能做的就是讓模型以開放的方式生成英語內容。」

要衡量模型在此類定性問題上的表現,只有兩種方法:依靠人類評分員,或者再次求助于 GPT-4。兩位研究人員選擇了后者,實際上是讓大型模型既編寫教科書,又進行批改。

Bhagavatula 說,他希望看到 GPT-4 的評價與人類審稿人的評價相比如何 —GPT-4 可能偏向于它幫助訓練的模型,而語言模型的不透明性使得這種偏向難以量化。但他認為這些微小之處不會影響不同模型之間的比較,這些模型是在類似的合成故事集上訓練出來的,而這正是 Eldan 和李的工作重點。

Eldan 和李采用了兩步程序來評估訓練后的每個小型模型。首先,他們向小型模型 prompt 一個與訓練數據集不同的故事的前半部分,使其產生一個新的結尾,并用 50 個不同的測試故事重復這一過程。其次,他們指示 GPT-4 根據創意、語法和與故事開頭的一致性這三個類別對小模型的每個結尾進行評分。然后,他們對每個類別的分數進行平均,最后得出每個模型的三個最終等級。

有了這個程序,Eldan 和李終于可以比較不同的模型,找出哪些是「明星學生」了。

測試結果

經過初步探索,兩位研究人員確定了一個包含約 200 萬個故事的訓練數據集。然后,他們使用這個被稱為 TinyStories 的數據集來訓練參數規模介于 100 萬到 3000 萬的、層數各不相同的模型。這個工作并不耗時:僅使用了四塊 GPU,其中最大的模型的訓練時間不超過一天。

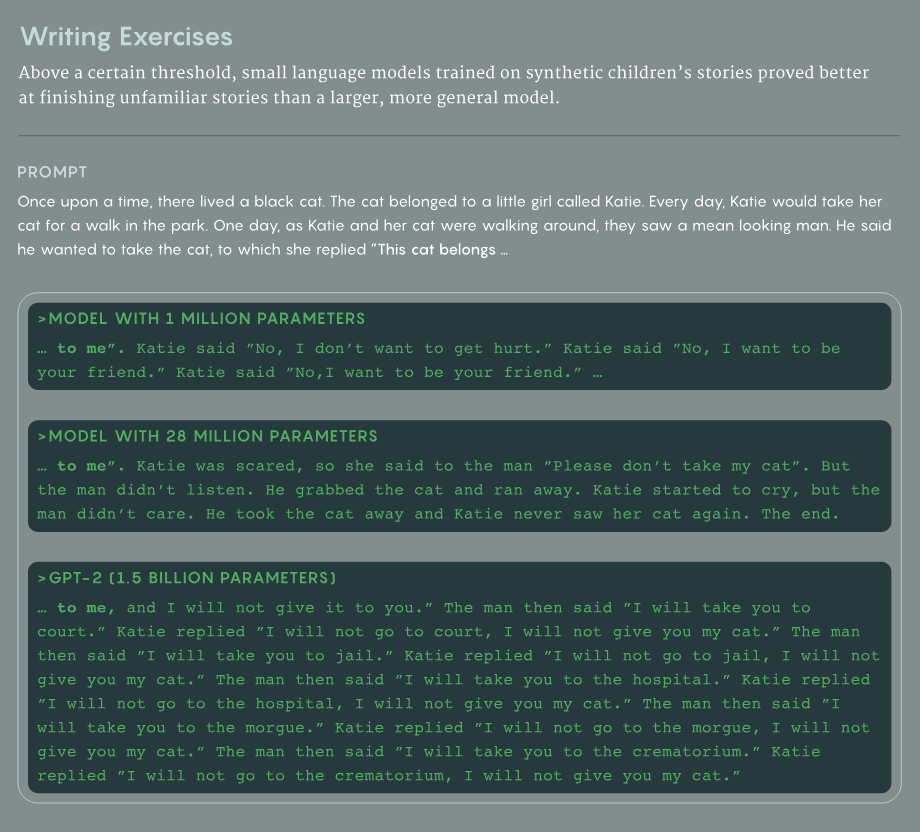

模型太小也不行。例如,一個測試故事的開頭是一個長相兇惡的男人對一個女孩說他要帶走她的貓。一個百萬級參數的模型陷入了一個死循環,女孩反復告訴男人她想和他做朋友。但更大一點的模型(仍然比 GPT-3.5 小數千倍)卻表現出人意料的好。2800 萬參數的版本講述了一個連貫的故事,盡管結局很悲慘:「凱蒂開始哭泣,但那個男人并不在意。他把貓帶走了,凱蒂再也沒見過她的貓。這就是結局」。

除了測試他們自己的模型,Eldan 和李還向 OpenAI 的 GPT-2 提出了同樣的挑戰,這是一個在 2019 年發布的擁有 15 億個參數的模型。它的表現要糟糕得多——在故事戛然而止之前,男子威脅要把女孩送到法庭、監獄、醫院、太平間,最后送進火葬場。

研究簡介

Nguyen 說,如此微小的模型都能如此流暢地工作,真是讓人驚訝,但 GPT-2 在這項任務中的表現也許并不令人驚訝:它是一個較大的模型,但還遠未達到最先進的水平,而且它是在一個非常不同的數據集上進行訓練的。他指出:「一個小孩子只接受幼兒任務訓練,比如玩玩具,可能會比你我做得更好。但是我們沒有專攻這個簡單的東西。」

不同 TinyStories 模型之間的比較并不存在相同的干擾因素。Eldan 和李觀察到的提示是,層數較少但每層神經元較多的網絡更善于回答需要事實知識的問題;相反,層數較多且每層神經元較少的網絡更善于追蹤故事早期的人物和情節點。巴加瓦圖拉發現這一結果特別有趣。他說,如果能在更大的模型中復制這一結果,「那將是這項工作產生的一個非常酷的結果。」

Eldan 和李還研究了他們的小模型的能力與訓練期的長短的關系。多次實驗表明,模型都是先掌握語法,后掌握一致性。Eldan 認為,這種模式說明了獎勵結構的差異決定神經網絡和兒童之間語言習得模式的差異。對于通過預測單詞來學習的語言模型來說,「對『我想要』這個單詞的獎勵和對『冰淇淋』這個單詞的獎勵一樣大,」他說。另一方面,兒童 「并不在乎他們說的是『我想吃冰淇淋』還是『冰淇淋、冰淇淋、冰淇淋』」

定性分析與定量分析

Eldan 和李希望這項研究能激勵其他研究人員在 TinyStories 數據集上訓練不同的模型,并比較它們的能力。但通常很難預測小型模型的哪些特征也會出現在大型模型中。

「也許小鼠視力模型確實是人類視力的很好替代品,但小鼠抑郁模型是人類抑郁的可借鑒模型嗎?」Pavlick 說。「每種情況都有些不同。」

TinyStories 模型的成功還提供了一個更廣泛的啟示。編譯訓練數據集的標準方法不只包括從互聯網上收集文本,然后過濾掉垃圾信息。由大型模型生成的合成文本可以提供另一種方法來建立高質量的數據集,同時不必如此龐大。

Eldan 說:「我們有越來越多的證據表明,這不僅在 TinyStories 這樣大小的模型中非常有效,在更大的模型中也是如此。」

這些證據來自 Eldan、李和其他微軟研究人員關于十億參數模型的兩篇后續論文。在第一篇論文中,他們利用 GPT-3.5 生成的代碼片段和從互聯網上精心挑選的代碼,訓練了一個學習 Python 編程語言的模型。在第二篇論文中,他們用涵蓋廣泛主題的合成「教科書」擴充了訓練數據集,以訓練通用語言模型。在測試中,這兩個模型都優于在較大數據集上訓練的較大模型。但是,語言模型的評估總是很棘手,合成訓練數據的方法仍處于起步階段,需要進行更多的獨立測試。

雖然最先進的語言模型越來越大,但在它們的小型同類上的驚人發現卻提醒我們,即使是最簡單的模型,我們也還有很多不了解的地方。Nguyen 希望看到更多論文探討 TinyStories 首創的方法。

「當前的問題是:參數規模該多大、為什么參數規模如此重要?這應該是一門科學,而這篇論文有望成為一系列研究的開端。」